下一個AI爆款應用,或許就從您點擊"立即部署"的那一刻開始!

一、前言:AI 浪潮下的模型訴求

在當今這個全民 AI 的時代,快速入門 AI,趕上時代的浪潮,成為了大家當下最熱切的追求和期盼。於是,模型作為 AI 場景的載體,隨着 AI 技術的不斷髮展,在持續的,如雨後春筍般出現在大家的視野中,可謂是種類繁雜,功能齊全,從不同方面滿足大家對 AI 的需求。例如在 AI 聊天場景,就有很多大語言模型(LLM)可供選擇;在文本轉語音的場景,又有很多不同種類的 TTS 模型。AI 場景多變,人們也在不斷探索以模型為載體的更多 AI 的可能。ModelScope 作為國內 Top 的 AI 模型平台,收錄承載了大量的模型,人們可以在 ModelScope 按需選擇模型。此時,將模型快速調試應用,發佈上線並運維,也成為了很多公司必不可少的探索方向。

二、痛點分析:傳統模型集成方案已成 AI 革新攔路虎

ModelScope 給 AI 開發者在模型層面上提供了非常大的便利,然而,真正將模型用起來,讓模型具備企業級的生產能力,又是所有企業用户不得不面臨的問題。對於很多開發者來説,有着不小的使用門檻。且模型迭代速度太快,如何能實時緊跟模型的熱度是很多開發者亟待解決的問題。

試想一下:一箇中小型公司希望在自己的平台集成LLM模型,卻要面對GPU資源配置、工程化調試、鏡像構建等一系列繁瑣步驟,整個過程耗時 1 ~ 2 周!這對於急需快速響應市場的團隊來説,簡直是"致命傷"。更別提公司的非開發者,如果想要體驗模型效果,卻因為技術門檻望而卻步,錯失了寶貴的業務創新機會。

- 高使用門檻阻滯快速接入:讓模型具備基礎工程能力並對外提供服務,需要經歷一系列繁瑣步驟:獲取合適的GPU資源、投入大量時間進行開發調試、配置運行鏡像、與現有業務系統適配。對於新入職的 AI 工程師而言,這些工作需與公司業務學習並行展開,而較高的技術門檻必然拉長前期準備週期,整個過程可能需要 1 ~ 2 周的時間週期。在緊湊的項目排期壓力下,難以實現模型的迅速接入與上線。

- 運維複雜性威脅服務穩定性:模型上線後,突增的流量往往會暴露系統瓶頸。擴容過程鏈路冗長——需重新配置GPU資源、調整運行環境、部署新鏡像——耗時巨大,難以應對流量洪峯,最終導致服務宕機。流量消退後,為控制高昂的GPU成本又不得不釋放資源。如此循環往復,每次流量高峯都重複相同的擴容困境。

- 迭代效率低下難跟技術潮流:鑑於模型迭代速度加快,AI工程師若欲及時升級至新版本模型,不僅需部署新模型,還需處理舊模型的流量平滑過渡,同時承受現有架構的沉重負擔。這種低效的迭代機制,使團隊難以實時跟進業界最新的模型方案。

究其根本,可以將以上的三個痛點問題提煉為當前 AI 工程師普遍遇到的技術瓶頸:部署門檻高、環境配置複雜、企業化運維難!

三、對新模型集成方案的期望

行業期待的模型集成方案應該具備:

- 零代碼部署:告別繁瑣的推理代碼編寫、Dockerfile配置,只需簡單填寫配置,模型即刻上線

- 一鍵擴縮容:借鑑Serverless理念,實現GPU資源的彈性伸縮,應對流量波動

- 全流程覆蓋:從開發調試到生產運維,一站式解決,讓企業不僅"用得起",更要"用得好"

- 快速迭代能力:新模型上線無需重構架構,平滑過渡,緊跟技術潮流

四、模型集成新範式 —— FunModel

面對以上 AI 開發中遇到的痛點以及開發者們對模型的持續探索和期待,阿里雲 FunModel 帶來了模型集成的新範式。FunModel 是阿里云云原生的模型服務平台,以阿里雲函數計算 FC 為底座,依託天然的 Serverless + GPU 的基本能力,同時在業務層面無縫對接 ModelScope 官方模型平台,實現 0 代碼一鍵部署,並能快速擴縮容。為企業極大程度上減少了部署和運維模型的時間和人力成本,讓企業專注於 AI 業務的開發,也讓模型企業化觸手可及。

雙渠道部署,靈活自由

阿里雲 FunModel 提供了兩種部署渠道,兼容多種類模型,給用户提供了部署模型的自由度

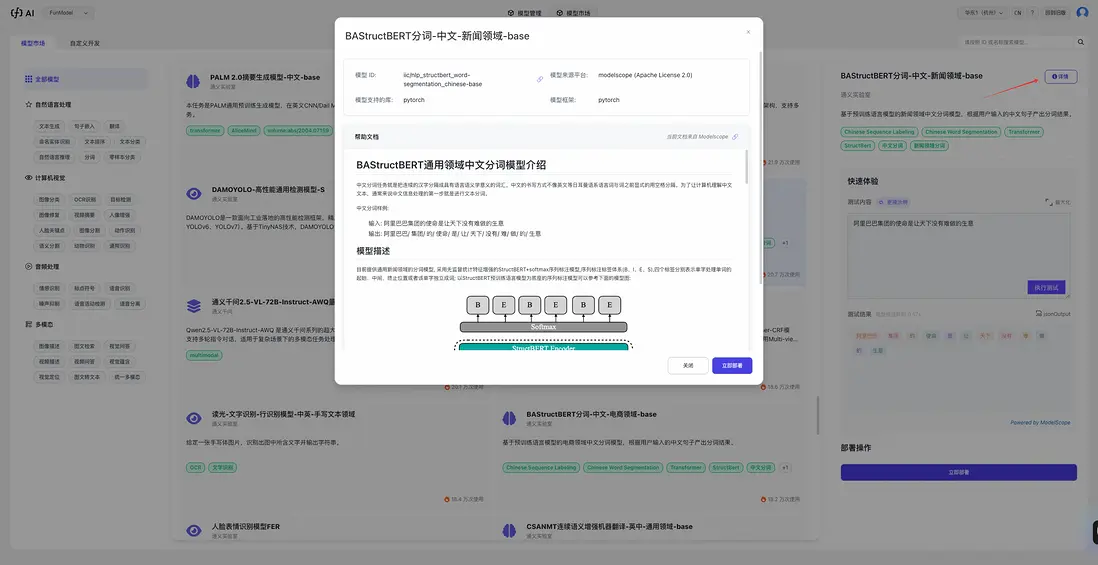

- 無縫對接 ModelScope:阿里雲 FunModel 承載了 ModelScope 上大量的熱門模型,能根據用户需求和熱門模型趨勢快速上架和迭代新的模型,滿足用户需求。同時,也可以輸入 ModelScope 上的模型 ID,即可立即部署。在 FunModel 上,還能快速體驗 ModelScope 模型效果和了解模型詳情,擁有從體驗到部署的完整流程,為用户最大程度上帶來便捷。

- 自定義部署:阿里雲 FunModel 不僅為用户提供模型集成能力,更為有模型開發需求的用户提供了專業的自定義模型部署能力。用户可以上傳自己訓練好的工程鏡像到 FunModel 平台,指定模型來源或存儲路徑,填寫對應啓動參數,就能部署模型到線上,具備企業級服務能力。

5分鐘極速上線

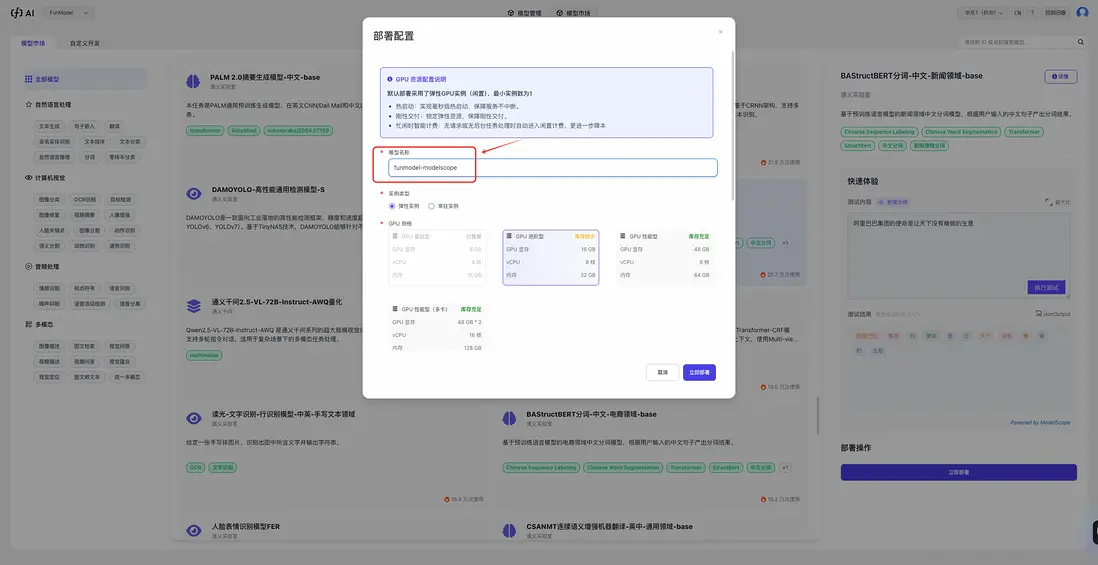

阿里雲 FunModel 極大程度上簡化了模型的部署流程,用户不再需要擔心“推理代碼不會寫”,“部署鏡像太慢”,“啓動參數填寫錯誤”,“GPU 規格選不對”等問題。FunModel 平台已經提前包裝了啓動模型需要的所有參數和環境,只需填寫模型名稱,5分鐘即可完成企業級服務上線,效率提升數十倍。傳統集成方案需要耗時數週,在FunModel這裏壓縮到了一杯咖啡的時間。

Serverless + GPU 幫助實現擴縮容

依託阿里雲函數計算,FunModel 實現 Serverless+GPU 新範式,提供:

- 定時伸縮 / CRON表達式伸縮:根據業務規律預設擴縮容時間

- 水位伸縮:基於CPU/GPU使用率自動調整資源

兩種種策略靈活組合,精準匹配業務流量,極大程度上提高 GPU 利用率,從而節約昂貴的 GPU 費用成本。

五、實戰指南:快速部署 ModelScope 模型

環境準備與權限配置

在使用 FunModel 平台前,需要完成必要的雲資源準備工作:

- 阿里雲賬號準備

確保擁有有效的阿里雲賬號,並完成實名認證。 - FunModel 控制枱訪問

訪問 FunModel 控制枱,這是阿里雲 Serverless AI 模型服務的統一入口。 - RAM 角色授權

根據控制枱指引完成 RAM(Resource Access Management)角色授權配置。這個步驟至關重要,它確保 DevPod 能夠訪問必要的雲資源。

重要提示:如果您當前使用的是舊版控制枱界面,請務必點擊右上角的“新版控制枱”按鈕切換至最新界面,以確保功能完整性。

三步極速部署

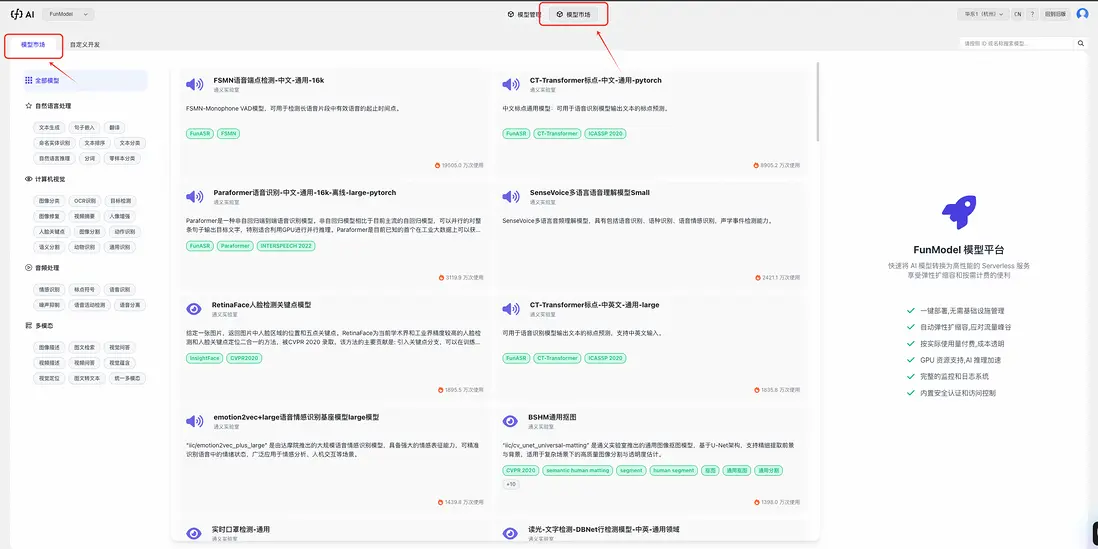

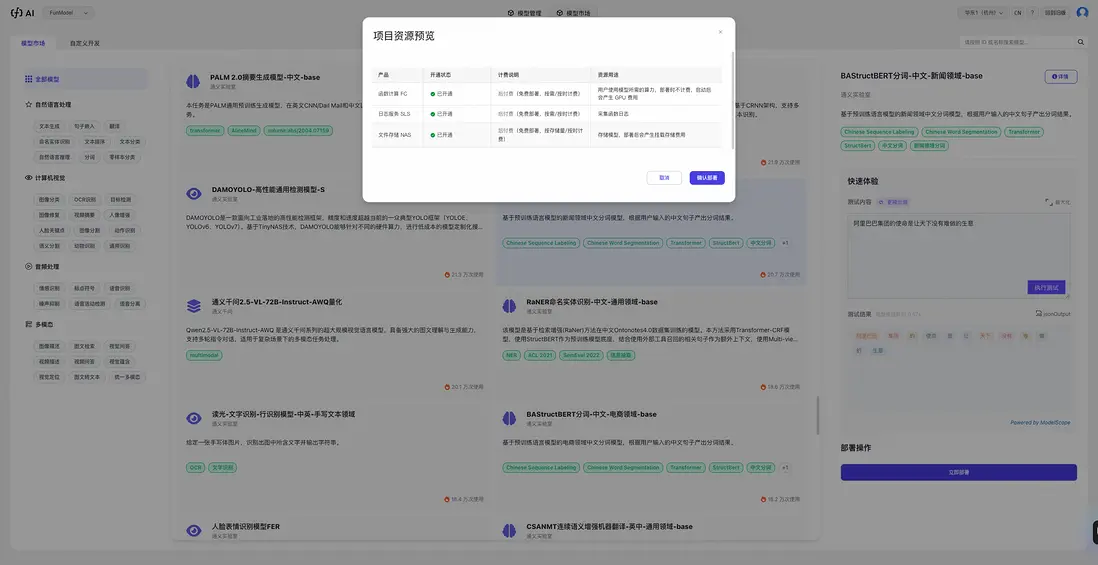

步驟一:登錄 FunModel 控制枱,進入【模型市場】

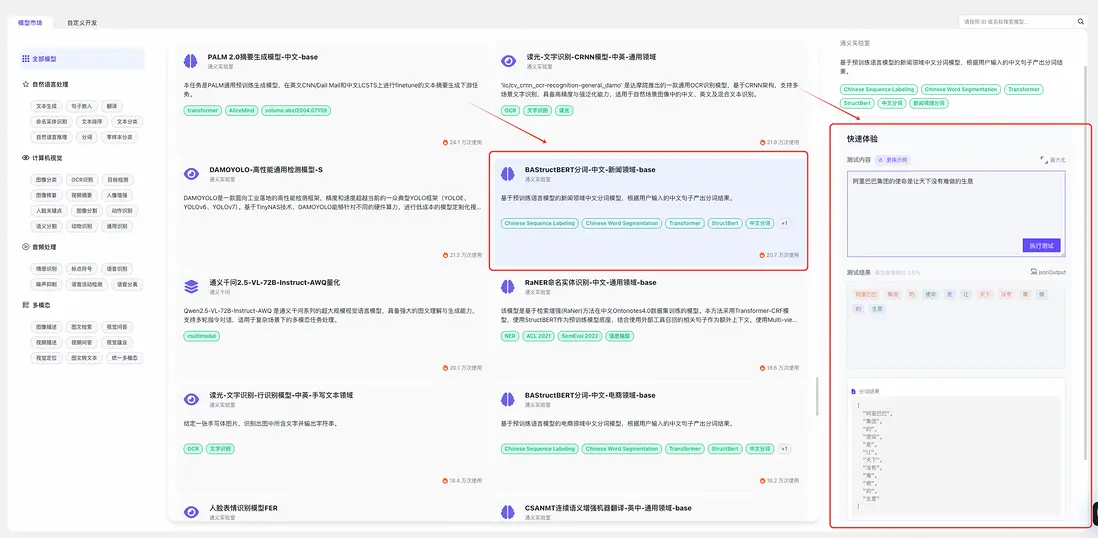

步驟二:在左側頁籤可以選擇不同的模型分類,選擇模型卡片,可以在右邊查看模型詳情,並快速體驗模型效果

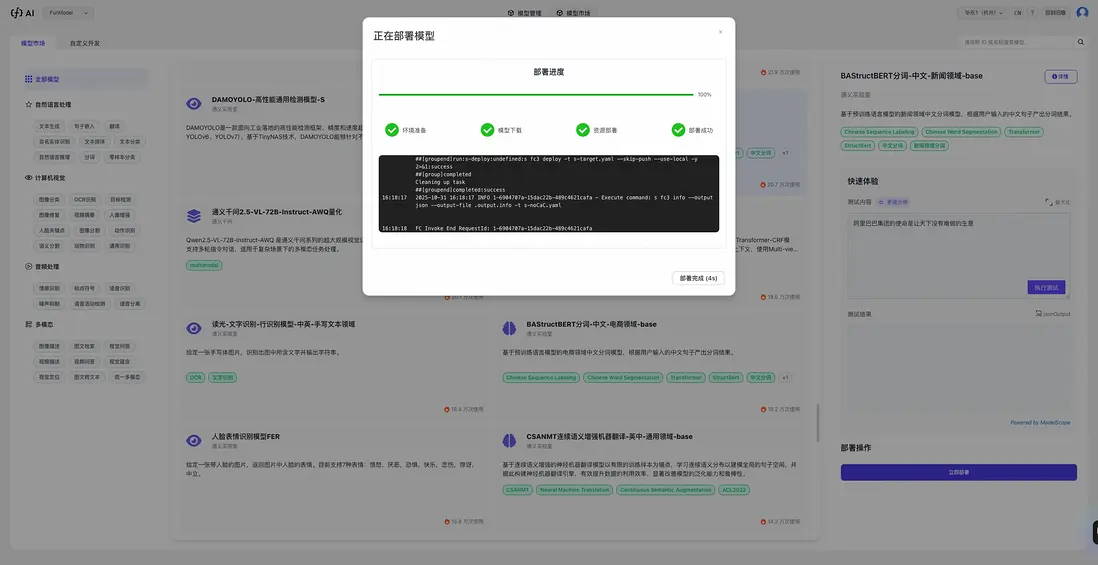

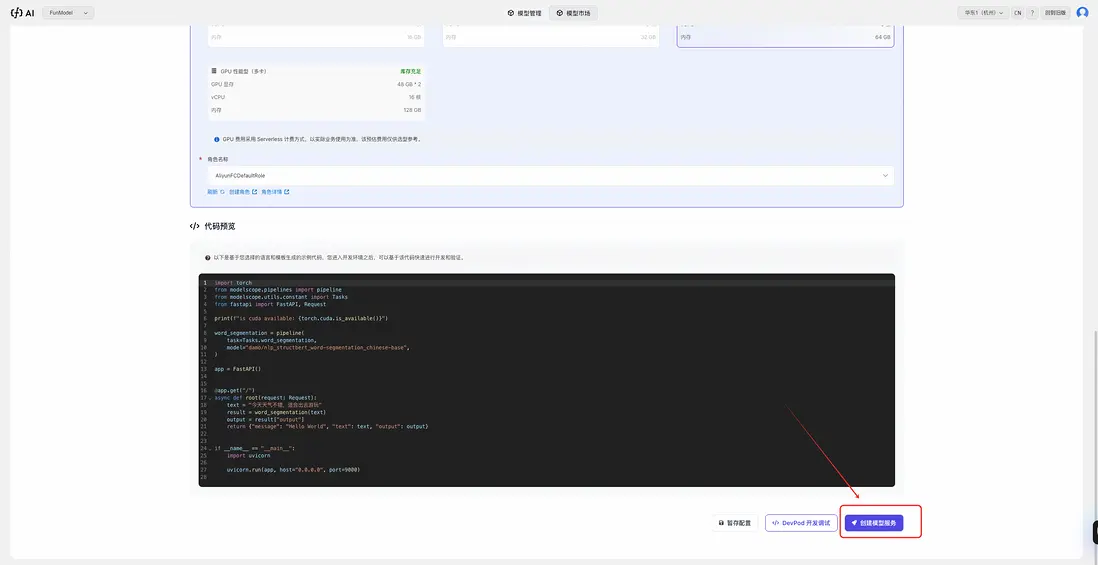

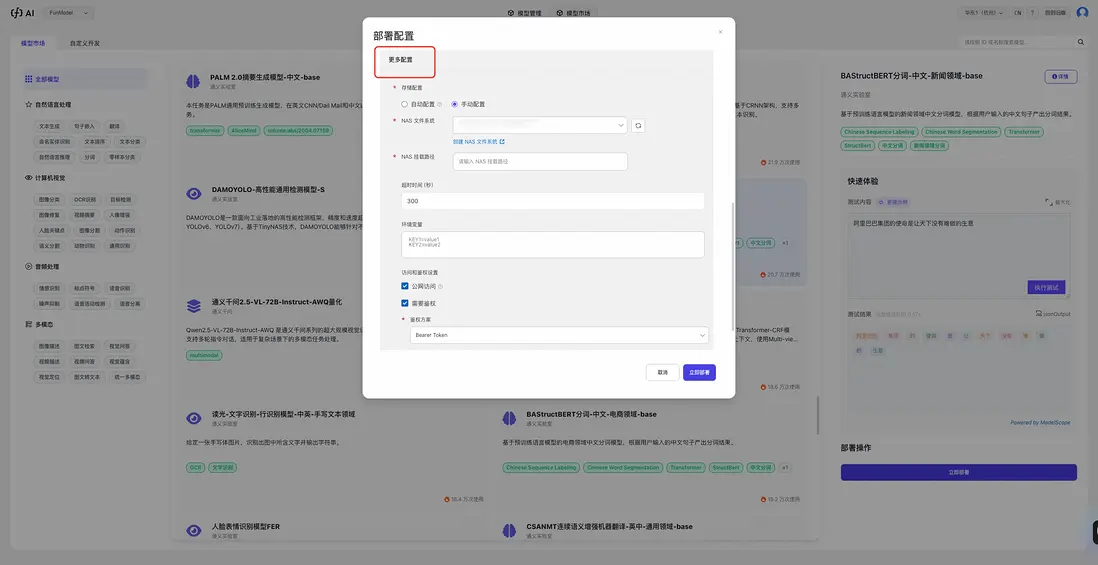

步驟三:點擊"立即部署",填寫模型名稱(建議包含業務含義,如"ocr-v1"),確認資源配置(系統會根據模型類型智能推薦),點擊確認

等待幾分鐘即可完成部署

如果有更多需求,可以在【更多配置】中自定義配置阿里雲存儲 Nas,模型執行的超時時間等參數

高級玩法

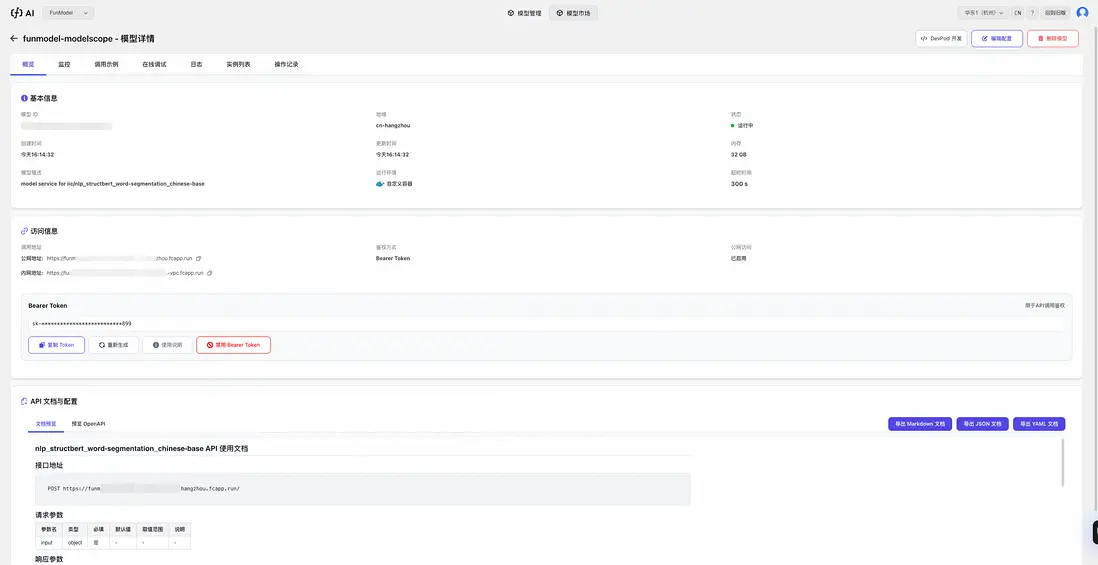

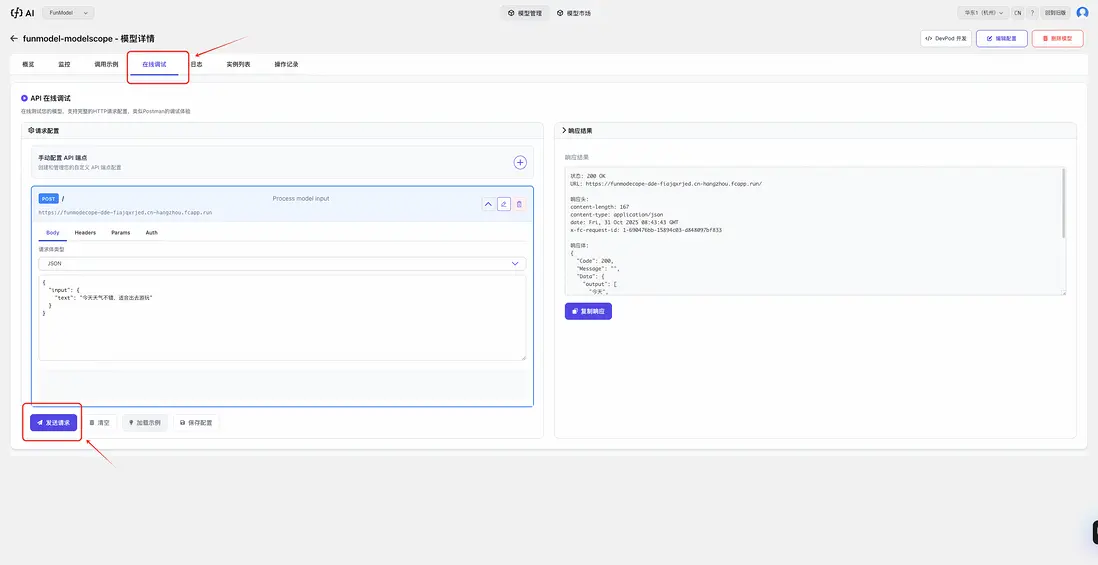

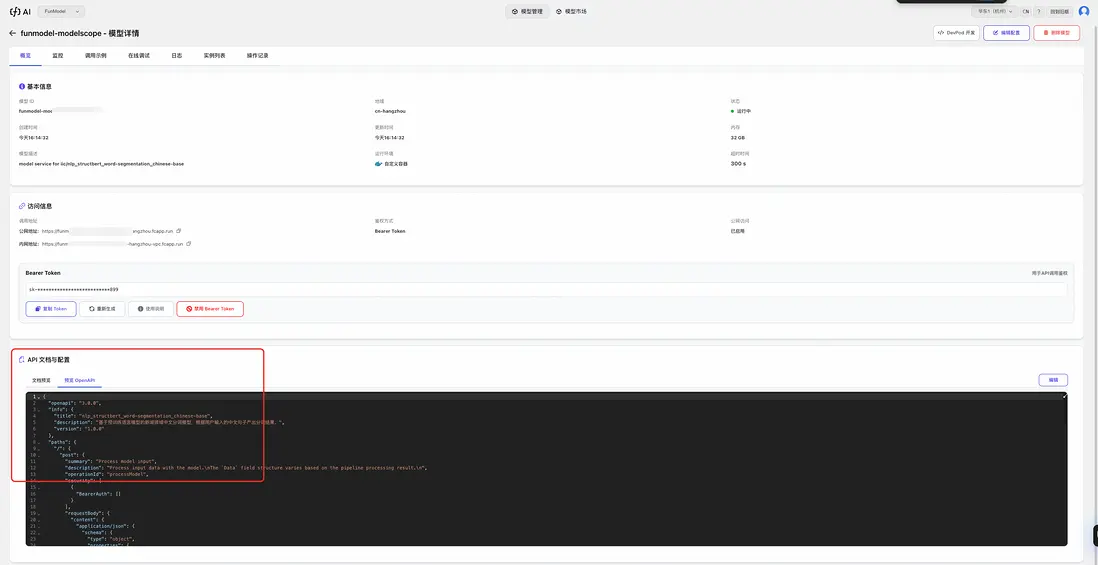

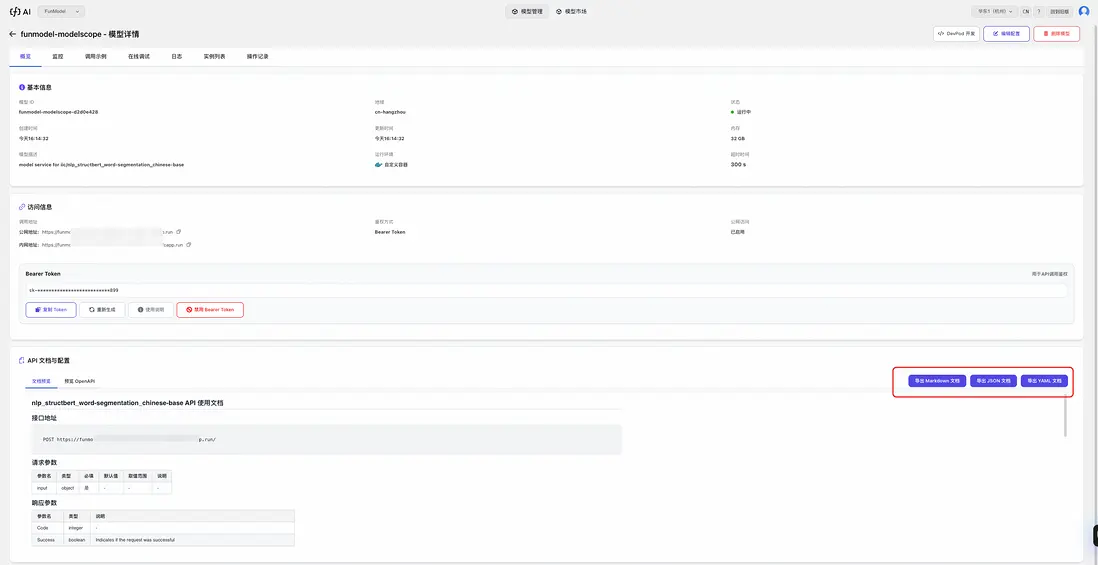

- 模型在線調試:部署完成後,切換到"在線調試"頁籤,填寫對應的 API-Key(如果有),點擊發送請求,即可在頁面右側看到模型返回結果,同時支持修改請求參數,並保存到模型概覽頁的 OpenAPISchema 中

- API文檔導出:一鍵生成 JSON/YAML 格式的 OpenAPI 文檔。支持單獨修改 Schema 並保存,讓接口定義更精準。

輸入模型 ID 部署模型

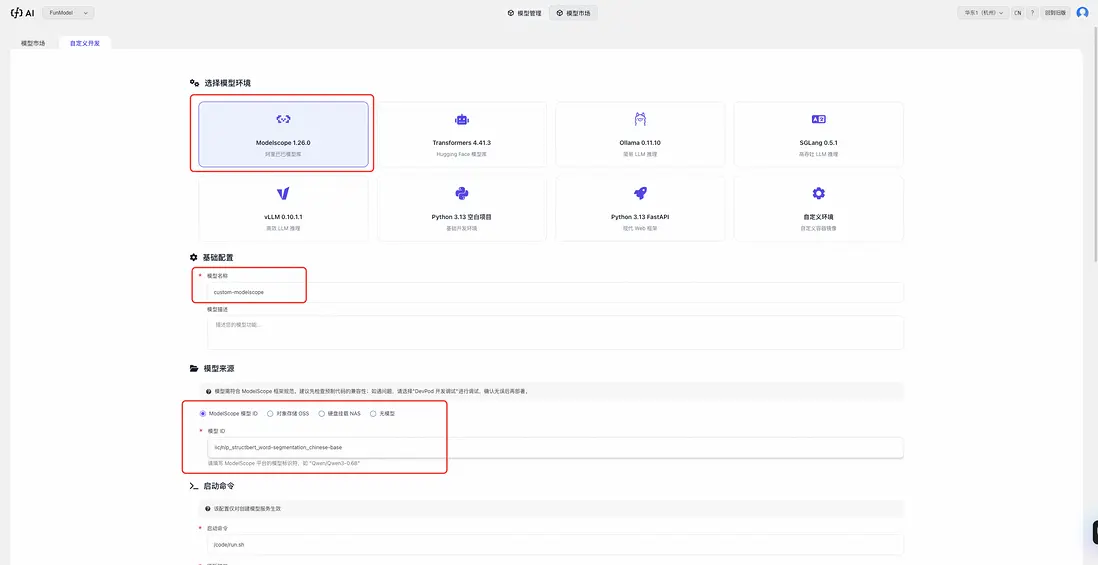

自定義模型部署功能允許用户部署自己的模型或使用預訓練模型,支持多種部署方式以滿足不同的業務需求。 更多有關使用 vLLM、SGLang 和自定義鏡像等方式部署模型的詳情見自定義部署模型

選擇【自定義開發】頁籤,【模型來源】選擇【ModelScope 模型 ID】,填入模型 ID,以 iic/nlp_structbert_word-segmentation_chinese-base 為例,點擊立即部署

六、總結

| 維度 | 傳統方案 | FunModel |

|---|---|---|

| 部署時間 | 以天計 | 5分鐘 |

| 技術門檻 | 高 | 低 |

| 運維以及迭代成本 | 高 | 低 |

FunModel 依託 Serverless + GPU,天然提供了簡單,輕量,0 門檻的模型集成方案,給個人開發者良好的玩轉模型的體驗,也讓企業級開發者快速高效的部署、運維和迭代模型。

在阿里雲 FunModel 平台,開發者可以做到:

- 模型的快速部署上線:從原來的以周為單位的模型接入週期降低到 5 分鐘,0 開發,無排期

- 一鍵擴縮容,讓運維不再是負擔:多種擴縮容策略高度適配業務流量,實現“無痛運維”

在 AI 的時代浪潮下,模型作為 AI 的載體必然會不斷迭代,開發者對模型部署的需求也會日益增多,FunModel 作為模型集成和部署的新範式,也會朝着“讓人人成為開發者”的目標演進下去。

七、更多內容請參考

- FunModel快速入門

- FunModel 自定義部署

- modelscope魔搭平台