本文整理自 2025 雲棲大會,阿里雲智能集團產品專家,劉宇演講議題《函數計算髮布 FunctionAl:serverless Al 原生應用基礎設施》

在 AI 技術應用落地進程中,目前面臨着五大核心挑戰:開發/學習門檻過高,部署運維階段複雜,AI 應用安全備受挑戰,生態能力方面存在嚴重的割裂與鎖定現象,同時資源成本高昂且利用率低下。這些挑戰極大地阻礙了 AI 技術的廣泛普及以及應用效率的有效提升。

阿里雲函數計算(FC)依託 Serverless AI 基礎設施與全棧能力的創新突破,推出 Function AI(函數智能),精準攻克上述痛點問題,全面推動 AI 應用在開發至運維的全流程中實現降本增效。以下將從四個關鍵維度,詳細闡述阿里雲函數計算(FC)的核心解決方案。

一、函數計算 FC:Serverless 形態的 AI 基礎設施

阿里雲函數計算(FC)全新推出 Serverless AI 基礎設施,以“高可用、低成本、零/低運維”為核心,為企業提供從模型部署到 Agent 開發的全棧解決方案。該平台通過 Serverless 架構的彈性特性與智能化資源管理,顯著降低 AI 應用的開發複雜度與資源成本,助力企業快速實現 AI 落地。

- 開發效率提升:無需關注底層資源,開發者可專注於業務邏輯,模型一鍵轉換為 Serverless API。

- 彈性資源調度:按需付費 + N 分之一卡資源分配(如 1/16 卡),GPU 部署成本降低 90% 以上。

- 免運維特性:實例閒置時自動縮容至 0,資源利用率優化 60%,實現業務運維轉型。

二、核心能力發佈:AgentRun 與模型服務、文生圖服務

阿里雲函數計算全新發布 FunctionAI,基於 Serverless 架構的企業級 AI 應用基礎設施平台,實現從模型託管到 Agent 開發的全流程覆蓋,顯著降低技術門檻並提升跨平台適配性。

AgentRun 全流程解決方案:

Agent Run 通過高代碼與低代碼結合,提升 AI 開發效率,支持主流開發生態。在部署階段,提供輕量、靈活、安全隔離的 AI 運行時,支持多種模型和工具運行時,確保應用安全與擴展性。運維方面,Agent Run 具備全鏈路監控能力,免資源運維,實現業務運維轉型。八大組件共同構建,助力開發者輕鬆構建企業級 AI 應用。

- 全生命週期能力

- 開發階段:高代碼 + 低代碼模式,兼容阿里雲百鍊、CloudFlow、Dify 等生態,開發者可自由選擇框架;

- 部署階段:輕量、靈活、安全隔離的運行時,支持大模型/垂類模型調用,提供安全沙箱隔離機制與 MCP/Function Call 協議雙保障;

- 運維階段:全鏈路監控 + 端到端可觀測性,定位問題並提供優化建議,實現免資源運維。

- 技術架構優勢

- 百萬級併發:基於 Session 親和與多語言引擎,提供企業級沙箱服務能力;

- 毫秒級彈性:內存快照技術實現 CPU 毫秒啓動、GPU 秒級響應;

- 成本降低 60%:支持 GPU/CPU/內存解耦配置(最小 0.25 CPU),實例閒置時自動縮容至 0,按需付費。

大語言模型代理機制

多模型統一接入

- 支持 Cloud、GPT、通義千問等 20 家主流大模型,實現開源模型一鍵部署;

- 通過統一規範管理所有模型,解決 First Token 延遲與負載均衡問題。

動態模型治理

- 自動切換機制:當主模型 First Token 時間過長或負載過高時,快速啓用備用模型;

- 並行處理能力:多模型並行執行,首個返回結果的模型優先作為主模型。

工具生態聯動

- 統一工具接口

- 兼容 MCP/Function Call 協議,適配主流工具與第三方服務,API 集成時間從天級降至分鐘級。

- 智能工具管理

- Tool Hub 插件市場:海量插件一鍵部署,快速構建業務場景;

- 智能路由優化:通過語義分析前置篩選工具,降低調用時間(從 60 秒降至秒級)與 Token 消耗。

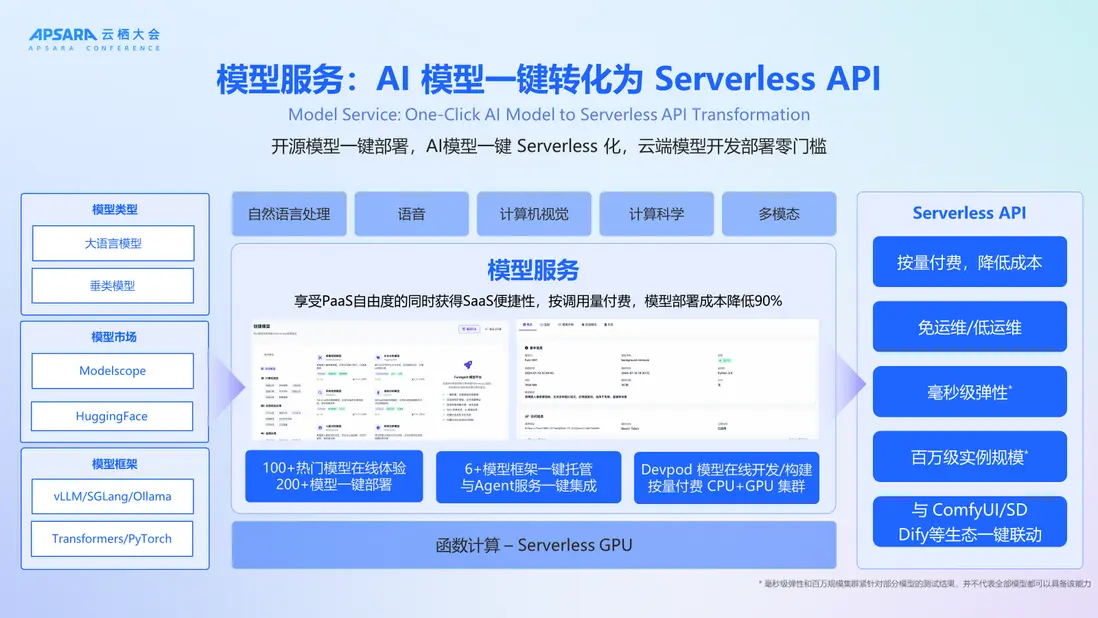

模型服務:AI 模型一鍵轉化為 Serverless API

阿里雲函數計算推出的模型服務,以 Serverless 架構為核心,通過生態兼容性、技術能力與成本優化三位一體,為企業提供從模型部署到服務調用的全鏈路解決方案。該服務顯著降低 AI 應用開發門檻,同時保障高可用性與資源高效利用,助力企業快速構建生產級模型服務。

-

生態兼容性

- 覆蓋大語言模型與垂類模型,兼容 ModelScope、HuggingFace 等主流平台;

- 支持 vLLM、SGLang、Ollama、Transformer 等技術架構的一鍵部署。

-

技術能力

- 提供 100+ 模型在線體驗,200+ 模型一鍵部署;

- 六大框架一鍵託管,與 Agent 服務無縫集成;

- DevPod 在線環境支持代碼調試與鏡像自動構建,無需掌握 Dockerfile。

-

成本優化

- Serverless GPU 技術結合按量付費模式,N 分之一卡資源分配(如 1/16 卡);

- 部署成本降低 90% 以上,資源閒置時不計費,支持百萬級併發與毫秒級彈性;

- 與 ComfyUI、Dify 等生態實現一鍵聯動,消除資源預置顧慮。

文生圖/聲音/視頻:多模態AI創作平台

多模態AI創作平台以“零門檻生成”為核心,通過全鏈路工具與生態聯動,覆蓋電商設計、遊戲渲染、營銷物料、教育培訓等全行業場景。平台提供開箱即用的文生圖/視頻/聲音能力,結合高性價比算力與自動化資源管理,顯著降低創作門檻與成本。

- 文生圖與文生視頻

- 集成 ComfyUI 與 Stable Diffusion 工具,解決本地部署複雜度與顯存資源限制;

- 支持全場景內容生成,從設計到渲染實現端到端自動化。

- Lora 模型訓練

- 提供 Muse Lora 等專業訓練器,覆蓋數據標註到模型訓練的全流程;

- 適配垂類場景需求,快速生成定製化模型。

- 企業級 Serverless API 調用

- 一鍵部署 Stable Diffusion、ComfyUI 等模型,自動轉換為 Serverless API;

- 高性價比 GPU 彈性算力 + 自動擴容,支持同步/異步靈活切換。

三、Agent 最佳全棧實踐:Function Q,你的雲上助理

Function Q 是專業的函數計算智能助手,集成了基於大模型的代碼自動生成、智能運維診斷和系統架構設計三大核心能力,顯著提升 Serverless 應用的開發效率。整體技術棧基於函數計算 FC、API 網關、RocketMQ、SLS 等阿里雲成熟基礎服務構建,遵循雲原生設計原則,提供企業級的高可用性、安全性和可觀測性保障。

- 智能開發助手

- 意圖驅動部署:用户通過自然語言描述需求(如“獲取本地天氣”),Function Q 自動生成代碼並部署至函數計算,提供按量付費的 API 接口;

- 示例場景:輸入“獲取本地 IP”,Function Q 自動查詢 API 並生成可調用服務,無需手動編寫 Dockerfile 或配置資源。

- 運維診斷專家

- 問題自動分析:針對資源費用異常、函數運行錯誤等問題,調用 MCP 工具鏈定位根源並提供解決方案;

- 實時監控支持:支持全鏈路可觀測性,縮短故障排查週期,提升運維效率。

- 架構設計顧問

- 業務遷移指導:通過業務描述分析,推薦切分方法或整體打包策略,適配函數計算架構需求;

- 場景覆蓋:解決開發者對 Serverless 架構遷移路徑的困惑,實現零門檻上雲。

四、擁抱開源,與開源共成長

阿里雲函數計算將堅定擁抱開源、與開源共成長。AI 並非單純商業化產品,而是開放共贏的技術生態平台。當下,我們已與 Agentscope、LangChain、dify 等平台開展開源託管及代碼集成工作。

未來,還有兩大關鍵動作:一是開源 AgentRun SDK,助力快速集成上層開源框架;二是推出 model plugin,讓所有垂類模型可像插件般,快速接入 dify、N8N、Stable Diffusion\ComfyUI 等現有生態。我們期望藉此不僅擁抱開源,更能反哺開源,攜手共進。