作者:範中豪(熾凡)

在多雲架構日益普及的今天,企業常常面臨這樣的場景:運行在多雲環境中的業務系統會產生大量日誌數據,通常存儲於對象存儲服務中,但為了實現集中化運維、安全合規與統一分析,需要將這些分散的日誌數據匯聚至統一的日誌平台進行處理與洞察。

典型場景包括:

- 跨雲服務日誌集中分析: 各類雲服務產生的審計日誌、網絡流日誌、負載均衡訪問日誌等,需在統一平台進行關聯分析與故障排查;

- 海外業務數據迴流: 分佈在境外的業務系統生成的日誌需安全、高效地迴流至國內,以滿足數據合規、安全審計與運營分析需求;

- 多雲統一運營管理: 企業採用多雲或混合雲戰略,亟需構建統一的日誌採集、分析與告警體系,打破數據孤島,提升可觀測性與響應效率。

針對以上場景,阿里雲日誌服務 SLS 提供了強大的實時分析能力、靈活的查詢語法和完善的告警機制,是日誌統一管理的理想選擇。接下來,我們以業界廣泛採用的對象存儲服務 AWS S3 為例,展示如何將異構環境中的對象存儲日誌高效導入 SLS,實現統一平台上實現日誌的實時查詢、智能分析、可視化監控與自動化告警,幫助企業更加智能、高效、可靠地進行跨雲平台海量日誌統一管理。

技術挑戰:看似簡單的數據搬運背後

挑戰一:海量小文件的實時發現難題

許多 AWS 服務(如 CloudTrail、ALB)會持續向 S3 寫入小文件,每分鐘可能產生成百上千個文件。如何快速發現這些新增文件並及時導入?

核心難點在於: S3 的 ListObjects API 只支持按字典序遍歷,不支持按時間過濾。這意味着要找到最新的文件,可能需要遍歷整個目錄樹。

舉個例子:假設某個 S3 bucket 中已有上億個歷史文件,每分鐘新增 1000+ 文件。如果採用全量遍歷,可能需要數分鐘才能完成一次掃描,根本無法滿足實時性要求;但如果只做增量遍歷,又可能因為文件命名不規則而遺漏數據。

挑戰二:流量突發的彈性應對

業務流量往往具有明顯的波動性。電商大促、營銷活動、系統故障都可能導致日誌量瞬間暴增。

真實場景: 某電商客户在平時每分鐘產生 1GB 日誌,但在大促期間會飆升到 10GB 甚至更高。如果導入能力無法快速擴容,就會導致數據積壓,影響實時分析和告警的時效性。

更棘手的是,流量波動往往不可預測。系統需要自動感知流量變化,並在幾分鐘內完成擴容,這對調度系統提出了很高的要求。

挑戰三:數據格式的多樣性與成本控制

S3 中的日誌數據千差萬別:

- 壓縮格式:gzip、snappy、lz4、zstd 等;

- 數據格式:JSON、CSV、Parquet、純文本等;

- 數據質量:可能包含髒數據、需要字段提取和轉換。

如果先將數據原樣導入 SLS,再進行加工處理,會產生額外的存儲和計算成本。理想的方案是在導入過程中就完成數據清洗和轉換。

我們的解決方案:智能、彈性、全面

在 S3 到 SLS 的遷移場景中,最讓運維團隊頭疼的是“如何又快又穩地搬數據”。傳統方案往往面臨兩難選擇:要麼快但容易漏,要麼穩但慢如蝸牛。

SLS 團隊的解決方案是:不做選擇題,兩個都要。

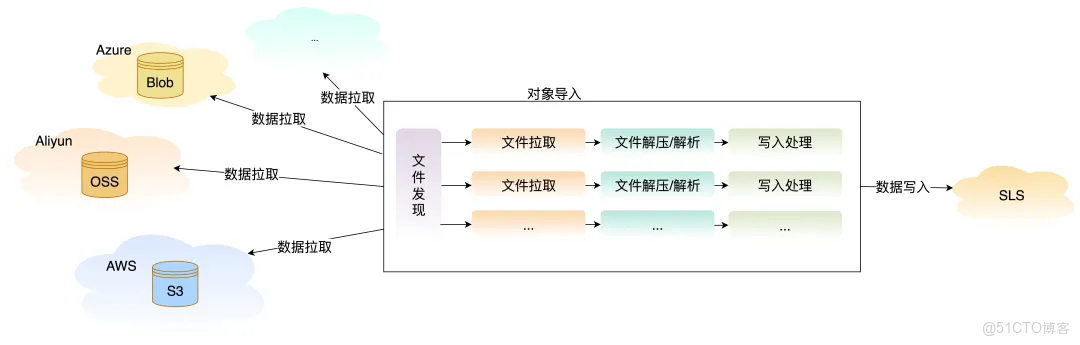

通過創新的兩階段並行架構:

- 第一階段(文件發現):多種機制組合出擊,實時事件捕獲 + 定期全量校驗,確保“一個不漏”;

- 第二階段(數據拉取):專屬傳輸通道全速運轉,不受文件掃描拖累;

- 關鍵創新:兩階段獨立運行、並行推進,既快又穩。

實時文件發現:秒級響應零遺漏

方案一:雙模式智能遍歷

針對文件發現難題,我們提供了兩種互補的遍歷模式:

全量遍歷模式

- 週期性(如每分鐘)對指定目錄進行完整掃描;

- 確保不遺漏任何文件,適合對數據完整性要求極高的場景;

- 智能記錄已導入文件,避免重複處理。

增量遍歷模式

- 基於字典序的增量發現機制;

- 每次從上次掃描的位置繼續遍歷,快速發現新增文件;

- 適合文件按時間順序命名的標準場景,可實現分鐘級實時導入。

兩種模式組合使用: 增量遍歷保證實時性,全量遍歷兜底保證完整性。

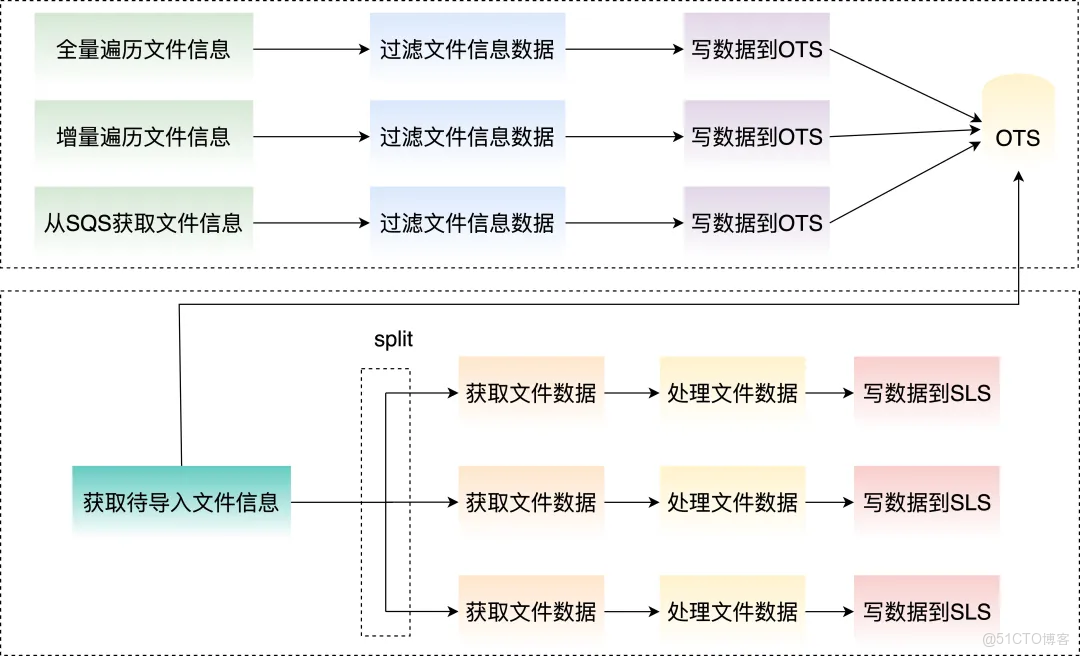

方案二:SQS 事件驅動導入

對於實時性要求極高的場景,我們支持通過 SQS 消息隊列來驅動導入流程:

- 配置 S3 事件通知: 當有新文件上傳到 S3 時,自動發送事件到 SQS;

- 實時消費消息: 導入服務從 SQS 中獲取文件變更通知;

- 精準導入: 直接導入指定的文件,無需遍歷。

這種方案可以實現分鐘級的導入延遲,特別適合:

- 文件創建順序不規則的場景;

- 對實時性有嚴格要求的業務;

- 需要同時監控多個目錄的複雜場景。

方案對比:

|

對比維度

|

雙模式遍歷

|

SQS 事件驅動

|

|

新文件發現實時性

|

分鐘級

|

秒級

|

|

配置複雜度

|

簡單

|

需配置 S3 事件

|

|

可靠性

|

高(全量兜底)

|

依賴 SQS 可靠性

|

|

適用場景

|

標準日誌導入

|

高實時性要求

|

智能彈性伸縮:自動應對流量波動

我們實現了三種彈性機制來應對流量突發:

1. 基於滑動窗口的自適應調整

- 每 5 分鐘評估一次待導入的數據量;

- 根據文件元信息(大小、數量)預估所需併發度;

- 自動擴容或縮容,確保導入速度與數據產生速度匹配。

2. 長尾問題優化

- 讓不同 task 導入的文件量/文件數據量儘量一致,避免長尾問題帶來延遲。

3. 用户提單預先設置併發度

- 支持用户根據業務規律提單設置導入併發度;

- 例如:用户提前預知活動高峯流量,支持提單給 SLS 來提前設置任務併發度。

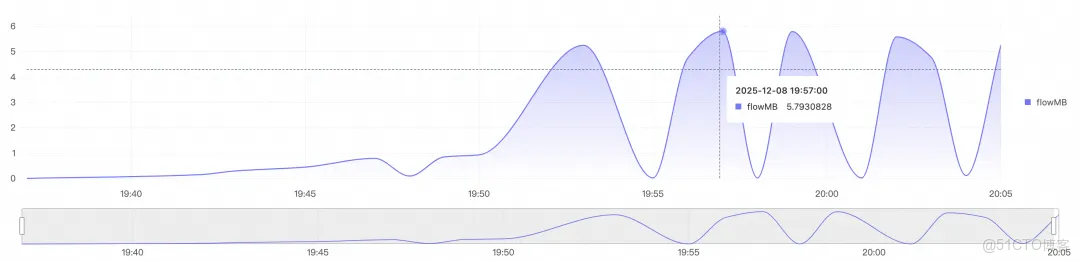

下圖展示了在大數據量導入場景下,快速彈性擴縮,快速擴至 300 併發,以近 5.8 GB/s 的速率導入文件數據。

全面的數據處理能力

多格式無縫支持

|

能力類型

|

支持範圍

|

|

壓縮格式

|

zip、gzip、snappy、lz4、zstd、無壓縮等

|

|

數據格式

|

JSON、CSV、單行文本、跨行文本、Cloudtrail、Json數組等

|

|

字符編碼

|

UTF-8、GBK

|

落盤前處理:省錢又高效

傳統方案是“先存儲,再加工”,會產生不必要的存儲成本。我們支持在數據寫入 SLS 之前進行處理:

- 字段提取:從非結構化日誌中提取關鍵字段;

- 數據過濾:丟棄無用日誌,減少存儲量;

- 字段轉換:格式標準化、時間戳轉換等;

- 數據脱敏:敏感信息脱敏處理;

- 等等。

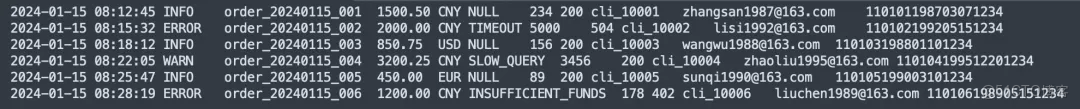

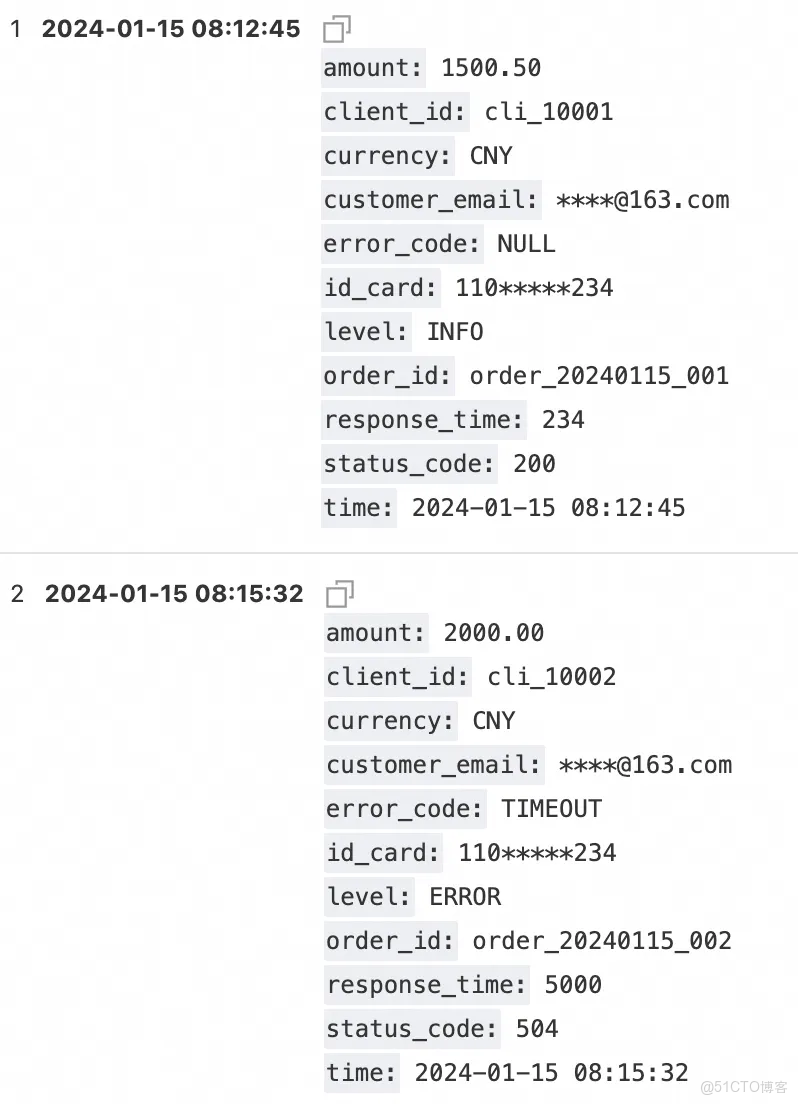

落盤前數據處理樣例

源單行文本日誌

寫入處理器規則

* | parse-csv -delim='\t' content as time,level,order_id,amount,currency,error_code,response_time,status_code,client_id,customer_email,id_card

| project-away content

| extend customer_email = regexp_replace(customer_email, '([\s\S]+)@([\s\S]+)', '****@\2')

| extend id_card = regexp_replace(id_card, '(\d{3,3})(\d+)(\d{3,3})', '\1*****\3')

| extend __time__ = cast(to_unixtime(cast(time as TIMESTAMP)) as bigint) - 28800落盤日誌樣例

方案價值:不只是數據搬運

可靠性保障

- 文件級狀態追蹤:每個文件的導入狀態清晰可查;

- 自動重試機制:臨時失敗自動重試,無需人工干預;

- 完整性校驗:支持文件級別的導入確認;

- 監控告警:導入延遲、失敗率等關鍵指標實時監控。

成本優化

- 按需彈性:根據實際流量自動調整資源,避免延遲增長;

- 寫入前處理:減少無效數據存儲,降低存儲成本;

- 增量導入:只導入新增和變更的文件,避免重複導入。

開箱即用

- 可視化配置:無需編寫代碼,通過控制枱即可完成配置;

- 預設模板:針對 CloudTrail、JsonArray 等常見日誌提供開箱即用的配置模板;

- 完善文檔:詳細的配置説明和最佳實踐指南。

最佳實踐建議

場景一:AWS 服務日誌導入(推薦雙模式遍歷)

典型日誌: CloudTrail、VPC Flow Logs、S3 訪問日誌,文件名順序遞增場景

推薦配置:

- 配置檢查新文件週期為一分鐘;

- 自動啓用增量遍歷,保證實時性;

- 自動啓用全量遍歷,保證完整性;

- 配置寫入處理器,提取關鍵字段。

效果: 可實現 2-3 分鐘的端到端延遲,數據完整性 100%

場景二:應用日誌實時分析(推薦 SQS 方案)

典型場景: 應用程序實時日誌,文件生成速率以及文件名無規則,但需要快速告警

推薦配置:

- 配置 S3 事件通知到 SQS;

- 使用 SQS 驅動導入。

效果: 可實現 2 分鐘內的端到端延遲,滿足實時告警需求

總結

從 S3 到 SLS 的數據導入,看似簡單的數據搬運工作,實則是一個需要精心設計的系統工程。我們通過雙模式智能遍歷解決了文件發現難題,通過三種彈性機制實現了流量突發的自動應對,通過寫入處理器降低了客户成本。

這不僅僅是一個數據導入工具,更是一套完整的跨雲日誌集成解決方案。無論是標準的雲服務日誌,還是複雜的應用程序日誌,我們都能提供高效、可靠、經濟的導入能力。

立即開始:訪問 SLS 控制枱,選擇“數據導入 > S3 導入”,三步即可完成配置,開啓您的跨雲日誌分析之旅。