聚水潭·奇門數據集成到MySQL:售後單數據的高效對接方案

在現代企業的數據管理中,如何高效、準確地將業務系統中的數據集成到分析平台是一個關鍵問題。本文將分享一個具體的技術案例,展示如何通過輕易雲數據集成平台,將聚水潭·奇門的售後單數據無縫對接到MySQL數據庫中,實現業務數據的實時監控與分析。

本次案例的集成方案命名為“聚水潭-售後單-->BI崛起-售後表_原始查詢”,主要涉及以下幾個關鍵環節:

- 高吞吐量的數據寫入能力:為了確保大量售後單數據能夠快速被寫入MySQL,我們利用了輕易雲平台提供的高吞吐量特性。這不僅提升了數據處理的時效性,也保證了業務系統和分析平台之間的數據同步。

- 定時可靠的數據抓取:通過調用聚水潭·奇門API接口

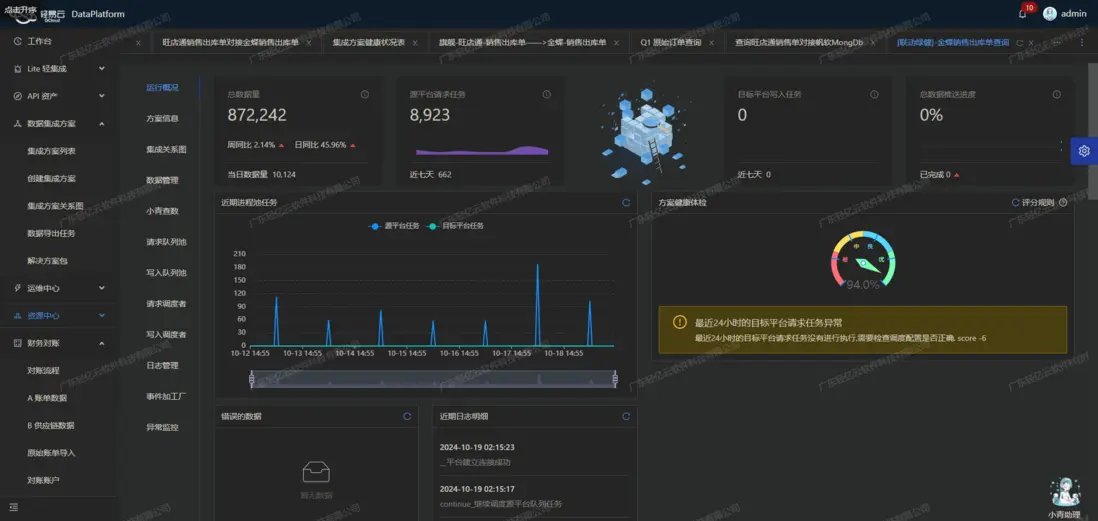

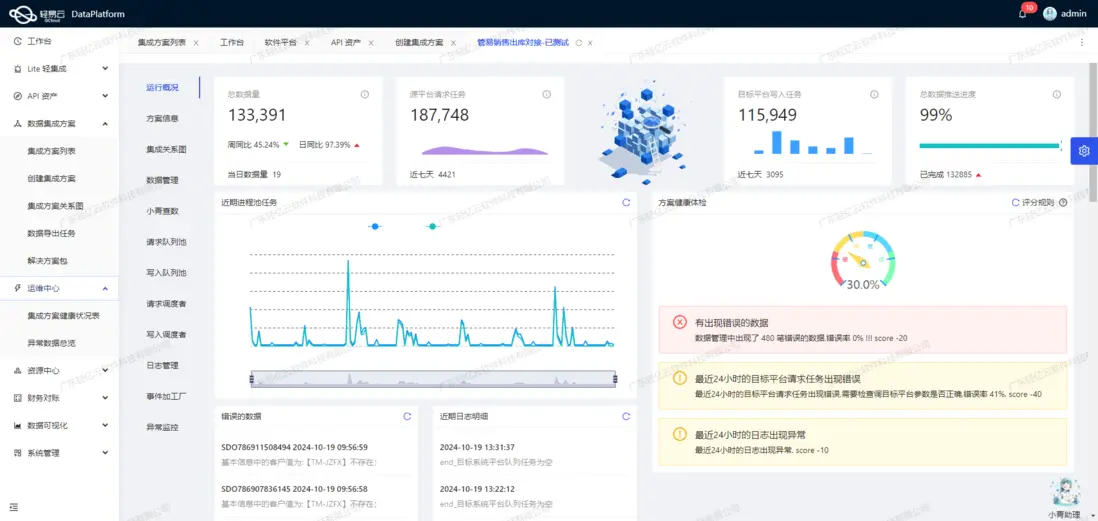

jushuitan.refund.list.query,我們實現了定時可靠地抓取售後單數據。該接口支持分頁和限流功能,使得我們能夠有效處理大批量的數據請求,並避免因接口調用頻率過高而導致的問題。 - 集中監控和告警系統:在整個數據集成過程中,輕易雲平台提供了集中監控和告警系統,實時跟蹤每個任務的狀態和性能。一旦出現異常情況,系統會及時發出告警通知,從而確保問題能夠迅速得到解決。

- 自定義數據轉換邏輯:為了適應不同業務需求和數據結構,我們在輕易雲平台上配置了自定義的數據轉換邏輯。這使得從聚水潭·奇門獲取的數據能夠準確映射到MySQL數據庫中的相應字段,並進行必要的格式轉換。

- 異常處理與錯誤重試機制:在實際操作中,不可避免會遇到各種異常情況。為此,我們設計並實現了一套完善的異常處理與錯誤重試機制,確保即使在網絡波動或接口響應超時等情況下,依然能夠保證數據不丟失、不重複。

通過上述技術手段,本次案例成功實現了聚水潭·奇門售後單數據向MySQL數據庫的高效對接,為企業提供了全面、實時的數據支持。在接下來的章節中,我們將詳細介紹每個步驟的具體實現方法及注意事項。

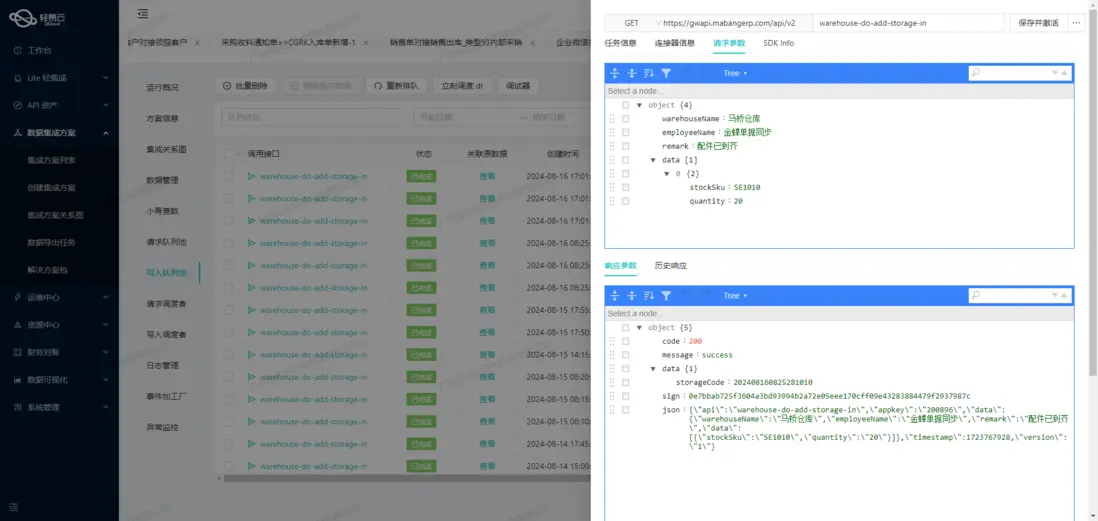

調用聚水潭·奇門接口jushuitan.refund.list.query獲取並加工數據

在數據集成過程中,調用源系統的API接口是關鍵的一步。本文將詳細探討如何通過輕易雲數據集成平台調用聚水潭·奇門接口jushuitan.refund.list.query,並對獲取的數據進行初步加工處理。

接口配置與請求參數

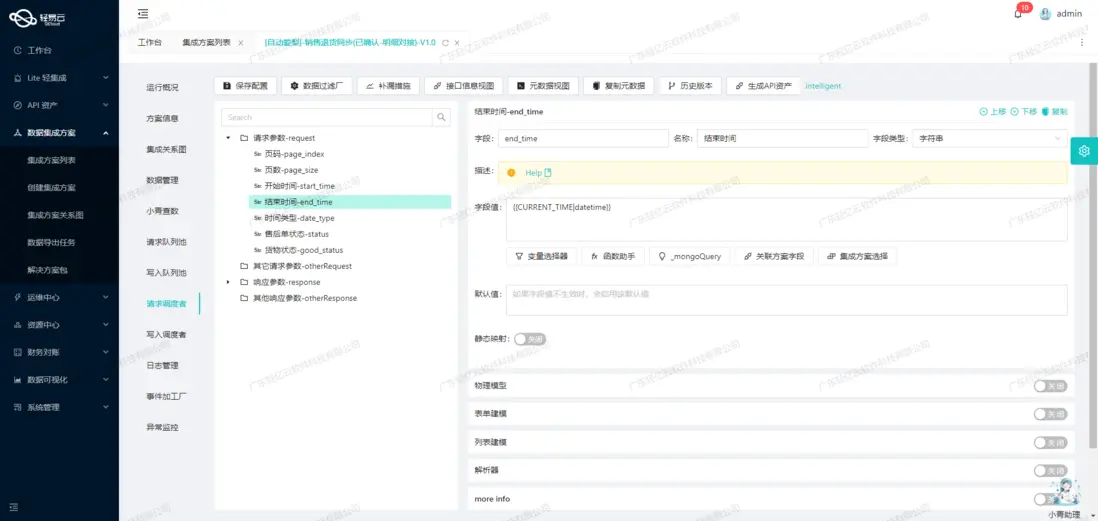

首先,我們需要了解該接口的基本配置和請求參數。根據元數據配置,jushuitan.refund.list.query接口採用POST方法進行查詢操作,其主要參數包括頁碼、頁數、時間範圍、售後單狀態等。這些參數可以靈活設置,以滿足不同業務場景下的數據需求。

{

"api": "jushuitan.refund.list.query",

"method": "POST",

"request": [

{"field": "page_index", "value": "1"},

{"field": "page_size", "value": "50"},

{"field": "start_time", "value": "{{LAST_SYNC_TIME|datetime}}"},

{"field": "end_time", "value": "{{CURRENT_TIME|datetime}}"}

]

}數據抓取與分頁處理

為了確保數據不漏單,我們通常會設置定時任務來定期抓取數據。例如,可以使用Cron表達式設定每天凌晨1點2分執行一次抓取任務:

{

"crontab":"2 1 * * *"

}由於API返回的數據可能會分頁,因此我們需要在每次請求中處理分頁邏輯,確保所有數據都能被完整抓取。具體實現方式可以通過循環遞增頁碼直到沒有更多數據為止。

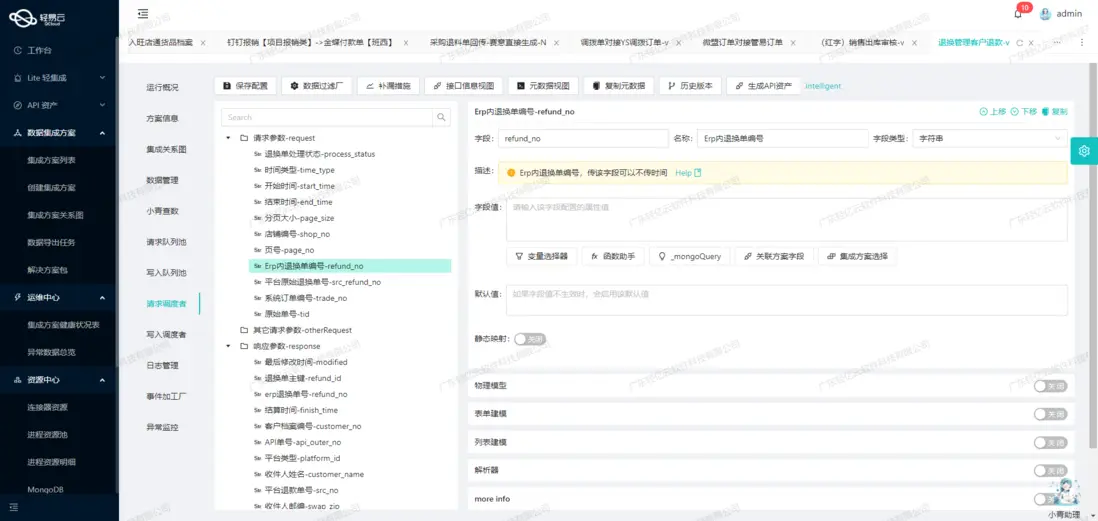

數據清洗與轉換

在獲取到原始數據後,需要對其進行清洗和轉換,以便後續寫入目標系統。在這個過程中,可以利用輕易雲平台提供的自定義數據轉換邏輯功能,對字段進行映射和格式調整。例如,將日期格式統一轉換為標準的ISO8601格式,或者將狀態碼翻譯成人類可讀的描述。

{

"beatFlat":["items"],

"omissionRemedy":{

"takeOverRequest":[

{"field":"start_time","value":"{{DAYS_AGO_1|datetime}}"}

]

}

}異常處理與重試機制

在實際操作中,不可避免地會遇到網絡波動或其他異常情況。為了保證數據抓取的可靠性,需要設計異常處理和錯誤重試機制。當請求失敗時,可以記錄錯誤日誌並觸發重試操作,確保最終能夠成功獲取所需的數據。

實時監控與告警

輕易雲平台提供了強大的監控和告警系統,可以實時跟蹤每個集成任務的狀態和性能。一旦發現異常情況,例如長時間未完成或返回錯誤信息,即可及時發送告警通知給相關人員,從而快速響應和解決問題。

通過以上步驟,我們可以高效地調用聚水潭·奇門接口jushuitan.refund.list.query獲取售後單信息,並對其進行初步加工,為後續的數據存儲和分析打下堅實基礎。這一過程不僅提高了數據處理的自動化程度,還顯著提升了業務透明度和效率。

將已集成的源平台數據進行ETL轉換並寫入MySQL

在數據集成過程中,ETL(Extract, Transform, Load)是關鍵步驟之一。本文重點討論如何將聚水潭·售後單的數據通過ETL流程轉換為目標平台MySQLAPI接口所能接收的格式,並最終寫入MySQL數據庫。

數據抽取與清洗

首先,從聚水潭·售後單API接口提取原始數據。通過調用jushuitan.refund.list.query接口,可以獲取到詳細的售後單信息。這一步驟需要特別注意分頁和限流問題,以確保數據完整性和系統穩定性。

{

"api": "jushuitan.refund.list.query",

"params": {

"page_size": 100,

"page_no": 1

}

}數據轉換

接下來是數據轉換階段,將聚水潭·售後單的數據映射到目標MySQL表的字段。這一步驟需要確保數據格式的一致性,並處理可能存在的字段差異。例如,售後單號as_id、申請時間as_date等字段需要精確映射。

元數據配置如下:

{

"field": "id",

"label": "主鍵",

"type": "string",

"value": "{as_id}-{items_asi_id}"

}在這裏,我們將聚水潭·售後單中的多個字段組合生成一個唯一主鍵,以確保在MySQL中記錄的唯一性。

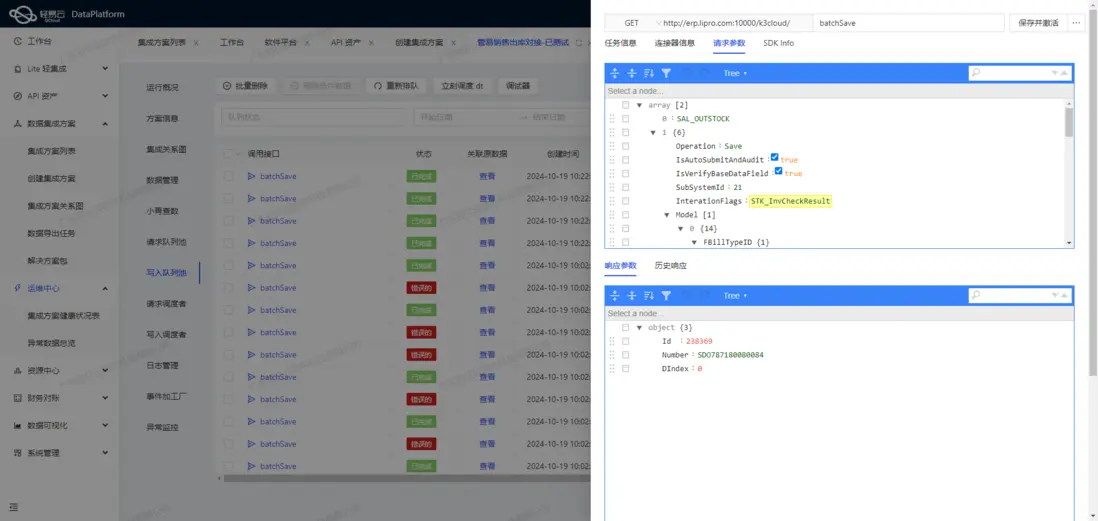

數據加載

最後,將處理後的數據寫入MySQL數據庫。在此過程中,使用批量操作來提高寫入效率。以下是一個示例SQL語句,用於將轉換後的數據插入到目標表中:

REPLACE INTO refund_list_query(

id, as_id, as_date, outer_as_id, so_id, type, modified, status, remark,

question_type, warehouse, refund, payment, good_status, shop_buyer_id,

shop_id, logistics_company, l_id, o_id, order_status, drp_co_id_to,

wh_id, drp_co_id_from, node, wms_co_id, shop_status, freight,

labels, refund_version, sns_sku_id, sns_sn, order_type,

confirm_date, items_outer_oi_id, items_receive_date,

items_i_id, items_combine_sku_id,

items_asi_id, items_sku_id,

items_qty,

items_price,

items_amount,

items_name,

items_type,

items_properties_value,

items_r_qty,

items_sku_type,

items_shop_sku_id,

items_defective_qty,

items_shop_amount,

items_remark,

created,

ts,

shop_name,

order_label,

free_amount,

creator_name,

buyer_receive_refund,

buyer_apply_refund

) VALUES (?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?)通過批量執行上述SQL語句,可以有效提升數據寫入速度,滿足高吞吐量需求。同時,需要配置定時任務來定期抓取和更新聚水潭·售後單的數據,確保數據的實時性和一致性。

異常處理與監控

為了確保整個ETL流程的可靠性,需要實現異常處理與錯誤重試機制。例如,在網絡波動或API調用失敗時,可以進行多次重試。此外,通過集中監控和告警系統,實時跟蹤數據集成任務的狀態和性能,及時發現並處理潛在問題。

自定義轉換邏輯

根據業務需求,可以自定義數據轉換邏輯。例如,對於特定類型的售後單,可以添加額外的數據處理步驟,以適應不同的數據結構和業務規則。這些自定義邏輯可以通過輕易雲平台提供的可視化工具進行配置,使得整個過程更加直觀和易於管理。

綜上所述,通過合理配置元數據並結合高效的ETL流程,可以實現聚水潭·售後單數據向MySQL平台的無縫對接,確保數據完整、準確、高效地加載到目標數據庫中。