美團外賣推薦算法團隊基於HSTU提出了MTGR框架以探索推薦系統中Scaling Law。MTGR對齊傳統模型特徵體系,並對多條序列利用Transformer架構進行統一建模。通過極致的性能優化,樣本前向推理FLOPs提升65倍,推理成本降低12%,訓練成本持平。MTGR離在線均取得近2年迭代最大收益,且於2025年4月底在外賣推薦場景全量。本文系相關工作的實踐與經驗總結,希望能給從事相關方向研究的同學帶來一些幫助。

1. 引言

深度學習中的縮放法則(Scaling Law)是指模型的一些功能屬性(通常指評估的損失Loss或任務的評估指標)與模型架構或優化過程的屬性(例如模型大小、訓練計算量等)之間的關係。直觀的理解就是探索模型算力和效果之間的聯繫,如OpenAI的GPT3、GPT3.5、GPT4在模型參數量、數據量、計算量逐步提升,模型能力(效果)變強。這些法則可以幫助指導深度學習模型的設計和訓練。

在自然語言處理、計算機視覺等領域中,Scaling Law已經被多次驗證其有效性,然而,對於推薦系統則仍處於起步階段。目前影響較大的是工作為Meta的GR(Generative Recommendation)。生成式推薦捨棄了當前推薦系統的大量人工特徵工程,採用了類似於LLM的純序列化表示方式表示用户行為,再通過增大模型計算量的方式提升模型的能力,基於原始信息端到端地預估點擊率/轉化率。

美團外賣推薦場景經過近十年的面向交易目標的迭代,通過傳統DLRM(Deep Learning Recommendation Model)模式進一步提升轉化率變得十分困難。從生成式框架出發,外賣推薦團隊基於HSTU架構針對排序模型進行優化,提出了MTGR(Meituan Generative Recommendation)這一新的架構,成功在美團核心的外賣首頁推薦場景落地。對比基準模型,單樣本前向推理FLOPs提升65倍,離線CTCVR GAUC + 2.88pp,外賣首頁列表訂單量+1.22%(近2年迭代單次優化最大收益),PV_CTR + 1.31%。在資源使用上,訓練成本與基準模型持平,在線推理資源節省12%。該工作於2025年4月底在外賣首頁、頻道頁、小程序等核心場景完成全量。

2. 工業界生成式推薦探索與挑戰

在LLM時代,Scaling Law被證實適用於絕大多數深度學習任務,包括語言模型、圖像生成、信息檢索等。然而,在推薦系統領域中,伴隨用户行為爆炸式增長,傳統DLRM建模不能高效的處理全量用户行為,因此往往通過序列檢索 、特徵工程等方式對重要信息進行加工,但這也同時也限制了模型Scaling的效果。為了解決這一問題,近一年多來,工業界針對生成式推薦展開了系統性探索,主要呈現三種技術路徑:

- 生成式架構:以Meta的GR和快手OneRec為典型,基於類LLM的Transformer架構,結合高效的FlashAttention算子實現自迴歸內容生成。Meta GR使用HSTU通過千億級參數擴展驗證了推薦Scaling law效果,OneRec採用Encoder-Decoder+MoE混合設計,結合DPO優化與獎勵模型實現CTR/CVR與生成任務的多目標兼容。然而這類生成式方法不能使用任何交叉特徵,過度依賴模型從原始的用户行為信號中學習知識,這對於低點擊率且高復購率的外賣業務過於困難。

- 堆疊式架構:如阿里LUM和字節HLLM,通過生成式技術賦能傳統推薦框架。LUM採用預訓練三階段策略平衡模型容量與推理時延,HLLM構建Item/User雙塔LLM分別處理特徵提取與行為預測。這類架構通過離線生成高階特徵實現漸進式升級,但是在迭代範式上過於複雜,通常需要多階段串行優化,極大增加了推薦系統的迭代成本。

- 混合式架構:類似於生成式架構針對訓練數據按用户進行壓縮,減少冗餘計算,但是不嚴格按因果順序組織Token建模用户完整的行為鏈,僅藉助Transformer強大的編碼能力將Token編碼的結果直連曝光物品的CTR/CVR等任務的預估,進而兼容兩類技術優勢。

MTGR也是混合式架構的一種,基於該架構,我們保留包括交叉特徵在內的全部信息進行建模,採用統一的HSTU架構針對多個序列同時編碼提升學習效果;此外,我們對MTGR的訓練、推理框架進行針對性優化,大幅提高了MTGR在混合式架構下的計算性能表現。

3. 外賣業務DLRM範式迭代路徑

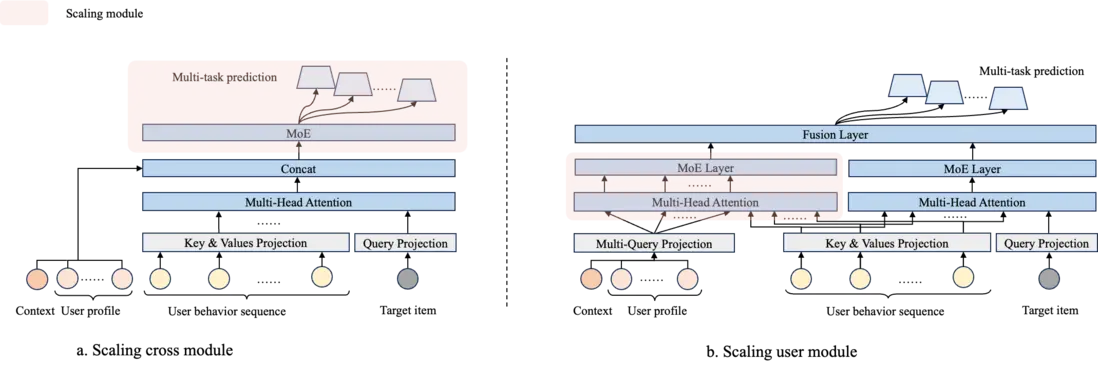

經典的推薦系統模型可以針對需要預估的用户-商品對,根據處理信息不同,可以把模型拆解成三個部分,User module(編碼用户的歷史行為序列等信息),Item module(編碼候選商家的信息)以及Cross module(同時編碼用户和候選的交叉信息)。根據Scaling模塊的不同,我們可以簡單的將過去的迭代劃分為Scaling cross module(圖1a)以及Scaling user module(圖1b)前後兩個不同階段。此外,Item module由於一般包含信息比較簡單,不作為scale up的對象。

- Scaling Cross Module(2018-2022年):在推薦系統逐步步入深度學習階段,迭代以Scaling Cross Module為主,如圖a所示,一個經典的排序模型會將Context(時間、地點、場景等環境特徵)、User profile(登陸頻率、購買頻次、復購傾向等用户畫像特徵)、用户行為序列、預估商家等全部信息在特徵處理完成後拼接在一起,然後通過複雜的非線形映射得到最後的預估值,結合多任務學習,經典的非線形映射方案包括PLE、MoE、DCN、PEPNet等。這些方案從各自的角度出發針對網絡的Cross Module進行優化,起到加速收斂或者平衡多目標學習的作用。外賣算法團隊在過去的迭代中也遵循這一路徑,在早期迭代中嘗試使用類似deepFM、DCN等特徵交叉網絡加速收斂,後期則選擇MoE架構為基座,配合較大的MLP獲取Scaling收益。

- Scaling User Module(2023年):然而Scaling Cross Module存在兩個明顯的缺點限制其效果天花板。1)Scaling存在天花板,網絡複雜度到一定程度後,進一步擴大hidden units或者專家數量,收益不顯著。2)推理不友好,每增加一倍計算資源,相應推理資源也會增加一倍。為了解決上述問題,在2023之後,外賣算法團隊轉向為Scaling User Module。如圖b所示,我們先利用Context以及User profile將其映射成多個Query,然後在與用户行為序列做Multi-Query Attention,隨後通過MoE(16 expert,每個expert包含三層MLP,hidden units為1336、1336、976,MoE輸入維度達2~3k)進一步擴大網絡的計算複雜度,再將得到的結果與原網絡通過Fusion Layer融合進行預測。僅Scaling User Module,可以在預估時通過先統一計算User Module,再將其廣播到不同的樣本上來降低推理成本,最終,我們的方案推理成本少量增加24%,模型FLOPs增長182%,首頁列表訂單量+0.60%。Scaling User Module這一方案使我們的主力模型達到業內計算複雜度較為頭部的水平。

然而,在過去的迭代中,無論是Scaling Cross Module還是Scaling User Module,仍存在以下兩個顯著缺點:1)Scaling依賴於採用MLP捕捉不同特徵之間的共現關係,注意力機制使用相對較少,在深度學習的其他領域中,注意力機制對比MLP往往更加有效。2)無論是何種Scaling方案,在訓練階段都存在較大的資源成本,且優化空間較小。Meta所提出的GR方案較好的解決以上兩個問題,在後續篇幅中,我們將沿着GR所提出的HSTU框架出發,採用混合式架構,儘可能的保留DLRM原始特徵體系,在美團外賣業務中展開落地。

4. 外賣業務生成式推薦落地實踐

4.1 MTGR模型框架

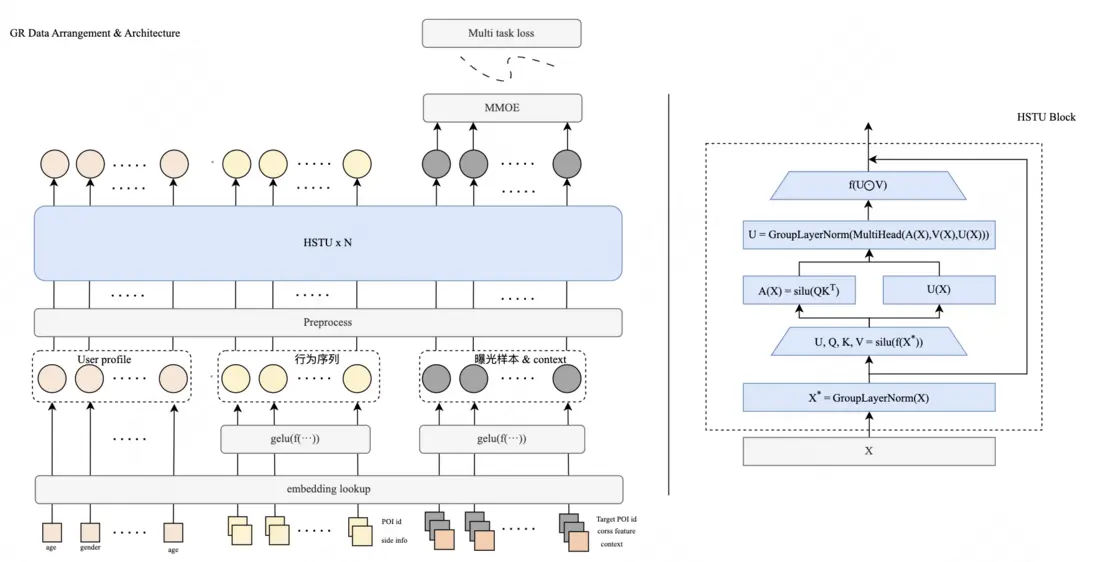

我們所提出的MTGR整體框架如圖2所示,通過MTGR,我們將這些信息編碼成自然語言中的Token,然後利用HSTU架構進行建模。在這個過程中,我們:

- 保留全部DLRM原始特徵,並針對樣本進行無損壓縮,同時建設稀疏化存儲以及計算框架將padding導致的冗餘計算降低至0。

- 利用Group LayerNorm以及動態混合掩碼策略,實現用統一的HSTU架構針對不同語義空間的Token信息進行編碼。

- 我們設計了三種不同尺寸的模型(MTGR-small、MTGR-middle、MTGR-large),驗證了離在線效果的Scaling Law,並使用MTGR-large在美團核心業務中取得顯著受益,並完成全量。

下面,我們將對MTGR的數據、特徵以及模型架構逐一展開介紹。

4.1.1 數據&特徵

在數據與特徵上,我們首先對齊DLRM的特徵,保留了全部的交叉特徵以減少信息損失,其次針對訓練數據按用户粒度實施壓縮來實現MTGR高效訓練,具體的:

對齊DLRM的特徵使用策略:在我們的場景下,如表1結果所示,採用生成式方案完全拋棄交叉特徵會極大的損害MTGR模型性能,為了儘可能的減少信息損失,我們所使用的特徵與DLRM基本一致,這些特徵包括:

- User Profile:用户統計信息,如登陸頻次/購買頻次等。

- Context:用户當前請求的場景信息,如哪個場景,時間,地點。

- User Behaviour Sequence:用户歷史點擊/曝光序列,其中每個item為有用户交互行為的商家,此外還包含了大量side info,包含了商家的各種屬性信息(tag、品牌等)、歷史統計信息(歷史點擊、訂單數量等)、當次交互的細分行為(例如停留時長、子頁面點擊數量等)等,不同請求(用户)的序列長度不同。

- Target item:待打分商家信息,如商家ID、各種該商家的side info以及大量的基於統計的交叉特徵。

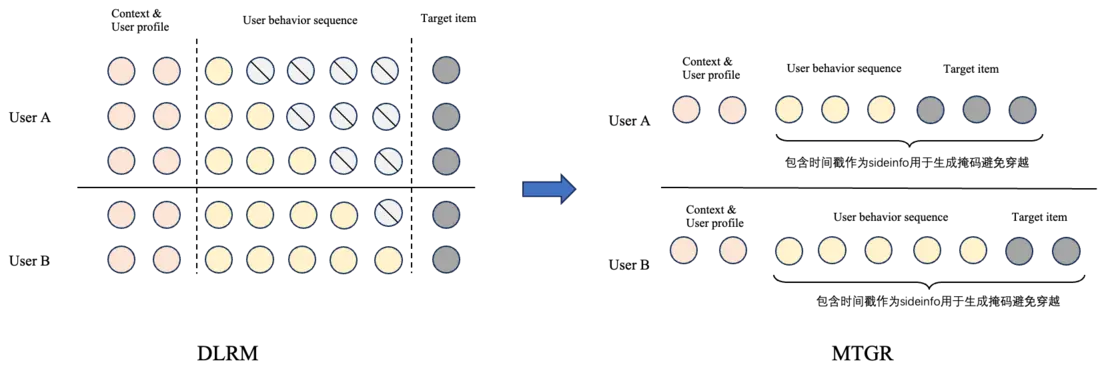

- 按用户粒度壓縮訓練數據:如圖3所示,左圖表現了傳統DLRM數據組織方式,針對用户的N個曝光,在數據組織中需要存N行,在處理不同長度的序列數據時,往往使用padding進行補全。在DLRM訓練時,對同一個用户的N行樣本存在大量重複編碼,導致計算效率較低,甚至需要結合負採樣降低樣本量和訓練成本。為了解決這一問題,對於訓練數據,MTGR針對用户粒度進行壓縮,如圖3右所示,將同一用户N行樣本壓縮成一行,同時我們採用稀疏化存儲,配合JaggedTensor以及變長的HSTU算子,拋棄了全部padding操作以降低無效存儲和冗餘計算。額外的,為了避免訓練穿越,對於用户行為序列以及target item,我們在數據中保存了其發生的原始時間戳,以用於生產掩碼保證正確的因果性,具體的掩碼細節將在下一節展開介紹。

4.1.2 模型架構

在模型架構上,我們首先將輸入信息Token化,再針對不同類型Token進行Group LayerNorm,並設計了一種特殊的動態混合掩碼策略,以實現用統一的HSTU架構針對不同序列、用户信息、Target信息進行統一編碼。具體的:

- 輸入信息Token化:我們將樣本信息拆分成一個個Token。其中對於User Profile每一個特徵都表示為一個Token,對於用户行為,則將每一個具體行為對應的item ID以及多個side info的Embedding表徵拼接在一起再通過非線形映射組裝成一個Token。同理,對於每一個曝光,我們則將item ID、對應的side info、交叉特徵、時空等Context信息拼接在一起組成一Token。

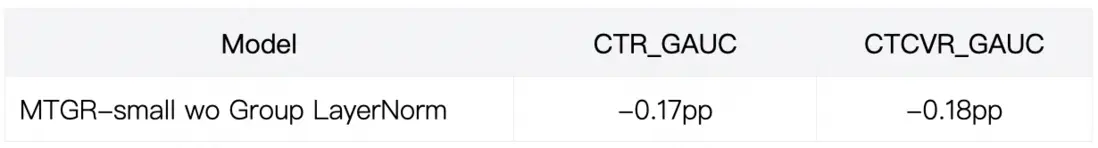

- 採用HSTU架構統一建模多個序列:我們利用HSTU架構針對Token化的輸入進行統一編碼,對比原方法,我們對每一層的輸入都做了額外的LayerNorm以保證深層次訓練的穩定性,考慮到不同與傳統的LLM,我們的數據可以分組為多種類型的Token,因此,我們將LayerNorm拓展為Group LayerNorm,針對不同類別的Token採用不同的LayerNorm參數,以實現不同語義空間下Token的對齊,下表展現了採用Group LayerNorm的離線效果。

-

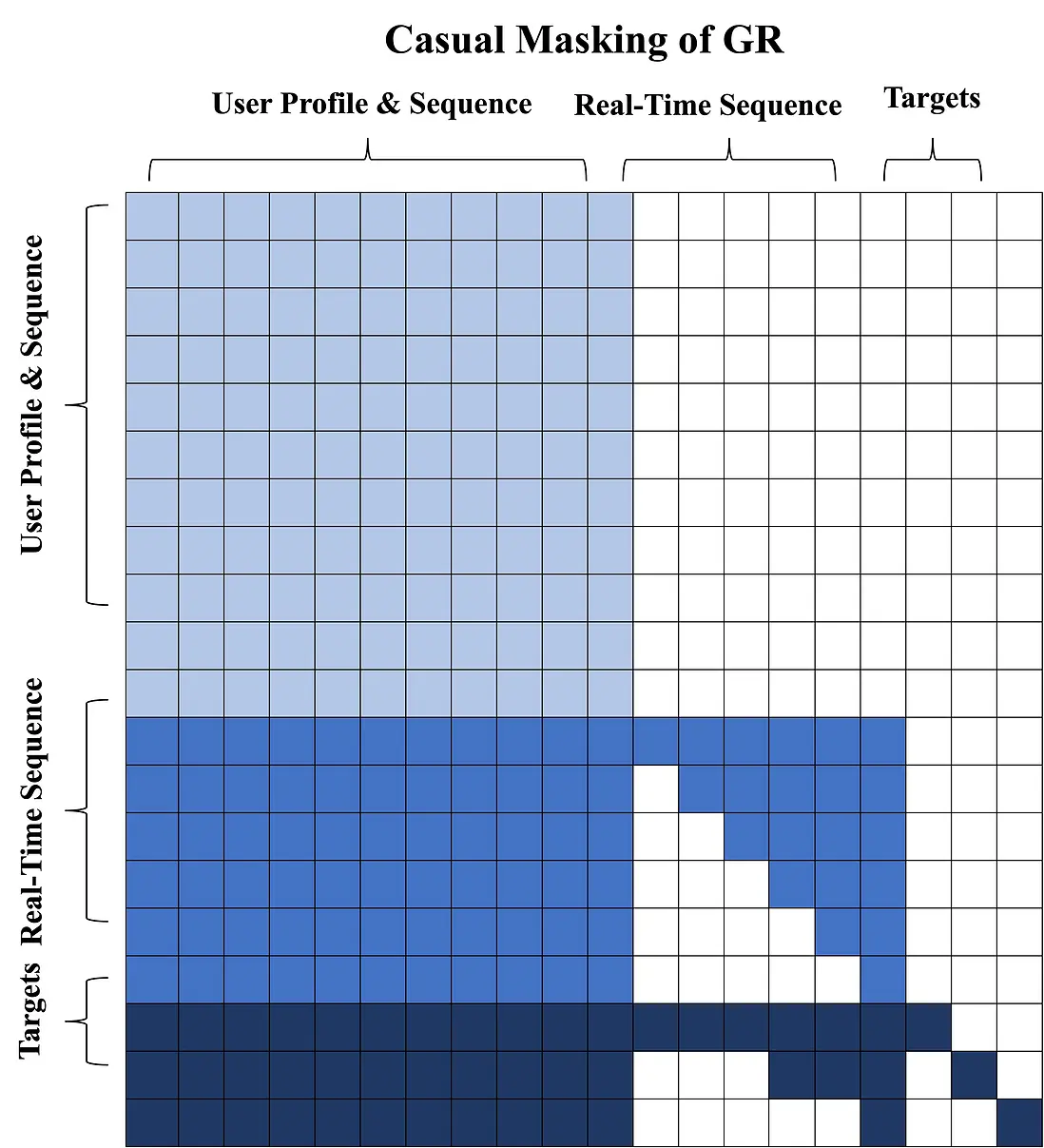

引入動態混合掩碼:我們將Token簡單分為歷史靜態特徵(User Profile & Sequence),當日實時行為(Real-Time Sequence),以及曝光樣本(Targets)三個部分。我們採用一種動態混合掩碼,具體掩碼策略如下圖所示,對於歷史靜態特徵我們不進行任何掩碼操作,對於當日實時行為採用Causal mask,並結合時間戳過濾未來事件。具體來説,在訓練時我們按照用户一天曝光數據進行聚合,並取最後一條實時行為。實時行為/曝光樣本按照時間近至遠進行排列,更遠發生的實時行為看不到更近發生的實時行為。同Targets中存在部分曝光出現在某些實時行為之前,因此需要結合兩者時間戳計算掩碼,保證較早發生的Targets看不到較晚發生的實時行為。我們以圖4為例展開説明:

- 標有顏色表示可以被看見,每一行表示該Token可以看到哪些Token,每一列表示該Token可以被哪些Token看到。

- 實時行為/曝光樣本按照時間近至遠進行排列:最近發生的曝光樣本可以看到全部的實時行為,但較早發生的曝光樣本只能看到部分實時行為。

- 對於Target 1,因為它出現的時間較晚,因此它可以看到全部的User Profile & Sequence以及Real-Time Sequence;對於Target 2,有一部分Real-Time Sequence出現在其之前,因此它只能看到部分Real-Time Sequence。

表3展示了採用動態混合掩碼對比傳統因果掩碼的離線效果,採用動態混合掩碼可以更好的發揮HSTU作為encoder的學習能力。

4.2 MTGR訓推引擎

相比傳統DLRM模型,GR模型的訓練和推理面臨嚴峻挑戰:

- 訓練數據和稠密網絡參數規模scale導致離線訓練計算量激增:按照Scaling Law的指導,模型效果的提升來自訓練數據量和模型參數量的增加,帶來訓練計算量的大幅增加。

- 稀疏Embedding規模scale導致離線訓練存儲規模激增:新模型範式引入更多的樣本和特徵,導致Embedding數據量大幅膨脹,給Embedding的分佈式存儲和通信帶來嚴峻的性能挑戰。

- 在線推理模型規模和計算量伴隨模型scale激增:模型大小和計算量膨脹顯著,需要更強算力、更大顯存的GPU加速卡,或者考慮CPU-GPU聯合推理的異構計算模式。

為了解決上述問題,我們建設了MTGR模型訓推引擎,解決模型計算量和存儲量激增帶來的諸多性能挑戰。包含兩個核心組件:

- MTGR-Training:支持低成本、高效率大規模分佈式訓練。

- MTGR-Inference:支持低延遲、高吞吐大規模線上推理部署。

4.2.1 MTGR-Training

我們基於TorchRec構建了簡單易用、高性能、可擴展的GR模型訓練引擎MTGR-Training,可支持千億參數、100GFLOPs/example甚至更大計算量的模型的高效分佈式訓練。

如圖5所示,系統框架分成三層:

- 最底層是TorchRec。TorchRec是Meta開源的稀疏模型訓練框架,我們對其做了一些功能上的擴展,例如支持動態Hashtable、梯度累積等,滿足業務的實際需求。另外,GR模型的Dense部分可能也會變得很大,我們借鑑LLM社區的模型並行方案(例如FSDP/Megatron)進行支持。

- 中間層就是MTGR-Training,我們的主要工作也集中在這層,其對訓練流程進行了封裝,包括離線/流式數據讀取、訓練評估流程、斷點續訓、離在線一致性校驗、warm-start等。同時,給用户暴露簡單的模型定義接口。

- 最上層是算法模型層,不同業務根據我們提供的接口定義自己的算法模型。

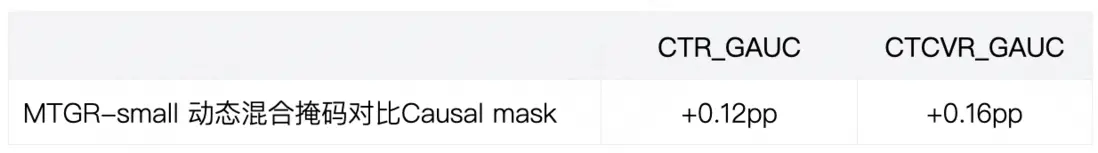

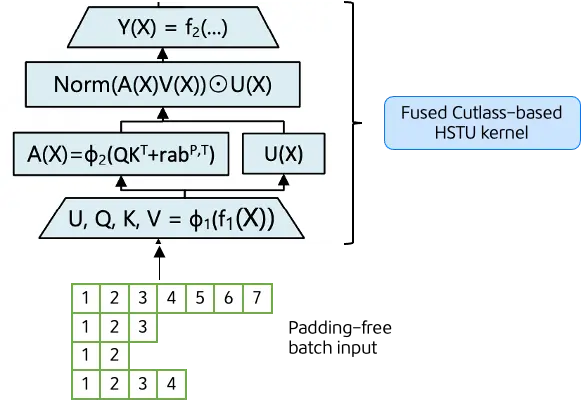

MTGR-Training具體的功能支持和性能優化工作總結如下表4所示:

下面重點介紹下Kernel優化和變長序列負載均衡的工作:

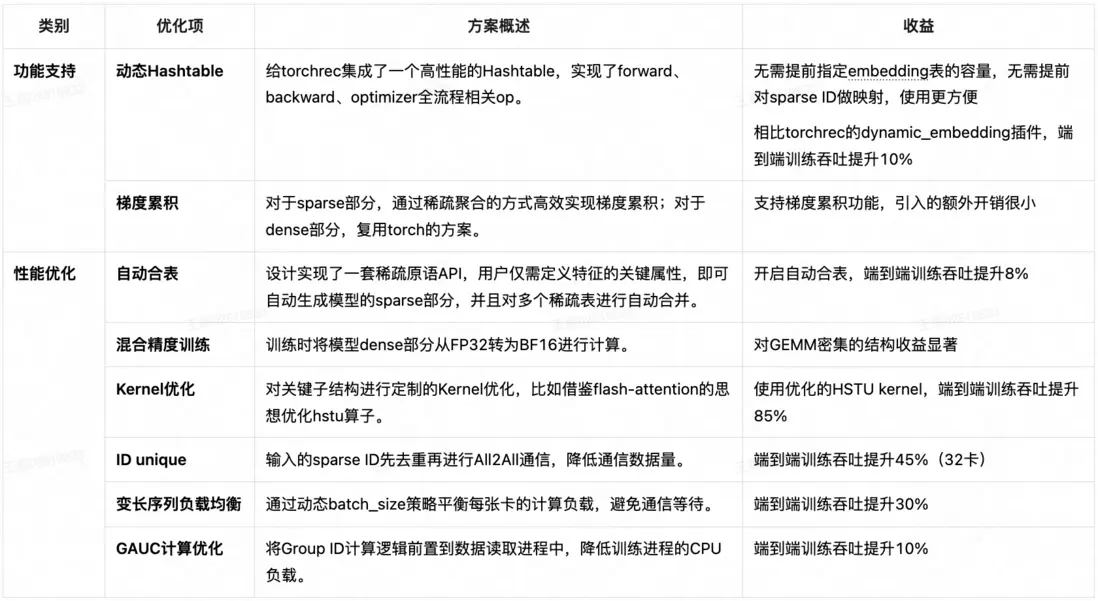

- Kernel優化:GR模型中最核心的計算單元就是Attention模塊——HSTU。原始的pytorch實現存在算子細碎、無法支持動態序列長度、計算效率低下等問題;Triton版本的實現一定程度上解決了這個問題,但仍有較大優化空間。最終我們借鑑flash-attention的思想手寫了Fused Cutlass-based HSTU kernel,通過減少內存讀寫次數,提高 GPU 的內存 IO 效率;同時支持變長序列的輸入無需padding,大幅提升了Attention的計算效率,單算子性能相較於Triton版本提升2~3倍。

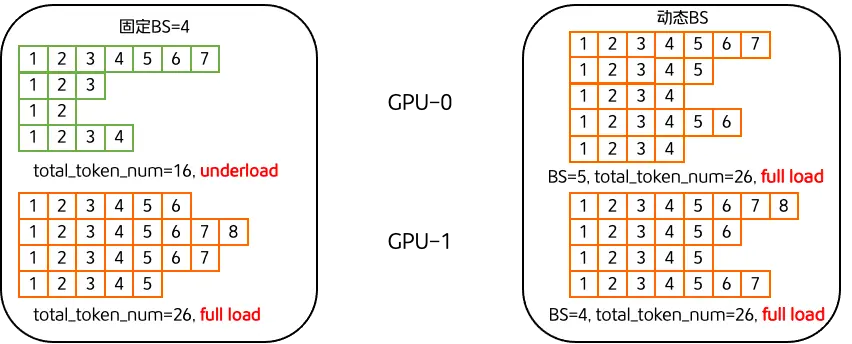

- 變長序列負載均衡:GR模型的樣本是按照用户維度去組織的,而在推薦系統中,用户序列呈現明顯的長尾分佈:少數用户的序列很長,大部分用户的序列都比較短。因此固定batch_size(下文簡稱為BS)訓練時,每張卡的計算量差別比較大,計算量大的卡會拖慢整個訓練流程,因為在同步訓練模式下,每個step都得等所有卡計算完才能進行梯度同步。同時為了避免出現GPU顯存OOM,BS也不能預設的很大,這導致GPU並沒有被充分利用。我們的解決思路也比較直觀,就是引入動態BS,每張卡的BS根據實際數據的序列長度動態調整,保證計算量(total_tokens)基本相同;同時修改梯度聚合策略,按照BS對每張卡的梯度進行加權,保證計算邏輯的一致性。如圖7所示,假設2張卡進行同步訓練,固定BS=4時,卡0上的用户序列比較短,是underload的,存在資源的浪費;切換到動態BS後,比較短的用户序列會組成更大的batch(4 -> 5),從而保證所有卡都是full load的,進而最大化系統吞吐。

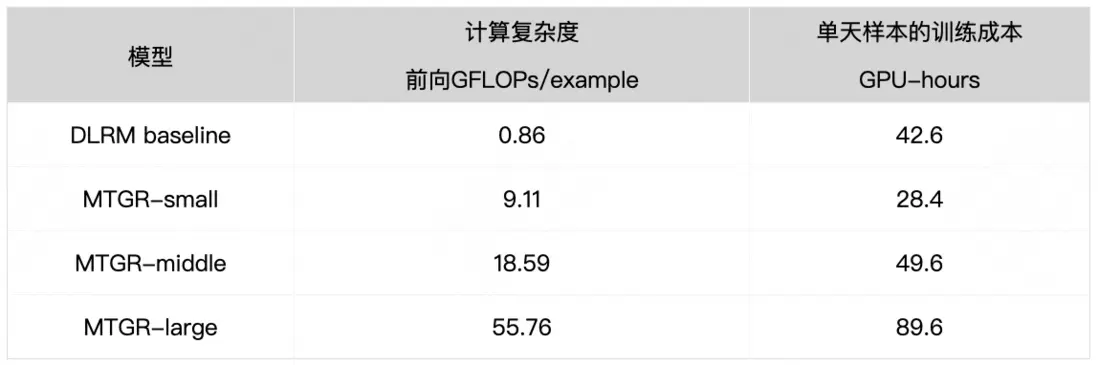

總的來説,得益於用户粒度的樣本聚合方式使得相同用户的大部分計算可以共享,以及MTGR-Training的諸多優化,最終我們實現了GR模型的訓練成本相比DLRM baseline增加很少,有效控制了訓練成本。如表5所示,不採用任何序列採樣策略時,65倍計算複雜度GR模型訓練成本相比DLRM baseline,只增加了1倍。

4.2.2 MTGR-Inference

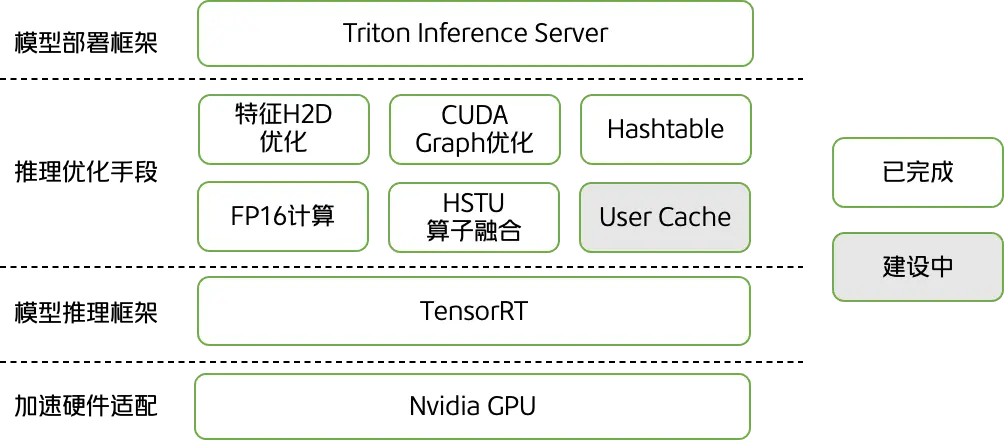

基於Nvidia軟件生態,我們構建了高性能的GR模型推理引擎MTGR-Inference:

- 選擇TensorRT作為模型推理框架:TensorRT是Nvidia推出的推理優化框架,在業界廣泛應用,具有較強的算子融合、低精度量化能力。

- 選擇Triton Inference Server作為模型部署框架:Triton Inference Server是Nvidia推出的高性能模型部署框架,在業界廣泛應用,是TensorRT官方推薦的模型部署方案。

如圖8所示,系統框架分成四層:

- 最底層是硬件層,主要適配Nvidia GPU;

- 再上層是模型推理框架層,基於TensorRT。

- 中間是我們引入的各種推理優化手段,包括特徵H2D優化、CUDA Graph優化、HashTable等。其中Hashtable面向推理場景進行了極致優化,閹割掉了寫的功能,進一步提升了性能。

- 最上層是模型部署層,基於Triton Inference Server進行部署。

下面詳細介紹各種優化手段:

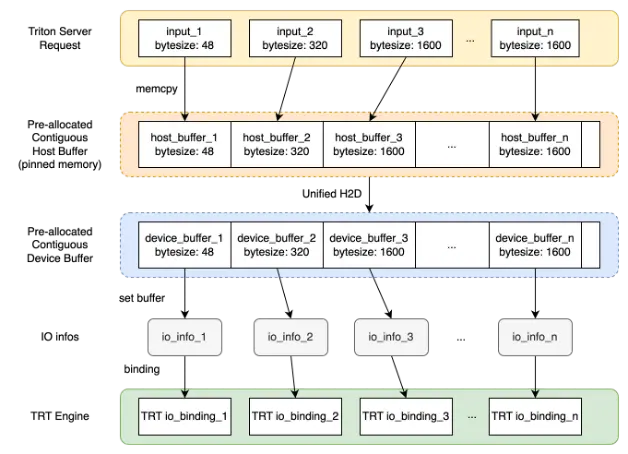

- 特徵H2D優化:推薦模型一般都包含數百個特徵,將特徵從Host讀到GPU時,有較大的傳輸耗時。為了解決這個問題,我們採取了先merge後split的思路:即在Host buffer中預先開闢一塊連續的空間,將不同特徵拷貝至這個空間,再統一進行一次H2D,從而充分利用傳輸帶寬。傳輸到GPU上後,再進行split。這個方案雖然簡單,但是收益比較顯著,H2D耗時從7.5ms減少至12us,整體推理延遲從19ms減少至12ms(時延降低37%),吞吐從68 req/s提升至94 req/s(吞吐提升38%)。

- CUDA Graph優化:在我們的場景下,使用CUDA Graph優化後吞吐提升13%,不同QPS壓力下,Avg延遲降低17%~52%,P99延遲降低16%~57%。

- FP16計算:FP16推理具有內存佔用少、計算速度快等優勢。在我們的場景下,使用FP16格式進行推理,相比FP32,吞吐提升50%;精度幾乎無損(相比FP32打分diff控制在0.006以內)。

4.3 Scaling效果

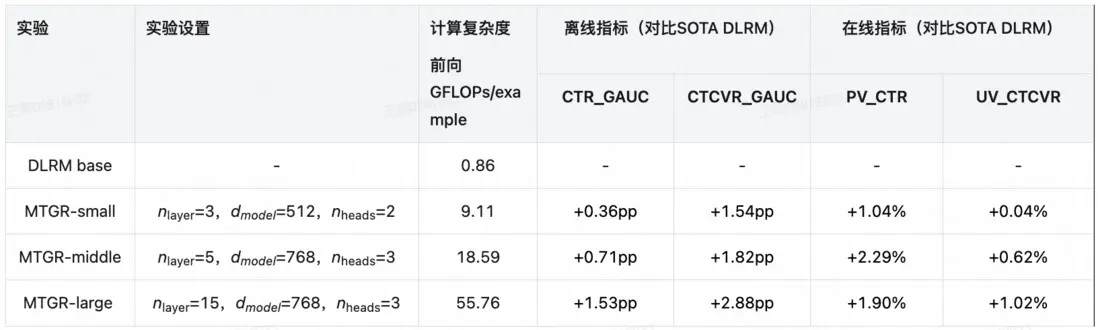

為了驗證Scaling Law,我們設置了small、middle、large三種不同大小的MTGR模型與當前在線最好的DLRM base(Scaling User Module)進行對比。對於small、middle兩個版本,我們序列的最大長度設置為3k;對於large版本,為了權衡訓練效率,最大長度設置為1k。

當前DLRM base在線經歷了超過2年的學習,水位線較高,MTGR則僅採用2024.10之後近半年的數據進行訓練。表6展現了不同尺寸的MTGR模型離在線效果,儘管數據上有所劣勢,MTGR離在線各個指標仍大幅超越了DLRM base。除了這三種尺寸外,我們離線階段最大實現了深度22層,d_{model}=1024,計算複雜度達137.87GFLOPs(約160倍DLRM)的超大規模模型,並取得了更高的離線結果,但是受推理性能限制並沒有進一步在線實驗。

此外,在驗證Scaling Law過程中,除了傳統的增加深度、寬度外,我們還特別伴隨不同的模型尺寸,同步增大稀疏參數的大小(調整embedding dim),該參數作為超參數存在,且針對不同尺寸的模型以及不同類型的Token分開設置,假設某一個Token由k個特徵組成,每個特徵的embedding dim通常會被設置為d_{model}/k附近的整數。

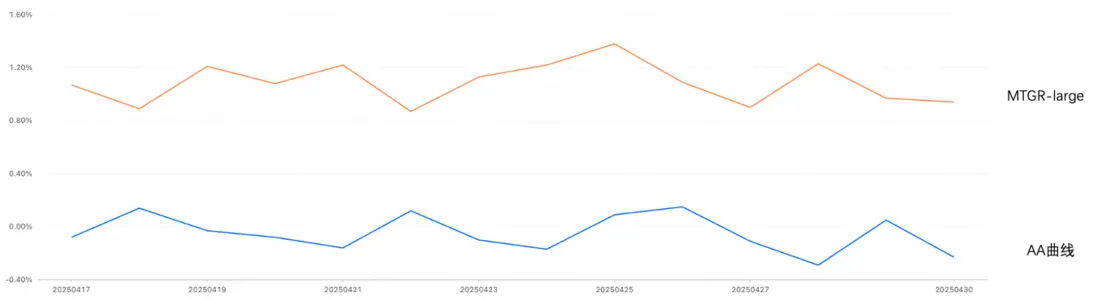

我們基於MTGR-large在美團外賣推薦業務中完成了全量,對比之前SOTA的DLRM base,MTGR單樣本前向FLOPs提升65倍,達到55.76GFLOPs,圖10給出了AB test階段MTGR-large對比DLRM訂單收益曲線。

對於訓練資源,採用與GR原方案一致的隨機長度採樣策略,優化後訓練成本降低至與DLRM持平,且離在線效果基本無損;對於推理資源則節省12%,推理資源下降是由於對比DLRM,MTGR在推理階段資源消耗對於候選數量不敏感,對比DLRM需要多分片推理來降低耗時,MTGR採用單分片推理即可,較好的提升了在線吞吐。

5. 總結與展望

Scaling Law已成為當下深度學習的基本準則,但是在推薦系統領域中的探索還相對較少,我們基於HSTU提出了MTGR這一新的排序框架。MTGR保留與DLRM一致的特徵體系,以避免生成式架構下丟失交叉特徵帶來的信息損失;在序列編碼方式上,我們結合Group LayerNorm以及動態混合掩碼策略提升HSTU學習效果;此外,我們還針對MTGR的訓練與推理框架做了針對性優化以減少資源消耗。最終,MTGR在我們的實際業務中取得了離線CTCVR GAUC + 2.88pp,首頁列表訂單量+1.22%,PV_CTR + 1.31%的收益;同時在資源上,訓練資源持平,在線推理資源節省12%。

在未來,我們將與各部門繼續展開緊密合作,針對以下方向持續進行探索:

- 結合LBS業務特點優化原始HSTU結構突出時空屬性,進一步優化當前排序效果。

- 建立多業務全場景MTGR模型。建設基於User Center的生成式推薦框架,結合KV Cache提升全場景推理效率。

- 粗排+排序階段融合。結合LBS下供給數量有限的特點,利用MTGR實現粗排+精排一段式打分。

6. 團隊招聘

算法團隊來自搜索和推薦平台部/外賣搜推算法組,負責外賣主站、以及神搶手和拼好飯等業務的搜索、推薦、大模型應用算法,業務核心,技術能力強,每年有多篇論文發表在KDD、SIGIR、CIKM等會議上。當前,MTGR仍在深度迭代中,機會廣闊潛力大,歡迎各路英才加入,聯繫方式:jiangfei05@meituan.com。

工程團隊來自搜索和推薦平台部/機器學習引擎組,負責美團各業務的搜索推薦機器學習引擎的工程架構工作,包括模型訓練,模型推理,用户特徵平台建設等。團隊技術能力強,工作氛圍好,當前正在深度探索下一代搜推架構等多個前沿方向,歡迎感興趣的同學加入,聯繫方式:yulei37@meituan.com。

7. 參考文獻

- [1] Zhai J, Liao L, Liu X, et al. Actions speak louder than words: Trillion-parameter sequential transducers for generative recommendations[J]. arXiv preprint arXiv:2402.17152, 2024.

- [2] Fang Y, Zhan J, Ai Q, et al. Scaling laws for dense retrieval[C]//Proceedings of the 47th International ACM SIGIR Conference on Research and Development in Information Retrieval. 2024: 1339-1349.

- [3] Pi Q, Zhou G, Zhang Y, et al. Search-based user interest modeling with lifelong sequential behavior data for click-through rate prediction[C]//Proceedings of the 29th ACM International Conference on Information & Knowledge Management. 2020: 2685-2692.

- [4] Si Z, Guan L, Sun Z X, et al. Twin v2: Scaling ultra-long user behavior sequence modeling for enhanced ctr prediction at kuaishou[C]//Proceedings of the 33rd ACM International Conference on Information and Knowledge Management. 2024: 4890-4897.

- [5] Deng J, Wang S, Cai K, et al. OneRec: Unifying Retrieve and Rank with Generative Recommender and Iterative Preference Alignment[J]. arXiv preprint arXiv:2502.18965, 2025.

- [6] Yan B, Liu S, Zeng Z, et al. Unlocking Scaling Law in Industrial Recommendation Systems with a Three-step Paradigm based Large User Model[J]. arXiv preprint arXiv:2502.08309, 2025.

- [7] Chen J, Chi L, Peng B, et al. Hllm: Enhancing sequential recommendations via hierarchical large language models for item and user modeling[J]. arXiv preprint arXiv:2409.12740, 2024.

- [8] Tang H, Liu J, Zhao M, et al. Progressive layered extraction (ple): A novel multi-task learning (mtl) model for personalized recommendations[C]//Proceedings of the 14th ACM conference on recommender systems. 2020: 269-278.

- [9] Jacobs R A, Jordan M I, Nowlan S J, et al. Adaptive mixtures of local experts[J]. Neural computation, 1991, 3(1): 79-87.

- [10] Wang R, Shivanna R, Cheng D, et al. Dcn v2: Improved deep & cross network and practical lessons for web-scale learning to rank systems[C]//Proceedings of the web conference 2021. 2021: 1785-1797.

- [11] Chang J, Zhang C, Hui Y, et al. Pepnet: Parameter and embedding personalized network for infusing with personalized prior information[C]//Proceedings of the 29th ACM SIGKDD Conference on Knowledge Discovery and Data Mining. 2023: 3795-3804.

- [12] Guo H, Tang R, Ye Y, et al. DeepFM: a factorization-machine based neural network for CTR prediction[J]. arXiv preprint arXiv:1703.04247, 2017.

閲讀更多

| 關注「美團技術團隊」微信公眾號,在公眾號菜單欄對話框回覆【2024 年貨】、【2023 年貨】、【2023 年貨】、【2022 年貨】、【2021 年貨】、【2020 年貨】、【2019 年貨】、【2018 年貨】、【2017 年貨】等關鍵詞,可查看美團技術團隊歷年技術文章合集。

| 本文系美團技術團隊出品,著作權歸屬美團。歡迎出於分享和交流等非商業目的轉載或使用本文內容,敬請註明 "內容轉載自美團技術團隊"。本文未經許可,不得進行商業性轉載或者使用。任何商用行為,請發送郵件至 tech@meituan.com 申請授權。