【01 論文概述】

論文標題:

Uniworld-V2:ReinforceImageEditingwithDiffusionNegative-awareFinetuningandMLLMImplicitFeedback

作者團隊:北京大學

發佈時間:2025 年 10 月 21 日

論文鏈接:<u>https://arxiv.org/pdf/2510.16888</u>

Lab4AI 大模型實驗室鏈接:

<u>https://www.lab4ai.cn/paper/detail/reproductionPaper?utm_source=jssq/_sf_edit&id=2b0294f7c8b14a099ced8cce7466f48d</u>

1.研究背景

當前基於指令的圖像編輯雖藉助擴散模型取得進展,但仍面臨三大核心挑戰:

l 監督微調(SFT)的固有缺陷:現有模型多依賴 SFT 訓練,易過擬合標註模式,導致泛化能力差(無法突破訓練分佈)、可控性不足(忽略複雜指令,僅重構輸入),且依賴大規模但多樣性低的數據集,進一步削弱跨任務的指令保真度。

l 強化學習(RL)在擴散模型中的應用瓶頸:RL 雖為模型對齊人類意圖的潛在方向,但現有策略優化方法(如基於似然估計)存在系統偏差,且一階 SDE 採樣器需在“軌跡多樣性”與“生成質量”間權衡,難以滿足圖像編輯對高保真和多樣化探索的雙重需求。

l 通用獎勵模型的缺失:圖像編輯指令和任務具有多樣性,導致缺乏統一獎勵模型。MLLM 雖適合主觀評估,但現有 MLLM 評分方法存在缺陷:基於 Chain-of-Thought(CoT)的方法易引入暴露偏差且計算成本高,基於採樣的方法信號稀疏,而領域微調需複雜數據集以避免偏差和災難性遺忘,成本高昂。

2.研究目的

針對上述挑戰,本研究旨在:

l 突破SFT 範式的泛化性與可控性限制,解決擴散模型結合 RL 時的策略優化偏差問題;

l 構建通用、低成本、低幻覺的獎勵模型,避免依賴複雜數據集或引入額外偏差;

l 提出一套高效的訓練後優化框架(Edit-R1),提升不同基礎擴散模型(如 UniWorld-V2、Qwen-Image-Edit、FLUX.1-Kontext)在指令圖像編輯任務中的性能與泛化能力,同時保證模型無關性(model-agnostic)。通過策略優化方法直接對齊生成過程與人類意圖,避免對領域特定獎勵模型的依賴。

3.核心貢獻

l 提出Edit-R1 訓練後優化框架:整合兩種關鍵技術——DiffusionNegative-awareFinetuning(DiffusionNFT,一種與流匹配前向過程一致的無似然策略優化方法,支持黑箱採樣器、decouple 訓練與採樣)和基於預訓練 MLLM 的無訓練獎勵模型,實現擴散模型的高效微調。

l 驗證獎勵信號的人類對齊性:所設計的MLLM 獎勵信號(非 CoT+logit-based 評分)無需訓練或複雜推理,能提供與人類偏好高度對齊的反饋,兼具可靠性、低成本與低幻覺特性,有效穩定訓練過程。

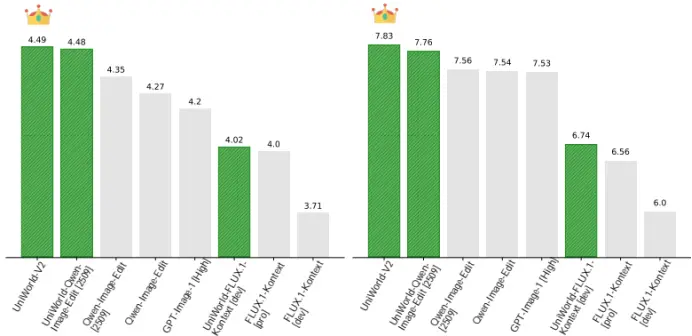

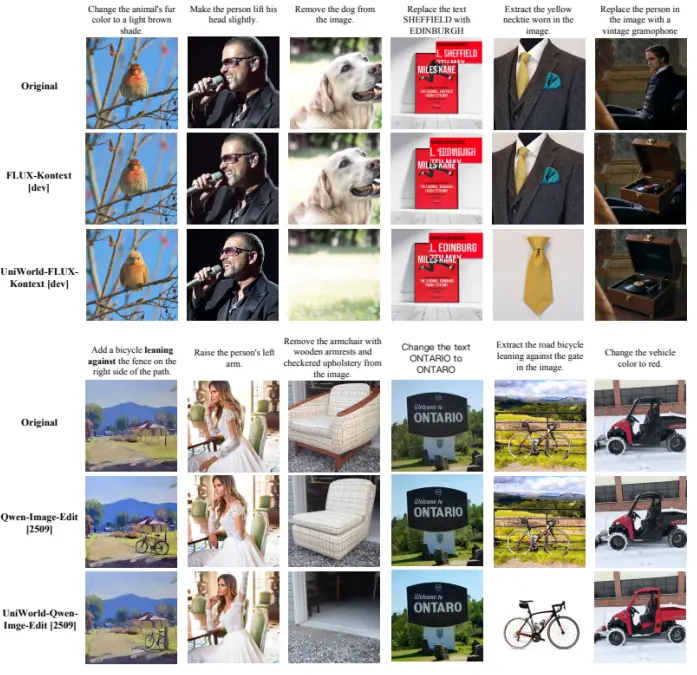

實證性能提升與泛化能力:實驗表明,Edit-R1 可顯著提升多種基礎模型性能:在 ImgEdit 和 GEdit-Bench 基準上,UniWorld-V2 取得 SOTA 結果(分別為 4.49、7.83),FLUX.1-Kontext[Dev]微調後超越其 Pro 版本,Qwen-Image-Edit[2509]成為開源模型中的 SOTA;同時框架具有模型無關性,可適配不同基礎模型。

4. 研究方法

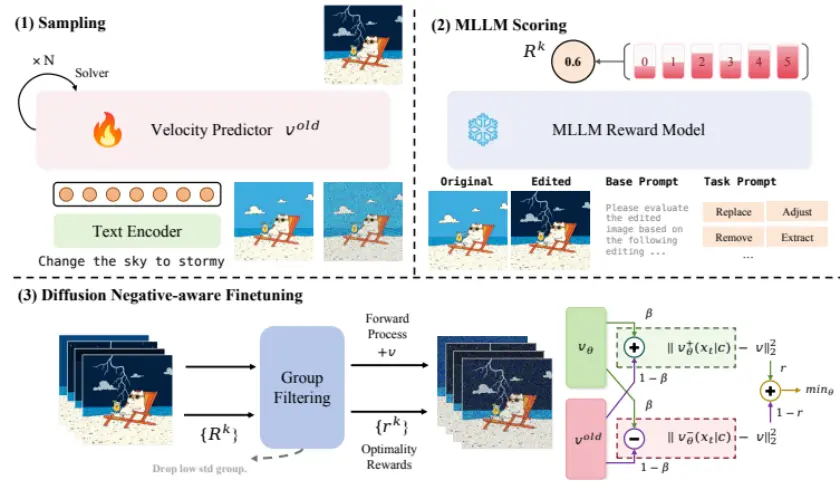

本研究的核心方法圍繞Edit-R1 框架展開,包含三大核心組件與完整流程:

l 策略優化:採用DiffusionNFT,一種基於流匹配前向過程的無似然策略優化方法,支持高階採樣器並避免偏差。

l 獎勵設計:

使用MLLM 的非 CoTlogit 評分機制,直接計算得分令牌的期望值作為獎勵。

通過任務定製化提示詞(基礎指令+ 任務指令)實現細粒度評估。

l 訓練流程:

採樣:利用 DPM-Solver 快速生成候選圖像組。

評分:MLLM 對編輯結果進行隱式反饋打分。

優化:通過 DiffusionNFT 損失函數更新模型,結合組過濾機制剔除低方差高均值樣本。

5.研究結果

5.1 基準測試性能

l ImgEdit 基準:UniWorld-V2 達到 SOTA(4.49 分),Qwen-Image-Edit 提升至 4.48 分,超越閉源模型(如 GPT-Image-1)。

l GEdit-Bench 基準:UniWorld-V2 取得 7.83 分,顯著優於基線模型。

l 泛化能力:在域外數據上(如GEdit-Bench),所有基礎模型均獲得穩定提升。

5.2 人類偏好評估

用户研究表明,優化後的模型在指令遵循和圖像質量上更受青睞。微調後的UniWorld-FLUX.1-Kontext 在“指令對齊”維度顯著優於 FLUX.1-Kontext[Dev]與 Pro 版本,整體偏好度更高(圖 6)。

5.3 消融實驗結果

策略優化方法對比:在FLUX.1-Kontext[Dev]上,DiffusionNFT 在 ImgEdit 基準的性能顯著優於 Flow-GRPO 及 Flow-GRPO+LocalStd(圖 7)。

核心組件貢獻:Qwen-Image-Edit[2509]上,僅 DiffusionNFT(7BMLLM)提升至 7.66,32BMLLM 進一步提升至 7.74,加入組過濾後達 7.76(表 3)。

6.總結與展望

本研究針對指令圖像編輯的泛化性、可控性及獎勵模型難題,提出Edit-R1 框架:通過 DiffusionNFT 實現無似然策略優化,結合無訓練的 MLLM 獎勵模型(非 CoT+logit-based),解決了 SFT 的過擬合與 RL 策略優化的偏差問題。該框架在 ImgEdit、GEdit-Bench 基準上取得 SOTA,可適配多種基礎模型,且獎勵信號與人類偏好高度對齊,為指令圖像編輯提供了高效、通用的訓練後優化方案。

【02 論文原文閲讀】

您可以跳轉到Lab4AI 平台上去閲讀論文原文。

Lab4AI大模型實驗室已經提供該論文,閲讀鏈接:

https://www.lab4ai.cn/paper/detail/reproductionPaper?utm_sour...

文末點擊閲讀原文,即可跳轉至對應論文頁面。目前,論文的復現工作還在招募中,歡迎各位感興趣的朋友報名參與復現創作,我們提供一定額度的H800 算力作為獎勵。

·Lab4AI.cn覆蓋全週期科研支撐平台,提供論文速遞、AI翻譯和AI導讀工具輔助論文閲讀;

·支持投稿論文復現和Github項目復現,動手復現感興趣的論文;

·論文復現完成後,您可基於您的思路和想法,開啓論文創新與成果轉化。

本文由AI 深度解讀,轉載請聯繫授權。關注“大模型實驗室 Lab4AI”,第一時間獲取前沿 AI 技術解析!