面向智能體與大語言模型的 AI 基礎設施:選項、工具與優化

本文探討了用於部署和優化 AI 智能體(AI Agents)與大型語言模型(LLMs)的各類基礎設施選項及工具。

無論採用雲、本地還是混合雲部署,基礎設施在 AI 架構落地過程中都起着關鍵作用。本文是 AI 基礎設施系列文章的一部分,聚焦於部署和優化 AI 智能體與大語言模型的多樣化基礎設施選擇,深入剖析了基礎設施在 AI 架構(尤其是推理環節)實現中的核心價值。我們將詳細介紹包括開源解決方案在內的各類工具,通過圖表展示推理流程,並強調高效、可擴展 AI 部署的關鍵考量因素。

現代 AI 應用對基礎設施提出了精密化要求——需承載大語言模型的計算強度、多智能體系統的複雜性,以及交互式應用的實時性需求。核心挑戰不僅在於選擇合適的工具,更在於理解這些工具如何在整個技術棧中協同集成,從而交付可靠、可擴展且經濟高效的解決方案。

本指南涵蓋 AI 基礎設施的全維度內容,從硬件加速、模型服務到監控與安全,詳細解析了經過生產環境驗證的開源工具、架構模式及實施策略。

一、AI 基礎設施在架構中的核心作用

AI 架構定義了 AI 系統構建與部署的藍圖,而基礎設施則是支撐該架構落地的基石。對於 AI 智能體與大語言模型而言,基礎設施直接影響系統性能、可擴展性、成本與可靠性。設計精良的基礎設施能夠實現:

- 更快的推理速度:低延遲對交互式 AI 智能體和實時應用至關重要

- 更強的可擴展性:在用户需求增長時保持性能穩定

- 更高的成本效益:優化資源利用率以降低運營支出

- 更優的可靠性:確保高可用性和容錯能力

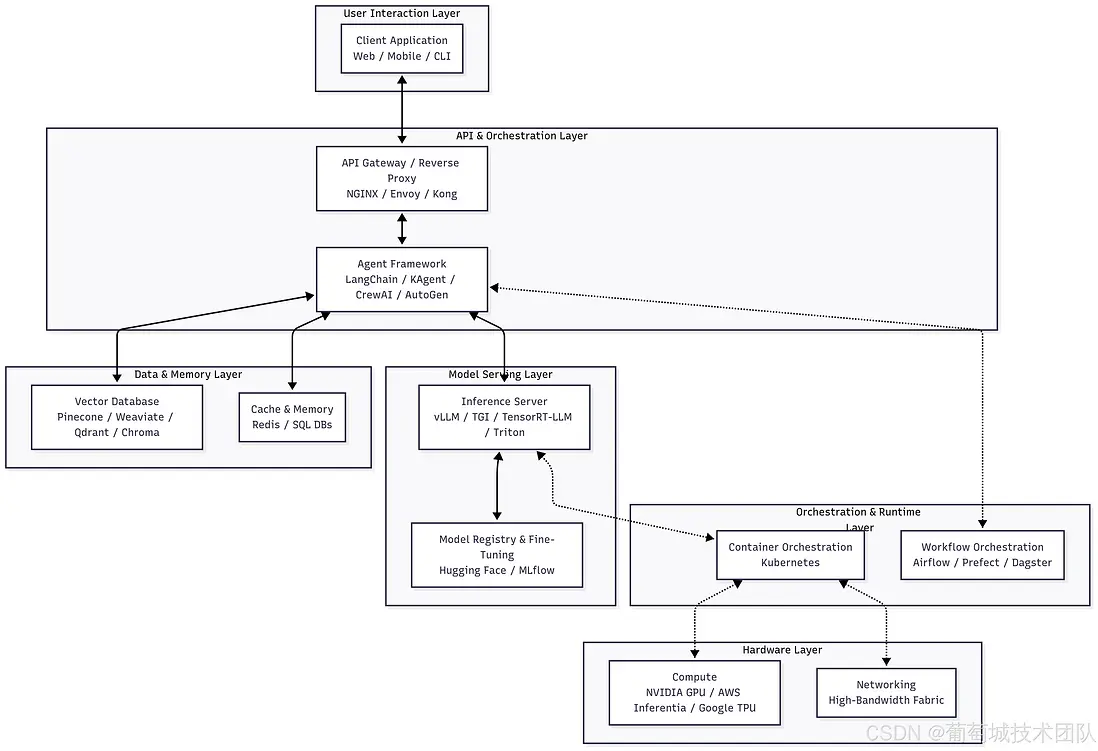

二、AI 基礎設施棧:分層架構設計

現代 AI 基礎設施棧由七個相互關聯的層級構成,每個層級承擔特定功能,同時與相鄰層級實現無縫集成。理解這一分層架構,對於工具選型、資源分配及運維策略制定具有重要指導意義。

(一)層級解析與核心工具

- 用户交互層:用户請求的入口,客户端可包括 Web 界面、移動應用或命令行工具。核心需求是與後端 API 層建立穩定、低延遲的連接。

-

API 與編排層:負責管理用户請求並編排複雜工作流

- API 網關(NGINX、Envoy、Kong):作為統一入口,處理流量接入、身份認證、限流及路由

- 智能體框架(LangChain、KAgent、CrewAI、AutoGen):AI 業務邏輯核心,其中 KAgent 是專為高效編排設計的專用工具,支持 AI 任務的動態路由與工作流管理

-

數據與內存層:提供上下文支持和持久化存儲,將無狀態模型轉化為具備知識儲備的助手

- 向量數據庫(Pinecone、Weaviate、Qdrant、Chroma):用於存儲和查詢高維向量的專用數據庫,是檢索增強生成(RAG)的核心組件

- 緩存與內存(Redis、SQL 數據庫):Redis 用於低延遲緩存和短期內存存儲,SQL 數據庫則存儲對話歷史、用户偏好等長期數據

-

模型服務層:推理核心層級,負責模型加載與執行

- 推理服務器(vLLM、TGI、TensorRT-LLM、Triton):專為高吞吐量、低延遲推理優化的服務器,支持動態批處理和量化

- 模型註冊與微調(Hugging Face、MLflow):集中式倉庫,管理從訓練到部署的全模型生命週期

-

編排與運行時層:抽象底層硬件的基礎層級

- 容器編排(Kubernetes):管理容器生命週期,提供可擴展性、彈性及高效資源利用率

- 工作流編排(Airflow、Prefect、Dagster):編排複雜的數據和機器學習流水線,支持訓練任務、數據攝入等操作

-

硬件層:計算的物理載體

- 計算資源(NVIDIA GPU、AWS Inferentia、Google TPU):大語言模型推理必需的專用加速器

- 網絡設備(NVLink、InfiniBand):支持多 GPU 和多節點通信的高速互聯設備

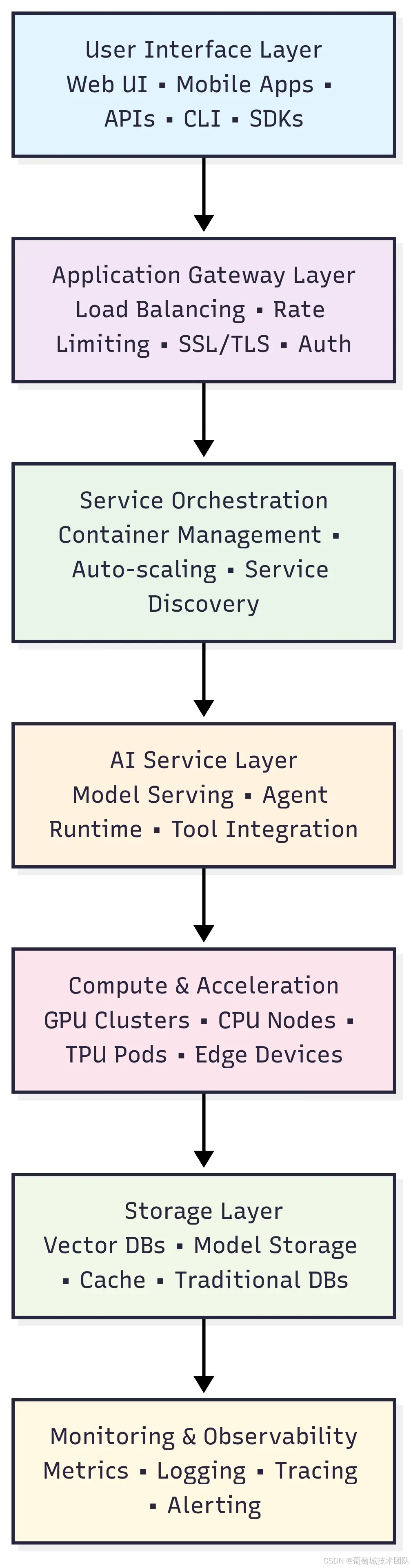

(二)層級依賴與數據流

基礎設施棧的每個層級都有明確的職責範圍,並通過標準化協議和 API 與其他層級交互:

- 用户交互層處理所有外部交互,將用户請求轉換為下游服務可處理的標準化格式

- API 網關層提供安全、路由和流量管理核心功能,確保請求經過正確認證、授權後分發至可用資源

- 服務編排層管理容器化服務的生命週期,負責 AI 工作負載的部署、擴縮容和健康監控——這一層對 AI 應用尤為重要,因其需應對動態資源需求,且需通過精密調度算法考量 GPU 可用性、模型加載時間和內存約束

- AI 服務層包含 AI 應用的核心業務邏輯,涵蓋模型推理引擎、智能體編排系統和工具集成框架,抽象不同 AI 框架的複雜性併為上游服務提供統一 API

- 計算與加速層提供 AI 工作負載所需的原始計算能力,通過專用硬件為不同類型操作提供加速支持

- 存儲層管理冷熱數據,包括模型權重、向量嵌入和應用狀態

- 監控與可觀測性層提供全層級的系統性能、用户行為和運維健康狀態可視化工具有

層級構成:用户交互層 → API 網關層 → 服務編排層 → AI 服務層 → 計算與加速層 → 存儲層 → 監控與可觀測性層 各層核心功能:

- 用户交互層:Web UI/移動應用、API/命令行工具/SDK

- API 網關層:負載均衡、限流、SSL/TLS 加密、身份認證

- 服務編排層:容器管理、自動擴縮容、服務發現

- AI 服務層:模型服務、智能體運行時、工具集成

- 計算與加速層:GPU 集羣、CPU 節點、TPU Pod、邊緣設備

- 存儲層:向量數據庫、模型存儲、緩存、傳統數據庫

- 監控與可觀測性層:指標採集、日誌記錄、鏈路追蹤、告警通知

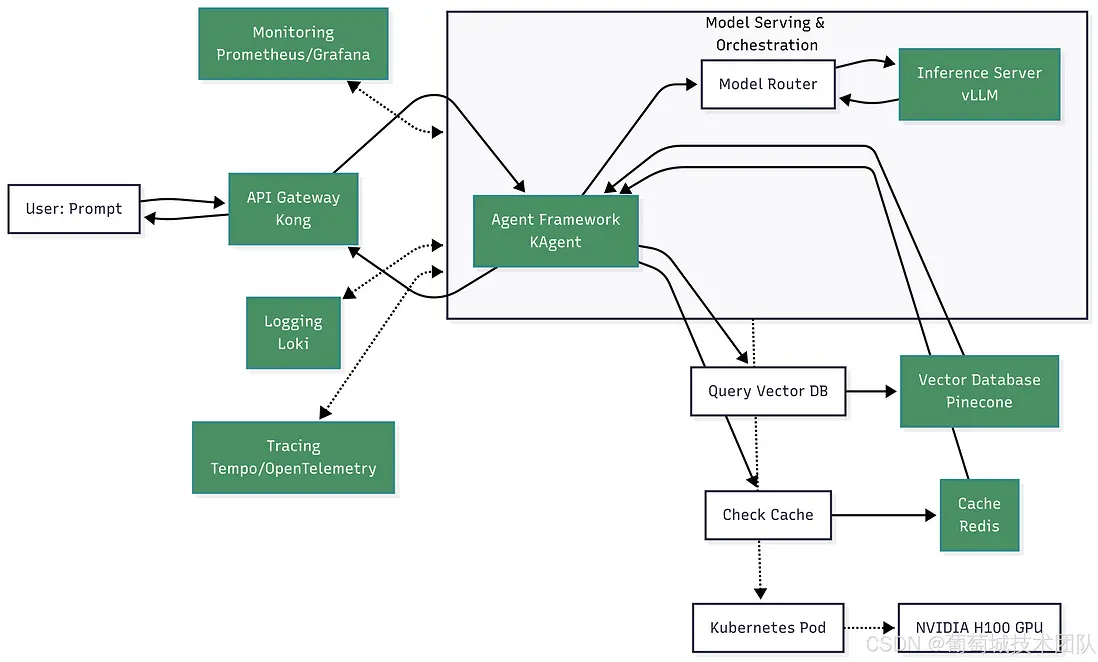

三、推理流程:從用户提示到 AI 響應

用户查詢在 AI 基礎設施中的流轉涉及多個步驟和工具,以下流程圖展示了完整流程及核心組件的交互關係。

核心組件交互:用户提示 → API 網關(Kong)→ 智能體框架(KAgent)→ 模型路由器 → 推理服務器(vLLM)→ NVIDIA H100 GPU(Kubernetes Pod);配套組件:緩存(Redis)、向量數據庫(Pinecone)、監控工具(Prometheus/Grafana)、日誌工具(Loki)、鏈路追蹤工具(Tempo/OpenTelemetry)

(一)步驟拆解

- 初始接入:用户通過 Web 界面發送提示詞,請求經 API 網關(Kong)路由,網關完成身份認證和限流處理

- 智能體編排:網關將請求轉發至 KAgent 等智能體框架,框架解析用户意圖並啓動多步驟推理流程

- 上下文檢索(RAG):智能體將提示詞轉換為嵌入向量,查詢向量數據庫(Pinecone),獲取內部文檔中的相關上下文

- 內存與緩存處理:智能體檢查緩存(Redis)中是否存在相似查詢,並從 SQL 數據庫中檢索長期上下文

-

模型路由與推理:智能體將增強後的提示詞發送至模型路由器,路由器調用推理服務器(vLLM);服務器通過動態批處理和 KV 緩存高效生成響應

- KV 緩存的作用:在自迴歸解碼過程中,KV 緩存存儲之前所有令牌的鍵(Key)和值(Value)向量;生成新令牌時,僅需計算該令牌的向量,其餘向量從緩存中讀取,大幅減少重複計算,降低延遲並提升吞吐量

- 響應生成與執行:生成的響應返回至智能體,智能體可對響應進行後處理或通過 API 調用觸發特定操作;最終響應經 API 網關返回給用户

- 可觀測性監控:整個流程通過 Prometheus 採集指標、Loki 記錄日誌、OpenTelemetry 實現鏈路追蹤,確保系統性能全可視

理解端到端推理流程對於優化系統性能和故障排查至關重要。

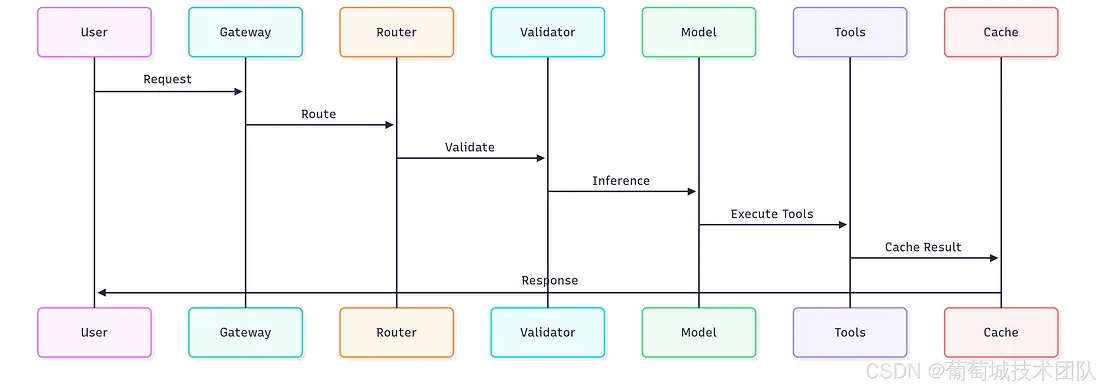

簡化流程:用户 → 網關 → 路由器 → 驗證器 → 模型 → 工具 → 緩存 → 響應 核心環節:請求路由、輸入驗證(基於 Pydantic 的 Schema 驗證)、推理處理(GPU 加速)、工具執行(智能體專用)、響應緩存(Redis 提升性能)

四、核心開源工具清單

(一)模型服務引擎

- vLLM:生產級推理首選工具,基於分頁注意力(PagedAttention)算法和連續批處理技術,吞吐量較傳統框架提升 2-4 倍,支持大型模型的張量並行

- 文本生成推理(TGI):具備企業級特性,提供全面監控、流式響應和兼容 OpenAI 的 API,適合追求運維簡化的生產部署場景

- Ollama:擅長開發環境和邊緣部署,支持自動模型管理、量化處理和簡易配置,是原型開發和本地部署的理想選擇

(二)智能體框架

- LangChain:生態最全面的框架,支持與工具、數據源及模型提供商的廣泛集成,模塊化架構可靈活構建複雜工作流

- CrewAI:專注於多智能體場景,採用基於角色的設計,支持智能體協作和複雜團隊動態管理

- AutoGen:對話式 AI 框架,支持多智能體通過協作推理和協商解決問題

(三)向量數據庫

- ChromaDB:適合開發環境和小規模部署,Python 集成性優異,部署簡易,採用 SQLite 後端確保可靠性

- Qdrant:生產環境性能出色,基於 Rust 開發,具備高級過濾能力和分佈式擴展特性,支持向量相似度與結構化數據結合的複雜查詢

- Weaviate:提供企業級功能,包括混合搜索、多模態支持和 GraphQL API,支持靈活的查詢模式

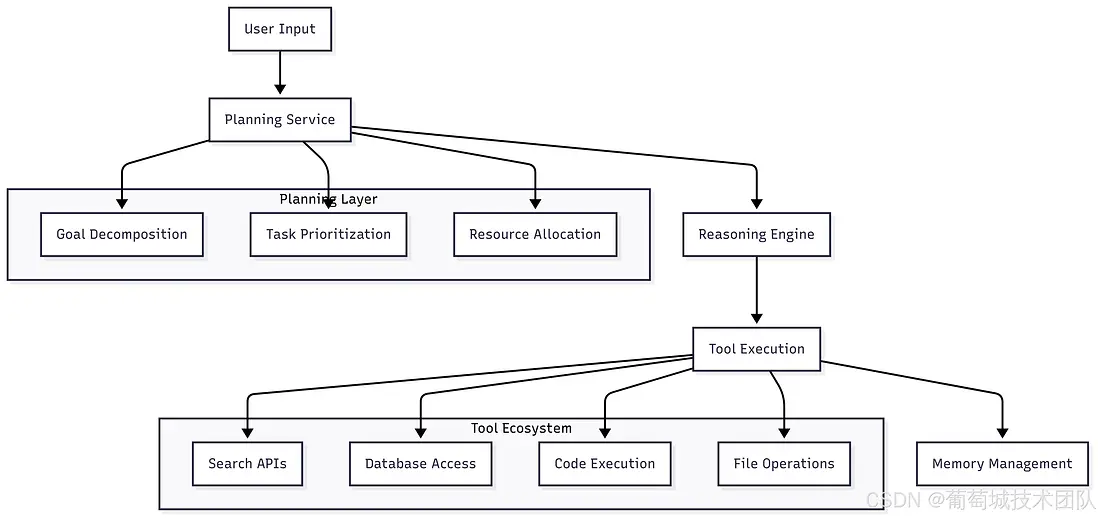

五、AI 智能體架構

AI 智能體超越了簡單模型的範疇,是具備複雜推理和行動能力的系統。

架構組成:用户輸入 → 規劃服務(規劃層:目標分解、任務優先級排序、資源分配、推理引擎)→ 工具執行(工具生態:搜索 API、數據庫訪問、代碼執行、文件操作)→ 內存管理(工作內存、情景記憶、語義記憶)

(一)核心組件

- 規劃服務:將複雜請求分解為可執行的子任務,需考量任務依賴關係、資源約束和故障處理機制

- 工具集成:需實現動態工具發現、安全執行沙箱隔離和性能監控,所有工具需容器化部署,並配置合理的資源限制和網絡隔離策略

- 內存系統:管理智能體的各類內存——工作內存(當前上下文)、情景記憶(對話歷史)和語義記憶(習得知識)

六、優化策略

(一)模型量化

量化技術可降低內存佔用並提升推理速度:

- INT8 量化:內存佔用減少 2 倍,精度損失極小

- INT4 量化:內存佔用減少 4 倍,精度損失約 2%-5%

(二)模型服務優化

包括 Transformer 模型的 KV 緩存管理、可變請求量的動態批處理,以及多 GPU 部署的張量並行技術。

1. KV 緩存(鍵值緩存)

KV 緩存是大語言模型高效推理的核心優化技術。若缺少該機制,每個令牌生成時都需重新計算所有歷史令牌的向量,導致計算開銷難以承受。

(1)工作原理

緩存存儲序列中所有歷史令牌的計算後鍵(Key)和值(Value)向量;生成新令牌時,模型僅計算該令牌的 KV 向量,其餘向量從緩存中讀取。這一機制將計算複雜度從二次降至線性,顯著提升推理速度。

(2)挑戰與解決方案

- 內存佔用問題:KV 緩存可能消耗大量 GPU 內存,尤其對於長序列和大批量請求

- 優化技術:通過緩存卸載、量化和淘汰策略等高級方法,平衡內存使用與性能表現

(三)硬件加速優化

- GPU 優化:聚焦內存帶寬利用率提升、計算密集型與內存密集型操作識別,以及多 GPU 協同效率優化

- CPU 優化:充分利用高級指令集(AVX-512、AVX2)、線程庫(OpenMP、Intel TBB)和優化數學庫(Intel MKL、OpenBLAS)

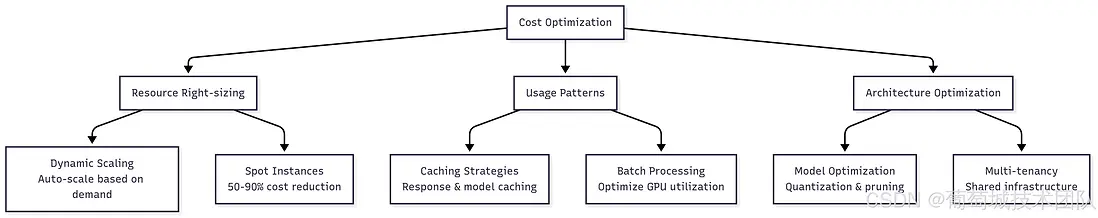

(四)成本優化策略

- 智能緩存:基於語義相似度的 AI 響應緩存

- 搶佔式實例:利用閒置資源處理批處理任務和開發工作

- 模型共享:單個模型實例為多個應用提供服務

- 動態擴縮容:基於隊列深度和響應時間目標進行彈性伸縮

優化維度:資源合理配置、使用模式優化、架構優化 核心策略:動態擴縮容(基於需求自動伸縮)、搶佔式實例(降低 50%-90%成本)、緩存策略(響應與模型緩存)、批處理(優化 GPU 利用率)、模型優化(量化與剪枝)、多租户(共享基礎設施)

七、綜合工具參考表

以下表格按基礎設施層級整理了完整的開源工具清單,為 AI 系統構建提供全面參考。

| 層級 | 類別 | 工具 | 核心應用場景 |

|---|---|---|---|

| 硬件與雲 | GPU 計算 | ROCm、CUDA Toolkit、OpenCL | 硬件加速、GPU 編程、計算優化 |

| 雲管理 | OpenStack、CloudStack、Eucalyptus | 私有云基礎設施、資源管理 | |

| 容器與編排 | 容器化 | Docker、Podman、containerd、LXC | 應用打包、隔離、可移植性 |

| 編排工具 | Kubernetes、Docker Swarm、Nomad | 容器調度、擴縮容、服務發現 | |

| 分佈式計算 | Ray、Dask、Apache Spark、Horovod | 分佈式訓練、並行處理、多節點推理 | |

| 工作流管理 | Apache Airflow、Kubeflow、Prefect、Argo Workflows | 機器學習流水線自動化、任務調度、工作流編排 | |

| 模型運行時與優化 | 機器學習框架 | PyTorch、TensorFlow、JAX、Hugging Face Transformers | 模型訓練、推理、神經網絡開發 |

| 推理優化 | ONNX Runtime、TensorRT、OpenVINO、TVM | 模型優化、跨平台推理、性能調優 | |

| 模型壓縮 | GPTQ、AutoGPTQ、BitsAndBytes、Optimum | 量化、剪枝、模型體積縮減 | |

| 大語言模型服務 | vLLM、Text Generation Inference、Ray Serve、Triton | 高性能大語言模型推理、請求批處理、擴縮容 | |

| API 與服務 | 模型部署 | BentoML、MLflow、Seldon Core、KServe | 模型打包、版本管理、部署自動化 |

| Web 框架 | FastAPI、Flask、Django、Tornado | REST API 開發、Web 服務、微服務 | |

| 負載均衡 | Nginx、HAProxy、Traefik、Envoy Proxy | 流量分發、反向代理、服務網格 | |

| API 網關 | Kong、Zuul、Ambassador、Istio Gateway | API 管理、身份認證、限流 | |

| 數據與存儲 | 向量數據庫 | Weaviate、Qdrant、Milvus、Chroma | 嵌入向量存儲、語義搜索、RAG 應用 |

| 傳統數據庫 | PostgreSQL、MongoDB、Redis、Cassandra | 結構化數據存儲、緩存、會話存儲、元數據管理 | |

| 數據處理 | Apache Kafka、Apache Beam、Pandas、Polars | 流處理、ETL、數據轉換 | |

| 特徵存儲 | Feast、Tecton、Hopsworks、Feathr | 特徵工程、特徵服務、版本管理、共享 | |

| 監控與可觀測性 | 基礎設施監控 | Prometheus、Grafana、Jaeger、OpenTelemetry | 指標採集、可視化、分佈式鏈路追蹤 |

| 機器學習實驗追蹤 | MLflow、Weights & Biases、Neptune.ai、ClearML | 實驗日誌、模型版本管理、超參數追蹤 | |

| 大語言模型可觀測性 | LangKit、Arize Phoenix、LangSmith、Helicone | 大語言模型性能監控、提示詞評估、使用分析 | |

| 日誌與分析 | ELK Stack、Fluentd、Loki、Vector | 日誌聚合、搜索、分析、告警 | |

| 應用與智能體 | 智能體框架 | LangChain、AutoGen、CrewAI、LlamaIndex | 智能體開發、多智能體系統、工具集成 |

| 工作流自動化 | n8n、Apache Airflow、Temporal、Zapier Alternative | 業務流程自動化、工作流編排 | |

| 安全與訪問控制 | Keycloak、HashiCorp Vault、Open Policy Agent | 身份認證、密鑰管理、策略執行 | |

| 測試與質量保障 | DeepEval、Evidently、Great Expectations、Pytest | 模型測試、數據驗證、質量保障 |

八、結語:基礎設施作為戰略優勢

構建成功的 AI 基礎設施需要在即時需求與長期可擴展性之間取得平衡——應從成熟、簡潔的解決方案起步,逐步增加系統複雜度。

AI 基礎設施架構設計是一項核心工程任務,直接影響 AI 產品的性能、成本和可靠性。基於分層架構構建的精良系統,結合 Kubernetes、vLLM、KAgent 和 Pinecone 等工具,能夠支撐大規模部署並提供流暢的用户體驗。

AI 基礎設施領域發展迅速,但聚焦於開源工具構建堅實基礎、實現全面可觀測性並追求運維卓越,將幫助企業在把握 AI 技術進步的同時,保持系統的可靠性和可擴展性。儘管不同企業的實施路徑因需求差異而有所不同,但本指南提供的框架將為構建具備實際業務價值的 AI 基礎設施提供清晰 roadmap。

理解並實施 KV 緩存等高級優化技術,是 AI 系統從原型階段邁向生產級部署的關鍵。隨着 AI 技術的不斷演進,高效的基礎設施將持續成為核心差異化優勢,助力企業部署功能強大、可擴展且成本效益優異的 AI 應用。