摘要

GMI Cloud Inference Engine 最近密集上線眾多模型,吸引了眾多科技博主體驗,感謝大家的支持。

下文為 ID 為“知識淺談”的體驗實錄,全文為博主自述。

當前,大模型技術發展如火如荼,相信不少小夥伴和我一樣,接到了“將智能對話功能集成到公司現有應用中”的任務。

我們公司內部也提出了兩種方案:一種是自行採購 GPU 服務器,部署開源大模型;另一種是直接接入多家大模型提供的 API 接口。經過詳細的成本與效益分析,我們最終選擇了接入大模型 API 的方式。 初期我們主要依賴各家大模型的 Token 調用服務,但在業務高峯時段,響應延遲明顯增加,用户體驗受到一定影響。

經過多輪調研,我們發現了一個專注於 AI 出海場景的算力雲服務——GMI Cloud。它不僅支持一鍵調用多家主流大模型 API,還提供 H200 等大型 GPU 雲資源海外租賃服務,支持企業部署自有的大模型平台,是全球六大 Reference Platform NVIDIA Cloud Partner 之一。 引入GMI Cloud 之後,我們的服務響應效率顯著提升,處理能力也更加穩定。

因此,本文想和大家分享 GMI Cloud 在實際應用中的出色表現和強大功能。

Part 1

GMI Cloud Inference Engine 新用户友好

免費體驗得 Token

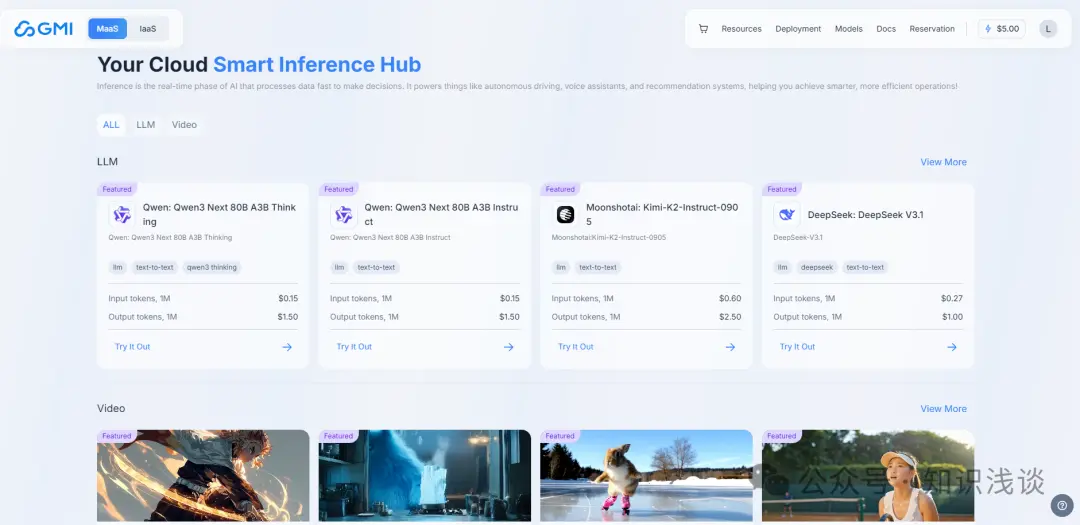

GMI Cloud Inference Engine 是一家全球領先的 AI Native Cloud 服務提供商,專注於為人工智能應用提供高性能的 GPU 雲計算服務。它致力於通過其全球分佈的算力基礎設施和自研技術,幫助企業(尤其是在出海場景下的 AI 企業)高效、經濟地部署和運行 AI 應用。底層搭載 H100/H200 芯片,集成全球近百個最前沿的大語言模型和視頻生成模型,如DeepSeek V3.1, GPT OSS, Qwen3, Wan 2.2, Seedance 1.0 等,為 AI 開發者與企業提供速度更快、質量更高的模型服務。

免費獲取海量 Token:

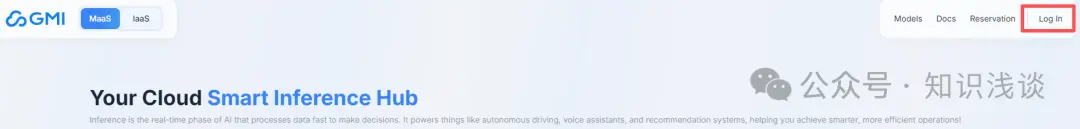

1、PC 端登錄 https://console.gmicloud.ai

2、點擊右上方 Log In

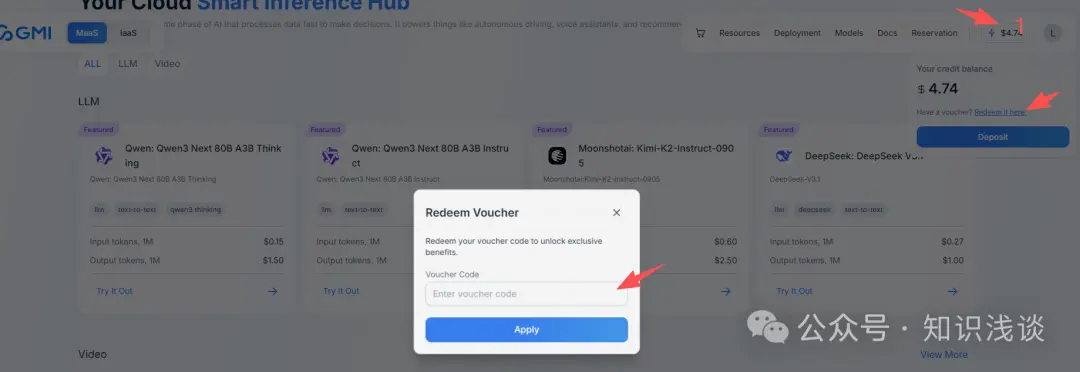

3、點擊右上角餘額,再點擊 Redeem it here,然後輸入兑換碼:TRYIENOW ,領取免費使用額度

Part 2

初試水:用 API 快速搞定智能對話功能

前提説明:為了防止泄露公司機密,接下來的例子中我都是使用的測試案例

為什麼我選擇了 API 調用方案?

採用 GMI Cloud 預先配置的端點,允許用户直接將AI模型用作與 OpenAI 兼容的 API,而無需進行大量設置。此功能簡化了集成過程,提供以下好處:

- 開箱即用功能:立即訪問預先配置為與 OpenAI 標準無縫協作的 AI 模型。

- 可擴展性:根據應用程序的需求自動擴展,確保高可用性和性能,無需手動干預。

- 成本效益:只需為使用付費,無需維護基礎設施。

實操分享: 10 分鐘完成千問大模型集成

因為公司產品是把智能對話千問大模型、DeepSeek 大模型集成到產品中,所以採用購買 GMI Cloud 中 Token 的形式來按量付費,這種靈活性比較高,可以選用不同的大模型進行使用,能夠滿足用户不同的使用需求,下邊採用千問大模型舉個例子:

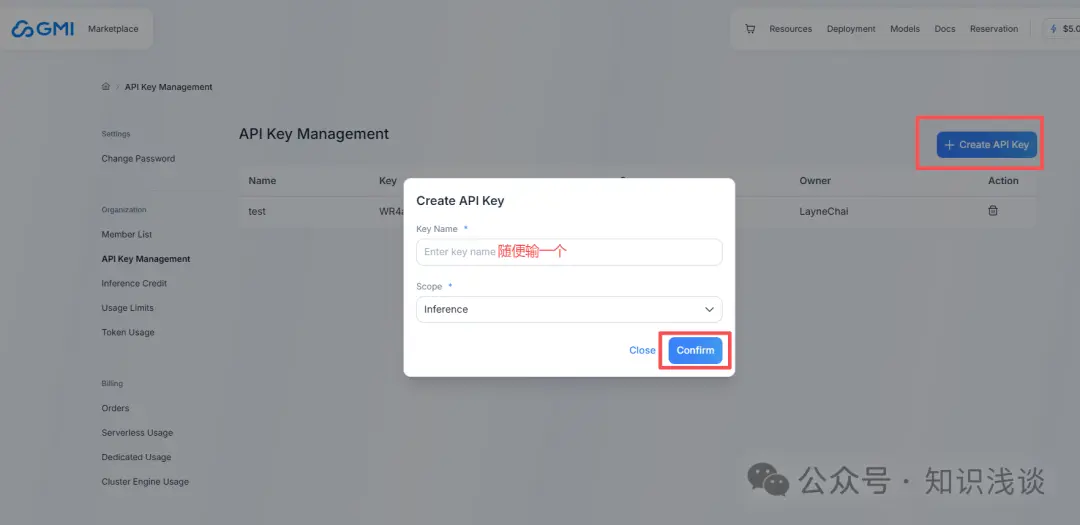

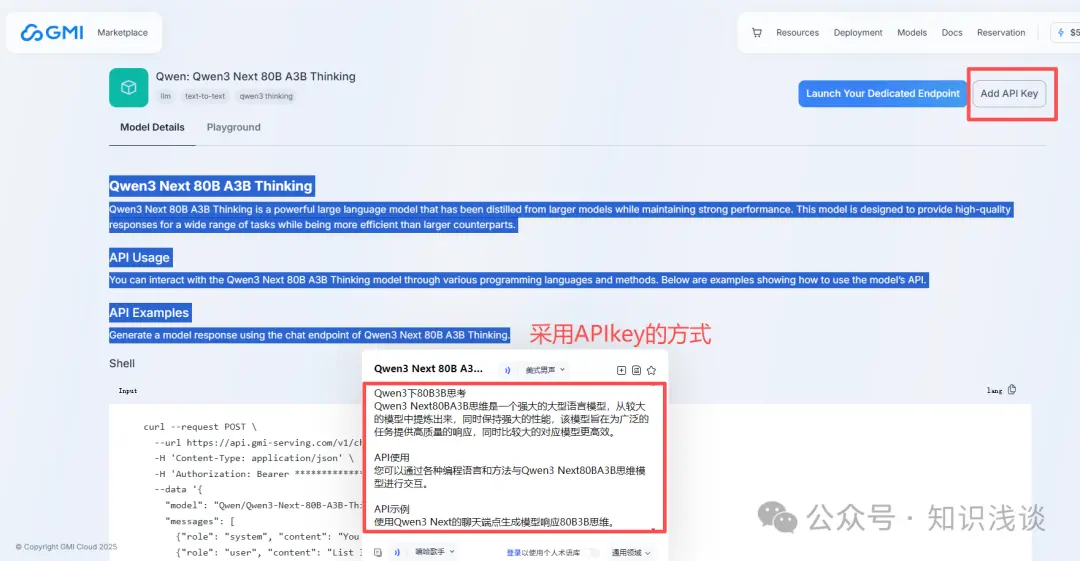

**1、先申請一個 APIKEY【注意申請之後複製保存,因為創建後只出現一次】**https://console.gmicloud.ai/user-setting/organization/api-key...

2、打開首頁 MaaS 頁面,有關於模型介紹和示例代碼

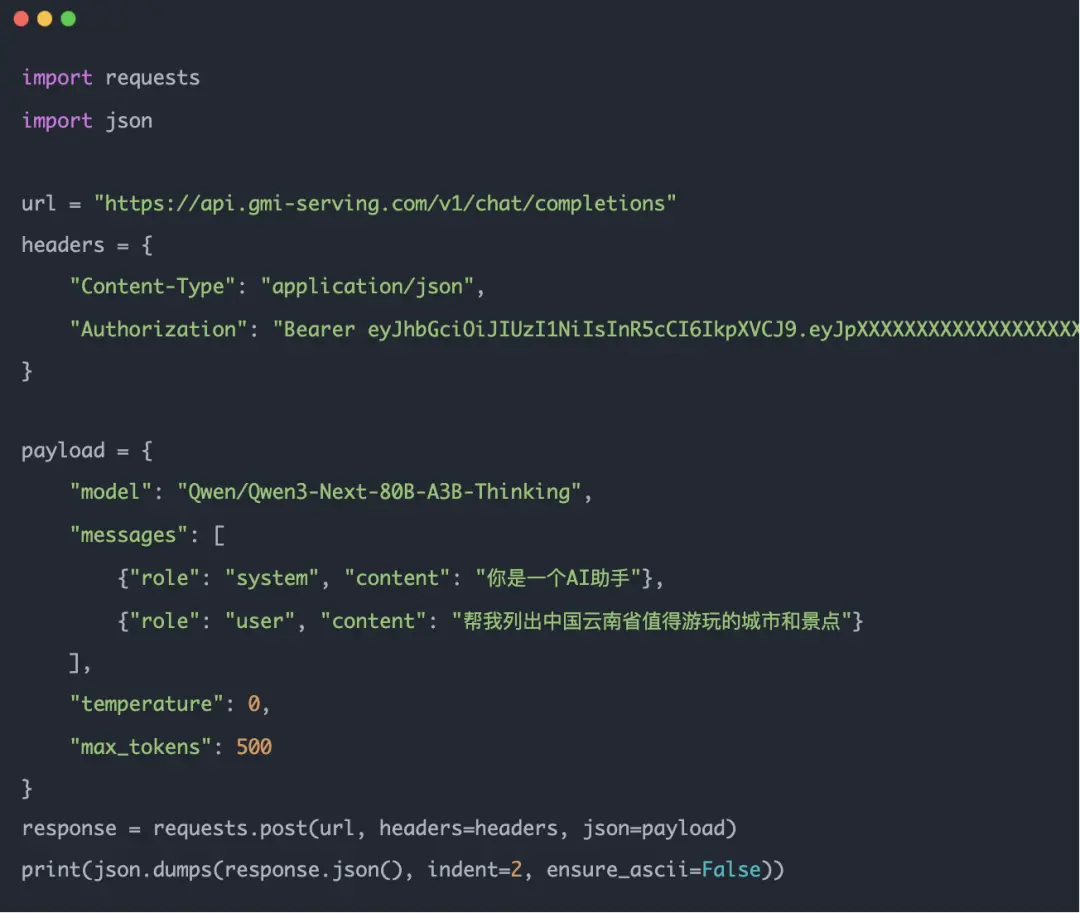

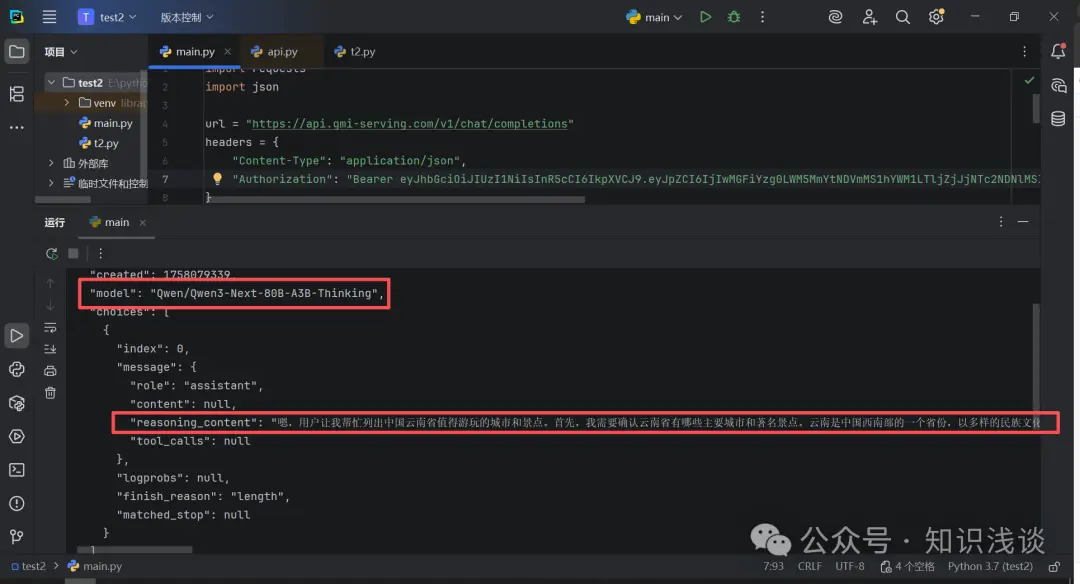

3、API 引用千問大模型【Python 代碼】

響應情況:根據用户提出的需求響應相應的內容,特別低代碼嵌入到公司的應用中

如果你們公司的需求比較高,使用人數比較多,並且併發量比較大的話,GMI Cloud 相比於其他官方平台更具優勢的一點就是提供在海外單獨租用 H200 這種大型 GPU 服務器,部署專用的算力服務器,來滿足高併發的需求,接下來探索一下 GMI Cloud 專用算力服務器部署方案。

Part 3

進階篇:業務爆發後我的專用部署選擇

專用部署帶來的驚喜變化

專用端點是可定製的用户配置資源,旨在為 AI 模型提供服務,並完全控制基礎設施和配置。此功能非常適合需要更多控制其 AI 解決方案的用户。主要優勢包括:

- 完全定製:部署您自己的模型並配置設置以滿足特定的應用程序需求。

- 增強的性能:優化資源以獲得針對您的用例量身定製的更好性能。

- 隔離和安全性:受益於隔離工作負載的專用環境,增強安全性和合規性。

專用服務器部署全記錄

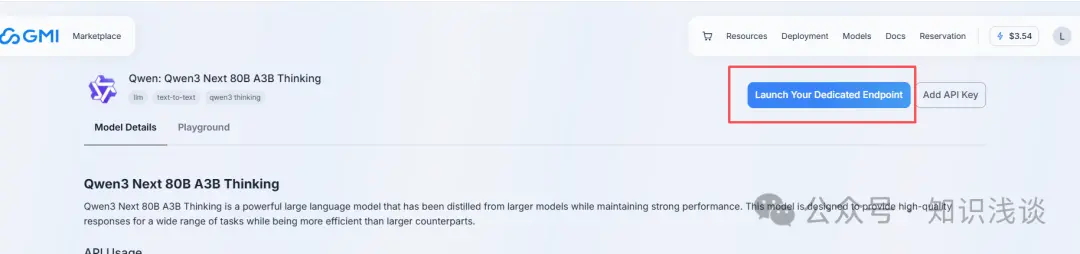

1、點擊大模型左上角的 Launch Your Dedicated Endpoint

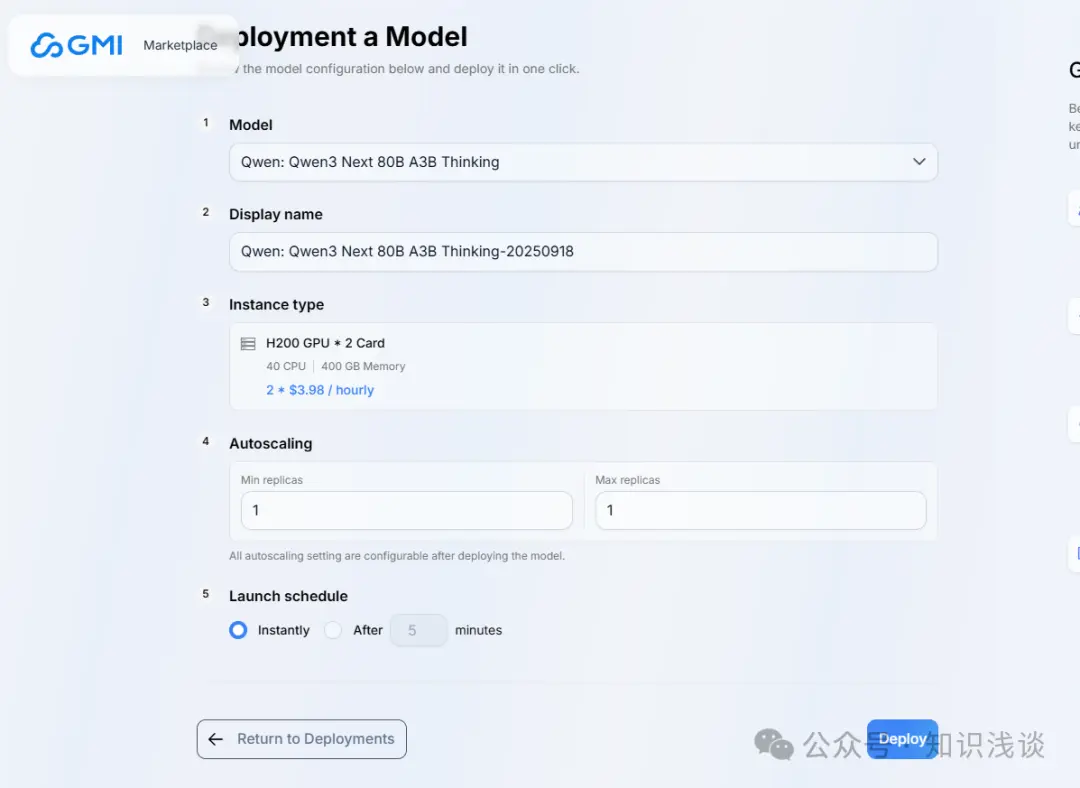

2、設置部署參數

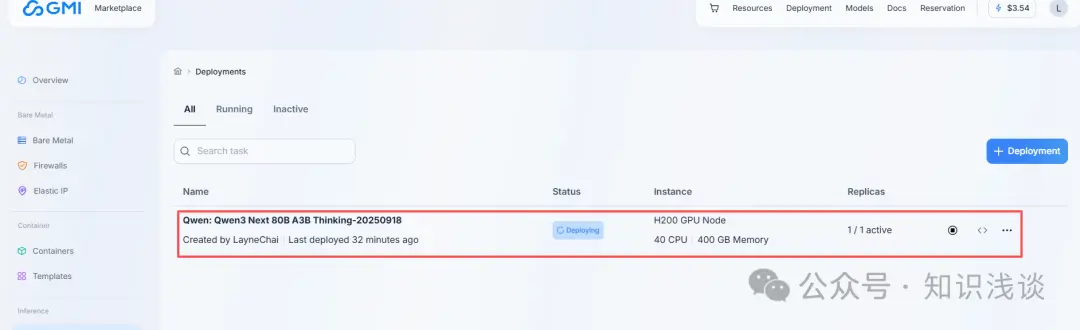

3、查看部署狀態

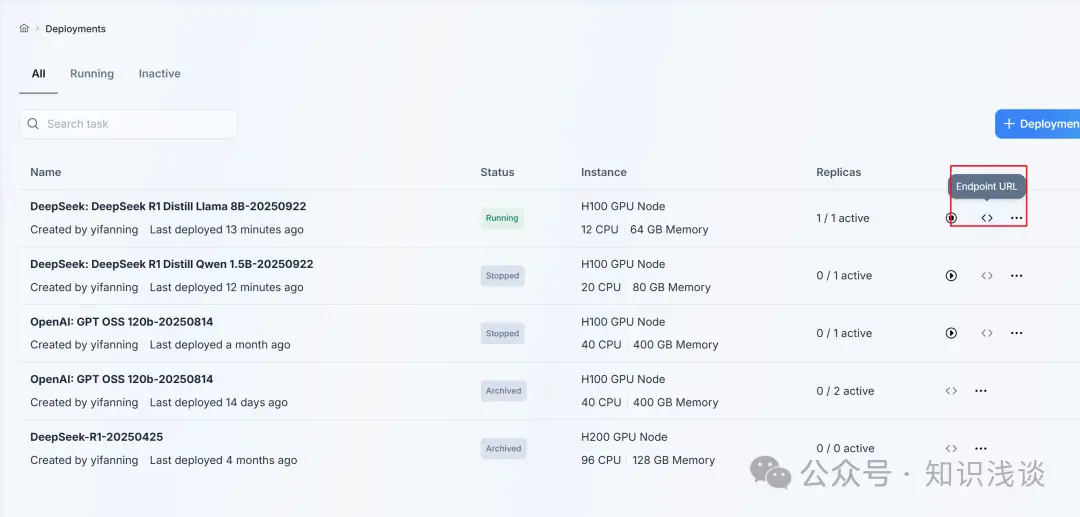

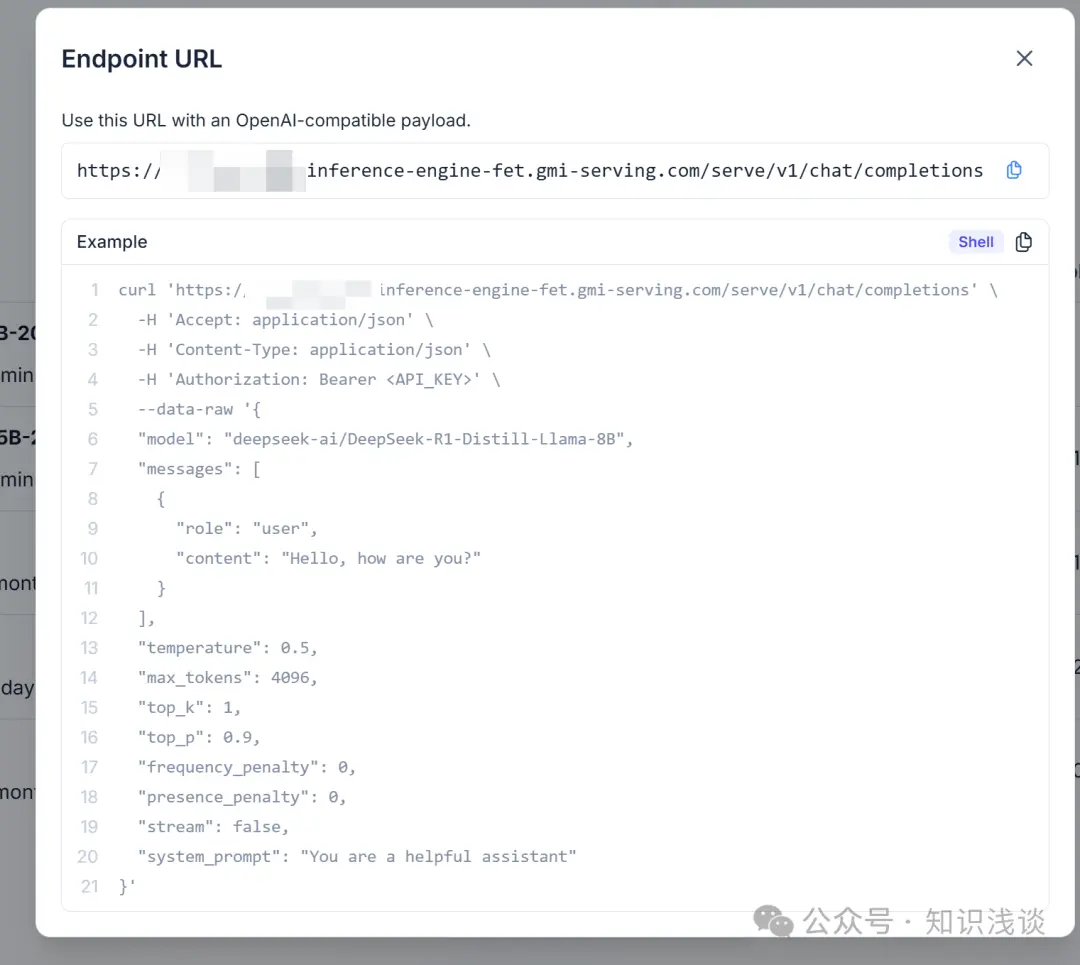

4、點擊 endpoint URL 即可獲取調用 API URL 以及示例

5、根據示例代碼替換 API Key 後調用即可

Part 4

驚喜彩彈

順手玩了玩 AI 視頻生成

除了公司業務需要集成的對話大模型,GMI Cloud 還提供了其他的如在線 AI 視頻生成和 API 調用生成的大模型,淺淺使用了一下,確實有點意思,生成的速度槓槓的,來看下怎麼玩。

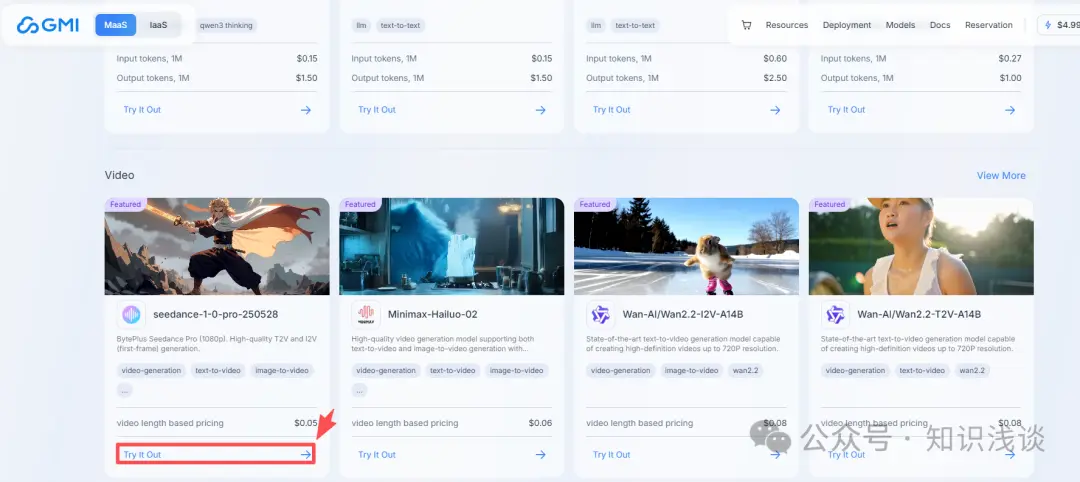

1、打開首頁,點擊下邊的視頻生成板塊的 Try it Out

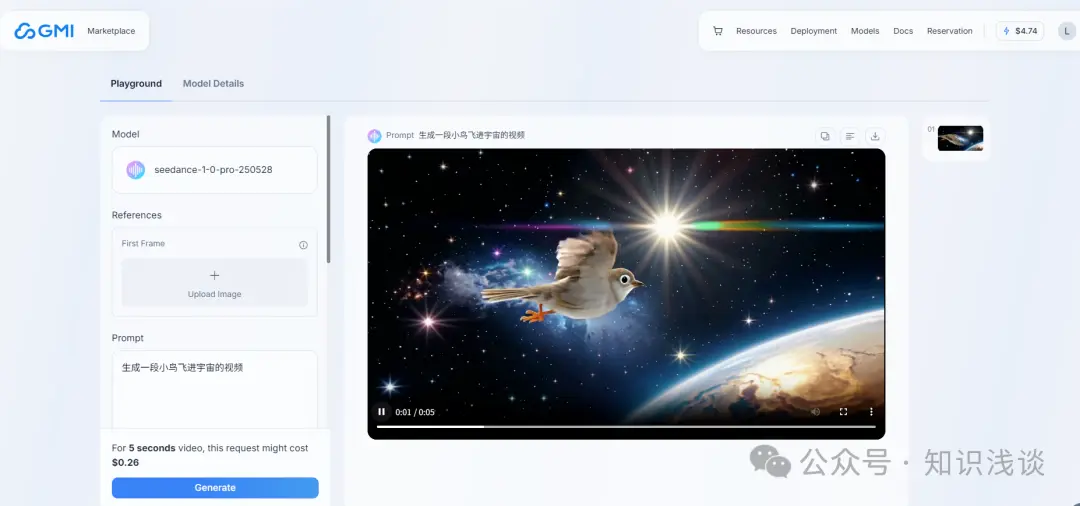

2、在線調用大模型生成視頻(左邊輸入參數,點擊生成,生成一段視頻)

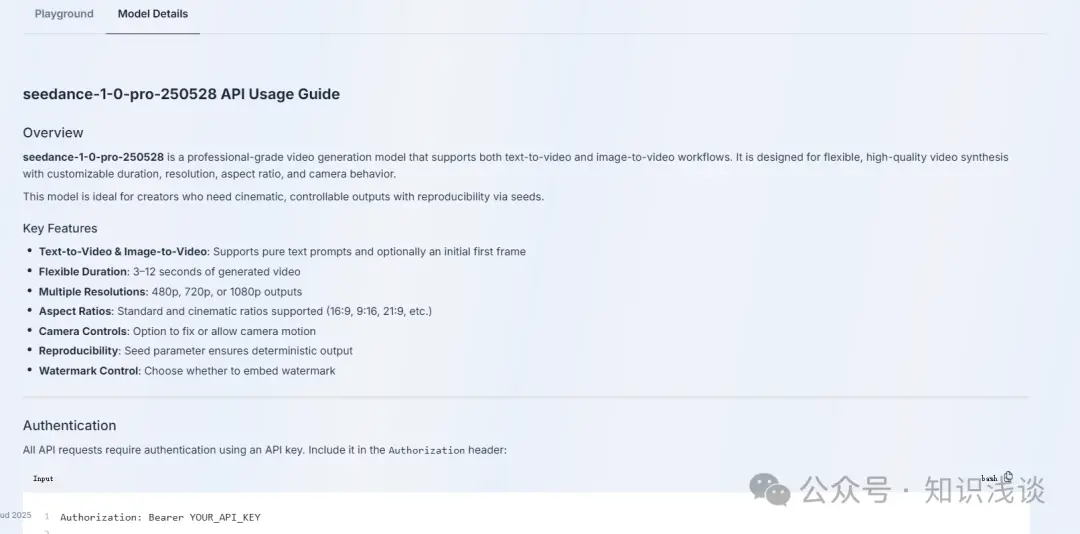

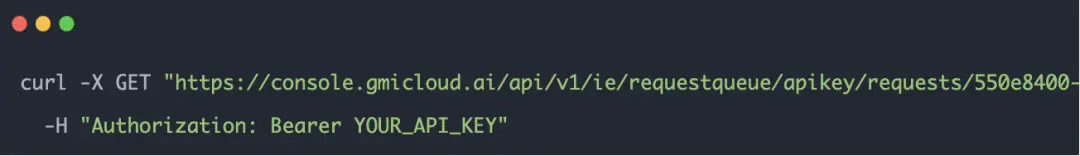

3、使用 API 調用視頻大模型生成視頻,可以點擊 Model Details,裏邊有相關的操作方法

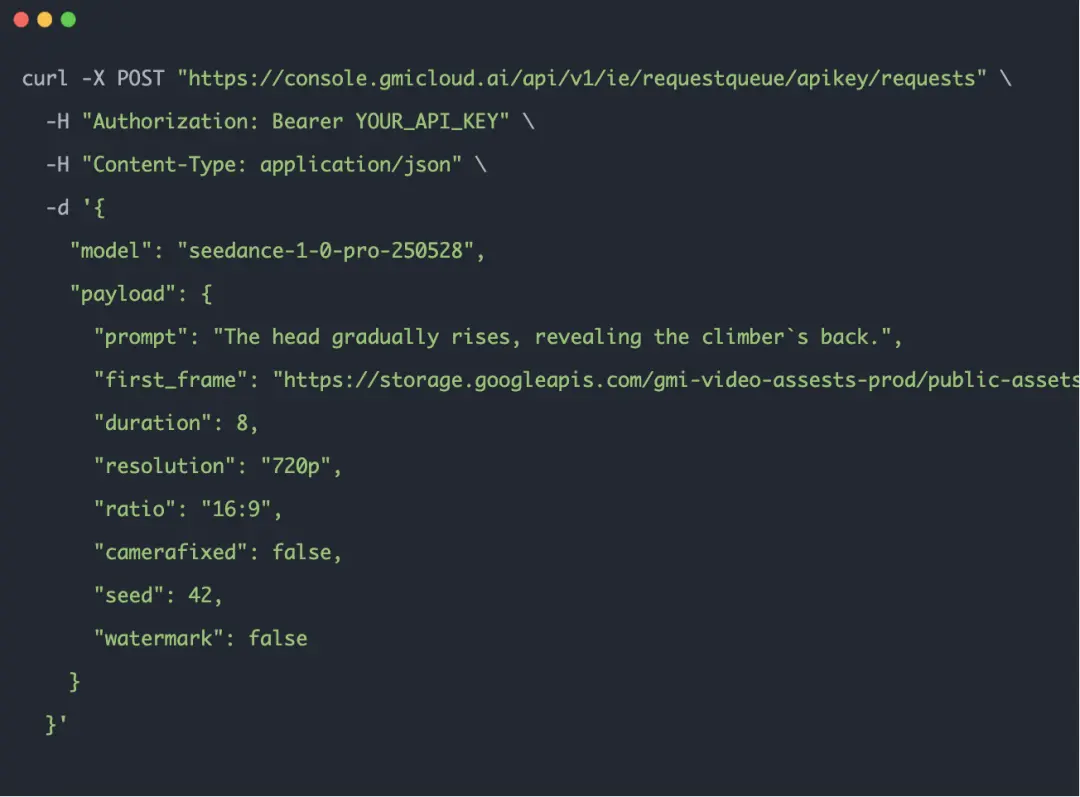

舉個 Demo 例子,使用命令行發送視頻生成請求:

生成視頻請求之後,檢查視頻生成狀態【是否生成完成】

關於 GMI Cloud

由 Google X 的 AI 專家與硅谷精英共同參與創立的 GMI Cloud 是一家領先的 AI Native Cloud 服務商,是全球六大 Reference Platform NVIDIA Cloud Partner 之一,擁有遍佈全球的數據中心,為企業 AI 應用提供最新、最優的 GPU 雲服務,為全球新創公司、研究機構和大型企業提供穩定安全、高效經濟的 AI 雲服務解決方案。

GMI Cloud 憑藉高穩定性的技術架構、強大的GPU供應鏈以及令人矚目的 GPU 產品陣容(如能夠精準平衡 AI 成本與效率的 H200、具有卓越性能的 B200/B300 以及未來所有全新上線的高性能芯片),確保企業客户在高度數據安全與計算效能的基礎上,高效低本地完成 AI 落地。此外,通過自研“Cluster Engine”、“Inference Engine”兩大平台,完成從算力原子化供給到業務級智算服務的全棧躍遷,全力構建下一代智能算力基座。

作為推動通用人工智能(AGI)未來發展的重要力量,GMI Cloud 持續在 AI 基礎設施領域引領創新。選擇 GMI Cloud,您不僅是選擇了先進的 GPU 雲服務,更是選擇了一個全方位的 AI 基礎設施合作伙伴。

如果您想要了解有關 GMI Cloud 的信息

請關注我們並建立聯繫