作者:嶽元浩(顧城)、汪誠愚(熊兮)、黃俊(臨在)

背景

近年來,多模態人工智能技術迅猛發展,推動了視覺、語言、語音等多種模態信息的深度融合與理解。尤其在多模態深度推理任務中, GPT-4V 等前沿模型通過模擬人類的鏈式思維過程,展現出強大的跨模態推理能力。然而,當前的多模態大模型在實際應用中仍面臨兩個關鍵問題:首先,能力較強的SOTA模型往往參數規模龐大、計算資源消耗高,導致部署成本高昂,難以在資源受限的場景中落地。其次,現有開源社區缺乏大規模高質量的多模態長思考數據集,致使多模態推理模型的訓練過程難以復現,也制約了開源社區多模態推理模型的性能提升。

基於阿里雲人工智能平台(PAI)的蒸餾工具包 EasyDistill(<https://github.com/modelscope/easydistill), 我們提出了一套面向多模態深度推理的蒸餾數據構建框架,併發布了首個支持大規模多模態思維鏈蒸餾的高質量數據集 OmniThoughtV。OmniThoughtV不僅填補了開源社區在多模態複雜推理數據方面的空白,還通過一套透明、可復現的數據蒸餾機制,實現了對多模態思維鏈的高效提取與結構化組織。該數據集融合了精細化標註、多階段過濾機制與針對多模態推理優化的蒸餾策略,顯著提升了小模型在保持邏輯連貫性的同時,降低推理冗餘、加快響應速度,並增強了在開放場景中的魯棒性與泛化能力。特別地,基於蒸餾的OmniThoughtV數據集得到的Qwen3-VL-4B小模型在下游任務上接近或超越了參數量為其兩倍的基座模型(Qwen3-VL-8B),實現了參數量50%的壓縮效果,其結果如下:

| 模型/評測數據集 | 4B模型(蒸餾前) | 4B模型(蒸餾後) | 8B模型(蒸餾前) |

|---|---|---|---|

| AI2D | 0.7134 | 0.8164 | 0.8096 |

| MMMU ProStandard | 0.4133 | 0.4694 | 0.4688 |

| MMMUval | 0.5667 | 0.6033 | 0.6000 |

| MathVista | 0.7070 | 0.7400 | 0.7250 |

| MathVersetestmini | 0.3640 | 0.5315 | 0.3820 |

| MMBench | 0.8204 | 0.8273 | 0.8256 |

本文將重點解析基於 EasyDistill 框架構建 OmniThoughtV 數據集的核心方法,評測其在多模態深度推理任務中的實際效果,並介紹該數據集及配套蒸餾模型在開源社區和 PAI 平台上的使用方式和各個場景的應用,為推動開源多模態大模型邁向人類水平的系統性思考能力提供堅實基礎。

OmniThoughtV數據集構建

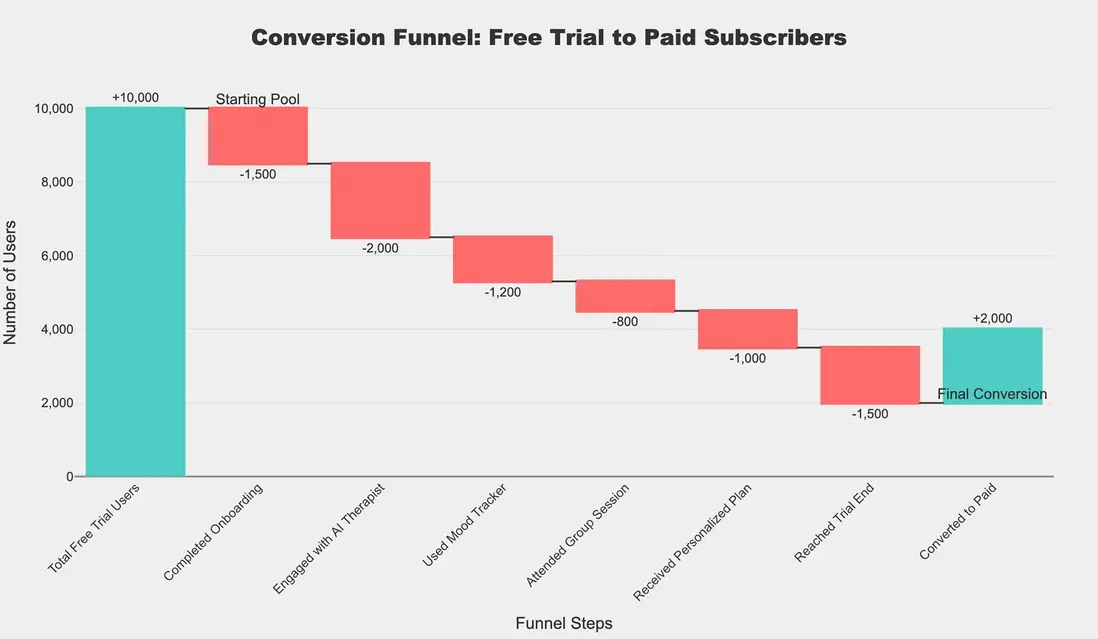

開源社區現有的多模態指令微調數據集往往只包含簡單直接的回答,缺乏複雜的推理過程,難以支持模型學習如何“看圖深度思考”。例如,在回答“免費試用用户的總數是多少?”這類問題時,模型不僅需要定位圖表中的關鍵視覺元素,還需理解其語義、排除干擾信息,並逐步推導出結論。然而,現有數據集通常僅提供最終答案,缺失中間可解釋的推理鏈。為彌補這一空白,我們構建了 OmniThoughtV, 首個大規模、面向多模態深度推理的高質量長思考數據集。我們的模型思考不僅涵蓋數學、邏輯等推理,還包括對圖像中物體、空間等信息的理解與推理。

多模態數據集示例

問題:免費試用用户的總數是多少?

原回答標註

免費試用用户的總數在圖表開頭的“Total Free Trial Users”(總免費試用用户數)下方標明。

答案:10,000

長思考標註

<think>

為了確定免費試用用户的總數,我需要查看漏斗圖中標有“Total Free Trial Users”(總免費試用用户數)的第一個柱狀條。該柱狀條代表了開始免費試用的初始用户羣體。

從圖表中可以看出:

- 第一個柱狀條的高度對應 10,000 名用户。

- 該柱狀條上的標籤明確標示為“+10,000”,表明這是免費試用用户的起始人數。

無需進一步計算,因為圖表已直接提供了免費試用用户的總數。

因此,免費試用用户的總數為 10,000。

</think>

<answer>

10,000

</answer>

我們從 HuggingFace 的 FineVision 數據集中抽取了 180 萬條英文圖文指令,全面覆蓋其全部子數據集與數據來源,從而構建了一個多樣化、高覆蓋度的初始多模態問題池。在此基礎上,我們利用當前性能領先的多模態大模型 Qwen3-VL-Max,為每一條樣本生成結構化、可解釋、多步驟的長思考推理過程,涵蓋視覺信息定位、跨模態語義對齊、邏輯推導與答案驗證等關鍵認知環節。其中,我們使用如下Prompt模版從 Qwen3-VL-Max蒸餾得到上述長思考推理過程:

SYSTEM_PROMPT="You are a helpful assistant to think step by step. Provide your reasoning steps within <think></think> tags and give your final answer within <answer></answer> tags."

QUERY=f"""

<image>

### Question

{question}

### Output Format (Strictly Enforced)

<think>

Clearly explain your reasoning step by step. Describe how you arrived at the conclusion.

The reasoning process MUST BE enclosed within <think> </think> tags.

</think>

<answer>

Your final answer to the user's question.

</answer>

"""最終,我們構建了一個包含約 0.8B Tokens 的高質量多模態長思考蒸餾數據集,為訓練具備深度推理能力的小型多模態模型奠定了堅實的數據基礎。該數據集不僅規模龐大,更在推理深度、邏輯連貫性與任務多樣性等方面顯著超越現有開源多模態指令微調數據集。

OmniThoughtV思維鏈評估指標

在完成對 180 萬條英文圖文指令的蒸餾標註後,我們對生成的長思考數據進行了系統性質量清洗,以確保數據的難度和標註準確性。數據清洗與過濾主要基於兩個維度:規則過濾和模型打分。 在規則層面,我們設計了三類啓發式規則:除了剔除不符合<think>...<\think><answer>...<\answer>思考鏈格式的數據外,我們還過濾掉模型回答長度過長的數據,通常這類數據對應極為複雜的問題,模型在思考過程中難以找到有效答案。此外,我們還剔除了回答中出現模型自我反覆糾錯的樣本,例如包含“Wait, …..”等自我糾錯模板的數據,這類數據通常也是極難問題,模型無法做出準確推理。 在模型打分方面,我們使用 Qwen3-VL-Flash 對數據進行打分,分別標註了數據的質量、難度以及開放式任務標籤,具體定義如下:

| 分數 | 級別 | 描述 |

|---|---|---|

| 難度評分 | ||

| 1 | 非常簡單 | 明顯存在的物體、簡單的顏色/形狀識別 |

| 2 | 簡單 | 清晰可見物品的基本計數、簡單的空間關係 |

| 3 | 中等 | 需要簡短推理、識別常見動作或屬性 |

| 4 | 困難 | 多步推理、細微的視覺線索、或不常見的概念 |

| 5 | 非常困難 | 抽象推理、複雜的場景理解、或模糊不清的上下文 |

| 質量評分 | ||

| 1 | 非常低 | 完全錯誤或無關的回答 |

| 2 | 低 | 大部分錯誤,僅含少量正確元素 |

| 3 | 中 | 部分正確,但遺漏關鍵細節或包含錯誤 |

| 4 | 高 | 基本正確,僅有輕微不準確或遺漏 |

| 5 | 非常高 | 完全準確、精確且完整的回答 |

此外,模型會為每個問題分配 3 到 6 個簡潔、相關、開放式任務標籤,描述問題的性質(例如:“counting”、“color”、“spatial”、“action”、“object”、“attribute”、“reasoning”、“scene”、“text”、“math” 等)。為了保證語義的清晰性,我們僅使用常見、通用的標籤。

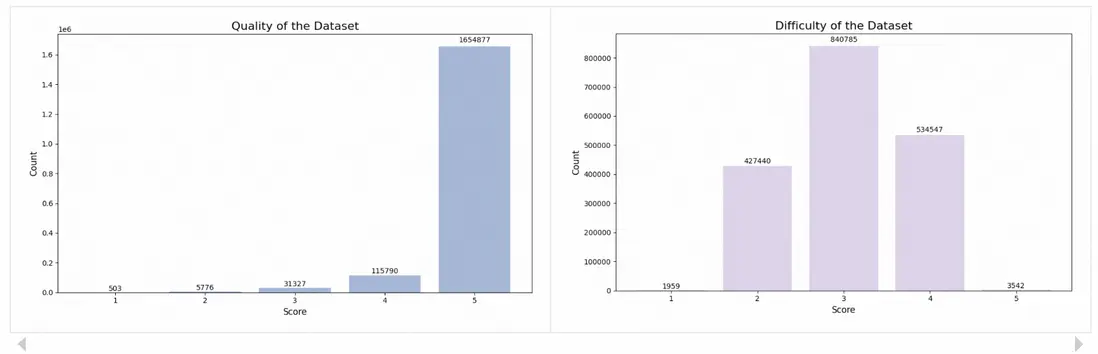

OmniThoughtV數據集的標註統計結果如下:

可以看出,絕大多數OmniThoughtV數據集中的思維鏈質量極高,在難度上明顯呈現近似正態分佈。我們進一步使用詞雲統計了任務標籤:

從數據標籤統計可以看出該數據集覆蓋廣泛的領域主題和任務類型,包括但不限於:

- 視覺理解:如對象識別(

object)、屬性解析(attribute)、場景理解(scene); - 空間推理:如位置關係(

spatial、position、layout)、方向(direction)與座標(coordinate); - 圖表解讀:涵蓋多種可視化形式(

chart、graph、table、bar chart、pie chart、scatter plot)及其元信息(axis、legend、label、caption); - 邏輯推理:包括計數(

count)、比較(comparison)、數學計算(math、algebra、geometry)以及統計概念(percentage、ratio、average); - 領域知識:涉及科學(

physics、chemistry、biology)、技術(code、algorithm、electronics)、人文(history、politics、literature)等多個領域; - 反思能力:強調事實核查(

verification、fact-check)、誤差識別(error、discrepancy)與細節敏感性(precision、detail)。

實驗效果評測

為了系統性地尋找最優訓練超參數,我們採用不同的超參數組合,對 Qwen2.5-VL-3B-Instruct 模型在視覺推理任務上的表現進行了訓練與評測。首先,我們在 MMMU_pro_vision Benchmark 上開展了一系列微調超參數的實驗。該基準能夠全面、深入地衡量模型在複雜圖像理解與多步邏輯推理方面的綜合能力。在未進行任何微調的情況下,原始的 Qwen2.5-VL-3B-Instruct 模型在該基準上的得分僅為 0.2130。我們使用的Prompt模版如下圖所示。

SYSTEM_PROMPT="You are a helpful assistant to think step by step. Provide your reasoning steps within <thinking></thinking> tags and give your final answer within <answer></answer> tags. Final answer requirement: Answer with the option letter from the given choices directly."

QUERY_PROMPT=f"""

### Question

{question}

### Output Format (Strictly Enforced)

<thinking>

Clearly explain your reasoning step by step. Describe how you arrived at the conclusion.

The reasoning process MUST BE enclosed within <thinking> </thinking> tags.

</thinking>

<answer>

Your final answer to the user's question.

Answer with the option letter from the given choices directly.

</answer>

"""隨後,我們圍繞學習率和訓練輪次(Epoch)這兩個核心超參數,設計了多組對比實驗,以探索它們對模型最終性能的影響。具體而言,我們測試了四種不同的學習率(5e-6、1e-5、2e-5、4e-5),並分別在 1 至 5 個訓練輪次下觀察模型得分的變化趨勢。實驗結果顯示,不同超參數組合對模型性能有着顯著影響:例如,當學習率為 5e-6,且訓練 4 個 Epoch 時,模型取得了 0.3220 的最佳分數;而較高的學習率(如 4e-5)則普遍導致性能下降,表明過高的學習率可能不利於模型穩定收斂。最終,我們選用了 5e-6 的學習率,訓練 4 個 Epoch 作為後續實驗的微調訓練參數。

| 學習率/Epoch | 1 Epoch | 2 Epochs | 3 Epochs | 4 Epochs | 5 Epochs |

|---|---|---|---|---|---|

| 5e-6 | 0.2815 | 0.2936 | 0.3116 | 0.3220 | 0.3087 |

| 1e-5 | 0.2931 | 0.3017 | 0.3093 | 0.3104 | 0.3098 |

| 2e-5 | 0.2722 | 0.2919 | 0.2977 | 0.2959 | 0.3000 |

| 4e-5 | 0.2566 | 0.2515 | 0.2671 | 0.2688 | 0.2798 |

為了深入探究數據篩選策略對模型微調效果的影響,我們系統性地測試了“質量”(Quality)與“難度”(Difficulty)指標的數據過濾條件,並在前述實驗的最佳超參數設置下評估其訓練性能。每組過濾條件對應的微調數據集均統一為 10 萬條。實驗結果表明,單純依賴標註質量指標進行過濾(如僅保留 Quality ≥ 5 的數據)反而會導致模型性能輕微下降(得分 0.2948),甚至低於未經過過濾的原始數據集(得分 0.3093)。這説明高標註質量數據未必等同於高有效性,有時可能因過於簡單或同質化而削弱模型的學習能力。 相反,當引入“難度”指標作為核心過濾條件時,模型表現顯著提升:在僅要求 Difficulty ≥ 4 的條件下,模型得分躍升至 0.3156;而將高質量與高難度相結合(Quality ≥ 5 且 Difficulty ≥ 4)時,模型得分也達到了 0.3139,同樣優於無過濾基線。由此驗證了我們提出的“難度”與“標註質量”聯合過濾的有效性。同時也得出結論,在當前任務場景下,以“難度”為核心的過濾機制比單純依賴“標註質量”的過濾策略更為有效,因為它能更精準地篩選出既能挑戰模型、又能促進其推理能力提升的關鍵樣本,從而更高效地驅動模型性能的提升。

| 過濾條件 | 分數 |

|---|---|

| 無過濾 | 0.3093 |

| Quality>=5; Difficulty>=0 | 0.2948 |

| Quality>=0; Difficulty>=4 | 0.3156 |

| Quality>=5; Difficulty>=4 | 0.3139 |

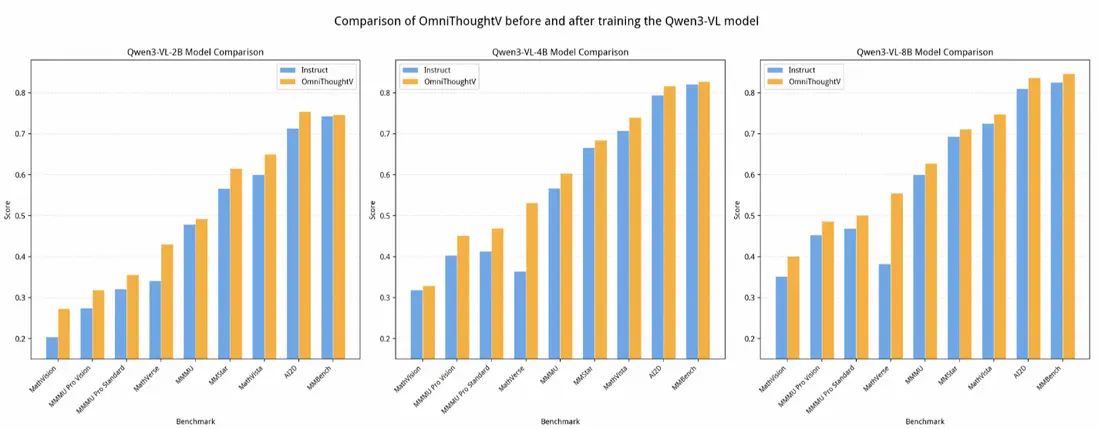

我們基於 Quality ≥ 5,Difficulty ≥ 4 的過濾條件,篩選得到約 50 萬條數據,並對 Qwen3-VL 2B、4B、8B 版本進行了微調。我們使用 LMMs-Eval 框架進行評測。由於不同 Prompt 評測模板會對測評結果產生影響,我們在評測過程中統一固定了一套推理 Prompt。實驗結果如下表所示。 我們成功驗證了數據集的有效性,通過構建了約 50 萬條高質量、高難度的訓練數據,以此微調 Qwen3-VL 系列不同規模的模型(2B、4B、8B)的實驗數據顯示,無論是在通用視覺理解能力 benchmark(如 AI2D、MMStar),還是在對推理能力更敏感的 benchmark(如 MMMU_Pro_standard、MMMU_Pro_vision、 MathVerse、 MathVision)上,所有經過微調的模型均實現了性能提升,在強調推理能力的 benchmark 上提升尤為顯著。這充分證明了高質量數據的蒸餾、篩選與規模擴展對模型推理能力提升的有效性。

綜上而言,OmniThoughtV 數據集的構建流程不僅驗證了長思考思維鏈數據不僅能提升模型在視覺推理等任務上的推理能力,也驗證了模型“看圖深度思考”能力的提升也能提高模型的通用視覺理解能力。OmniThoughtV 數據集很好彌補了開源社區中大規模多模態長思考數據集的匱乏,也通過系統化的數據工程,提供了全流程清晰、可復現的工具和技術路線。

資源下載和使用

在EasyDistill框架的使用教程

通過使用阿里雲人工智能平台(PAI)推出的開源工具包EasyDistill,用户可以輕鬆實現實現多模態思維鏈數據的蒸餾、對思維鏈數據打分。

- 克隆代碼庫,並安裝相關依賴:

git clone https://github.com/modelscope/easydistill

cd EasyDistill

pip install -r requirements.txt- 可以使用各種配置文件生成訓練數據,以思維鏈數據生成為例,配置文件如下:

{

"job_type": "mmkd_black_box_api",

"dataset": {

"instruction_path": "data/mllm_demo.json",

"labeled_path": "data/mllm_demo_distill.json",

"seed": 42

},

"inference":{

"base_url": "ENDPOINT",

"api_key": "TOKEN",

"system_prompt" : "You are a helpful assistant.",

"max_new_tokens": 512

},

"models": {

"student": "student/Qwen/Qwen3-VL-2B-Instruct/"

},

"training": {

"output_dir": "./result/",

"num_train_epochs": 3,

"per_device_train_batch_size": 1,

"gradient_accumulation_steps": 8,

"max_length": 512,

"save_steps": 1000,

"logging_steps": 1,

"learning_rate": 2e-5,

"weight_decay": 0.05,

"warmup_ratio": 0.1,

"lr_scheduler_type": "cosine"

}

}- 完成思維鏈數據生成後,可以使用思維鏈評價打分功能,配置文件如下:

{

"job_type": "mmcot_eval_api",

"dataset": {

"input_path": "cot_input.json",

"output_path": "cot_output.json"

},

"inference":{

"base_url": "https://dashscope.aliyuncs.com/compatible-mode/v1",

"api_key": "YOUR KEY",

"max_new_tokens": 8196

}

}運行下面的命令,即可完成對cot數據質量的評價打分:

export JUDGE_MODEL=qwen3-vl-plus

easydistill --config mmcot_eval_api.json詳細用法可以參考 https://github.com/modelscope/easydistill/blob/main/docs/CoT_Eval.md

從HuggingFace/ModelScope下載資源

我們的公開的數據約180萬條原始數據集和50萬條篩選後的數據集。每一條數據都帶有評分。篩選後的數據集是難度大於等於4分,質量大於等於5分的數據。數據集中的圖像採用base64編碼儲存。

| 數據集 | HuggingFace | ModelScope |

|---|---|---|

| OmmiThoughtV_Raw_1.8M | https://huggingface.co/datasets/alibaba-pai/OmmiThoughtV_Raw_... | https://modelscope.cn/datasets/platformofai/OmniThoughtV_Raw_... |

| OmniThoughtV_Filter_0.5M | https://huggingface.co/datasets/alibaba-pai/OmniThoughtV_Filt... | https://modelscope.cn/datasets/platformofai/OmniThoughtV_Filt... |

可以參考以下代碼讀取數據集:

from datasets import load_dataset

data_path='...YOUR_PATH_To.../OmmiThoughtV_Raw_1.8M/'

OmmiThoughtV=load_dataset(data_path, streaming=True)場景化應用

除了典型的多模態任務,我們提出的蒸餾方法可以有效應用於各種實際場景中,以下我們給出多個多模態深度思考任務的典型應用。

自動駕駛

問題:你需要右轉,請基於當前圖像中的道路環境和交通狀況,請分析並規劃你(自動駕駛車輛)下一步的最優駕駛策略。

<thinking>

1. **評估道路環境**:圖像顯示了一條多車道的城市道路,交通繁忙,前方有大型綠色自卸卡車和一輛白色轎車。道路兩側有高層建築,表明這是一個密集的城市區域。道路由黃色隔離欄分隔,表明車流受到管控。

2. **識別當前車道及交通流**:車輛位於中間車道,該車道似乎是直行車道。圖像中未見明顯的右轉車道或轉彎信號指示,因此右轉並不立即可行。相鄰車道有大型卡車,表明轉彎時需謹慎操作以避免碰撞。

3. **評估右轉可行性**:前方道路看起來是直行的,未見明顯的右轉車道或轉彎信號標誌。相鄰車道的大型卡車表明,若要轉彎,需要小心操作以避免碰撞。黃色隔離欄表明道路為分隔式設計,轉彎可能需要駛離當前車道。

4. **考慮交通法規與安全性**:圖像中顯示了一個“40”的限速標誌,表明限速為40公里/小時。大型卡車的存在提示車輛應保持安全車距,避免突然變道或轉向。黃色隔離欄進一步説明道路為分隔設計,轉彎可能需提前變道。

5. **規劃最優駕駛策略**:基於當前的道路環境和交通狀況,作為自動駕駛車輛,下一步的最優駕駛策略應為:

- **保持當前車道**,繼續直行,直到到達指定的右轉車道或交叉路口。

- **持續監測交通狀況**,確保有足夠空間安全完成右轉。

- **利用車輛的傳感器和攝像頭**,探測周圍環境中可能存在的障礙物或危險。

- **遵守交通法規**,與其他車輛保持安全距離。

- **僅在安全且合法的情況下執行右轉**,確保不阻礙其他車輛正常通行。

6. **結論**:作為自動駕駛車輛,下一步的最優駕駛策略是保持當前車道繼續直行,直至到達指定的右轉車道或交叉路口,同時密切觀察交通狀況,確保有充足空間安全完成右轉。

</thinking>

<answer>

保持當前車道繼續直行,直至到達指定的右轉車道或交叉路口,同時監測交通狀況並確保有足夠空間安全完成右轉。

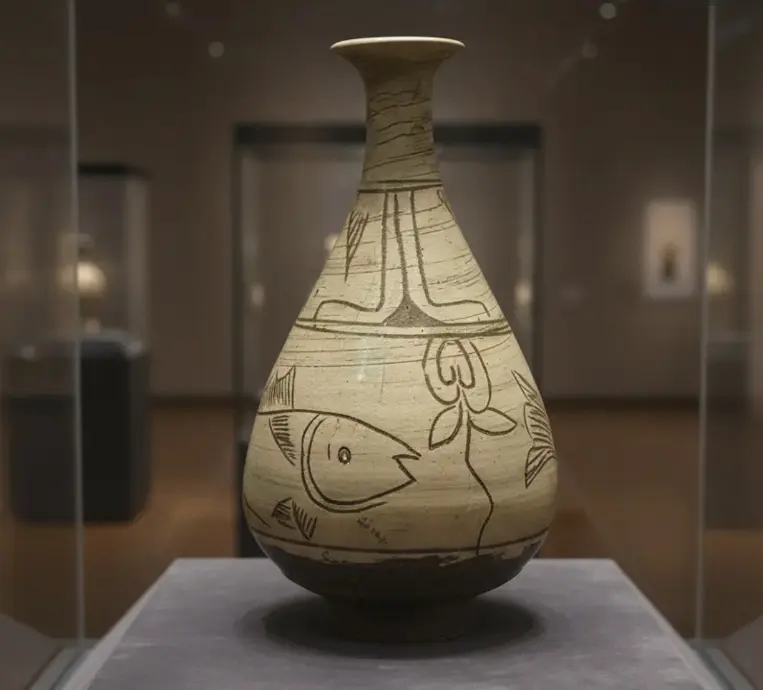

</answer>文物講解

假如你是博物館講解員,分析此陶器歷史背景。

<thinking>

第一步:分析該陶器的視覺特徵。器物擁有細長的頸部和圓鼓的腹部,這種器型在東亞陶瓷傳統中十分常見。器表裝飾有風格化的魚紋和花卉圖案,表明其用途更偏向象徵性或裝飾性,而非日常實用。

第二步:考察釉面與表面質感。釉色呈柔和的土色調,略帶斑駁或砂質感,這表明它很可能採用天然陶土,並以低温或半燒製工藝製成——這在古代朝鮮陶瓷中頗為典型。釉面呈灰藍色調,説明使用了含鐵量較高的陶土,並採用了還原焰燒製工藝,這種技法在朝鮮陶器中常用於營造含蓄而典雅的視覺效果。

第三步:推測歷史時期。具備此類特徵(魚紋、砂質感、灰藍釉)的陶器,與高麗王朝(918–1392年)尤其是晚期(12至13世紀)的朝鮮陶器風格相符。這一時期,朝鮮陶工發展出獨具特色的風格,包括著名的“粉青沙器”(buncheong或powder-blue ware),常飾以精巧的手繪紋樣和柔和半透明的釉面。魚紋可能象徵富足、多產或與自然和諧共處,這些主題在朝鮮藝術中十分常見。

第四步:考慮文化背景。此器物的設計與工藝表明,它很可能用於禮儀或祭祀場合,例如盛裝酒或水,也可能是貴族家庭中的陳設品。魚與花卉元素的結合,反映了當時朝鮮社會崇尚平衡、和諧以及自然崇拜的文化價值觀。

第五步:結合博物館語境。該文物被置於玻璃展櫃中陳列,説明其具有重要的歷史與文化價值。其保存狀態與展示方式表明,它是朝鮮豐富陶瓷遺產中的一件珍貴代表,很可能製作於高麗王朝晚期。

結論:綜合其視覺特徵與歷史背景,這件陶器很可能是一件高麗王朝晚期的作品,採用傳統朝鮮製陶技藝製作而成,並飾有象徵性的紋樣,體現了當時朝鮮陶工在陶瓷藝術上的高度成就與文化內涵。

</thinking>

<answer>

這件陶器很可能源自朝鮮高麗王朝晚期(918–1392年),該時期以精緻的陶瓷藝術著稱。器物細頸鼓腹的造型,輔以風格化的魚紋與花卉圖案,表明其用途偏向禮儀性或裝飾性。其砂質肌理與灰藍色釉面,反映出當時朝鮮陶工採用含鐵陶土及傳統還原焰燒製工藝的典型技法。魚紋可能象徵富足或與自然的和諧,體現了當時的主流文化價值觀。此器被博物館珍藏並展出,彰顯了它作為朝鮮陶瓷藝術瑰寶的重要歷史與文化意義。

</answer>自動商品審核

這是用户發來的商品圖,並申請了自動退款,請審核是否滿足退款要求。

<thinking>

圖片顯示了一盒橙子,其中一個橙子表面明顯長有黴菌(灰綠色斑塊)。水果上出現黴菌是變質的明確標誌,通常被視為缺陷,會使該產品不符合新鮮且安全食用的標準。

大多數線上或零售購買的標準退款政策都包含針對變質、損壞或與描述不符商品的條款。由於黴菌清晰可見,影響了產品的質量和安全性,因此符合典型消費者保護政策下的退款條件。

因此,應批准退款請求。

</thinking>

<answer>

是的,退款條件已滿足,因為橙子表面可見黴菌,表明其已變質,不再符合新鮮且安全食用的標準。

</answer> 小結

本文介紹了OmniThoughtV數據集,這是首個開源的大規模多模態長思考蒸餾數據集。我們完整構建了一套透明、可復現、高質量的多模態數據蒸餾與篩選流程,並系統驗證了其在提升多模態大模型視覺推理能力方面的關鍵作用。我們通過嚴謹的消融實驗,首次明確指出“難度”指標在數據篩選中的核心價值:相較於單純依賴標註質量評分,引入高難度樣本能更有效地驅動模型學習複雜推理邏輯,從而顯著提升泛化性能。基於這一發現,我們設計了完整的數據過濾標準,從原始數據集中精準提煉出約50萬條兼具挑戰性與代表性的訓練樣本,併成功提升了Qwen3-VL系列的性能表現。實驗結果表明,該數據流程不僅使各模型在多個權威評測集上實現穩定且顯著的能力躍升,更展現出良好的模型規模擴展性。本工作填補了當前開源社區在結構化、可復現、面向推理能力提升的多模態數據蒸餾上的空白;在未來,我們會繼續深入探索大模型的蒸餾和訓練技術,推動大模型在各個場景的落地。

參考工作

EasyDistill系列相關論文

- Wenrui Cai, Chengyu Wang, Junbing Yan, Jun Huang, Xiangzhong Fang. Reasoning with OmniThought: A Large CoT Dataset with Verbosity and Cognitive Difficulty Annotations. arXiv preprint

- Yuanjie Lyu, Chengyu Wang, Jun Huang, Tong Xu. From Correction to Mastery: Reinforced Distillation of Large Language Model Agents. arXiv preprint

- Chengyu Wang, Junbing Yan, Wenrui Cai, Yuanhao Yue, Jun Huang. EasyDistill: A Comprehensive Toolkit for Effective Knowledge Distillation of Large Language Models. EMNLP 2025

- Wenrui Cai, Chengyu Wang, Junbing Yan, Jun Huang, Xiangzhong Fang. Thinking with DistilQwen: A Tale of Four Distilled Reasoning and Reward Model Series. EMNLP 2025

- Wenrui Cai, Chengyu Wang, Junbing Yan, Jun Huang, Xiangzhong Fang. Enhancing Reasoning Abilities of Small LLMs with Cognitive Alignment. EMNLP 2025

- Chengyu Wang, Junbing Yan, Yuanhao Yue, Jun Huang. DistilQwen2.5: Industrial Practices of Training Distilled Open Lightweight Language Models. ACL 2025

- Yuanhao Yue, Chengyu Wang, Jun Huang, Peng Wang. Building a Family of Data Augmentation Models for Low-cost LLM Fine-tuning on the Cloud. COLING 2025

- Yuanhao Yue, Chengyu Wang, Jun Huang, Peng Wang. Distilling Instruction-following Abilities of Large Language Models with Task-aware Curriculum Planning. EMNLP 2024