本期,我們更新和優化了實時開發相關功能,為您提供更高效的產品能力。以下為第14期袋鼠雲產品功能更新報告,請繼續閲讀。

功能新增

重點新增內容

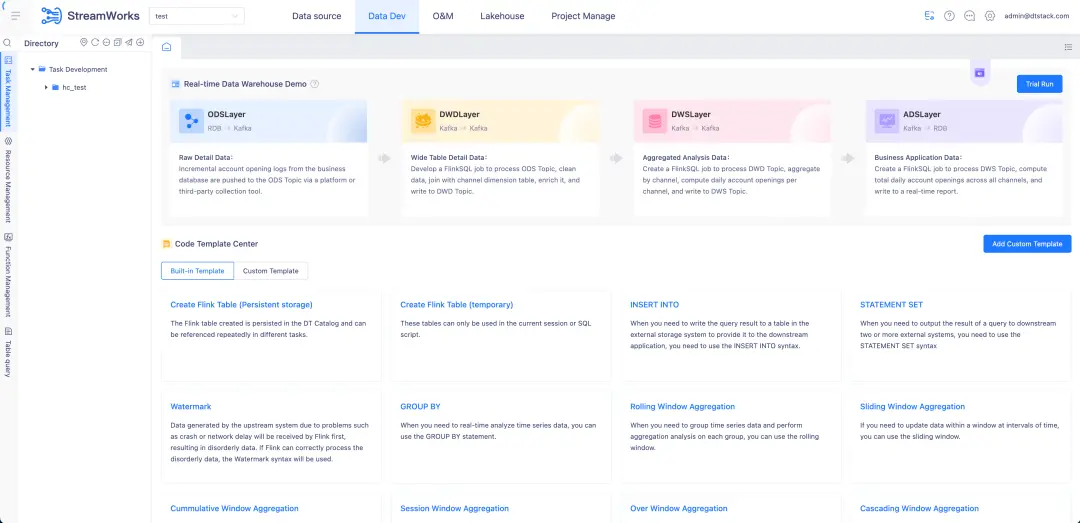

支持國際英文版

實時開發平台上線了國際英文版,適配全球國家的通用語言體系,消除語言差異帶來的使用問題。

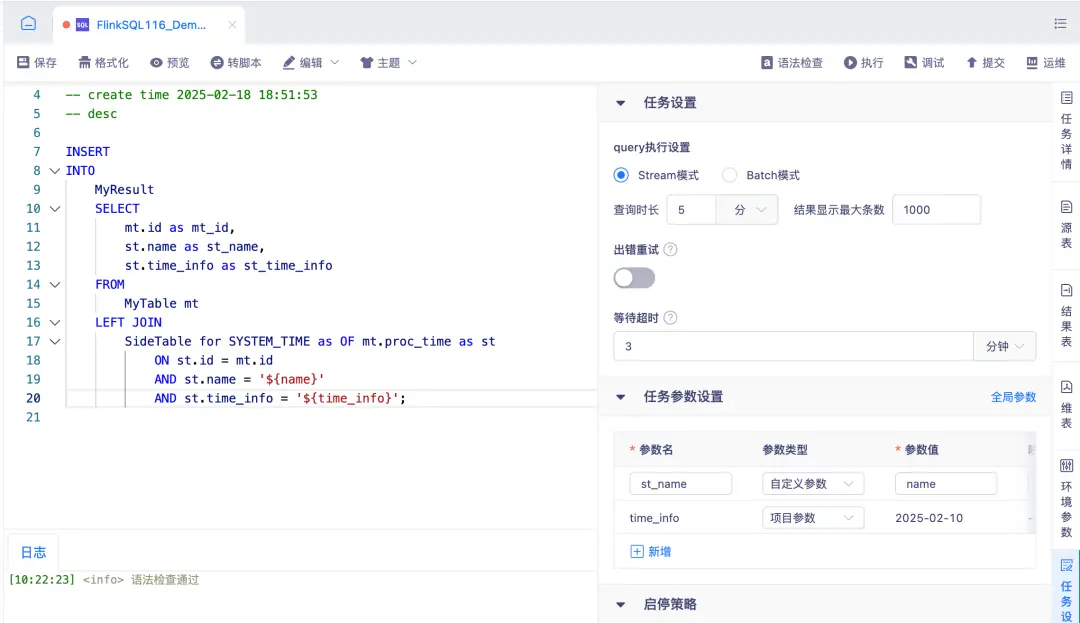

任務自定義參數支持項目級、全局參數

任務自定義參數現已支持項目級與全局參數:在任務參數設置-中映射值中將此任務發佈至目標項目時會自動替換原值;同時提供變量參數,可在單個任務內使用,適用於 FlinkSQL IDE 編輯區、FlinkJar 命令行參數、實時採集腳本模式 JSON 及 PyFlink 嚮導模式入參,使用格式為 ${參數名};此外,項目配置中新增了項目參數管理頁面,方便統一維護。

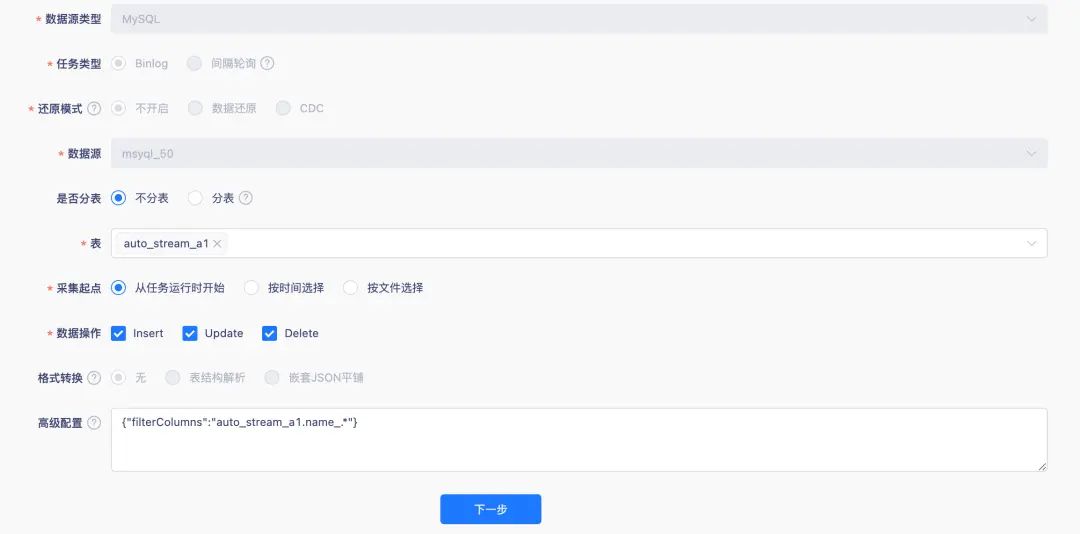

實時採集 MysqlBinlog 採集支持字段過濾

在實時 MySQL Binlog 採集中,我們新增了敏感字段過濾能力:在嚮導模式多表採集場景下,用户可通過高級參數 filterColumns 配置需要過濾的字段(支持表名、字段名正則匹配,格式 " filterColumns ":" tableName.columnName "),目前適用於 Flink 1.16 及以上版本的 MySQL Binlog 採集,助力用户滿足安全合規需求。

實時採集腳本模式支持 FlinkCDC Yaml 格式

實時採集支持 FlinkCDC Yaml 格式,適用於 Flink 1.16 及以上版本,並支持自定義參數使用,方便用户直接以原生腳本方式運行代碼。

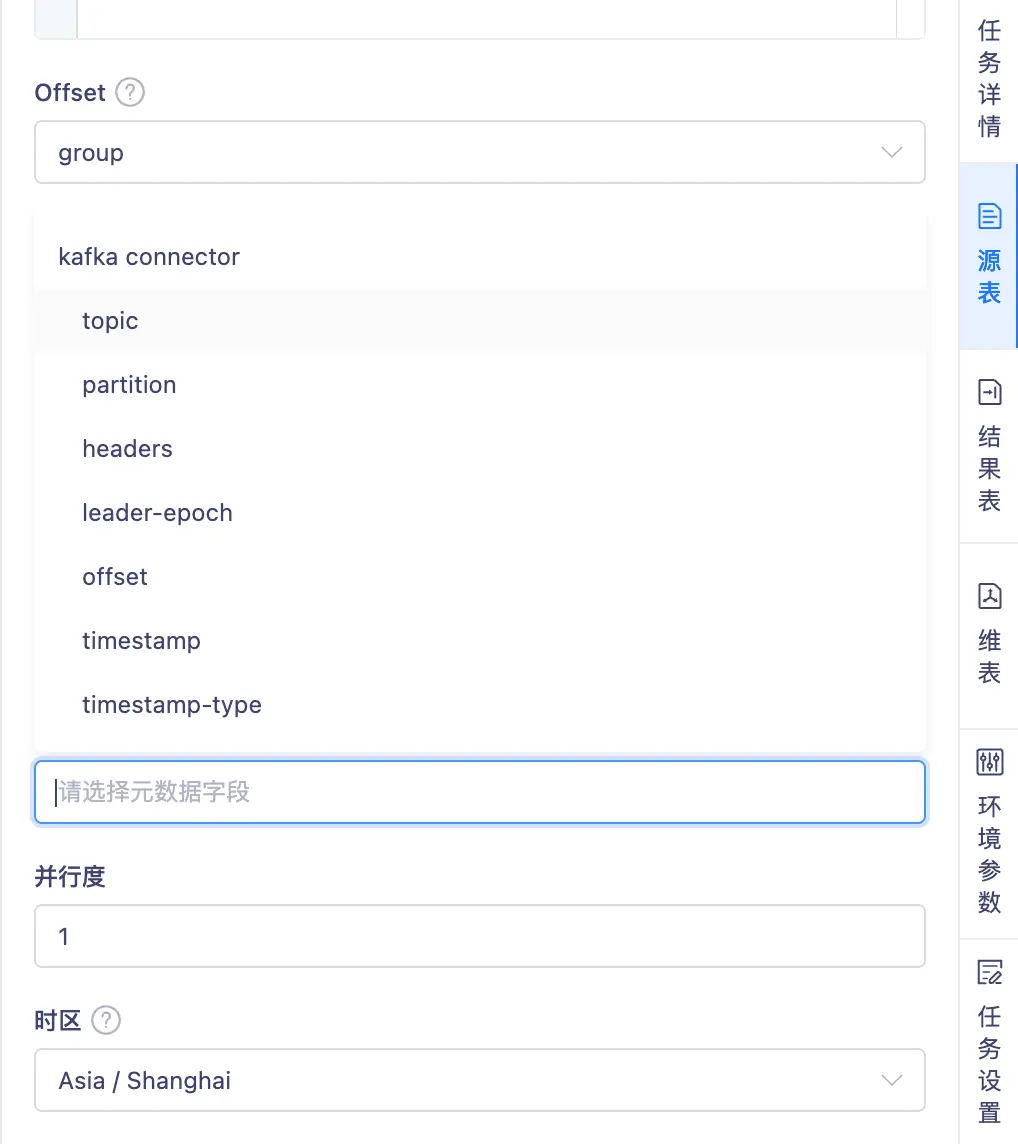

FlinkSQL 嚮導模式 Kafka 源表支持選擇可用元數據

在 FlinkSQL 嚮導模式(支持 1.12 、1.16 版本),使用 Kafka 源表時現已支持在 With 中選擇可用的 Kafka 元數據參數。針對 JSON、OGG-JSON、AVRO、CSV、RAW、Debezium-JSON ,用户可將可用的 Kafka Metadata 配置為運行 SQL 的字段,提升建表靈活性。

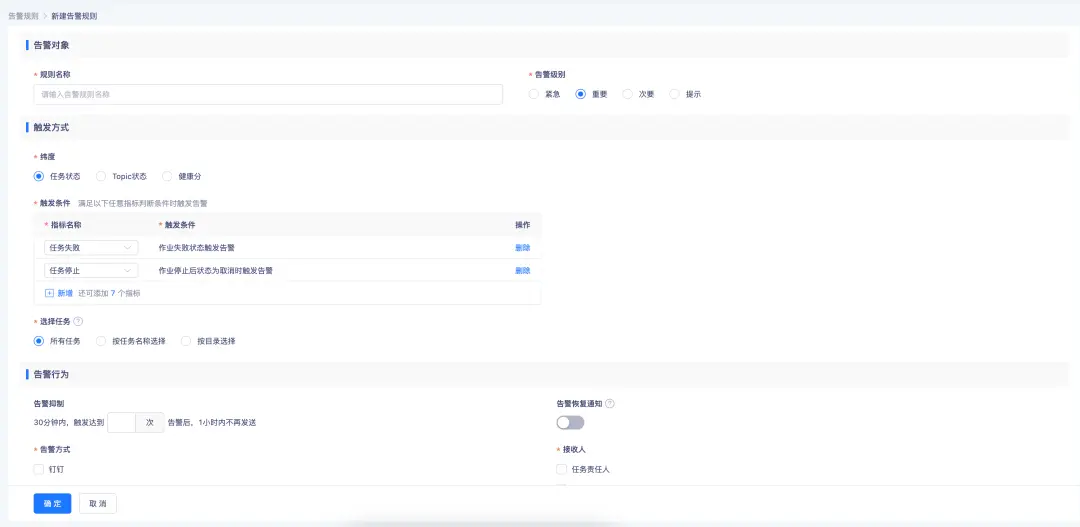

運維管理中告警規則支持對應多個告警指標

運維管理告警能力進一步優化:現在支持單個告警配置多個告警指標,對相似告警可統一處理,減少重複配置工作;同時支持在同一維度下設置多條觸發規則,只要滿足任意一條即可觸發告警,幫助用户更高效地進行運維監控。

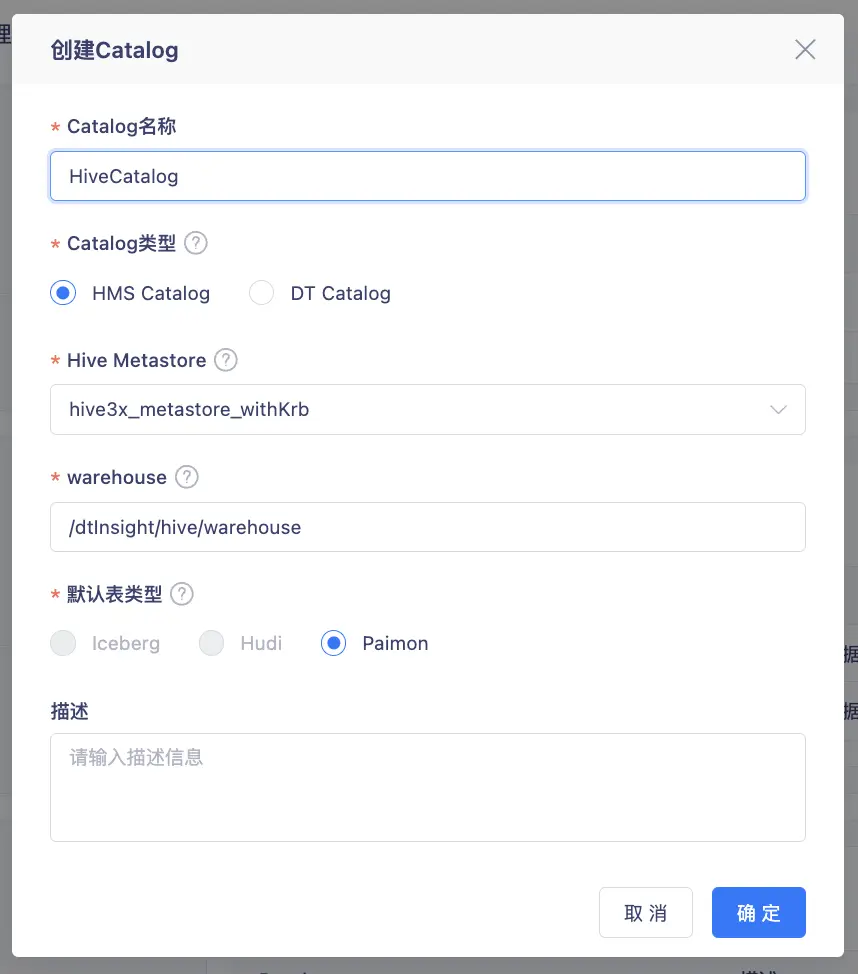

元數據管理 HiveMetaStore 支持 Hive3.1 適配

完成元數據管理 Catalog 對 HiveMetaStore 的 Hive 3.1 版本適配,支持 Flink 1.16,並在數據源中心新增 HiveMetaStore 3.x 類型。該版本可在 Hadoop 3.x 集羣中運行,支持認證方式開啓 Kerberos 和非開啓 Kerberos 的情況,同時支持 Hive 3.x 下的 Paimon 湖格式,為用户帶來更完善的湖倉一體化體驗。

底層元數據庫適配達夢(DM)

- 通過將底層元數據庫全面適配至國產達夢(DM)數據庫,助力企業在關鍵數字基礎設施領域的自主可控。

其他新增內容

- 元數據管理支持控制枱 Sftp 使用 RSA 認證方式

- FLinkSQL 支持 hyperbase 9.0 作為維表和結果表適配

- FLinkSQL 支持 keybyte 9.0 作為維表和結果表適配

- FLinkSQL 結果表支持 KingBaseESV8R6

- FLinkSQL 結果表支持 OushuDB 外部表寫入

功能優化

重點功能優化説明

實時採集 FLinkCDC 優化支持 Transformer 轉換規則

實時採集 FlinkCDC 現已支持 Transformer 轉換規則,在 Flink 1.16 版本下可對錶字段進行 projection、filter、primary-key、table-options 等級別的靈活轉換。

FLinkSQL 支持 FLinkCDC 數據源可視化 Oralce

FlinkSQL 支持對 FlinkCDC Oracle 數據源的可視化支持,適用於 Flink 1.16 版本,用户可在嚮導模式下直接配置 Oracle-CDC。

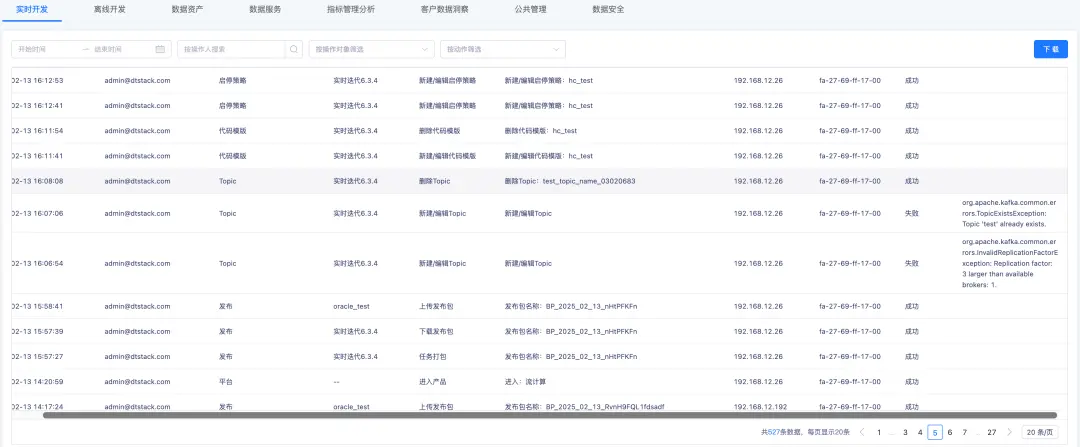

實時開發平台操作記錄至安全審計平台

實時開發平台完成一系列內部優化:新增操作記錄同步至安全審計平台,並在列表中支持展示操作結果、失敗原因及操作對象篩選;同時整理並整合歷史動作,優化操作對象匹配與搜索條件;此外,還修復了數據預覽連接信息顯示和頁面字符超長展示等問題,整體執行與審計體驗更完善。

FLinkSQL 嚮導模式源表 Kafka 配置 offset 支持選擇 group-offsets

FlinkSQL 嚮導模式在配置 Kafka 源表 offset 時,現已支持選擇 group-offsets,適用於 Flink 1.12 與 1.16 版本;當未輸入 group.id 時,系統會自動設置默認值,使用更便捷。

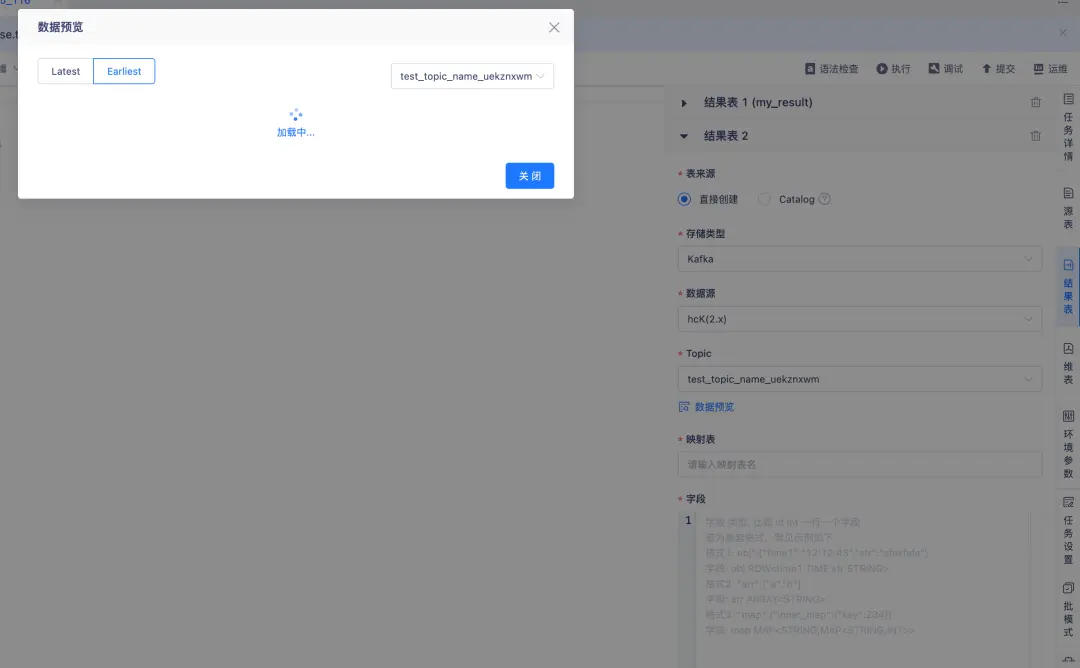

優化參數模版提示及數據預覽功能

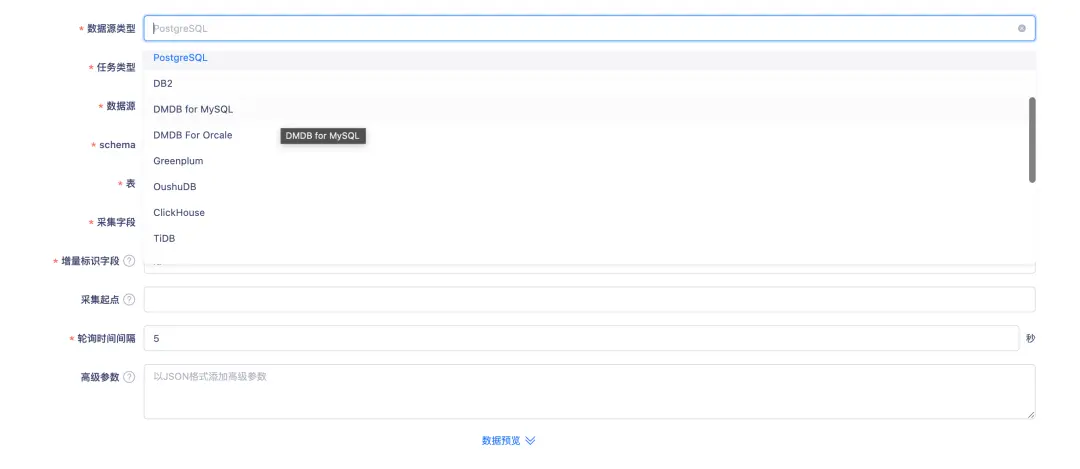

參數模板與數據預覽功能優化:更新了參數模板提示語,並在 FlinkSQL 數據開發中擴展了數據預覽能力,現已支持更多數據源,包括 PostgreSQL、KingbaseES、Impala、ClickHouse、TiDB、Kudu、MongoDB 以及 Kafka(結果表),讓調試與驗證更高效。

實時採集適配引擎已完成的數據源插件

實時採集優化支持引擎適配的數據源插件,在 Flink 1.16 版本下支持 TiDB、OceanBase(MySQL、Oracle 模式)及 PostgreSQL 的間隔輪詢採集,進一步完善數據源接入能力。

底層 Engine-plguins 提交流程狀態優化

- 內部對 Engine-plguins 提交流程狀態優化,解決客户在提交任務的時候在資源不足,網絡波動,hdfs 負載過高等場景下會出現狀態遊離的場景。

- 修復場景hdfs負載過高,網絡波動導致任務上傳 jar 包時間過長超過調度超時時間導致任務遊離。

- 修復場景資源不足導致 perjob 任務被提交到 yarn 上之後由於集羣沒有資源拉起jm 導致任務導致 submit 接口沒有返回從而超時。導致任務遊離。

- 修復場景資源不足導致 perjob 任務被提交到 yarn 上之後由於集羣沒有資源拉起jm導致任務導致 submit 接口沒有返回,而此時客户對於當前任務進行kill操作導致任務遊離。

其他功能優化説明

- 實時湖倉一級菜單名稱變更為元數據管理;

- 數據開發任務執行按鈕體驗優化:在 FlinkSQL 數據開發中,任務結果頁已移除“開始/停止”按鈕,執行中狀態僅展示停止按鈕,任務停止後則展示執行按鈕,操作更直觀高效;

- 實時採集 PGWAL Source 現已支持將數據寫入 Kafka,併兼容多種數據類型,包括 JSON、JSONB、Array、Geometry(PostGIS 經緯度)及 Enum 類型,適用於 Flink 1.16 版本,滿足更豐富的數據採集需求;

- FlinkSQL Oushu 寫入內外表切換通過結果表前端配置選擇項進行切換,默認使用COPY 導入方式,需在控制枱配置 HDFS 參數後支持選擇 HDFS 導入切換;

- FLinkSQL 嚮導模式支持開啓 kerberos 的 hive2 數據源;

- Kafka 版本適配優化:在項目交付中,Kafka 0.10 與 0.11 版本區分支持,實現 Topic 管理對兩版本的創建操作;

- 實時前端頁面已完成整體 UI 優化與遷移,為用户帶來更清晰流暢的使用體驗。