今年涌現了大量新的視頻模型,可以説 2025 年是視頻建模真正主導公眾對 AI 技術興趣的第一年。隨着 Sora 2 的普及,這一點變得越來越清晰。得益於 OpenAI 的一系列移動應用程序,獲取視頻生成工具的可能性與普及度達到了前所未有的高度。但閉源模型並非本文的重點,而這些模型的開源競爭實際上正變得比以往任何時候都更加令人印象深刻。

今年早些時候,HunyuanVideo 和 Wan2.1 以其令人難以置信的保真度、相對低廉的成本和公開可用性震撼了開源世界。這種發展趨勢仍在繼續,Wan 的新版本不斷髮布,其他競爭對手也紛紛入場。

在本文中,我們將介紹最新公開可用的視頻模型:美團的 LongCat Video。這個出色的視頻模型是進入我們工具箱的最新、最棒的開源工具,我們很高興在本教程中展示如何從今天開始,利用 DigitalOcean 生成你自己的視頻。

請跟隨我們,簡要了解 LongCat Video 的工作原理,以及一個展示如何在配備 NVIDIA GPU 的 DigitalOcean GPU Droplet 上設置並開始運行 LongCat Video 的教程。

本文的核心要點

- LongCat Video 是目前可用的、對標 Sora 2 的最佳開源競爭者。

- 用户可以使用 DigitalOcean GPU Droplets,通過自己的提示詞和硬件,生成質量可與 Sora 2 媲美的視頻。

- 運行 LongCat Video 至少需要 NVIDIA GPU 系統上具備 80GB 的顯存,但可以擴展到多 GPU 設置以加快生成速度。

LongCat Video:概述

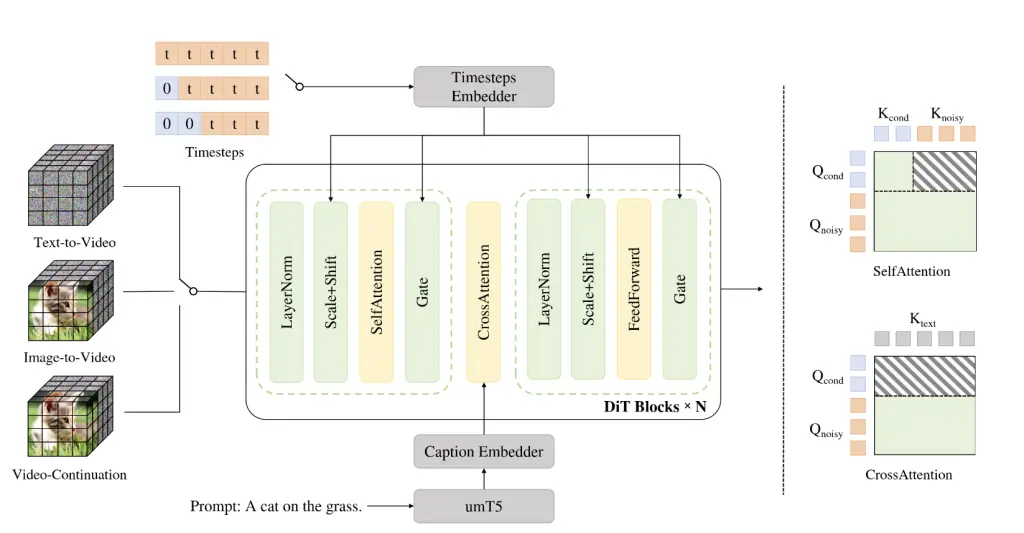

LongCat Video 的精妙之處在於其核心架構。這是因為他們非常巧妙地設計了一個單一管道來處理多項任務,包括文本到視頻、圖像到視頻和視頻延續。他們認為,所有這些任務都應被定義為視頻延續,即模型根據給定的一組前置條件幀來預測未來的幀。

為了實現這一點,他們採用了相對標準的擴散變換器架構,並配有單流變換器塊。“每個塊包含一個 3D 自注意力層、一個用於文本條件的交叉注意力層,以及一個帶有 SwiGLU 的前饋網絡。為了進行調製,他們利用了 AdaLN-Zero,其中每個塊都包含一個專用的調製 MLP。為了增強訓練穩定性,在自注意力模塊和交叉注意力模塊中都應用了 RMSNorm 作為 QKNorm。此外,還採用了 3D RoPE 作為視覺標記的位置編碼。”這種統一的架構允許使用相同的模型設計來完成三種視頻任務中的任何一種。

該模型在一個包含來自各種不同來源、視頻類型和主題的大量標註視頻語料庫上進行了訓練。我們可以在上圖中看到訓練數據中包含主題的大致聚類。對於這些數據,他們採用了強大的數據預處理和數據標註流程來進行文本標註。首先,收集並處理數據以確保沒有重複項、裁剪黑邊以及進行視頻過渡分割。目前,他們沒有詳細討論其數據來源。

LongCat Video 的閃光點及其與競爭對手的不同之處在於其長視頻生成能力和高效的推理策略。對於長視頻生成,LongCat-Video 原生地在視頻延續任務上進行了預訓練,使其能夠生成長達數分鐘的視頻,而不會出現色彩漂移或質量下降。在實踐中,這得益於訓練策略的魯棒性,其中對視頻延伸的關注在訓練結果中得以體現。至於高效的推理策略,我們指的是從粗到精的策略。在 LongCat Video 中,“視頻首先生成為 480p、15fps,隨後精煉至 720p、30fps。”(來源)此外,他們實現了一種新穎的塊稀疏注意力機制,有效地將注意力計算量減少到標準密集註意力所需計算量的 10% 以下。這一設計顯著提高了高分辨率精煉階段的效率。最後,他們使用了一種新穎的組相對策略優化策略來進一步優化其流程。他們有效地採用了帶有多個獎勵的強化學習範式。

總而言之,美團 LongCat Video 是一個功能強大的視頻生成和延續模型,作為一個工具,它既多功能又強大。他們認為其模型與最先進的競爭對手相比具有競爭力,我們希望通過本文展示如何在 DigitalOcean 的硬件上使用它。

LongCat Video 演示:如何在 DigitalOcean GPU Droplet 上運行 LongCat Video

1、設置 Gradient GPU Droplet

要開始運行 LongCat Video,我們建議從創建一個 DigitalOcean Gradient GPU Droplet 雲服務器開始。這些 GPU Droplet 配備了運行本教程所需的 GPU 資源。我們建議至少使用單卡 NVIDIA H200 GPU,但擁有 8xH100 或 8xH200 設置的用户將看到更快的視頻生成效率。DigitalOcean 的 GPU 資源不僅比 AWS、GCP 等大型雲平台更加實惠,GPU Droplet 的性能比 Vast.ai 等 GPU 租賃平台更加穩定,而且 GPU 可選型號比 Linode 更加豐富。

要啓動 GPU Droplet 並設置運行此演示的環境,我們建議使用本教程入門:https://blog.aidroplet.com/tutorials/do-gpu-jupyter-dl-setup/

可以從本地終端訪問正在運行的 GPU Droplet 後,請繼續跟着下一部分步驟來操作。

2、為 LongCat Video 設置遠程環境

通過 SSH 連接到遠程機器後,導航到你想要工作的目錄。進入目錄後,粘貼以下代碼開始設置你的環境。

git clone https://github.com/meituan-longcat/LongCat-Video

cd LongCat-Video

pip install torch==2.6.0+cu124 torchvision==0.21.0+cu124 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu124

pip install ninja

pip install psutil

pip install packaging

pip install flash_attn==2.7.4.post1

pip install -r requirements.txt完成上述步驟後,我們幾乎可以準備開始了。現在要做的就是下載模型檢查點!使用以下代碼片段來完成:

pip install "huggingface_hub[cli]"

huggingface-cli download meituan-longcat/LongCat-Video --local-dir ./weights/LongCat-Video3、使用 Streamlit 應用程序生成 LongCat 視頻

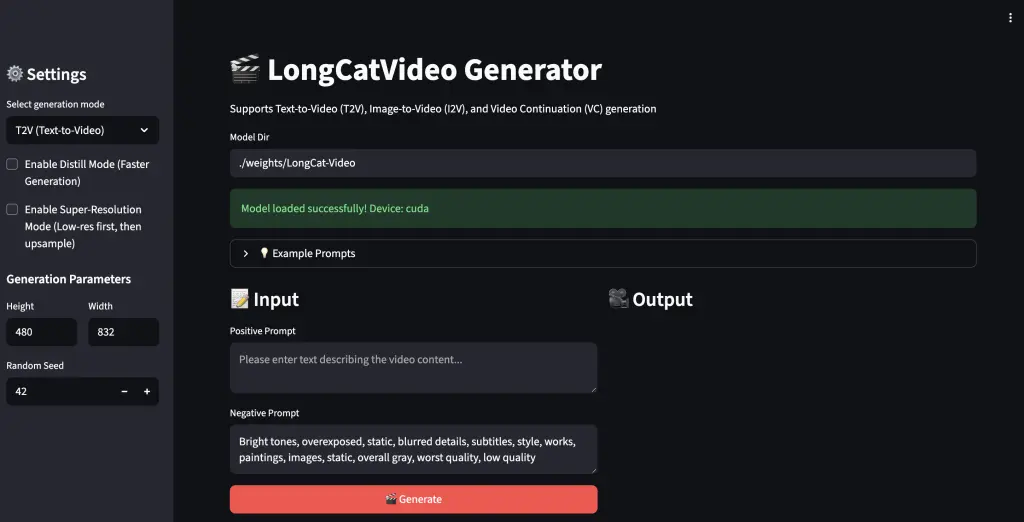

對於演示,我們建議使用作者提供的 Streamlit 應用程序來運行視頻生成。這個 Streamlit 演示使得在不同分辨率下生成視頻、從靜態圖像生成視頻以及延續視頻長度變得簡單。

設置完成後,我們就可以運行演示了。粘貼以下命令來運行演示。

streamlit run ./run_streamlit.py --server.fileWatcherType none --server.headless=false複製 Streamlit 窗口的 URL,然後使用 Cursor 或 VS Code 的簡單瀏覽器功能從本地訪問該窗口。設置 VS Code 環境的步驟在 卓普雲 aidroplet.com 的官網教程中有所概述。卓普雲是 DigitalOcean 中國區獨家戰略合作伙伴,為中國區企業客户提供商務對接與中文技術支持。

上圖顯示了加載後的 Streamlit 演示界面。左側有一個下拉菜單,我們可以在三個選項之間切換任務,啓用蒸餾模式(將模型限制為 16 個推理步驟而非 50 個),啓用超分辨率(從粗到精的上採樣),以及設置生成參數。在窗口本身,我們有選項可以輸入正面和負面提示詞文本,並且在其他任務中,根據需要添加圖像或視頻。

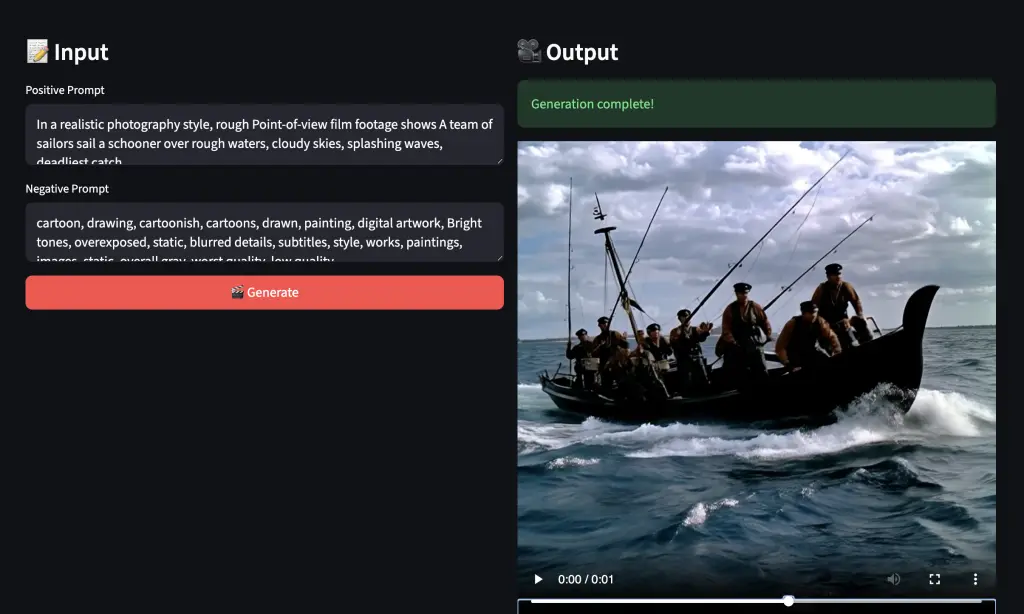

當我們運行生成器時,視頻輸出會顯示在右側!一定要嘗試各種不同的提示詞主題,來真正測試這個模型!

美團 LongCat Video 是一個真正強大的視頻生成範式。我們對其多功能性和能力都印象深刻。在測試中,它確實是 Wan2.1 和 HunyuanVideo 向前邁出的一步,並且與 Wan2.2 等最先進的模型不相上下。不僅如此,統一的框架使得這個流程比競爭對手更加令人印象深刻和多功能。我們期待未來圍繞 LongCat Video 發展出一個生態系統。