我們先來看一個常見的現象,大家也可以看下當前是否也遇到這類情況。

某大型製造企業在推進數字化轉型過程中,面臨一個典型的困境:生產系統的實時工單數據存於MySQL,倉儲物流使用SAP HANA,客户行為日誌流經Kafka,而集團BI分析依賴的卻是每月手動導出的Excel報表。多個團隊嘗試用腳本拼接數據,結果導致數據延遲嚴重、口徑不一,甚至出現財務對賬偏差。更棘手的是,當安全審計要求追溯某條銷售記錄的來源路徑時,技術團隊無法提供完整的血緣鏈路。

這一場景背後,是企業數據環境日益複雜的縮影。隨着業務系統解耦、微服務架構普及、雲原生部署成為主流,企業往往同時運行着數十種數據源:關係型數據庫、NoSQL、API接口、日誌文件、IoT設備流……這些數據分佈在私有云、公有云乃至邊緣節點,格式各異、更新頻率不一,形成了典型的“多源異構”格局。若缺乏統一的數據集成策略,不僅數據資產難以沉澱,連最基本的報表準確性都難以保障。

一、數據集成的戰略意義:不止於技術整合

數據集成早已不是“把數據從A搬到B”的初級階段,其核心價值在於打通數據資產流動的主動脈。通過統一治理的數據管道,企業能夠實現:

打破孤島:將分散在CRM、ERP、MES等系統中的數據打通,形成360°客户視圖或端到端供應鏈洞察;

支撐高階應用:為BI分析、機器學習模型訓練、實時風控決策提供高質量、低延遲的數據供給;

提升組織敏捷性:新業務上線時,無需重複開發數據對接邏輯,複用已有集成能力即可快速響應。

然而,錯誤的工具選型可能帶來高昂代價。某金融客户曾因選用封閉式ETL工具,在遷移到混合雲架構時遭遇嚴重兼容問題,項目延期8個月,額外投入運維人力超20人月。更普遍的風險包括:許可證成本失控、擴展性不足導致性能瓶頸、缺乏元數據管理引發合規風險等。

二、需求拆解:從業務目標到技術場景的映射

在啓動選型前,必須明確“我們到底要解決什麼問題”。這需要從三個維度協同思考:

1.視角分層:不同角色關注點不同

管理者關心投資回報率(ROI)、交付週期與合規性;

CIO關注架構兼容性、安全性與長期可維護性;

技術團隊則聚焦開發效率、調試體驗與故障排查能力。

2.場景分類:按數據流動模式劃分

3.關鍵需求清單(Checklist)

一個完整的評估框架應涵蓋:

- 支持的數據源類型(是否覆蓋老舊系統如DB2、ODBC?)

- 吞吐量與延遲指標(能否支撐每秒萬級事件處理?)

- 元數據自動採集與血緣追蹤能力

- 安全合規特性(字段級權限、GDPR脱敏、審計日誌)

三、核心能力評估框架:構建系統性判斷標準

面對市場上這麼多的數據集成工具選項,需建立多維評估模型,避免陷入“功能對比表陷阱”。

1.架構與部署模式

現代集成平台應支持混合部署能力,既能運行在Kubernetes集羣中實現彈性伸縮,也能對接本地數據中心。容器化部署已成為標配,能與Kubernetes等現代容器編排技術接軌。

2.連接性與擴展性

連接器的質量遠比數量重要。某些平台宣稱支持100+連接器,但實際對SAP ECC或Oracle EBS等複雜系統的支持僅限基礎讀寫。理想方案應提供標準化SDK,允許開發者基於JDBC、REST API快速封裝私有系統適配器,並具備版本管理能力。

3.數據處理範式支持

傳統ETL已難以滿足現代需求。領先的平台應同時支持:

ELT模式:將原始數據先加載至目標端(如Snowflake),再利用其計算資源進行轉換;

Reverse ETL:將分析結果反向寫回業務系統(如將客户分羣結果同步至CRM);

可視化+代碼混合開發:允許在圖形化流程中嵌入Python或Spark腳本,處理複雜邏輯。

4.實時性與性能

真正的實時集成依賴於變更數據捕獲(CDC) 技術。基於日誌解析的CDC(如Debezium)比輪詢方式減少90%以上的數據庫負載。同時,平台需內置流處理引擎或無縫對接Flink/Kafka,確保事件流的有序性和 Exactly-Once 語義。

5.數據治理與可觀測性

缺乏治理的集成等於製造新的技術債。必須具備:

自動化元數據採集(表結構、字段含義、更新頻率)

端到端血緣分析(從源系統到報表字段的追溯)

內建數據質量規則引擎(如空值率閾值告警)

6.安全與合規

身份認證應支持企業級標準(SAML、OAuth2.0、LDAP),並能與雲IAM系統集成。敏感字段需支持動態脱敏,且所有操作行為應記錄審計日誌,便於等保或SOC2審查。

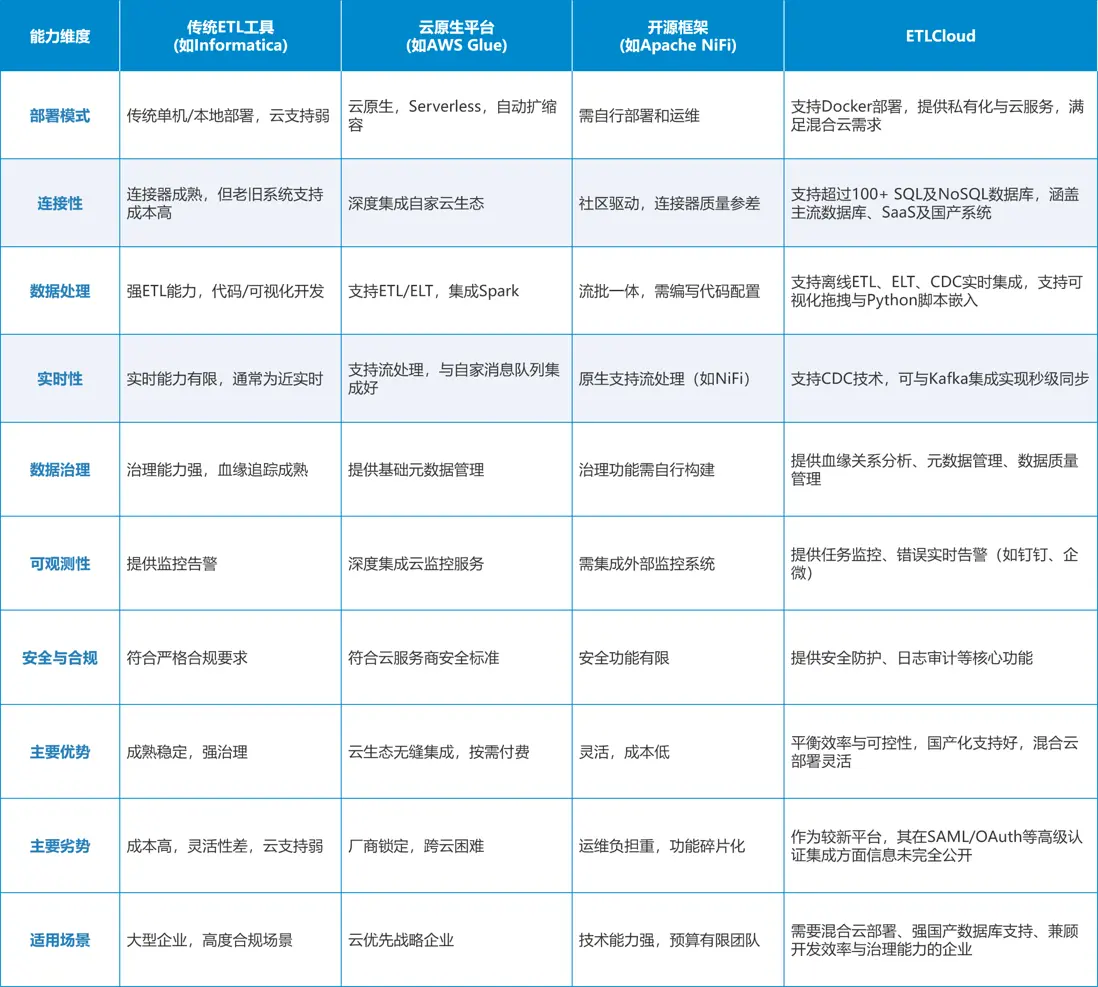

四、主流工具對比與適用場景

1.傳統ETL工具(Informatica、DataStage)

優勢在於成熟穩定、治理能力強,適合對合規要求極高的金融、醫療行業。但其單機架構難以適應雲環境,許可費用高昂,且開發效率偏低。

2.雲原生平台(AWS Glue、Azure Data Factory)

深度集成各自雲生態,支持Serverless執行與自動擴縮容,適合“雲優先”戰略企業。但跨雲遷移成本高,存在廠商鎖定風險。

3.開源框架(Apache NiFi、Airbyte)

靈活性高、成本低,適合技術能力強的團隊。但需自行搭建監控、高可用、權限體系,運維負擔重,功能碎片化明顯。

4.ETLCloud:平衡效率與可控性的新選擇

提供全託管雲服務的同時,也支持私有化部署,滿足混合雲需求;

內置超過100個高質量連接器,涵蓋主流數據庫、SaaS應用;

支持可視化編排+SQL/Python腳本嵌入,兼顧開發效率與處理靈活性;

元數據模塊可自動構建數據血緣圖譜,顯著降低治理成本。

更重要的是,其架構設計預留了對數據網格(Data Mesh) 和 語義層集成 的演進路徑,避免未來二次重構。

五、集成是能力,而非工具採購

數據集成的本質,是一場組織級的數據流通基礎設施建設。工具只是載體,真正的競爭力來自清晰的架構設計、統一的元數據標準、跨團隊的協作機制。

建議企業從“項目思維”轉向“平台思維”:不再為每個需求單獨搭建管道,而是構建可複用、可治理、可觀測的集成平台。未來,隨着AI在模式識別、異常檢測、自動映射中的深入應用,“智能集成”將成為新趨勢——而今天的選型決策,將決定企業能否順利邁入這一階段。