一、介紹

車型識別系統,基於TensorFlow搭建卷積神經網絡算法,通過對6種常見的車型車輛圖片數據集('SUV', '吉普車', '家用轎車', '巴士', '貨車', '麪包車')進行訓練,最後得到一個識別精度較高的模型,然後搭建Web可視化操作平台。

前端: Vue3、Element Plus

後端:Django

算法:TensorFlow、卷積神經網絡算法

具體功能:

- 系統分為管理員和用户兩個角色,登錄後根據角色顯示其可訪問的頁面模塊。

- 登錄系統後可發佈、查看、編輯文章,創建文章功能中集成了markdown編輯器,可對文章進行編輯。

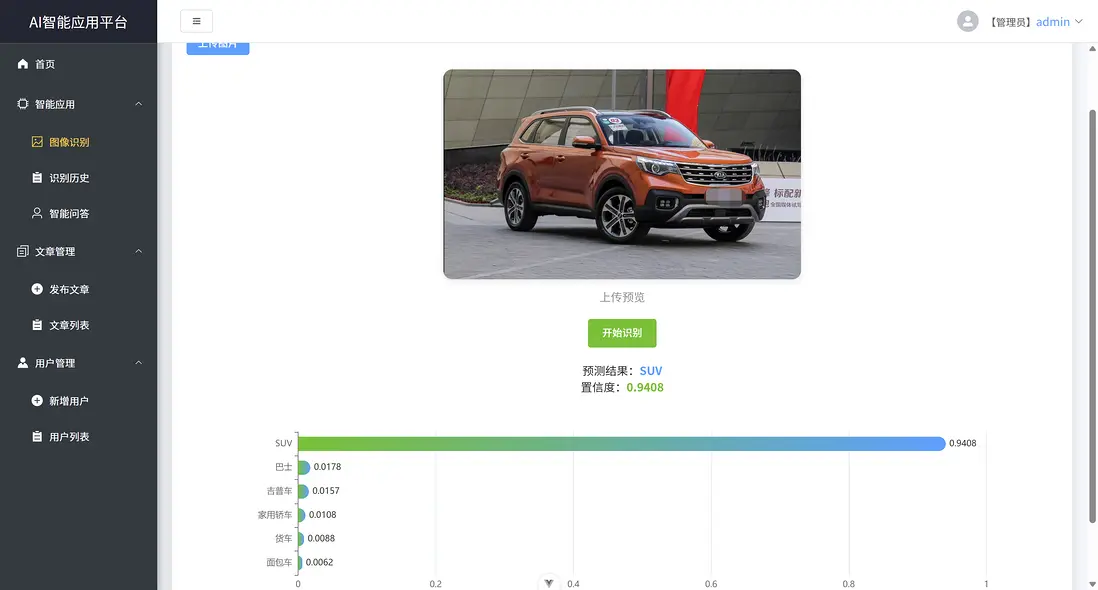

- 在圖像識別功能中,用户上傳圖片後,點擊識別,可輸出其識別結果和置信度

- 基於Echart以柱狀圖形式輸出所有種類對應的置信度分佈圖。

- 在智能問答功能模塊中:用户輸入問題,後台通過對接Deepseek接口實現智能問答功能。

- 管理員可在用户管理模塊中,對用户賬户進行管理和編輯。

選題背景與意義:

隨着人工智能與計算機視覺技術的快速發展,車輛識別在智能交通、安防監控、智慧社區及商業分析等領域展現出日益廣泛的應用需求。然而,傳統識別方法在複雜場景下的精度和泛化能力有限,同時,缺乏與業務系統整合的一體化解決方案,使得算法難以實際落地應用。

為此,本選題旨在構建一個融合車型識別與多功能管理的智能平台,通過引入基於TensorFlow的卷積神經網絡模型,實現對六類常見車型的高精度識別,並結合前後端分離的Web系統設計,集成內容管理、可視化分析與智能問答等功能。該系統不僅致力於提升車型識別的準確性與實用性,更着眼於打造一個易用、可擴展、支持多角色協作的應用平台,為相關領域提供一套具備參考價值的技術實現方案。

二、系統效果圖片展示

三、演示視頻 and 完整代碼 and 安裝

地址:https://ziwupy.cn/p/YQk8XJ

四、卷積神經網絡算法介紹

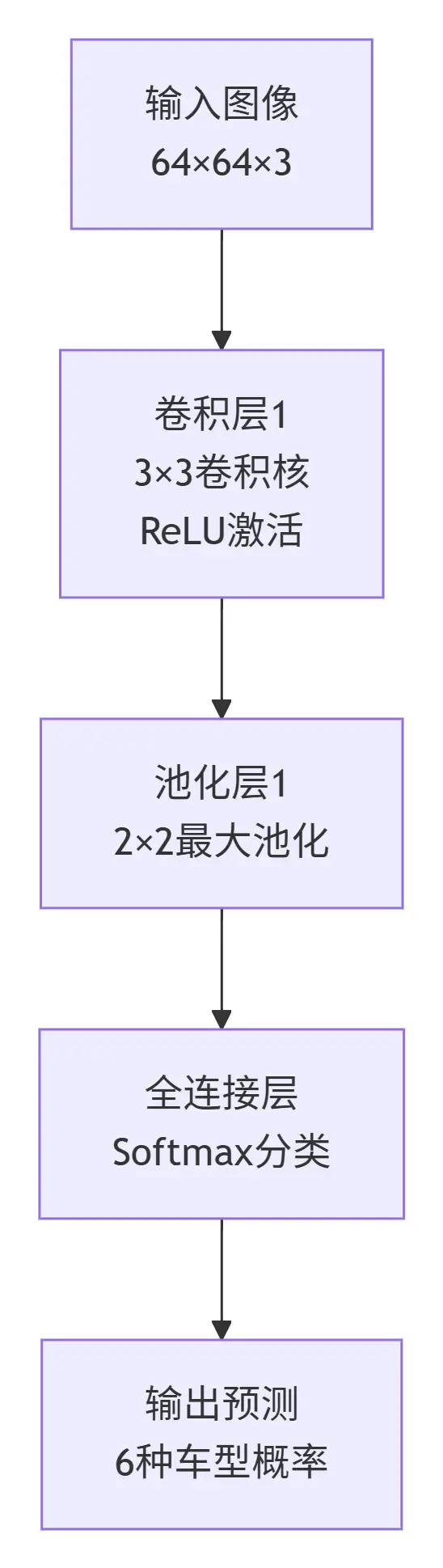

卷積神經網絡(CNN)是一種專為處理網格狀數據(如圖像)設計的深度學習模型。其核心思想是通過卷積層自動提取圖像的局部特徵,池化層降低特徵維度並增強平移不變性,最終通過全連接層進行分類決策。CNN的層級結構使其能夠從低級邊緣特徵到高級語義特徵進行層次化學習,在圖像識別領域表現出色。

import tensorflow as tf

from tensorflow.keras import layers, models

# 構建CNN模型

model = models.Sequential([

# 卷積層1

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)),

layers.MaxPooling2D((2, 2)),

# 卷積層2

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

# 全連接層

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(6, activation='softmax') # 6類車型分類

])

# 編譯模型

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# 模型訓練(示例)

# model.fit(train_images, train_labels, epochs=10, validation_split=0.2)以上代碼構建了一個包含兩個卷積層的CNN模型,輸入為64×64像素的RGB圖像,輸出為6類車型的概率分佈。卷積層負責提取圖像特徵,池化層壓縮特徵圖尺寸,全連接層完成最終分類。在實際車型識別系統中,需要準備標註好的訓練數據集,通過多次迭代訓練優化模型參數,最終得到能夠準確識別不同車型的深度學習模型。

該CNN模型首先通過卷積層提取圖像局部特徵,經池化層降維保留關鍵信息,最後由全連接層完成分類決策,輸出六類車型的識別概率分佈。這種層級結構使網絡能夠從低級特徵逐步學習到高級語義表示,實現高效的圖像識別功能。