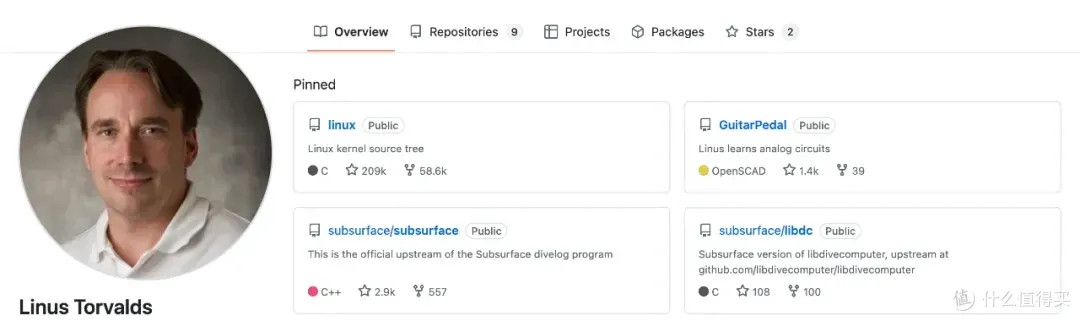

容器為什麼能隔離進程?Kubernetes 怎麼限制 Pod 資源?eBPF 監控的原理是什麼? 這些問題的答案,都指向同一個開源項目——Linux Kernel。它是 Linus Torvalds 在 1991 年創建的操作系統內核,如今已成為雲計算基礎設施的技術基石。

什麼是 Linux Kernel

Linux Kernel 是 Linux 操作系統的核心組件,負責管理硬件資源、調度進程、分配內存、處理網絡數據包。所有運行在 Linux 系統上的應用程序,都需要通過內核才能使用 CPU、內存、磁盤、網卡等硬件資源。

對於運維工程師來説,理解內核工作原理意味着:

- 排查故障時能直達問題根源

- 性能調優時知道瓶頸在哪

- 容器化部署時明白底層機制

五大核心子系統

1. 進程調度器

採用 CFS(完全公平調度器)算法,決定哪個進程獲得 CPU 時間、運行多久。這是容器 CPU 配額管理的底層實現。

實際應用:通過 nice 命令調整數據庫進程優先級,保證核心業務響應速度。Kubernetes 的 CPU Limit 最終也是由調度器執行。

2. 內存管理

提供虛擬內存機制,讓每個進程擁有獨立的地址空間,互不干擾。當內存不足時,OOM Killer 會選擇終止部分進程釋放資源。

運維要點:

- 監控

/proc/meminfo查看內存使用情況 - 調整

vm.swappiness參數控制 Swap 使用 - 配合 Kubernetes Memory QoS 避免容器 OOM

雲棧社區在實踐中發現,合理配置內存參數能顯著降低容器被驅逐的概率。

3. 網絡協議棧

從應用層的 Socket 到網絡設備驅動的完整實現,支持 TCP/IP、UDP、Netfilter(iptables 和 nftables)、eBPF 等技術。

DevOps 場景:

- 使用

tc命令進行流量整形 - 部署 Cilium 實現基於 eBPF 的容器網絡

- 調優

net.core.somaxconn支持高併發連接

# 高併發服務器網絡優化

net.core.somaxconn = 65535

net.ipv4.tcp_max_syn_backlog = 8192

net.ipv4.tcp_tw_reuse = 1

4. 虛擬文件系統

提供統一的文件操作接口,屏蔽底層文件系統差異(ext4、xfs、btrfs)。Docker 的存儲驅動 overlay2、devicemapper 都基於 VFS 實現。

關鍵指標:

- 用

df -i監控 inode 使用率 - 調整

fs.file-max支持大規模連接 - 選擇合適的容器存儲驅動

想深入瞭解存儲技術,可以訪問雲原生 / IaaS 學習路徑獲取系統化資料。

5. 設備驅動

提供硬件抽象層,支持 GPU(NVIDIA、AMD)、RDMA 網絡、NVMe 存儲等高性能設備的統一管理。

三個典型運維場景

場景一:內核參數調優

# /etc/sysctl.conf 配置示例

net.core.somaxconn = 65535

net.ipv4.tcp_max_syn_backlog = 8192

fs.file-max = 2097152

vm.swappiness = 10

vm.dirty_ratio = 15

這些參數直接影響 Web 服務器、數據庫、消息隊列的性能上限。執行 sysctl -p 使配置生效。

場景二:容器隔離機制

Docker 的底層實現就是 Namespace(隔離進程、網絡、文件系統)加 Cgroups(限制 CPU、內存、I/O)。

# 手動創建容器隔離環境

unshare --pid --net --mount --uts --ipc /bin/bash

# 使用 Cgroups 限制資源

cgcreate -g cpu,memory:myapp

cgset -r cpu.shares=512 myapp

cgset -r memory.limit_in_bytes=1G myapp

理解這些機制,才能深度排查容器網絡故障、資源爭搶問題。

場景三:eBPF 性能監控

通過內核的 eBPF 技術,可以零侵入監控生產環境的系統調用、網絡流量、安全事件。Falco、Cilium、Pixie 等工具都基於此實現。

# 使用 bpftrace 追蹤 TCP 連接

bpftrace -e 'kprobe:tcp_v4_connect {

printf("PID %d connecting\n", pid);

}'

性能分析工具

# CPU 調度延遲分析

perf sched latency

# 追蹤系統調用

strace -c -p <pid>

# 網絡連接統計

ss -s && nstat -az

# I/O 性能監控

iostat -x 1 && iotop -o

這些工具直接讀取內核暴露的性能指標,是故障排查的第一手資料。更多運維實戰技巧可以查看運維 / DevOps / SRE 學習路徑。

版本選擇建議

生產環境推薦使用 LTS(長期支持)版本:

- 6.6.x:最新 LTS,支持到 2026 年

- 6.1.x:穩定 LTS,支持到 2026 年

- 5.15.x:經典 LTS,支持到 2027 年

LTS 版本提供至少 2 年的安全補丁支持,API 接口穩定,經過社區充分驗證。對於追求極致性能的場景(如高頻交易、實時音視頻),可評估使用 Mainline 版本的新特性(如 io_uring、MPTCP)。

學習路徑

初級階段:

- 掌握

sysctl參數調優 - 使用

dmesg分析內核日誌 - 理解進程、內存、網絡基本概念

中級階段:

- 使用

perf、ftrace定位性能瓶頸 - 掌握 iptables 和 tc 流量控制

- 編寫簡單的內核模塊

高級階段:

- 編寫 eBPF 程序實現自定義監控

- 使用 kgdb 和 crash 調試內核

- 參與上游社區貢獻代碼

雲棧社區( https://yunpan.plus )整理了完整的計算機基礎學習資料,涵蓋操作系統、網絡、編譯原理等核心知識。

為什麼運維必須懂內核

雲原生時代,容器、微服務、Service Mesh 層出不窮,但它們都運行在 Linux Kernel 之上。當你理解了進程調度、內存管理、網絡協議棧的工作原理,就能:

- 快速定位故障:知道問題出在應用層還是內核層

- 精準性能調優:找到真正的瓶頸而不是盲目調參

- 深度理解容器:明白 Docker 和 Kubernetes 的底層機制

- 掌握新技術:eBPF、io_uring 等新特性的原理和應用

掌握內核,就是掌握雲原生基礎設施的底層邏輯。

關注《雲棧運維雲原生》,獲取更多運維、SRE、DevOps 技術乾貨!

📌 項目地址:github.com/torvalds/linux

📖 官方文檔:kernel.org/doc

🛠️ 性能工具:github.com/iovisor/bcc

📖 Linux內核開發課:https://yunpan.plus/t/574

標籤: #LinuxKernel #Github #雲原生 #DevOps #容器技術 #eBPF #運維

作者:https://yunpan.plus/t/1349-1-1 版權所有