大模型API調用會用,但不理解背後原理?微調訓練無從下手?本文從底層架構到工程實踐,拆解完整技術路徑。

大模型技術體系全景:從原理到工程實踐

隨着ChatGPT引發的AI浪潮,大模型技術已成為開發者必備技能。但從API調用到深入理解架構原理,再到企業級應用落地,中間存在明顯的知識斷層。本文整理了一套完整的學習資源,幫助開發者系統掌握大模型技術棧。

技術棧覆蓋範圍

基礎理論層

內容涵蓋必要的數學基礎,包括微積分中的導數與梯度概念、線性代數的矩陣運算、概率論基礎以及優化算法原理。這些是理解神經網絡反向傳播和模型訓練的前置知識。深度學習部分從神經網絡基本結構講起,包括邏輯迴歸、支持向量機等經典算法,以及自然語言處理的基礎概念。

核心架構層

重點解析Transformer架構的各個組件:自注意力機制的計算流程、位置編碼的設計思路、Add&Norm層的作用、Decoder的掩碼機制等。在此基礎上延伸到BERT的雙向編碼器架構、GPT系列的自迴歸生成模式,以及LLaMA模型的優化改進點。通過對比不同架構的設計理念,理解模型演進邏輯。

工程實踐層

以GLM4為例,演示完整的模型訓練流程:數據預處理、模型初始化、訓練循環設計、損失函數選擇等。微調部分介紹LoRA、P-Tuning等參數高效方法,推理優化涉及量化技術、推理加速策略。私有化部署講解模型服務化、接口封裝、負載均衡等工程問題。

應用開發層

LangChain框架的核心概念包括Chain的組裝邏輯、Memory的狀態管理、Agent的工具調用機制。RAG(檢索增強生成)系統構建涉及向量數據庫選型、Embedding模型對比、檢索策略優化。Prompt工程部分總結結構化提示詞設計方法、Few-shot學習技巧、思維鏈(CoT)應用場景。

工具與環境

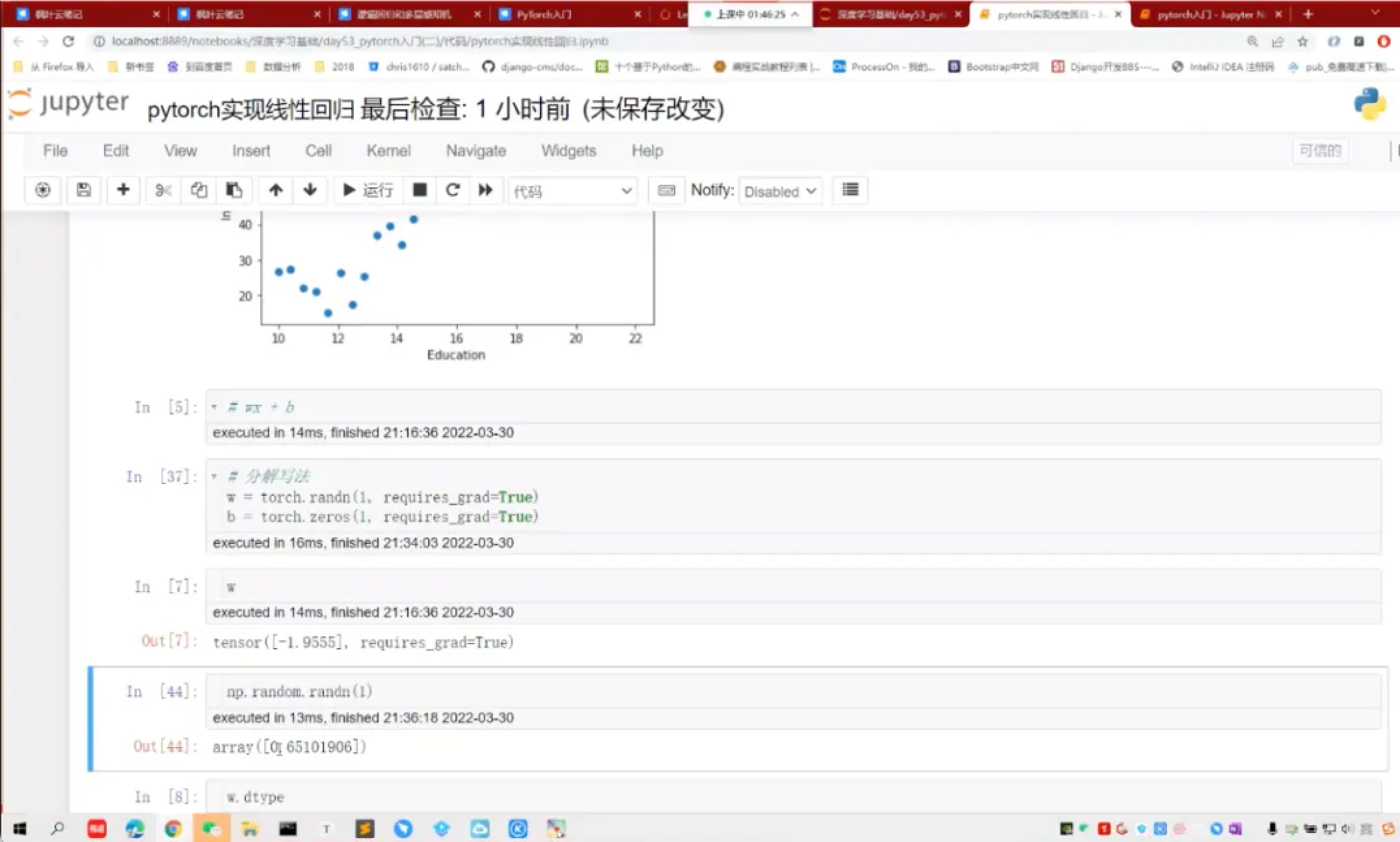

PyTorch框架的張量操作、自動微分機制、模型保存加載。HuggingFace生態的Transformers庫使用、Datasets數據集處理、Tokenizers分詞工具。雲端環境配置包括GPU資源申請、Docker容器化部署、分佈式訓練配置。

實戰項目案例

書籍翻譯系統

利用大模型的多語言能力,構建自動化翻譯流程。涉及文本分塊策略、上下文保持方法、術語一致性處理、翻譯質量評估等技術細節。

智能客服機器人

結合RAG技術,從企業知識庫檢索相關信息並生成回覆。包括意圖識別、多輪對話管理、答案生成與驗證、人工介入機制設計。

其他應用方向

圖像生成部分介紹DALL-E的文本到圖像原理、Copilot的代碼生成邏輯。Agent開發展示如何讓模型調用外部工具、執行復雜任務流程。

學習路徑建議

對於有一定編程基礎的開發者,建議按以下順序學習:

快速過一遍數學基礎,重點理解梯度下降和矩陣運算

深入學習Transformer架構,這是理解所有現代大模型的關鍵

動手實踐模型微調,從小規模數據集開始

學習LangChain等框架,快速構建應用原型

研究Prompt工程,提升模型輸出質量

嘗試完整項目,積累工程經驗

對於AI研究方向的學習者,可以更關注模型架構創新、訓練算法優化、評估方法設計等理論層面的內容。

技術要點總結

Transformer機制:自注意力通過Query、Key、Value三個矩陣計算token間關係,多頭注意力從不同子空間捕獲特徵,位置編碼注入序列順序信息。

模型對比:BERT適合理解類任務(分類、抽取),GPT擅長生成類任務(續寫、對話),LLaMA在參數效率和推理速度上做了優化,GLM融合了自編碼和自迴歸優勢。

微調策略:全量微調成本高但效果好,LoRA通過低秩矩陣減少參數量,Adapter插入可訓練模塊,Prefix-Tuning只優化前綴向量。

RAG系統:通過向量檢索增強模型知識,解決幻覺問題和知識更新難題。關鍵在於Embedding質量、檢索算法選擇、上下文融合策略。

這套資源適合希望系統學習大模型技術的開發者,從理論基礎到工程實踐都有詳細覆蓋。配套的代碼和項目文件可以直接用於學習和二次開發。

下載

資源獲取方式

資源包含視頻教程、配套代碼、課件文檔和項目示例文件。

AI大模型工程師從入門到精通:https://yunpan.plus/t/28

內容

模塊一:數學基礎與深度學習預備知識

在深入大模型之前,需要理解支撐神經網絡的數學原理。導數和梯度是反向傳播算法的核心,決定了參數更新的方向和幅度。線性代數中的矩陣運算貫穿整個模型計算過程,從輸入的Embedding到多層網絡的前向傳播,本質都是矩陣乘法和變換。概率論幫助我們理解模型輸出的分佈特性,以及為什麼交叉熵可以作為分類任務的損失函數。優化算法部分涵蓋從SGD到Adam的演進邏輯,解釋動量、自適應學習率等機制如何加速收斂。

深度學習基礎從最簡單的神經元模型開始,逐步構建多層感知機。邏輯迴歸雖然簡單,但其Sigmoid激活函數和二分類思想在現代模型中仍有應用。支持向量機的間隔最大化思想,對理解模型泛化能力有啓發。自然語言處理基礎介紹詞向量、序列建模等概念,為後續Transformer學習鋪墊。

模塊二:Transformer架構深度解析

Transformer是理解所有現代大模型的關鍵。自注意力機制通過Q、K、V三個矩陣的交互,讓模型能夠捕捉序列中任意兩個位置之間的依賴關係,突破了RNN的長距離依賴瓶頸。具體計算過程中,Query和Key的點積得到注意力分數,經過Softmax歸一化後與Value加權求和,這個過程可以並行化處理整個序列。

多頭注意力將表示空間分割成多個子空間,每個頭關注不同的語義關係。有的頭可能學習語法結構,有的捕捉語義相似性,有的識別長距離依賴。位置編碼使用正弦餘弦函數為每個位置生成唯一的向量,注入到輸入中讓模型感知詞序。Add&Norm層通過殘差連接緩解梯度消失,Layer Normalization穩定訓練過程。

Decoder部分引入掩碼機制,確保生成時只能看到當前位置之前的token,保持自迴歸特性。交叉注意力層讓Decoder關注Encoder的輸出,實現序列到序列的信息傳遞。輸出層通過線性變換和Softmax將隱藏狀態映射到詞表概率分佈。

BERT採用雙向Encoder結構,通過掩碼語言模型(MLM)和下一句預測(NSP)進行預訓練,適合需要理解上下文的任務如文本分類、命名實體識別。GPT系列使用單向Decoder,只能看到左側上文,通過自迴歸方式預測下一個詞,擅長文本生成。LLaMA在架構上做了多項優化:使用RMSNorm替代LayerNorm減少計算量,採用SwiGLU激活函數提升表達能力,應用RoPE位置編碼增強外推性。

模塊三:主流大模型訓練與微調實踐

以GLM4為例演示完整的模型訓練流程。數據預處理階段需要清洗文本、構建詞表、進行分詞和數值化。訓練循環中,每個batch經過前向傳播計算損失,反向傳播更新參數。損失函數通常使用交叉熵,衡量預測分佈與真實分佈的差異。學習率調度採用warmup+cosine decay策略,前期緩慢升温避免梯度爆炸,後期逐漸衰減精細調整。

微調是將預訓練模型適配到特定任務的關鍵技術。全量微調更新所有參數,效果最好但成本高昂。LoRA(Low-Rank Adaptation)通過在權重矩陣旁邊添加低秩分解矩陣,只訓練這些小矩陣,大幅減少可訓練參數量。Adapter方法在Transformer層之間插入小型瓶頸網絡,凍結原始參數只訓練Adapter。P-Tuning和Prefix-Tuning在輸入端添加可學習的虛擬token,通過優化這些前綴向量引導模型行為。

推理優化涉及多個層面。量化技術將FP32權重壓縮到INT8甚至INT4,顯著降低顯存佔用和計算量。KV Cache緩存注意力計算中的Key和Value,避免重複計算。Flash Attention優化注意力的內存訪問模式,減少GPU內存帶寬瓶頸。批處理推理通過合併多個請求提升吞吐量。

私有化部署需要考慮模型服務化、接口設計、負載均衡等工程問題。常用方案包括使用vLLM、TGI等推理框架,通過FastAPI或gRPC暴露服務接口,使用Nginx做反向代理和負載均衡,配置監控告警系統跟蹤服務狀態。

模塊四:LangChain框架與RAG系統構建

LangChain將大模型應用開發抽象為可組合的模塊。Chain是最基本的概念,將多個步驟串聯成工作流。LLMChain封裝模型調用和Prompt模板,SequentialChain按順序執行多個子鏈,RouterChain根據輸入動態選擇執行路徑。LCEL(LangChain Expression Language)提供聲明式語法,用管道符連接組件,代碼更簡潔可讀。

Memory組件管理對話歷史和上下文狀態。ConversationBufferMemory保存完整對話記錄,ConversationSummaryMemory通過模型總結壓縮歷史,VectorStoreMemory將記憶存儲到向量數據庫支持語義檢索。

Agent賦予模型使用工具的能力。通過ReAct(Reasoning+Acting)模式,模型先推理需要什麼信息,然後決定調用哪個工具,根據工具返回結果繼續推理或給出最終答案。工具可以是搜索引擎、計算器、數據庫查詢、API調用等。

RAG(Retrieval-Augmented Generation)通過檢索增強生成,解決大模型的知識侷限和幻覺問題。核心流程包括:

文檔處理:將知識庫文檔分塊,保持語義完整性

向量化:使用Embedding模型將文本塊轉為向量

索引存儲:存入向量數據庫(如Faiss、Milvus、Chroma)

檢索:將用户問題向量化,檢索最相關的文檔塊

生成:將檢索結果作為上下文,與問題一起輸入模型生成答案

關鍵技術點包括:Embedding模型選擇(BGE、E5、OpenAI等)影響檢索質量;分塊策略(固定長度、句子邊界、語義分割)影響上下文完整性;檢索算法(向量相似度、混合檢索、重排序)影響相關性;上下文融合(拼接、壓縮、篩選)影響生成效果。

模塊五:Prompt工程與輸出控制

Prompt工程是提升模型輸出質量的關鍵技能。結構化提示詞通常包含四要素:角色定位、任務描述、輸入內容、輸出要求。角色扮演通過"你是一個資深XX專家"設定模型人格,影響回答風格和專業度。任務描述明確説明要做什麼,避免歧義。輸入內容提供必要的上下文信息。輸出要求規定格式、長度、風格等約束。

Few-shot學習通過提供示例引導模型理解任務。Zero-shot直接描述任務,One-shot給一個例子,Few-shot給多個例子。示例的質量和多樣性直接影響效果。思維鏈(Chain-of-Thought)提示讓模型展示推理過程,在數學、邏輯等需要多步推理的任務中顯著提升準確率。

輸出格式控制讓模型生成結構化數據。Markdown格式適合生成文檔,可以包含標題、列表、表格、代碼塊。JSON格式便於程序解析,需要在Prompt中給出Schema示例。PlantUML和Mermaid可以生成UML圖和流程圖,模型輸出DSL代碼後通過渲染工具可視化。

指令符號的靈活運用包括:使用三引號包裹輸入內容避免混淆,用編號列表明確多個要求,用分隔符區分不同部分,用變量佔位符實現模板化。

模塊六:多模態應用與代碼生成

DALL-E等文本到圖像模型基於擴散模型(Diffusion Model)原理。訓練時逐步向圖像添加噪聲,學習去噪過程。生成時從隨機噪聲開始,根據文本條件逐步去噪得到圖像。CLIP模型提供文本和圖像的聯合表示空間,引導生成過程對齊文本描述。

Copilot等代碼生成工具基於Code-LLM,在大量代碼庫上預訓練。通過上下文理解當前代碼意圖,預測下一行或補全函數。支持多種編程語言,能夠理解註釋、函數簽名、變量命名等信息。實際使用中,清晰的註釋和函數名能顯著提升生成質量。

模塊七:工具鏈與開發環境

PyTorch是主流的深度學習框架。張量(Tensor)是核心數據結構,支持GPU加速計算。自動微分機制通過計算圖自動計算梯度,簡化反向傳播實現。模型定義使用nn.Module類,前向傳播在forward方法中實現。優化器(Optimizer)封裝參數更新邏輯,損失函數(Loss)衡量預測誤差。

HuggingFace生態提供豐富的預訓練模型和工具。Transformers庫統一了各種模型的接口,通過from_pretrained加載模型和分詞器。Datasets庫提供標準化的數據集加載和處理接口。Tokenizers庫實現高效的分詞算法,支持BPE、WordPiece等方法。Accelerate庫簡化分佈式訓練配置。

雲端環境配置涉及GPU資源申請、CUDA環境安裝、依賴管理等。Docker容器化部署保證環境一致性,避免依賴衝突。分佈式訓練使用數據並行或模型並行策略,突破單卡顯存限制。混合精度訓練使用FP16加速計算,配合梯度縮放避免數值下溢。

模塊八:綜合項目實戰案例

書籍翻譯系統的技術挑戰在於保持上下文連貫性和術語一致性。文本分塊需要在句子或段落邊界切分,避免截斷語義。翻譯時將前文摘要作為上下文輸入,保持代詞指代和情節連貫。術語表通過Few-shot示例或RAG檢索確保專有名詞翻譯統一。質量評估可以使用BLEU、COMET等指標,或者通過回譯(翻譯後再翻譯回原語言)檢測信息損失。

智能客服機器人結合RAG技術從知識庫檢索答案。意圖識別判斷用户問題類型(諮詢、投訴、查詢等),路由到不同處理流程。多輪對話管理維護對話狀態,處理指代消解和話題切換。答案生成時,先檢索相關文檔,然後讓模型基於檢索內容生成回覆,避免幻覺。答案驗證通過規則或分類器判斷回覆質量,低置信度時轉人工。人工介入機制設定觸發條件(如連續無法回答、用户明確要求),平滑切換到人工客服。

其他應用方向包括:文檔問答系統、代碼審查助手、數據分析Agent、內容創作工具等。每個場景都有特定的技術要點和優化策略,需要根據實際需求調整模型選擇、Prompt設計、系統架構等。

技術棧總結

整個學習路徑覆蓋了從數學基礎到工程應用的完整技術棧。核心是理解Transformer架構和注意力機制,這是所有現代大模型的基礎。掌握微調和推理優化技術,能夠將預訓練模型適配到實際場景。熟悉LangChain等應用框架,加速原型開發和系統集成。精通Prompt工程,最大化發揮模型能力。配合完整的工具鏈和開發環境,具備從零到一構建大模型應用的能力。