導語

分佈式集羣限流是保障雲服務高可用性的核心技術手段,其意義不僅在於防止系統過載,更是構建彈性架構、優化資源效率、實現業務可持續性的關鍵策略。未來,隨着邊緣計算和 Serverless 的普及,限流技術將進一步與底層基礎設施深度融合,成為構建下一代高可用架構的核心基石。

騰訊雲 TDMQ RabbitMQ Serverless 版作為一款極致彈性、高性能且高可靠的消息中間件,通過提供穩定低延遲的消息服務,助力企業實現系統異步解耦並高效應對海量消息堆積。然而,在高併發、大流量的實際業務中,如何科學分配資源、規避系統過載風險,已成為保障服務穩定性的關鍵。為此,騰訊雲 TDMQ RabbitMQ Serverless 版引入了集羣級別的分佈式限流機制,通過動態調控集羣的發送與消費速率,確保集羣在高負載下仍能穩定運行。

本文將深度剖析騰訊雲 TDMQ RabbitMQ Serverless 版的限流機制,涵蓋限流策略設計、觸發機制及底層實現邏輯。通過真實場景案例解析與實踐指南,系統講解如何通過客户端優化來降低限流影響,同時幫助客户精準掌握集羣限流相關服務端配置技巧,有效規避因流控策略不當引發的業務中斷風險,全面提升高併發場景下的系統穩定性與可靠性。

概要設計

分佈式限流的必要性

資源瓶頸的不可預測性

在分佈式系統中,單節點流量可能因負載均衡策略(如 Round-Robin)不均導致傾斜。例如,某台服務器因硬件故障觸發重試風暴,流量突增300%,若無全局視角的限流,可能引發級聯雪崩。

長尾延遲的放大效應

當某服務節點響應延遲升高(如磁盤刷寫延遲增大),後續請求堆積導致線程池耗盡,觸發上游重試,形成惡性循環。

突發流量衝擊

秒殺活動、熱點新聞等場景下,流量可能在毫秒級陡增數十倍。例如,某電商平台大促期間,訂單服務 QPS 從5k飆升至80k,若未通過分佈式限流攔截異常流量,核心計算資源將被瞬間打滿,導致服務不可用。

TDMQ RabbitMQ Serverless 版限流規則

騰訊雲 TDMQ RabbitMQ Serverless 版為超大規模、低時延、高可用性要求的在線業務提供專業級消息服務。客户端通過 RabbitMQ SDK 與 TDMQ RabbitMQ Serverless 版集羣建立長連接,實現高效的消息收發操作,同時動態佔用集羣的計算、存儲及網絡帶寬等關鍵資源。在此背景下,為確保消息服務的高性能與穩定性,在應對高併發、大流量場景時,必須對集羣的負載水位進行精細化管理。 基於集羣的資源配置上限,服務端支持動態調控客户端的每秒消息發送與消費能力(TPS),確保系統在高負載下依然保持穩定運行。

為實現資源隔離與靈活適配的雙重目標,系統對發送消息與消費消息的 TPS 配額進行獨立分配,並支持用户按需配置配額比例,從而實現精細化資源管理與業務場景的精準匹配(默認配額比例為1 : 1 也即50%)。業務可以根據實際的收發比例進行調整,可調整的收發消息比例範圍在20%-80%(服務端支持動態調整該區間)之間。

TDMQ RabbitMQ Serverless 版限流行為

騰訊雲 TDMQ RabbitMQ Serverless 版採用 Fail-Fast 限流機制,即當客户端請求速率觸及預設上限時,服務端會即時返回錯誤響應。在響應時間敏感的在線業務場景中,該機制可使客户端實時感知限流事件並主動介入處理,從而有效避免因資源競爭導致的端到端時延長尾,保障業務連續性與系統穩定性。

以 1000TPS 規格的基礎集羣為例(假設收發 TPS 比例為1:1 也即50%),客户端視角下的限流行為:

| 説明 | 發送消息限流 | 消費消息限流 |

|---|---|---|

| 觸發限流情景 | 所有連接該集羣的發送客户端每秒最多可發送 TPS 總和為 500 條,發送速率達到限制後,超限的發送請求會失敗。 | 所有連接該集羣的消費客户端每秒最多可消費 TPS 總和為 500 條,消費速率達到限制後,消息的消費延遲會增加。 |

| 觸發限流時 SDK 日誌關鍵詞 | com.rabbitmq.client.AlreadyClosedException: channel is already closed due to channel error; protocol method: #method<channel.close>(reply-code=530, reply-text=[requestId: 3143682333552716694] Action: pub rate limited by cluster on instance:xxx reason:PublishMessage, class-id=60, method-id=40) | 消費超過閾值以後,客户端使用 BasicGet 拉取消息時,會出現:com.rabbitmq.client.AlreadyClosedException: channel is already closed due to channel error; protocol method: #method<channel.close>(reply-code=530, reply-text=[requestId: 31436823332424324] Action: BasicGet rate limited by cluster rate limiter vhost: xxx. queue: xxx.當客户端使用 BasicConsume 消費消息時,服務端會抑制向客户端 DeliverMessage 的速率,客户端不會感知到明顯的 Channel 斷開的錯誤,整體表現為類似 AMQP 協議消費者 QOS 的行為,會抑制推送到消費者消息的速率,此時消費延遲會增加,可以通過調整限流比例或者增大購買的 TPS 來解決。消費的總 TPS 主要由 BasicGet 和 DeliverMessage 的調用 TPS 次數共享。 |

| 觸發限流時 SDK 重試機制 | 客户端 SDK 業務側需要處理連接斷開的行為,需要對發送錯誤被限流的消息重新建立 Channel 連接然後進行發送重試。 | 客户端 SDK 業務消費側會感知到延遲增加。若使用拉取 BasicGet 拉取消息,會感知到 Channel 連接斷開,需要業務上主動重試。 |

詳細設計與實現

架構設計

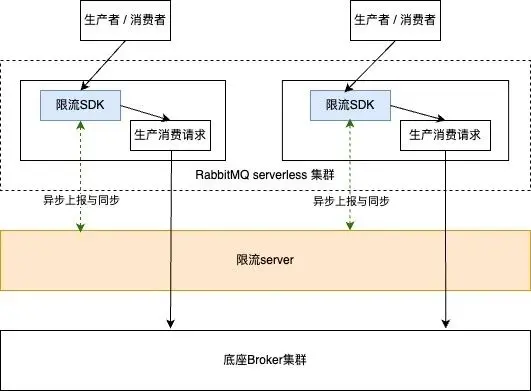

騰訊雲 TDMQ RabbitMQ Serverless 版採用雙模式限流架構,兼顧節點級保護與集羣級協同:

單機限流(Node-Level Throttling)

用於節點級資源保護,通過限制 CPU、內存、線程等關鍵資源的使用,防止單節點因過載導致服務不可用。

分佈式限流(Cluster-Level Throttling)

基於集羣全局視角,通過多節點流量協同管理,保護共享存儲資源(如 Broker)及後端系統穩定性。該模式通過使用分佈式限流系統實現。

限流實現

騰訊雲 TDMQ RabbitMQ Serverless 版通過在計算層 (TDMQ RabbitMQ Serverless 版集羣)接入分佈式限流系統實現集羣級讀寫流量控制,其核心機制是:TDMQ RabbitMQ Serverless 版集羣節點在處理 BasicPublish / BasicGet / DeliverMessage 請求前,需通過集成的限流 SDK 向限流 Server 異步上報與申請 Token。

生產端限流:若 BasicPublish 申請失敗,則立即拒絕生產消息請求並返回錯誤。

消費端限流:若 BasicGet 申請失敗,則立即拒絕拉取消息請求並返回錯誤。若 DeliverMessage 申請失敗,則抑制推送到消費者的消息速率,實現消費端不斷連接的流控,此時類似於 RabbitMQ 開源的實現,此時該消費者處於 Flow 狀態。

TDMQ RabbitMQ Serverless 版集羣內部集成限流 SDK,該 SDK 提供 Token 申請 API,並負責與限流 Server 通信,通過這種集中式 Token 管理實現對核心存儲層 (底座 Broker 集羣) 的保護。

限流實現難點一:如何平衡性能與精度

使用 TDMQ RabbitMQ Serverless 版的各類在線業務通常對時延比較敏感,如果計算層節點處理每次讀寫請求都執行一次 Limiter RPC 調用(SDK -> Server)的話,雖然 Limiter Server 內部處理耗時幾乎可以忽略,但兩次 RPC 的網絡 IO 耗時對消息端到端時延的影響是不能忽視的。

實際上從服務端的角度看, TDMQ RabbitMQ Serverless 版執行限流的主要目的是防止核心存儲層過載,而非追求 100% 精準的流量控制,即 SDK 與 Server 之間的強同步並不是必須的。因此,為了在限流性能和限流精度之間取得平衡,Limiter 採用了一種【先消費後結算】的 Token 管理機制,Token 申請過程在限流 SDK 內部閉環,SDK 會週期性(週期大概在50ms以內,上報週期越短,限流越敏感)地向限流 Server 異步上報 Token 使用量並同步配額。

騰訊雲 TDMQ RabbitMQ Serverless 版的限流機制通過以下四大核心特性,在保障系統穩定性的同時實現高性能與低時延的平衡:

- 內存級處理,主鏈路零干擾

執行機制:限流判斷為純內存操作,不涉及外部 RPC 調用,確保消息處理流程完全不受阻塞。

性能優勢:主鏈路延遲無感知,適用於對響應時間要求嚴苛的在線業務場景。

- 先消費後結算,消除誤限流風險

設計原理:採用異步 Token 核銷機制,客户端可先執行操作,限流 SDK 後續異步週期性同步配額消耗。

效果保障:杜絕因限流判斷延遲導致的正常請求被誤拒,確保業務連續性。

- 短暫超限容忍,資源緩衝池兜底

場景説明:在流量毛刺等突發場景中,可能出現瞬時配額超限,由於先消費後結算的機制導致。

容錯機制:通過服務端資源預留 Buffer 吸收流量波動,避免因短暫超限觸發系統風險。

- 彈性容錯設計,弱耦合架構保障可用性

故障降級策略:當限流 Server 服務異常時,系統自動切換至單機 Sentinel 組件實現基礎單機限流功能。

依賴特性:對限流 Server 服務實現弱耦合架構,可以通過隨時動態降級來避免限流 Server 服務異常導致的服務異常,確保分佈式限流服務的高可用。

限流實現難點二:如何平滑限流毛刺

騰訊雲 TDMQ RabbitMQ Serverless 版採用 TPS 作為集羣規格單位,用於衡量集羣的吞吐能力。例如,1000TPS 表示集羣每秒可處理 1000 條 TPS(即綜合生產、消費等操作的加權計算)。在分佈式限流系統中,這一規格對應每秒分配 1000 個 Token,其中 “一秒”即為默認的限流計數週期,用於動態控制流量配額。

在使用限流服務的實際運維中發現:

短週期(如1秒):

優勢:對流量波動敏感,可快速響應潛在過載風險;

缺陷:易因短暫毛刺誤觸限流,影響正常業務波動場景。

長週期(如10秒):

優勢:容忍毛刺,降低誤控率;

缺陷:服務端資源需承受更高瞬時衝擊風險。

為平衡流量控制精度與用户體驗,騰訊雲 TDMQ RabbitMQ Serverless 版將默認限流計數週期從1秒調整為10秒。這樣既降低了用户因毛刺導致的限流困擾,又通過利用少量的服務器預留資源 Buffer 來承載瞬時流量衝擊,為高併發場景下的消息處理提供了可靠的支撐。

限流實現難點三:如何實現消費端限流

騰訊雲 TDMQ RabbitMQ Serverless 版集羣使用 AMQP 協議與客户端交互,然而 AMQP 協議中並沒有定義很好的處理 Fail-Fast 限流錯誤的幀,因此在發送消息被限流的情況下,只能通過關閉 Channel 連接來通知到客户端,此時客户端會收到相應的 AlreadyClosedException 異常,然後業務需要通過重試來解決當前時間窗口內消息發送被限流的問題。

而在消費端限流的情況下,分為兩種情況,AMQP 協議中支持兩種消費模式,BasicGet(拉模式) 和 BasicConsume(推模式)。 此時對消費端的限流就需要考慮消費的連續性和延遲。針對 BasicGet 模式,是客户端發起的主動同步拉取消息的命令,此時客户端每一次拉取消息是可以直接感知到是否被限流的,更好的方式是通過關閉連接來讓客户端感知到限流,從而讓業務上通過重試來解決拉取當前時間窗口內消息消費被限流的問題。

但是針對 BasicConsume(推模式), 同時也是 AMQP 客户端最普遍的使用方式,考慮到客户端開啓一個長連接監聽相應隊列上的消息,此時如果因為限流粗暴地關閉 Channel 連接, 此時的客户端往往不能實時感知到連接 Channel 斷開,增加了客户端業務上處理的複雜度,同時消費側重建 Channel 連接也會讓消費流量充滿毛刺和消費延遲增加。因此騰訊雲 TDMQ RabbitMQ Serverless 版在推模式下使用消費抑制的方式來實現消費端限流,當消費 TPS 超過閾值時,會減少推送到客户端的頻率,保證了在連接 Channel 不斷開的情況下,消費流量的平穩,儘量減少因為限流導致的消費延遲。

客户端實踐教程

規劃集羣限流負載

騰訊雲 TDMQ RabbitMQ Serverless 版的限流機制旨在保障服務穩定性與可靠性。防止在集羣高負載時出現服務響應長尾毛刺,最終導致請求成功率下降,業務受損等問題。因此,在接入時建議:客户側需要提前規劃集羣負載,依據當前規模和未來趨勢預測來充分評估業務 TPS, 如果業務流量具有波動特性,應以峯值 TPS 為準,根據相應的評估後的 TPS 購買相應規格的實例集羣。

限流相關告警配置

騰訊雲 TDMQ RabbitMQ Serverless 版默認接入了騰訊雲監控的能力,可以利用騰訊雲 TDMQ RabbitMQ Serverless 版控制枱的監控告警能力實現對集羣負載的實時觀測,提前發現 TPS 水位風險並及時操作升配來避免觸發限流導致業務受損。告警策略建議:

- 發送和消費 TPS 水位超過容量的 70% 時觸發告警,提醒進行升配評估。

- 出現發送限流時觸發告警,警告業務發送消息可能失敗風險。

客户端限流異常處理

業務代碼通過 RabbitMQ SDK 發送消息時,需要捕獲包括限流錯誤在內的異常,並保存必要的上下文信息,以便人工介入恢復業務。當騰訊雲 TDMQ RabbitMQ Serverless 版實例的 TPS 流量峯值超過騰訊雲控制枱所購買實例的 TPS 規格上限時,業務側生產消費流量會被限流。

限流後的行為如下:

騰訊雲 TDMQ RabbitMQ Serverless 版服務端會返回錯誤碼信息。

騰訊雲 TDMQ RabbitMQ Serverless 版服務端關閉當前請求的 Channel 連接,代碼中可以捕獲異常並重新打開 Channel 連接,具體請參見錯誤碼處理示例代碼章節。

錯誤碼信息:

錯誤碼:reply-code=530

錯誤信息:reply-text=[requestId: 3143682333552716694] Action: pub rate limited by cluster on instance:xxx reason:PublishMessage, class-id=60, method-id=40)

錯誤堆棧:

Suppressed: com.rabbitmq.client.AlreadyClosedException: channel is already closed due to channel error; protocol method: #method<channel.close>(reply-code=530, reply-text=[requestId: 3143682333552716694] Action: pub rate limited by cluster on instance:amqp-autotest reason:PublishMessage, class-id=60, method-id=40)

at com.rabbitmq.client.impl.AMQChannel.processShutdownSignal(AMQChannel.java:437)

at com.rabbitmq.client.impl.ChannelN.startProcessShutdownSignal(ChannelN.java:295)

at com.rabbitmq.client.impl.ChannelN.close(ChannelN.java:624)

at com.rabbitmq.client.impl.ChannelN.close(ChannelN.java:557)

at com.rabbitmq.client.impl.ChannelN.close(ChannelN.java:550)

at com.rabbitmq.client.impl.recovery.AutorecoveringChannel.lambda$close$0(AutorecoveringChannel.java:74)

at com.rabbitmq.client.impl.recovery.AutorecoveringChannel.executeAndClean(AutorecoveringChannel.java:102)

at com.rabbitmq.client.impl.recovery.AutorecoveringChannel.close(AutorecoveringChannel.java:74)RabbitMQ AMQP Java SDK 業界使用的比較廣泛,因此使用該 SDK 作為示例,RabbitMQ AMQP Java SDK 不會對限流錯誤進行自動重試,因此業務代碼需要捕獲異常並進行處理,示例代碼如下:

private static final int MAX_RETRIES = 5; // 最大重試次數

private static final long WAIT_TIME_MS = 2000; // 每次重試的等待時間(以毫秒為單位)

private void doAnythingWithReopenChannels(Connection connection, Channel channel) {

try {

// ......

// 在當前通道channel下執行的任何操作

// 例如消息發送、消費等

// ......

} catch (AlreadyClosedException e) {

String message = e.getMessage();

if (isChannelClosed(message)) {

// 如果通道已經關閉,關閉並重新創建通道

channel = createChannelWithRetry(connection);

// 在重連後可以繼續執行其它操作

// ......

} else {

throw e;

}

}

}

private Channel createChannelWithRetry(Connection connection) {

for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

try {

return connection.createChannel();

} catch (Exception e) {

System.err.println("Failed to create channel. Attempt " + attempt + " of " + MAX_RETRIES);

// 檢查錯誤, 若仍是被限流導致的關閉錯誤,則可以等待後繼續重試

// 也可移除本部分重試邏輯

if (attempt < MAX_RETRIES) {

try {

Thread.sleep(WAIT_TIME_MS);

} catch (InterruptedException ie) {

Thread.currentThread().interrupt(); // 還原中斷狀態

}

} else {

throw new RuntimeException("Exceeded maximum retries to create channel", e);

}

}

}

throw new RuntimeException("This line should never be reached"); // 理論上不會到達這裏

}

private boolean isChannelClosed(String errorMsg) {

// 判斷是否包含channel.close報錯,該報錯代表通道已關閉。

// 可能涵蓋530,541等錯誤信息。

if (errorMsg != null && errorMsg.contains("channel.close")) {

System.out.println("[ChannelClosed] Error details: " + errorMsg);

return true;

}

return false;

}總結

騰訊雲 TDMQ RabbitMQ Serverless 版通過分佈式限流架構為在線業務提供高可用的消息服務保障。在分佈式限流模式下,服務端通過集中式 Token 管理系統(限流Limiter)動態分配資源配額,防止因突發流量衝擊導致核心存儲層(底座 Broker 集羣)過載來提高系統穩定性,同時採用 【先消費後結算】的異步處理模式,客户端在限流 SDK 內部閉環完成 Token 申請,避免阻塞主鏈路,確保限流調用接口低延時,限流 SDK 週期性同步 Token 消耗數據至限流 Server,最終平衡了限流精度與調用限流服務的性能開銷。同時針對消費端的限流可以實現不斷 Channel 連接,實現了消費端在限流毛刺與消費延遲之間的雙重保證,此外,面對限流 Server 服務不可用的情況,系統能夠自動動態降級為單機限流模式,確保客户端請求的連續性,保持對限流服務的弱依賴設計來實現系統解耦。

在實際應用與運維中,同時也需要客户業務方的配合,在接入騰訊雲 TDMQ RabbitMQ Serverless 版服務時,業務方客户需要根據業務規模和未來趨勢合理規劃集羣,預留足夠的 TPS 配額以應對突發流量,防患於未然。同時騰訊雲 TDMQ RabbitMQ Serverless 版提供了服務端完善的監控和告警,支持客户通過監控告警能力實時訂閲集羣負載,提前發現 TPS 水位風險並及時進行升配等操作。在客户端業務代碼層面,需要捕獲限流異常並處理,保證代碼的健壯性,同時保存必要的上下文信息,以便人工查看相關日誌最終介入來恢復業務。

通過本文對騰訊雲 TDMQ RabbitMQ Serverless 版的限流機制的介紹與實踐教程,相信讀者對騰訊雲 TDMQ RabbitMQ Serverless 版的限流機制有了更深入的理解,並能夠在實際項目中靈活應用,最終為業務的高併發、大流量場景提供穩定的支持。