引言:從“單次生成”走向“工程交付與長期運行”

大模型的對比,過去常停留在單輪迴答的流暢度與知識覆蓋面;而在真實工程裏,更關鍵的是兩件事:

- 複雜任務能不能一次交付:需求拆解、修改迭代、工具調用、依賴排錯、迴歸驗證,任何一個環節失手都會把成本指數級拉高。

- Agent 工作流能不能長時穩定:連續多步執行、長上下文保持、一致的輸出質量與可控的推理成本,決定了團隊能否把模型當“可用基礎設施”。

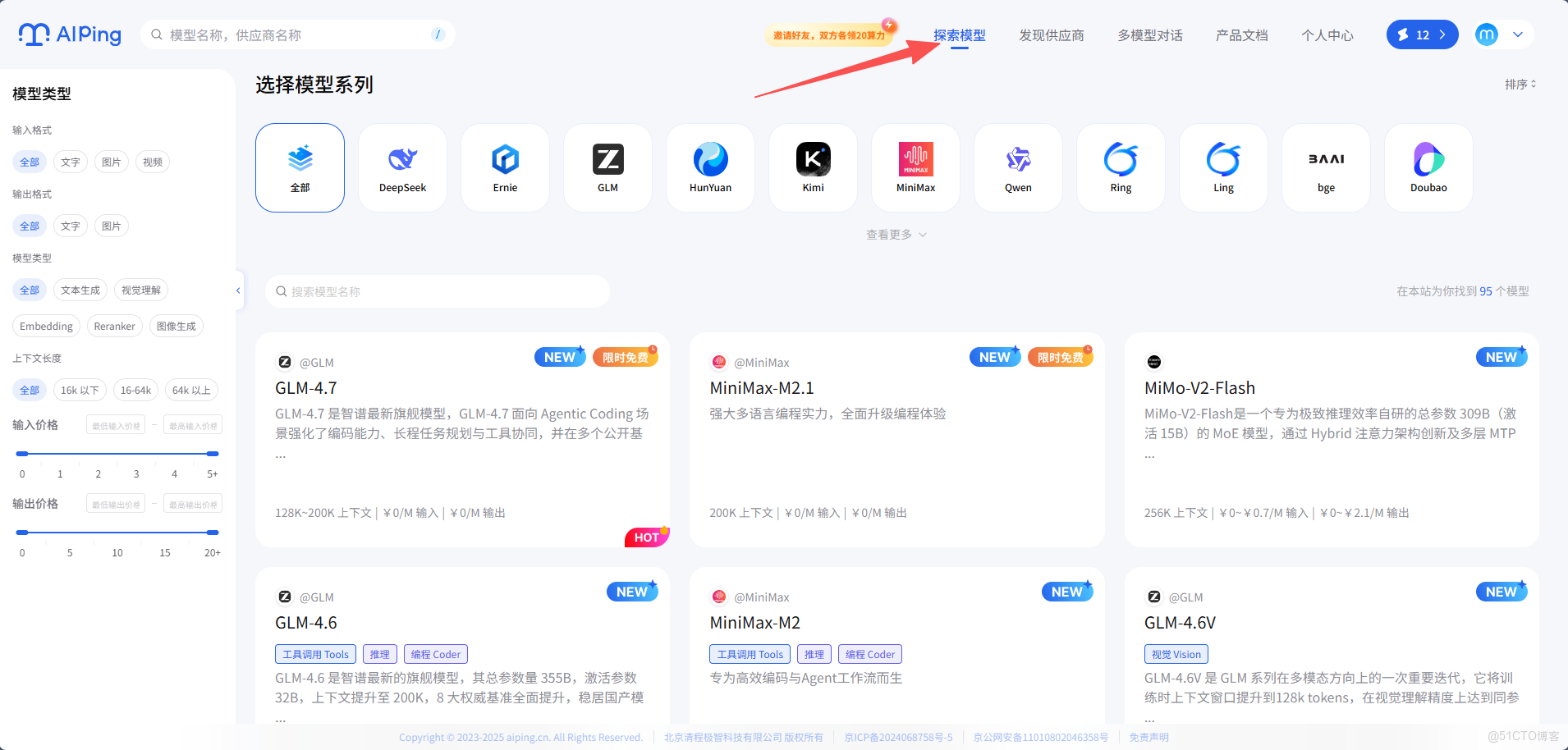

GLM-4.7 與 MiniMax M2.1 的同場上線,恰好代表兩條逐漸成熟的路線:一條強調可控推理與工具協同,面向複雜工程任務的一次性交付;另一條強調 MoE 架構帶來的吞吐效率與多語言工程優化,更適合持續運行的 Agent 流水線。 在 AI Ping裏,你可以用同一入口、同一套調用方式,把這兩類能力放到同一條真實鏈路裏驗證。 立即註冊登錄立享30元算力金

AI Ping 是什麼:把“對比、切換、穩定性”做成產品能力

AI Ping 的核心不是“再做一個聊天頁”,而是把大模型落地時最費工的事情產品化:

- 多供應商統一接入:平台已對接多家供應商,通過統一接口對外提供服務,避免你為每家廠商分別適配 SDK、鑑權與限流策略。

- 性能數據可視化:在平台看板裏可以對比吞吐、延遲、上下文長度、價格等指標,用數據做選型與路由決策。

- 智能路由:在高峯或波動時段,平台可基於實時指標自動選擇更優供應商並完成切換,減少“某家抖一下全鏈路雪崩”的風險。

這些能力的意義在於:你不需要在項目早期就押注單一供應商,也不必在模型升級、供應商波動時頻繁改代碼。對研發團隊來説,這相當於給“大模型依賴”加上了一層可觀測、可切換、可兜底的運行時。

兩款模型怎麼定位:工程交付 vs. 長時 Agent

GLM-4.7:面向複雜工程任務的一次性交付

GLM-4.7 的重點在於“把多步任務做完並做對”。在工程場景裏,往往體現在:

- 更注重任務拆解與步驟收斂:把需求拆成可執行子任務,減少中途跑偏。

- 更強調工具協同與可控推理:在需要查資料、讀文件、調用工具、逐步驗證的任務上更穩。

- 支持推理強度按需調節:在準確率與成本之間更靈活地做權衡(適合把“深思熟慮”留給關鍵步驟)。

MiniMax M2.1:高吞吐、長上下文,更適合連續執行

MiniMax M2.1 的方向更偏向“長期運行效率”,尤其適合連續編碼與長鏈 Agent 執行:

- 依託 MoE 架構帶來更好的吞吐與持續運行成本表現。

- 強化 Rust / Go / Java / C++ 等多語言工程能力,適合在真實生產代碼裏持續迭代。

- 結合長上下文優勢,更適合“需求—代碼—日誌—修復—迴歸”的循環鏈路。

如果把兩者放在同一個團隊裏:GLM-4.7 更像“關鍵節點的穩健交付者”,M2.1 更像“流水線上的高效執行者”。實際落地時,最合理的方式往往不是二選一,而是按任務類型做路由。

實測數據怎麼看:吞吐、延遲、上下文與可靠性

AI Ping 給出了平台實測的供應商表現。下面把核心數據整理成便於決策的表格(價格均為免費,可靠性為 100%):

GLM-4.7(不同供應商)

| 供應商 | 吞吐量 (tokens/s) | 延遲 P90 (s) | 上下文長度 |

|---|---|---|---|

| PPIO 派歐雲 | 50.47 | 3.64 | 200k |

| 智譜(官方) | 50.30 | 10.61 | 200k |

| 七牛雲 | 37.64 | 2.52 | 200k |

| 無問芯穹 | 22.94 | 3.93 | 128k |

MiniMax M2.1(不同供應商)

| 供應商 | 吞吐量 (tokens/s) | 延遲 P90 (s) | 上下文長度 |

|---|---|---|---|

| 七牛雲 | 99.75 | 0.54 | 200k |

| MiniMax(官方) | 89.56 | 0.72 | 200k |

這幾列指標如何解讀:

- 吞吐量(tokens/s):決定“單位時間能輸出多少”,對長輸出(生成代碼、生成報告、跑長鏈對話)更敏感。

- 延遲 P90:代表大多數請求的尾部體驗;對交互式產品、實時 Agent 更關鍵。

- 上下文長度:決定能否把更多歷史、代碼片段、日誌、需求放在同一輪請求裏,對“修 bug + 迴歸”尤其重要。

- 可靠性:如果長期運行,穩定性往往比峯值能力更重要;可靠性數據是做多供應商路由的基礎。

從表裏也能看到一個直觀結論:同一模型在不同供應商上的體驗差異很大。這也是統一接入與智能路由的價值所在——你可以把“選擇與切換”放在平台層,而不是每次都改業務代碼。

怎麼在 AI Ping 裏免費使用:面向產品與工程兩條路徑

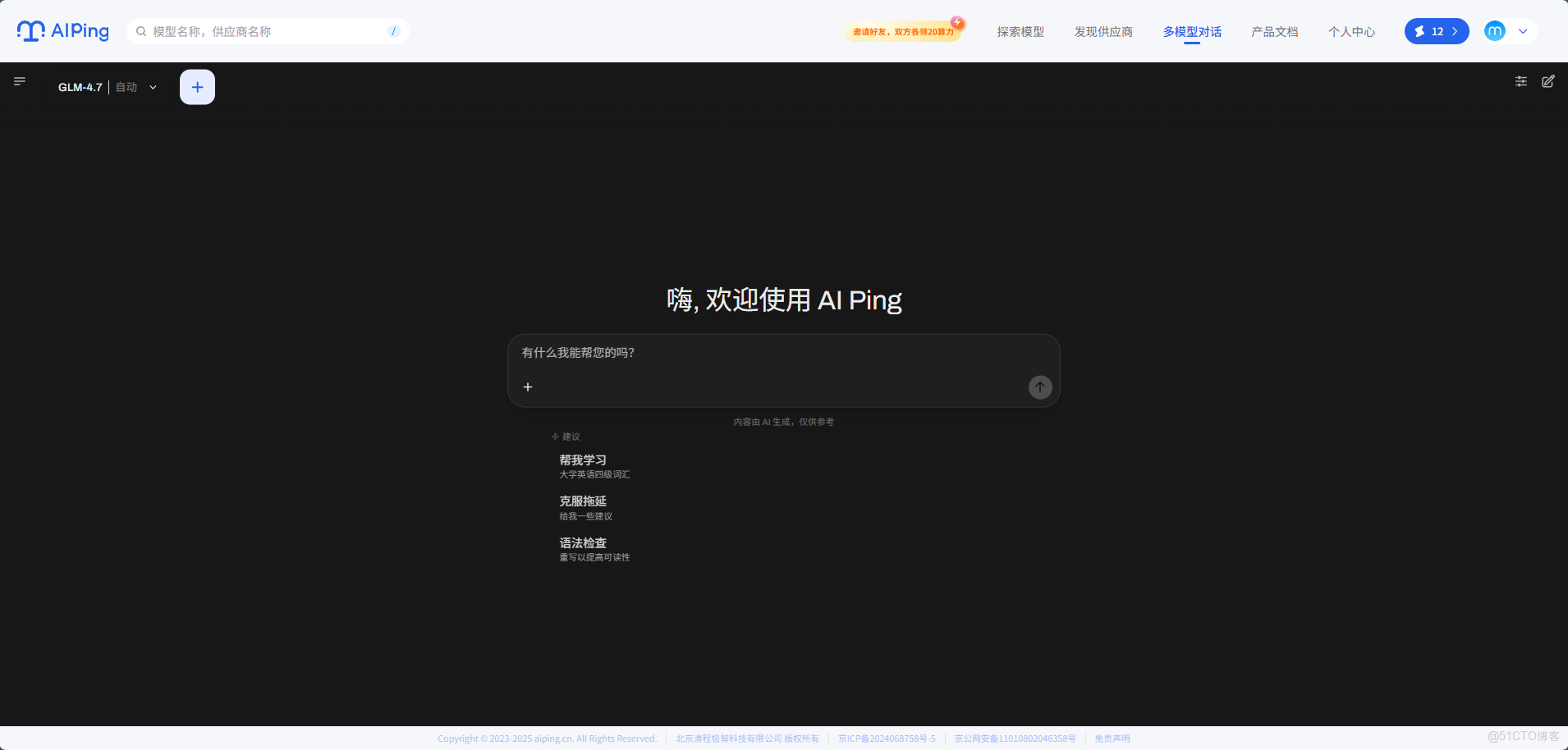

下面分兩部分介紹:先用網頁快速驗證,再用統一接口接入到你的工程裏。

路徑 A:網頁快速試用(適合評估與對比)

-

- 打開 AI Ping官網並登錄/註冊賬號。

-

在平台內找到模型體驗入口

-

選擇模型:

GLM-4.7MiniMax M2.1

用統一的對比腳本提問

- 工程交付:給出需求 + 約束 + 驗收標準,讓模型產出可執行計劃與關鍵代碼。

- 長時 Agent:連續追加變更、貼日誌、讓模型逐步定位並輸出可迴歸的修復方案。

在同一提示詞下切換供應商/模型,對比:

- 第一次給出方案是否可執行

- 迭代 3~5 輪後是否仍保持一致性

- 失敗時能否自我糾錯並收斂到可用結果

網頁試用的目標是儘快得到“能不能用、適合什麼任務”的答案,而不是追求一次性完美輸出。

路徑 B:程序化調用(適合接入業務/工作流)

AI Ping 的定位是“統一調用”,因此建議你把接入流程拆成三件事:拿到憑證、選擇模型與路由策略、把調用封裝進工程。

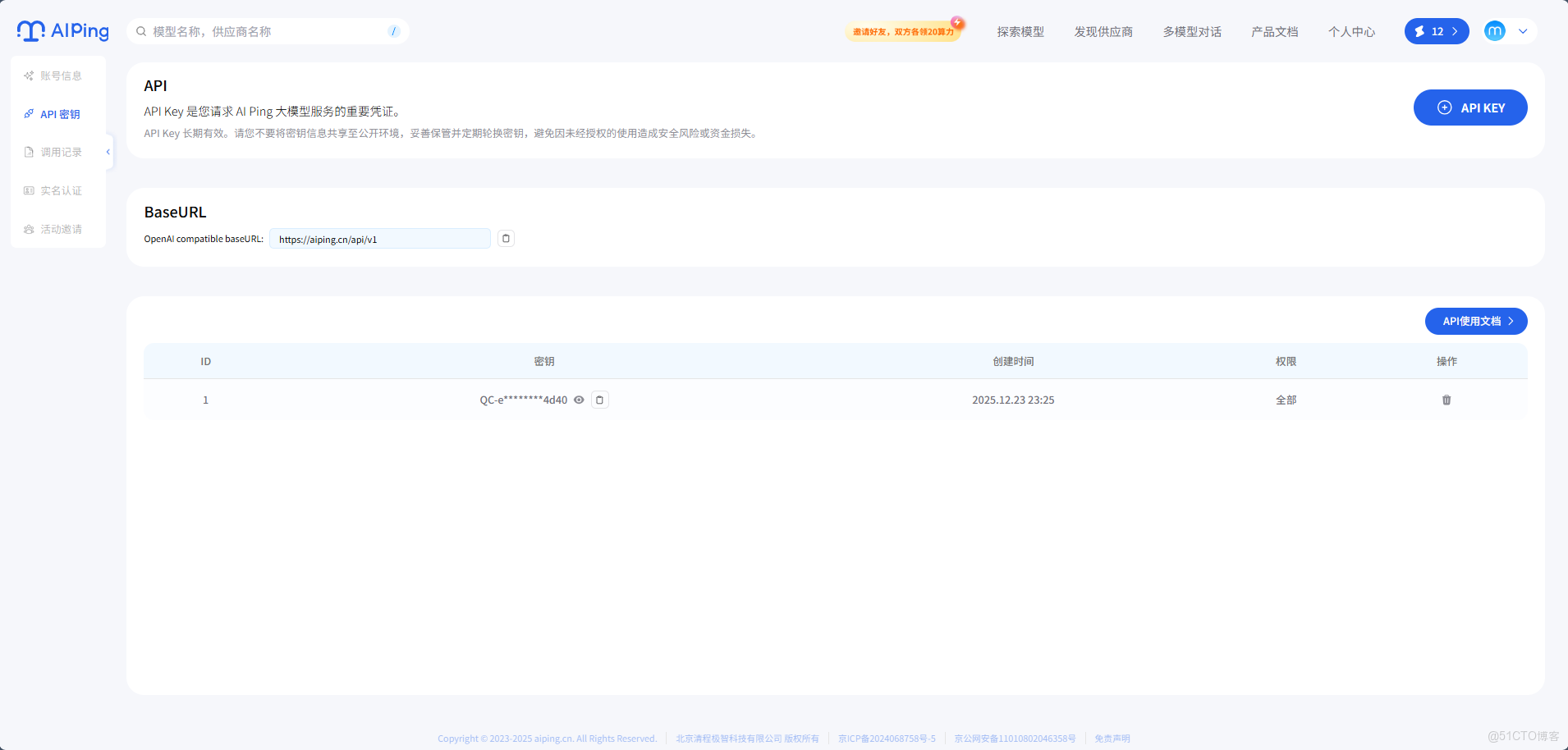

1)獲取調用憑證

-

登錄 AI Ping官網

-

打開控制枱裏的

API Key頁面 -

創建並獲取

API Key,妥善保存(通常僅在創建時可完整查看一次)。 -

在你的運行環境裏把 Key 放入安全的環境變量或密鑰系統(不要寫進代碼倉庫)。

2)選擇模型與供應商策略

你可以按“任務類型”來路由,而不是按“團隊偏好”:

- 複雜交付型任務(需要多步推理、工具協同、嚴格驗收)優先:

GLM-4.7 - 長鏈執行型任務(持續編碼、長對話、吞吐要求高)優先:

MiniMax M2.1

3)在工程中封裝統一調用

AI Ping 的調用方式對工程側很友好:整體形態與 OpenAI 兼容的 Chat Completions 類似,重點在於三類信息:

Authorization: Bearer <API_KEY>:鑑權方式- 請求地址:

https://aiping.cn/api/v1/chat/completions - 請求體:

model+messages(可選stream、temperature等)

下面給出兩個“可直接複製”的示例,分別對應 GLM-4.7 與 MiniMax M2.1(模型標識以控制枱展示為準)。

示例 1:Requests 調用 GLM-4.7(含流式輸出開關)

import requests

headers = {

"Authorization": "Bearer QC-e86e94dcded77f03b4ff995f197b4753-e05745deef245a9f3617180d30354d40",

"Content-Type": "application/json",

}

payload = {

"model": "GLM-4.7",

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"stream": True,

"extra_body": {

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

}

}

response = requests.post(

"https://aiping.cn/api/v1/chat/completions",

headers=headers,

json=payload,

stream=True

)

response.encoding = "utf-8"

try:

for line in response.iter_lines(decode_unicode=True):

if line:

print(line)

except KeyboardInterrupt:

print("流被手動中斷。")

示例 2:Curl 調用 MiniMax M2.1(適合腳本與 CI 裏做連通性測試)

curl -N -X POST https://aiping.cn/api/v1/chat/completions \

-H "Authorization: Bearer QC-e86e94dcded77f03b4ff995f197b4753-e05745deef245a9f3617180d30354d40" \

-H "Content-Type: application/json" \

-d '{

"model": "MiniMax-M2.1",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"provider": {

"only": [],

"order": [],

"sort": null,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

}

}'

如果你希望“固定供應商”或“交給平台自動路由”,通常會通過額外字段表達(不同頁面/版本可能叫 provider 或類似名稱)。在工程實踐裏更推薦:

- 日常默認交給平台自動路由,換取穩定性與運維成本更低。

- 對關鍵鏈路(如發佈前回歸)固定供應商,保證行為一致,便於排障與復現。

4)把“可觀測性”接進來

長時 Agent 最怕“偶發抖動導致全鏈路失敗”。建議在業務側至少記錄這些指標(不包含用户敏感內容):

- 請求耗時與重試次數

- 供應商選擇結果(固定 or 路由)

- 輸入/輸出 token 數(用於成本與吞吐評估)

- 失敗類型(超時、限流、內容不合規、上游錯誤等)

配合 AI Ping 的性能看板與智能路由,你能更快定位“是提示詞問題、模型能力問題,還是供應商時段性波動”。

總結:用同一入口驗證兩種成熟路線

GLM-4.7 與 MiniMax M2.1 的上線,給團隊提供了兩類更貼近工程現實的選擇:一個更擅長複雜任務的穩定交付,一個更擅長長時運行的效率與吞吐。而 AI Ping 的價值在於把“對比、切換、觀測、兜底”變成平台能力:你可以先用網頁快速評估,再用統一接口接入業務,把模型選型從“拍腦袋”變成“用數據跑通鏈路”。

當模型不再只是“寫得好看”,而是“跑得穩定、能交付、可持續”,團隊就能把更多精力放回產品本身——這才是 AI 真正進入工程體系後的正確打開方式。