你是否經歷過與 AI Coding 工具協作編程時,對話越來越長,回答卻開始變慢,甚至跑偏?在使用 AI Coding 工具過程中,是否覺得 tokens 消耗過快,越來越不經用?

Qoder 全新「上下文壓縮」功能正式上線,高效管理會話上下文,節省開發成本,同時保持高效協作!

什麼是上下文窗口?

上下文窗口(Context Window)可以理解成 AI 的“短期記憶”,它決定了模型在一次對話中能夠“記住”並處理的信息總量。就像人腦的短期記憶有限一樣,AI 會話的上下文窗口也有上限。當前 Qoder 選擇支持 200K 上下文長度。

為什麼需要管理?

隨着會話的不斷進行,這段“短期記憶”會越來越長,每次模型請求都需要處理窗口內的內容,才能準確理解你的意圖。這會導致:

- Credits 消耗增加:每次請求處理的 Token 數量增多,則 Credits 消耗更多。

想象一下:在同一個會話中,當對話長達數十輪後,你可能只是想讓 AI 修正一個變量名,但發給模型的卻是全部歷史對話(包含大量已解決的問題和無關代碼)。

有效的上下文管理,可以通過總結會話,減少發送給模型的 Token 量,直接降低成本,讓 Credits 消耗得更慢些。 - 響應變慢:除了成本,上下文過載還會拖慢 AI 的響應速度。

就像讓電腦處理一個巨大的文件,即便只是想在其中查找一個詞,也需要更長的加載和分析時間。通過主動管理上下文,相當於為 AI 減輕了數據處理的負擔,能提升其響應速度,讓你重獲流暢、即時的協作體驗。 - 潛在干擾:當上下文中混雜大量無關的歷史信息時,AI 可能被舊信息誤導,影響判斷準確性。

例如,當你從調試一箇舊模塊轉向開發一個新功能時,AI 可能會混淆不同階段的方案,甚至被舊代碼的邏輯所誤導,從而給出不準確的建議。

Qoder 新能力上線

上下文壓縮

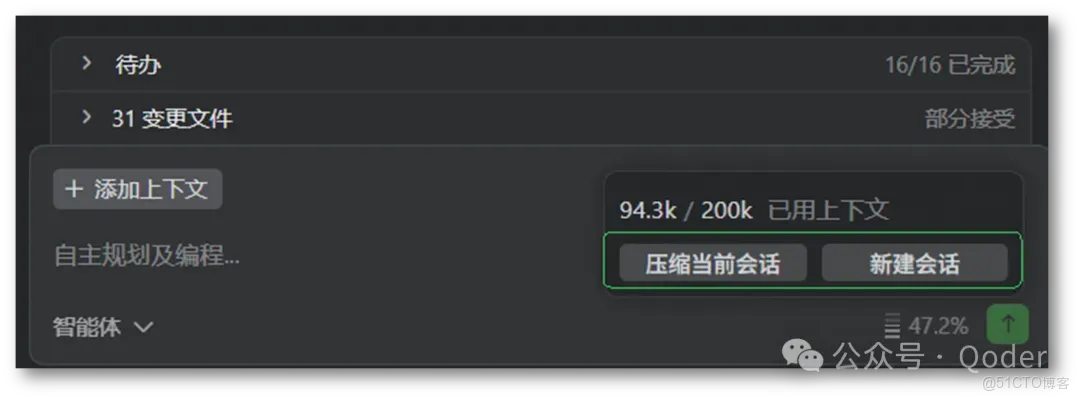

為了解決這些問題,讓 AI 更節能、更高效地為你工作, Qoder 全新能力上線,讓你可實時查看當前會話的上下文用量,並引導你在不同場景下適時採取相應措施。

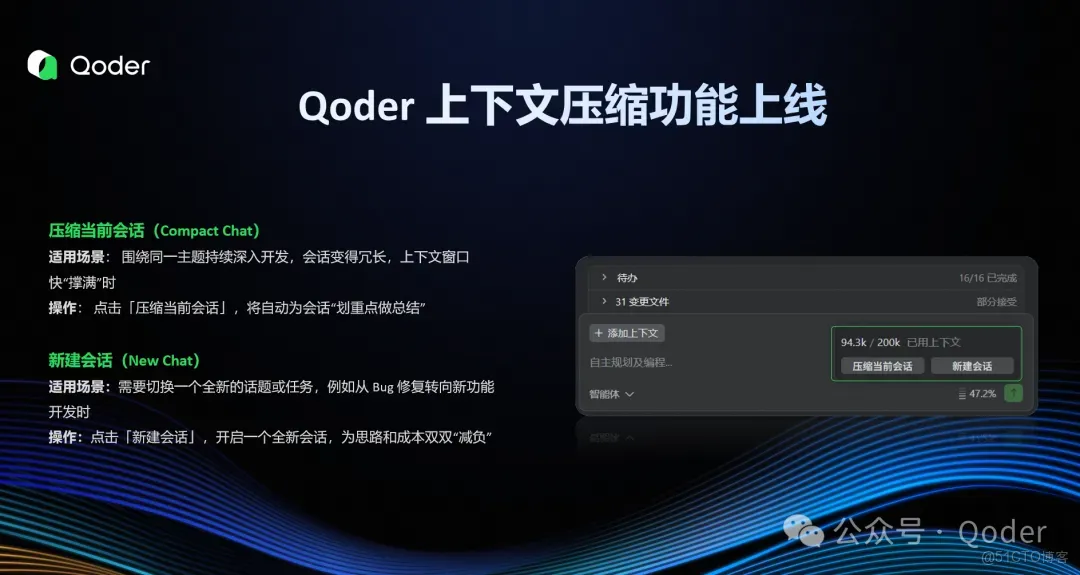

壓縮當前會話(Compact Chat)

◾ 適用場景:圍繞同一主題持續深入開發,會話變得冗長,上下文窗口快“撐滿”時。

◾ 操作:點擊「壓縮當前會話」,將自動為會話“劃重點做總結”:

- 智能總結:保留關鍵代碼邏輯等信息,剔除冗餘內容,同時保留核心脈絡。

- 效果立現:有效降低 Credits 消耗,同時提升 AI 響應速度。

新建會話(New Chat)

◾ 適用場景:需要切換一個全新的話題或任務,例如從 Bug 修復轉向新功能開發時。

◾ 操作:點擊「新建會話」,即可開啓一個全新會話,為思路和成本雙雙“減負”。

- 更準:擺脱無關歷史上下文干擾,讓 AI 響應更精準。

- 更省:避免因無關上下文導致的 Credits 浪費。

實戰指南:變身上下文管理大師

理論結合實踐,才能發揮最大威力。記住這幾條法則,輕鬆駕馭上下文管理。

法則一:留意上下文用量,合理管理

在 Qoder 對話框右下角,可實時查看當前會話的上下文用量(例如:115.3k / 200k)。建議當用量超過總量 40% 時,考慮進行上下文壓縮。

尤其發現 AI 回答偏離主題、響應變慢時,有可能是上下文過載所致。此時若仍需深入當前話題,執行一次壓縮將有效節省 Credits 並提升響應效率。

法則二:新話題,新會話

開啓全新的開發任務時,請果斷創建新會話。這不僅能避免歷史上下文干擾,提升 AI 理解與響應的準確性,還能有效減少上下文,節省 Credits,讓新對話更高效、更經濟。

歡迎更新到 Qoder 0.2.1 版本體驗!

官網地址:下載體驗鏈接:https://qoder.com

關注我,掌握Qoder最新動態