介紹

今天,我們正式宣佈:AutoMQ BYOC(Bring Your Own Cloud)正式上線 Connector 託管能力。

AutoMQ 作為基於 S3 構建的新一代 Diskless Kafka,已經在存儲層實現了計算存儲分離與 Zero Cross-AZ(零跨可用區)複製,大幅降低了雲上 Kafka 的 TCO。隨着 Connector 託管能力的引入,我們進一步降低了數據集成場景的准入門檻:在 AWS 等公有云上,你現在可以在一個統一的控制面中,以極簡的方式構建從數據採集(Connect)到流存儲(AutoMQ)的數據管道。通過產品層面的深度集成,我們把構建生產級 CDC 鏈路的複雜度從“專家級”降低到了“入門級”。

挑戰:CDC 鏈路中的“流量刺客”與配置壁壘

在雲原生架構中,Kafka Connect 是連接數據庫與 Kafka 的關鍵橋樑。特別是在高吞吐的 CDC(Change Data Capture)場景下,用户往往面臨着兩個核心挑戰,導致成本與運維壓力居高不下:

難以規避的跨 AZ 流量“隱形税”

AutoMQ 通過基於 S3 的共享存儲架構,可以在服務端層面完全消除客户端寫入 AutoMQ 時的跨 AZ 流量費用。但要真正做到“端到端 Zero Cross-AZ”,通常還要求**客户端(例如 Kafka Connect Connector)**具備一定的可用區感知能力或遵循特定的路由策略。現實情況是,在傳統自建 Connector 模式下,Worker 節點往往用默認配置直接啓動,對服務端的網絡拓撲一無所知。結果就是:即便 AutoMQ 側已經為本地寫入做好了架構準備,這些“矇眼狂奔”的 Connector 仍可能把 TB 級別的 CDC 流量寫到其他 AZ 的 Broker,產生大量跨 AZ 傳輸(Regional Data Transfer)費用,把 Diskless 架構在存儲層帶來的優勢抵消掉。

自管理 Connector 成本高昂

在傳統模式下,要把 Connector 調到既穩定又省錢,本質上是一整套高門檻的“自助運維套餐”:

- 配置上的精細活:你得啃完一堆文檔,手動配置 Rack Awareness,按 AZ 劃分 Bootstrap 地址,權衡要不要開壓縮、到底用哪種壓縮算法;

- 集羣和基礎設施運維:還要自己拉起並維護 Connect 集羣,在 K8s 裏部署、配置 VPC/安全組、接好監控告警,預估並處理擴縮容和升級帶來的各種影響;

- 隱藏成本和不可見風險:即便前面所有步驟都做對了,細節上也很容易翻車——只要有一個 client 參數漏配或配錯,就可能讓本應利用 AutoMQ 架構優勢實現的 Zero Cross‑AZ 能力徹底失效,跨 AZ 流量又悄悄回到老路子上,直到月底賬單出來才發現被多收了一大筆錢。

正是因為自管 Connector 充滿這種看不見、摸不着但真金白銀買單的複雜度,很多團隊才開始認真評估:是不是應該把這部分徹底交給一個 Fully Managed 的平台來做。

深度集成:把複雜留給平台,把簡單留給用户

AutoMQ 託管 Connector 的核心價值,在於利用統一控制面(Unified Control Plane)的上下文優勢,實現了 Connector 與 AutoMQ 集羣的深度綁定與自動化適配。

我們通過產品設計,將“如何正確連接 AutoMQ”這一複雜問題,在平台側通過自動化手段解決:

上下文感知的配置注入

在 AutoMQ 控制枱中,託管 Connector 天然知道它所連接的 AutoMQ 集羣的一切信息(接入點、認證方式、版本特性等)。 當用户創建 Connector 時,系統會自動生成並注入適配 AutoMQ 最佳實踐的 Client Configuration。無論是基礎的連接參數,還是適配 AutoMQ Zero Cross-AZ 特性所需的特殊配置,平台都會在後台自動完成。 這意味着,用户不需要理解底層的參數細節,Connector 啓動即處於“最佳狀態”。

統一網絡環境的無縫連接

託管 Connector 部署在與 AutoMQ 集羣相同的 VPC 環境中。平台自動處理了網絡連通性配置(Connectivity),用户無需在複雜的 VPC Peering、Secuity Group 規則中周旋。只要在同一個環境,就能天然連通,安全且高效。

一站式全生命週期管理

我們將 Connector 的創建、配置、監控和日誌查詢全部收斂到了 AutoMQ 控制枱。這不僅僅是 UI 的整合,更是運維流的打通。用户可以在一個頁面閉環解決所有問題,大幅降低了構建和維護 CDC 鏈路的隱形成本。

產品體驗:四步向導,一屏掌控

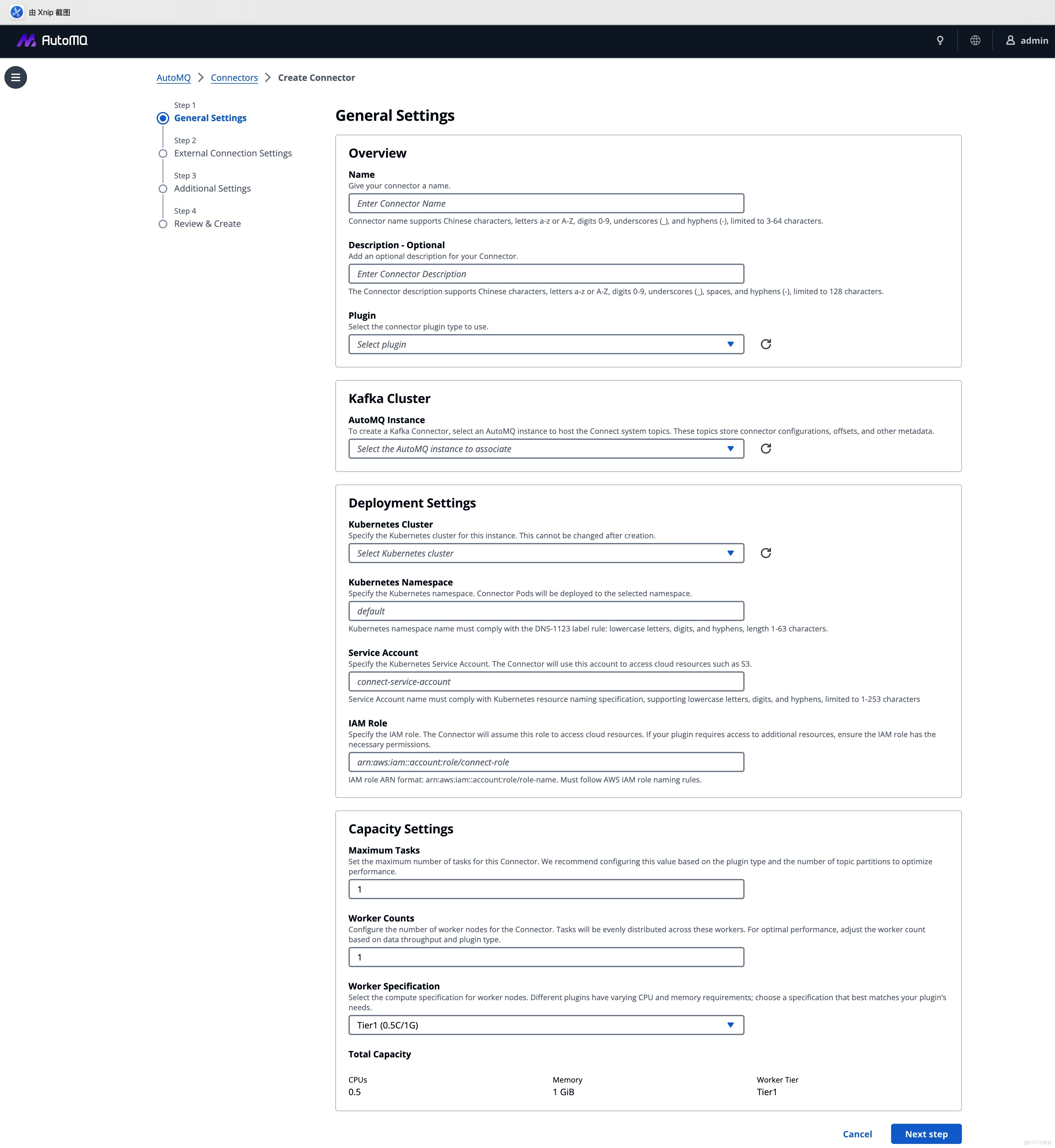

我們將複雜的集成邏輯封裝為標準化的四步向導,讓 CDC 鏈路的搭建迴歸業務本質。

1. 通用設置:自動化的環境適配

這是集成的起點。用户只需選擇目標 AutoMQ 實例和 Kubernetes 集羣,系統會自動鎖定正確的網絡上下文和 IAM 角色。“選擇即適配”,複雜的連接參數配置在後台自動完成。

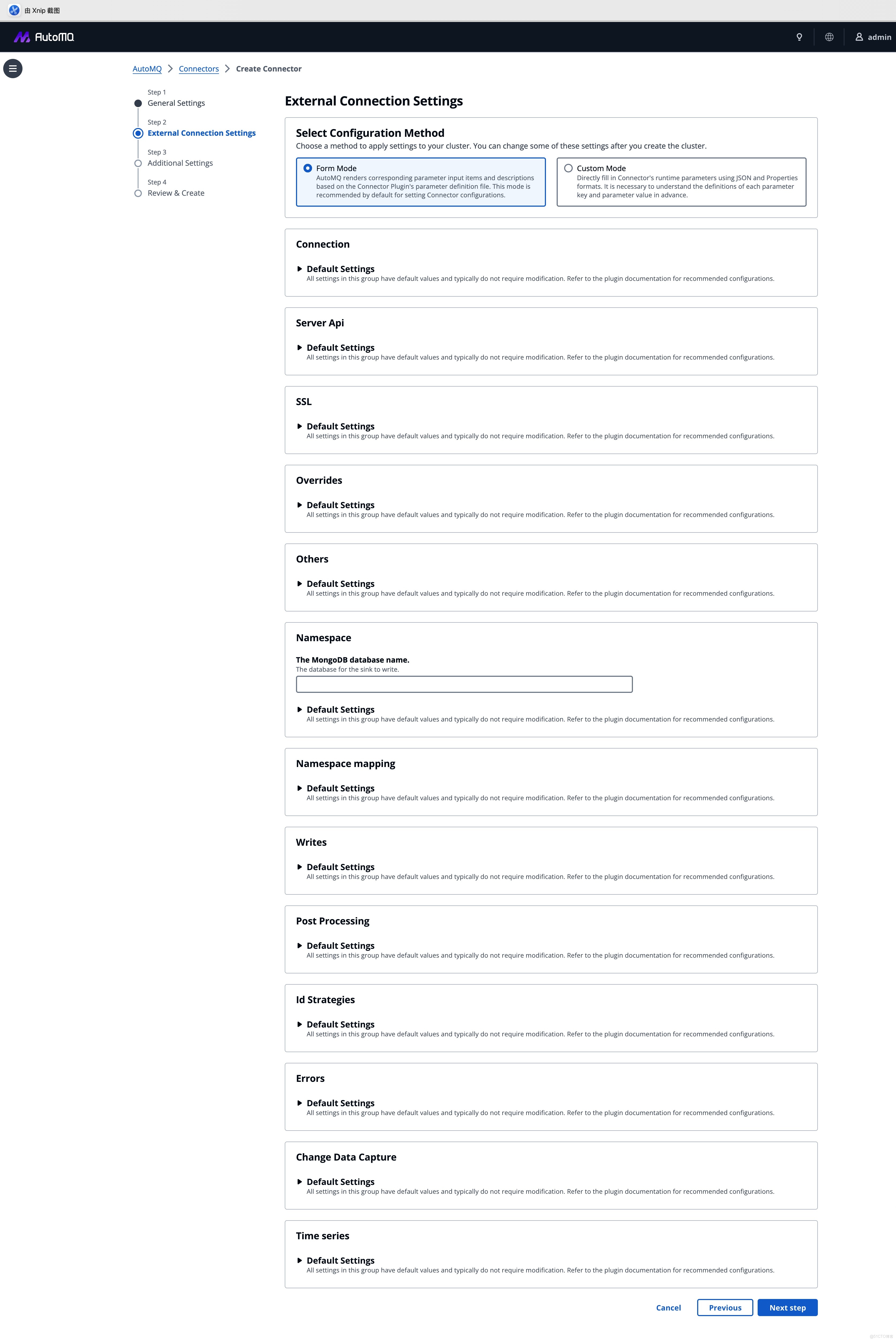

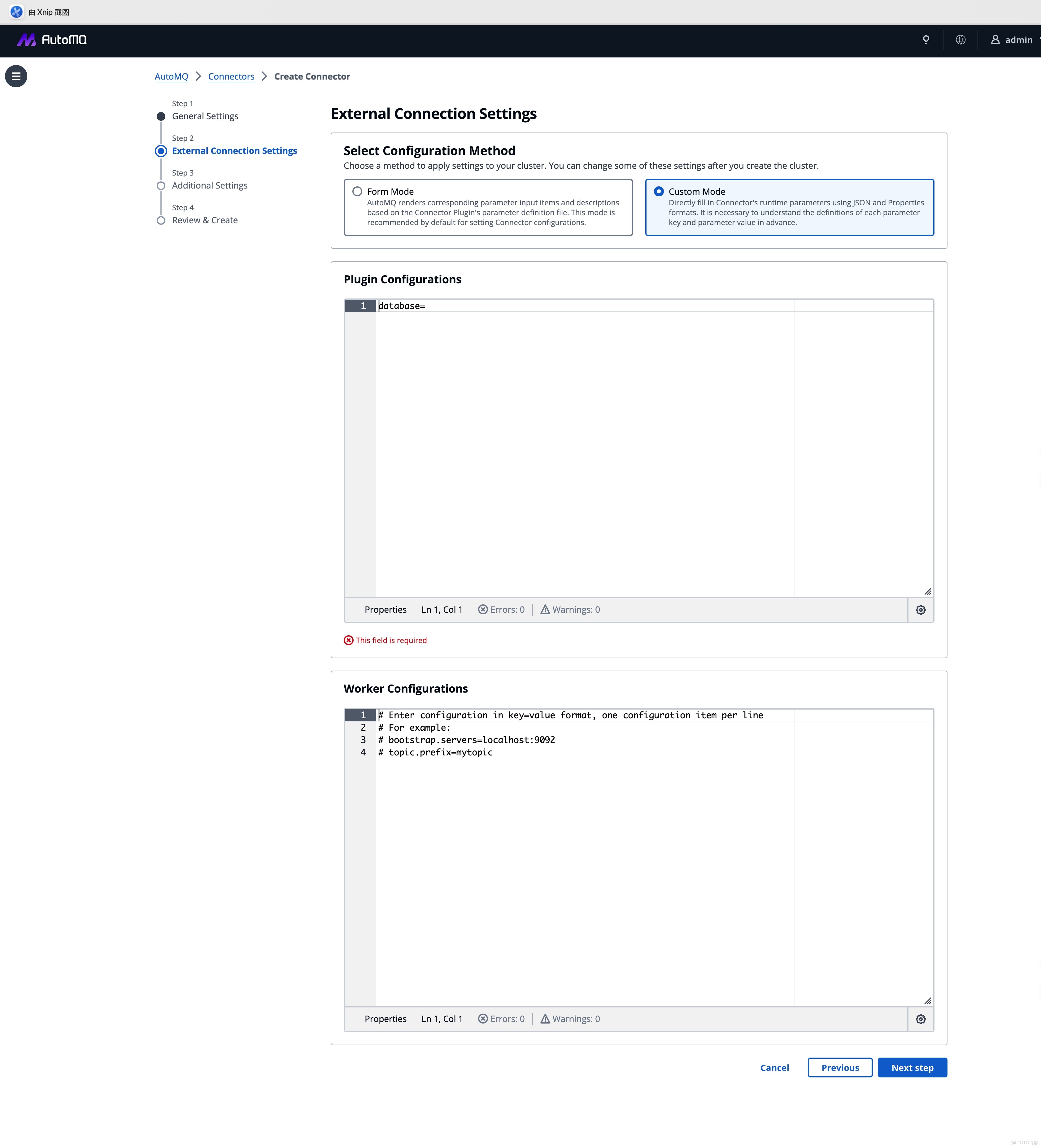

2. 連接配置:兼容性與易用性的平衡

支持標準的 Kafka Connect 插件生態,並系統內置了 Debezium 等 CDC 插件,針對不同的用户習慣,我們提供了靈活的配置模式:

- 表單模式:針對 S3 Sink 等標準化插件,參數可視化,減少配置錯誤。

- 自定義模式:針對 Debezium 等複雜場景,支持直接粘貼 JSON/Properties,確保存量業務的平滑遷移。

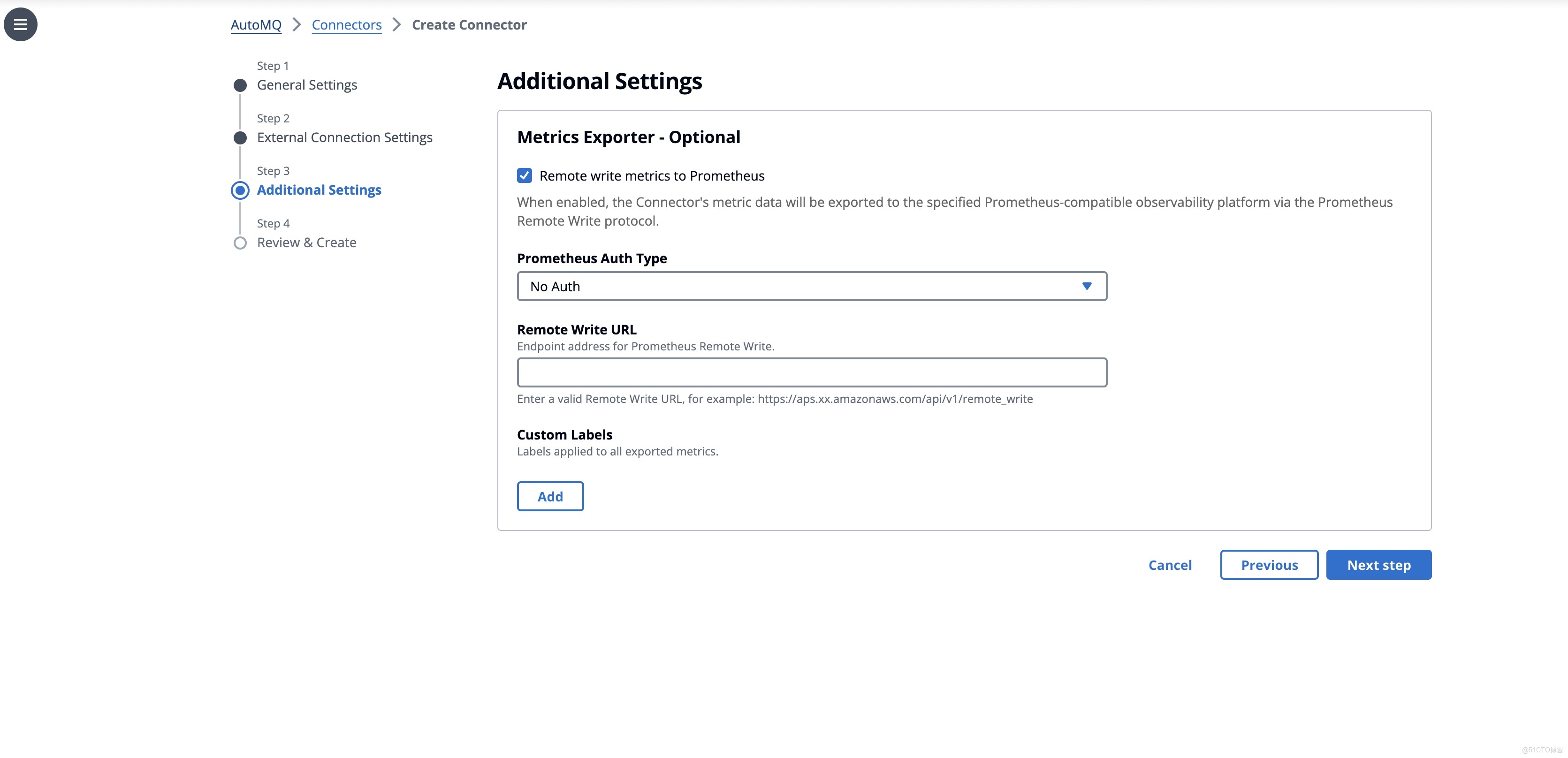

3. 可觀測性:打破數據孤島

在“額外設置”中,我們內置了標準化的可觀測性集成。通過勾選 Remote Write,Connector 的監控指標可直接對接到 Prometheus/Grafana 體系,無需額外部署 Exporter,徹底告別黑盒運維。

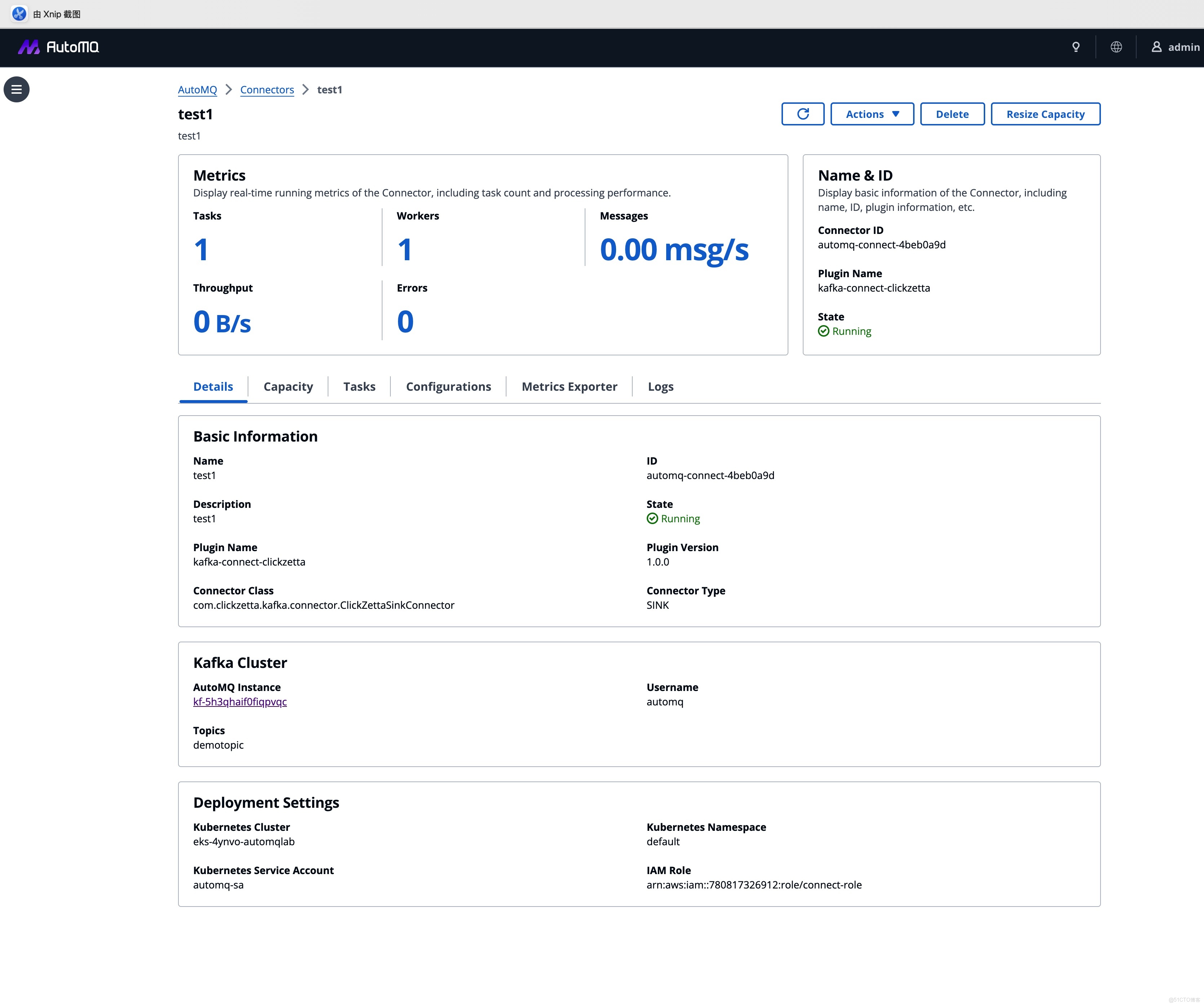

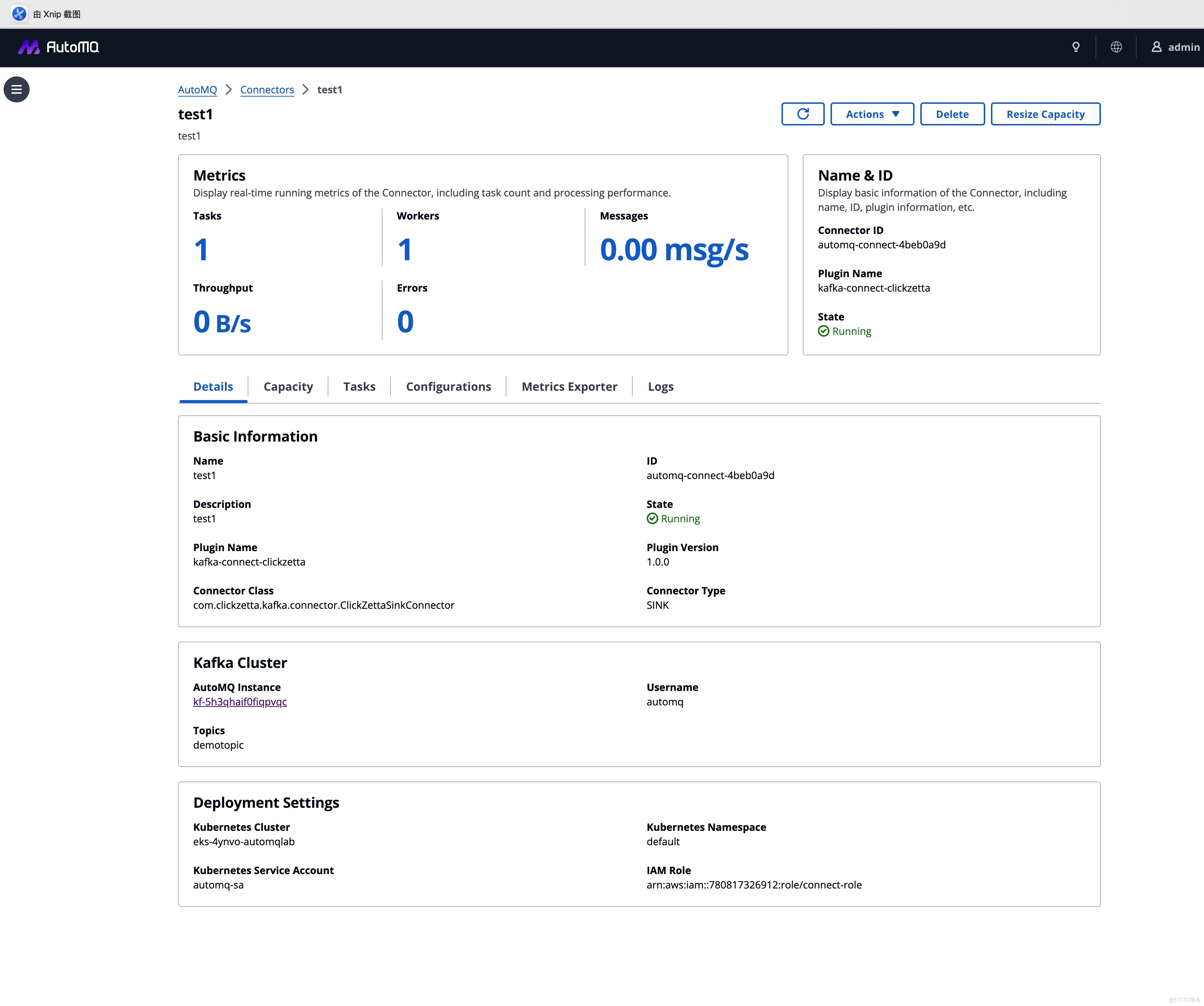

4. 部署與運維:全程可視

提交後,AutoMQ 接管全流程部署。部署完成後,用户獲得的是一個具備深度的運維儀表盤。

- 實時吞吐監控:

- 日誌聚合查詢:無需登錄 K8s,直接在控制枱聚合查詢所有 Worker 日誌,快速定位業務異常。

總結

AutoMQ Connector 託管能力的上線,標誌着 AutoMQ 從單一的流存儲引擎向完整的雲原生流數據平台邁出了關鍵一步。

通過將 Connector 與 AutoMQ 集羣進行產品級強綁定,我們實現了:

- 極簡的 CDC 鏈路構建:無需關心繁瑣的 Client 參數與網絡配置,四步向導即可拉起生產級鏈路。

- 默認的最佳實踐:通過自動化的配置注入,天然適配 AutoMQ 的核心特性(如 Zero Cross-AZ),消除配置錯誤帶來的隱患。

- 統一的治理體驗:從 Broker 到 Connector,在同一控制枱內實現全棧閉環管理。

如果你正在尋找一個能夠快速落地、且運維成本極低的數據集成方案,歡迎參考我們的官方文檔,在 AutoMQ BYOC 環境中體驗這一新特性。

💡 開源 AutoMQ 正在 Github Trending 中,歡迎關注:

https://go.automq.com/github?utm_source=openwrite_automq

👇 AutoMQ 商業版當前提供 2 周免費試用,歡迎試用:

https://go.automq.com/home?utm_source=openwrite_automq