Patroni與Mesos集成:大數據平台下的PostgreSQL高可用部署

在大數據平台架構中,PostgreSQL數據庫的高可用部署面臨三大核心挑戰:資源動態調度、跨節點狀態一致性、故障自動轉移。傳統主從複製方案在Mesos這樣的分佈式資源管理平台下,常出現腦裂、數據不一致等問題。Patroni作為PostgreSQL高可用解決方案,通過與分佈式協調服務(如etcd、Consul、ZooKeeper或Kubernetes)集成,可有效解決上述問題。本文將詳細介紹如何在Mesos環境中部署Patroni管理的PostgreSQL集羣,實現資源彈性伸縮與自動故障轉移。

架構設計:Patroni與Mesos的協同機制

核心組件交互流程

Patroni與Mesos的集成需通過Marathon框架實現服務編排,結合etcd作為分佈式協調服務(DCS)存儲集羣元數據。以下為關鍵組件交互流程:

- 資源調度:Mesos Master接收Marathon提交的Patroni任務,分配Slave節點資源

- 集羣初始化:Patroni通過etcd選舉主節點,初始化PostgreSQL集羣

- 健康檢查:Marathon定期檢查Patroni進程狀態,結合Patroni內置健康檢查確保數據庫可用性

- 故障轉移:當主節點故障時,Patroni通過etcd重新選舉新主,Marathon自動在健康節點重啓故障實例

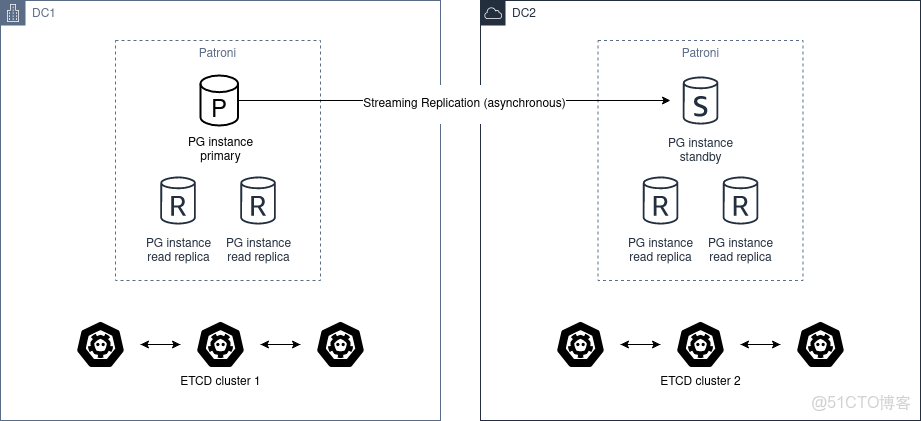

圖1:Patroni多數據中心部署架構(類似Mesos跨節點集羣架構)

關鍵技術組件

- Patroni:實現PostgreSQL集羣管理、故障轉移與配置同步,核心代碼位於patroni/

- etcd:分佈式鍵值存儲,存儲集羣狀態與配置,實現代碼見patroni/dcs/etcd.py

- Marathon:Mesos框架,負責Patroni服務的部署、擴縮容與健康檢查

- HAProxy:負載均衡器,通過haproxy.cfg配置實現讀寫分離

部署步驟:從環境準備到集羣啓動

1. 環境依賴配置

需在Mesos Slave節點安裝以下依賴:

- Python 3.6+及依賴包:requirements.txt

- PostgreSQL 12+:建議通過Docker鏡像部署

- etcd集羣:至少3節點,確保高可用

2. Marathon應用定義

創建Marathon JSON配置文件,定義Patroni服務:

{

"id": "/postgresql/patroni",

"cpus": 2,

"mem": 4096,

"disk": 20000,

"instances": 3,

"container": {

"type": "DOCKER",

"docker": {

"image": "patroni:latest",

"network": "BRIDGE",

"portMappings": [

{"containerPort": 5432, "hostPort": 0, "servicePort": 10000},

{"containerPort": 8008, "hostPort": 0, "servicePort": 10001}

]

}

},

"env": {

"PATRONI_DCS_ETCD_HOSTS": "etcd-node1:2379,etcd-node2:2379,etcd-node3:2379",

"PATRONI_SCOPE": "postgresql-cluster",

"PATRONI_POSTGRESQL_DATA_DIR": "/data/postgres"

},

"healthChecks": [

{

"protocol": "HTTP",

"path": "/health",

"portIndex": 1,

"gracePeriodSeconds": 30,

"intervalSeconds": 10,

"timeoutSeconds": 5,

"maxConsecutiveFailures": 3

}

]

}3. Patroni配置文件

創建PostgreSQL配置模板postgres0.yml,關鍵配置如下:

scope: postgresql-cluster

namespace: /service/

name: patroni-{HOST}

restapi:

listen: 0.0.0.0:8008

connect_address: {HOST_IP}:8008

etcd:

hosts: etcd-node1:2379,etcd-node2:2379,etcd-node3:2379

postgresql:

listen: 0.0.0.0:5432

connect_address: {HOST_IP}:5432

data_dir: /data/postgres

bin_dir: /usr/lib/postgresql/12/bin

parameters:

shared_buffers: 1GB

wal_level: replica4. 啓動集羣

通過Marathon API提交應用:

curl -X POST http://marathon:8080/v2/apps -d @patroni-marathon.json -H "Content-type: application/json"集羣管理:監控、擴縮容與故障處理

集羣狀態監控

- Patroni API:訪問每個節點的8008端口獲取集羣狀態

curl http://patroni-node1:8008/cluster返回結果示例:

{

"members": [

{"name": "patroni-node1", "role": "leader", "state": "running"},

{"name": "patroni-node2", "role": "replica", "state": "running"},

{"name": "patroni-node3", "role": "replica", "state": "running"}

],

"leader": "patroni-node1"

}- etcd集羣狀態:通過etcdctl檢查Patroni存儲的集羣數據

etcdctl get --prefix /service/postgresql-cluster/彈性擴縮容

通過Marathon調整實例數量實現集羣擴縮容:

curl -X PATCH http://marathon:8080/v2/apps/postgresql/patroni -d '{"instances": 5}' -H "Content-type: application/json"Patroni會自動將新增節點加入集羣作為副本,實現代碼見patroni/ha.py中的Ha.set_up_replica()方法。

故障轉移演練

- 手動觸發故障轉移:使用patronictl工具

patronictl -c postgres0.yml failover- 自動故障轉移驗證:

- 關閉主節點PostgreSQL進程

- 觀察etcd中leader鍵值變化:

etcdctl watch /service/postgresql-cluster/leader - 驗證新主節點日誌:

journalctl -u patroni

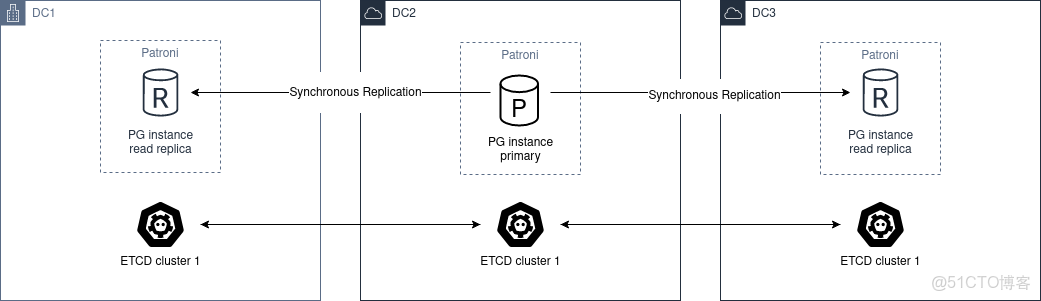

圖2:Patroni同步複製架構(Mesos環境下確保數據一致性)

最佳實踐:性能優化與高可用保障

資源配置建議

- CPU:每個Patroni實例至少2核,主節點可分配4核

- 內存:PostgreSQL的shared_buffers建議設為物理內存的25%

- 存儲:使用SSD,通過Marathon配置磁盤資源限制

高可用配置要點

- etcd集羣:至少3節點,部署在不同Mesos Slave

- Patroni參數調優:

retry_timeout: 30秒(Mesos網絡延遲容忍)loop_wait: 10秒(狀態檢查間隔)- 配置文件:patroni/ha.py中的

Ha類

- 備份策略:集成Barman工具,配置見patroni/scripts/barman/

常見問題排查

- 腦裂問題:確保etcd集羣多數派存活,檢查patroni/quorum.py實現的法定人數算法

- 複製延遲:通過

pg_stat_replication監控同步狀態,調整max_wal_senders參數 - 資源競爭:Mesos配置資源預留,避免其他任務搶佔數據庫資源

總結與展望

通過Patroni與Mesos的集成,可在大數據平台中構建彈性伸縮、自動故障轉移的PostgreSQL集羣。關鍵優勢包括:

- 資源高效利用:Mesos動態調度實現資源按需分配

- 高可用性:Patroni結合etcd確保99.99%服務可用性

- 簡化管理:自動化故障轉移與配置同步,減少人工干預

未來可探索方向:

- 集成Prometheus監控:利用docs/ENVIRONMENT.rst中定義的指標導出功能

- 實現基於GPU的PostgreSQL加速:通過Mesos GPU資源調度

- 跨區域容災:結合docs/ha_multi_dc.rst實現跨Mesos集羣部署