今天咱們和大家一起聊聊關於 XGBoost 的一個算法案例:XGBoost 在股市波動預測中的應用。

當然,僅僅作為算法模型的學習,切勿用於真實情況。

下面,咱們從原理到案例,好好説説~

XGBoost原理

XGBoost(eXtreme Gradient Boosting)是一個基於梯度提升決策樹(GBDT)實現的高效分佈式機器學習算法。它以決策樹為基學習器,通過優化加權的方式來提升模型的預測能力,廣泛應用於分類、迴歸等任務。

在股市波動預測中,XGBoost的優勢主要體現在:

- 強大的非線性擬合能力:可以捕捉股市複雜的非線性動態。

- 特徵重要性分析:評估不同財務指標對股市波動的影響。

- 魯棒性強:對異常數據和噪聲較為敏感。

XGBoost的核心原理

XGBoost的主要思想是將多個弱學習器(一般為CART樹)疊加,以提高整體模型的預測能力。以下為核心原理和公式。

目標函數:

XGBoost通過優化以下目標函數進行訓練:

其中:

- :損失函數,衡量預測值與實際值的偏差。

- :正則化項,控制模型複雜度。:樹的葉子節點數。:葉子權重的L2範數。

為了更高效地優化,XGBoost採用二階泰勒展開近似目標函數:

其中:

- :一階梯度。

- :二階梯度。

最佳分裂點的選擇: 對於每棵樹,每次分裂的目標是最大化增益(Gain):

其中:

- 和:左子節點的梯度和Hessian。

- 和:右子節點的梯度和Hessian。

XGBoost的優勢

- 高效計算:支持分佈式計算和多線程。

- 靈活性:支持自定義損失函數。

- 處理缺失值:可以自動分配缺失值的最佳分裂方向。

- 過擬合控制:通過正則化項和早停機制有效防止過擬合。

股市波動預測中的特殊注意點

在應用XGBoost預測股市波動時,應注意以下幾點:

- 數據的非平穩性:股市數據常表現出時間序列的非平穩性,需要先通過平穩化處理(如差分、對數變換)再輸入模型。

- 多重共線性:許多財務指標之間可能高度相關,應通過主成分分析(PCA)或變量篩選減少共線性。

- 特徵選擇:特徵工程在股市預測中尤為重要,可嘗試添加技術指標(如RSI、MACD)、市場情緒數據等。

- 模型解釋性:需要對模型輸出的重要性進行解釋,例如哪些指標對預測結果貢獻最大。

- 數據時間切分:股市預測是典型的時間序列問題,應確保訓練集和測試集按照時間順序切分。

完整案例實現

問題描述

假設我們預測某股票每日的波動(漲跌幅度),使用虛擬數據集模擬日收盤價、交易量、技術指標等特徵。

數據集生成

我們模擬如下特徵:

- 日期(Date)

- 收盤價(Close)

- 成交量(Volume)

- 技術指標(如RSI、MACD、移動平均值等)

下面是代碼實現。

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from xgboost import XGBRegressor, plot_importance

from sklearn.metrics import mean_squared_error, r2_score

# 生成虛擬數據

np.random.seed(42)

dates = pd.date_range(start="2022-01-01", periods=500)

close_prices = np.cumsum(np.random.randn(500) * 2 + 100)

volume = np.random.randint(100, 1000, size=500)

rsi = np.random.uniform(30, 70, size=500)

macd = np.cumsum(np.random.randn(500))

ma_10 = pd.Series(close_prices).rolling(window=10).mean().fillna(method='bfill')

# 創建數據集

data = pd.DataFrame({

'Date': dates,

'Close': close_prices,

'Volume': volume,

'RSI': rsi,

'MACD': macd,

'MA_10': ma_10

})

data['Target'] = data['Close'].shift(-1) - data['Close'] # 預測下一個交易日的波動

data.dropna(inplace=True)

# 特徵和目標

X = data[['Close', 'Volume', 'RSI', 'MACD', 'MA_10']]

y = data['Target']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, shuffle=False)模型訓練

我們使用XGBoost進行訓練,並調整參數。

# 初始化模型

xgb = XGBRegressor(

max_depth=5,

n_estimators=200,

learning_rate=0.1,

subsample=0.8,

colsample_bytree=0.8,

random_state=42

)

# 模型訓練

xgb.fit(X_train, y_train)

# 預測

y_pred = xgb.predict(X_test)可視化分析

(1)預測結果 vs 實際值

plt.figure(figsize=(10, 6))

plt.plot(y_test.values, label='Actual', color='blue', alpha=0.6)

plt.plot(y_pred, label='Predicted', color='red', linestyle='--', alpha=0.8)

plt.title('Actual vs Predicted Stock Movements')

plt.xlabel('Time')

plt.ylabel('Price Change')

plt.legend()

plt.show()模型預測的股市波動與真實波動的對比,評估模型效果。

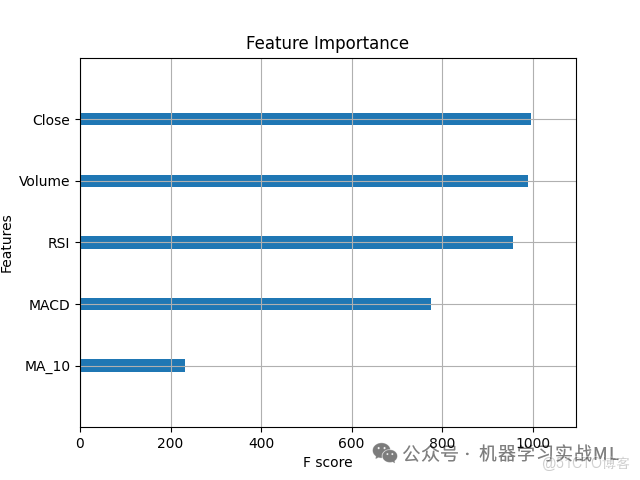

(2)特徵重要性

plt.figure(figsize=(8, 5))

plot_importance(xgb, importance_type='weight', title='Feature Importance', show_values=False)

plt.show()各特徵在模型中的重要性排名,幫助優化特徵選擇。

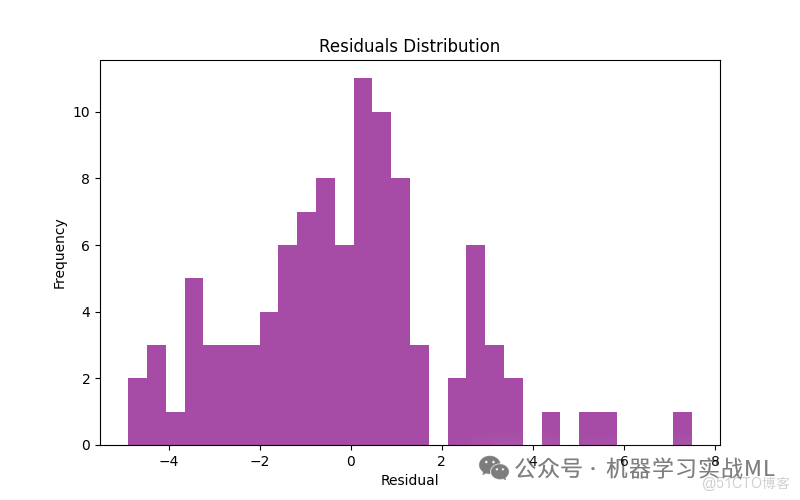

(3)殘差分析

residuals = y_test - y_pred

plt.figure(figsize=(8, 5))

plt.hist(residuals, bins=30, color='purple', alpha=0.7)

plt.title('Residuals Distribution')

plt.xlabel('Residual')

plt.ylabel('Frequency')

plt.show()檢查模型預測誤差的分佈,是否符合正態分佈。

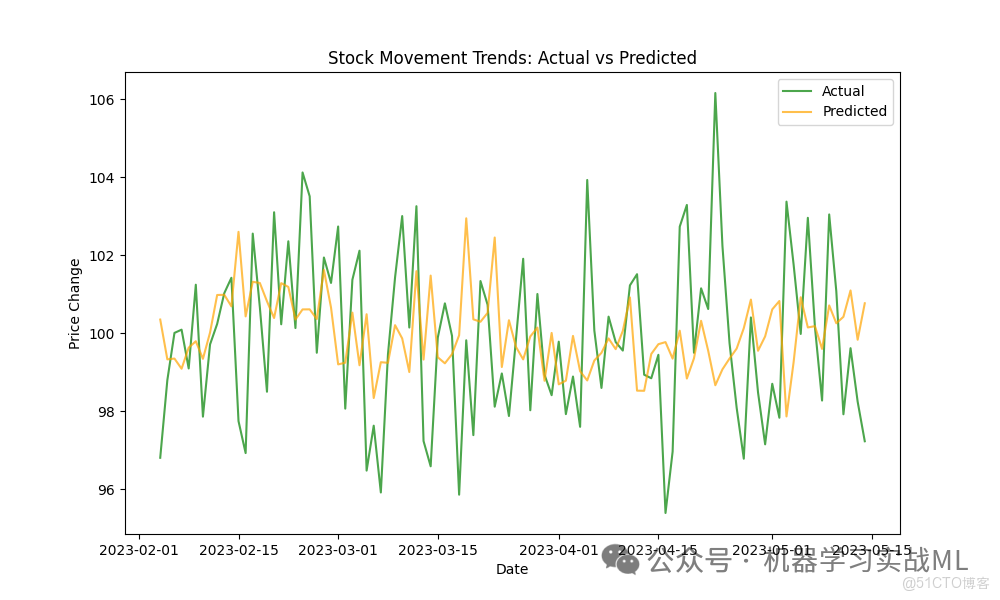

(4)實際波動與預測波動趨勢

plt.figure(figsize=(10, 6))

plt.plot(data['Date'][-len(y_test):], y_test.values, label='Actual', color='green', alpha=0.7)

plt.plot(data['Date'][-len(y_test):], y_pred, label='Predicted', color='orange', alpha=0.7)

plt.title('Stock Movement Trends: Actual vs Predicted')

plt.xlabel('Date')

plt.ylabel('Price Change')

plt.legend()

plt.show()展示預測波動的趨勢與真實波動趨勢的擬合程度。

優化與調參流程

算法優化點

- 處理時間序列特徵:加入滯後特徵(Lag Features)。

- 異常值處理:剔除或平滑極端異常值。

- 正則化:增加L1正則防止過擬合。

調參流程

- 學習率調整:從0.3到0.01逐步減少,控制收斂速度。

- 樹深度:選擇3-10之間,控制模型複雜度。

- 正則化參數:嘗試不同的、值,優化模型泛化能力。

- 交叉驗證:使用時間序列交叉驗證評估模型表現。