構建智能語義搜索系統:BERT與Elasticsearch的完美結合

在當今信息爆炸的時代,傳統的關鍵詞搜索已經難以滿足用户對精準內容檢索的需求。基於BERT的語義搜索技術通過深度理解文本語義,為信息檢索帶來了革命性的突破。本文將深入探討如何利用BERT模型與Elasticsearch構建高效的智能語義搜索系統。

核心優勢深度剖析

語義理解能力超強

傳統的TF-IDF和BM25算法主要依賴詞頻統計,而BERT模型能夠深入理解文本的語義含義。通過雙向Transformer架構,BERT可以捕捉詞語在上下文中的真實含義,實現真正的語義匹配。

多語言支持靈活

BERT模型支持多種語言版本,包括中文、英文、多語言等,能夠滿足不同語言環境下的搜索需求。項目提供了完整的預訓練模型下載和使用指南。

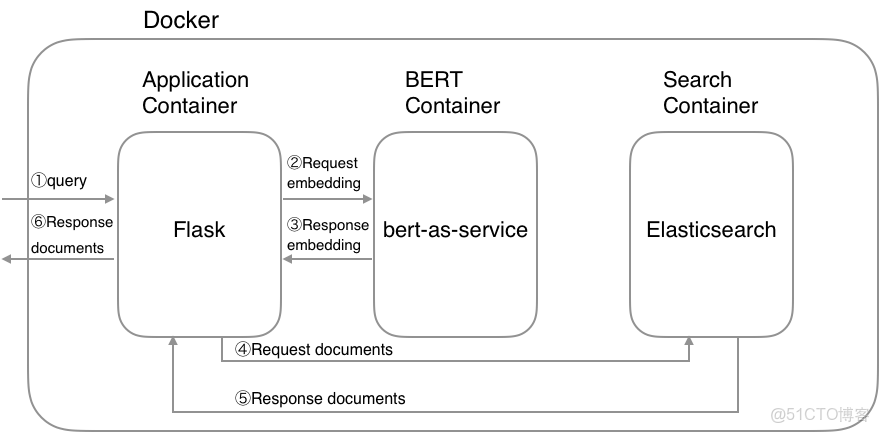

高性能架構設計

系統採用Docker容器化部署,BertSearch服務與Elasticsearch分離,確保系統的高可用性和可擴展性。

技術實現原理詳解

BERT向量化處理

系統核心在於將文本內容通過BERT模型轉化為768維的向量表示。這些向量包含了豐富的語義信息,能夠準確反映文本的深層含義。

向量化處理示例:

from bert_serving.client import BertClient

bc = BertClient(output_fmt='list')

embeddings = bc.encode([doc['text'] for doc in batch_docs])Elasticsearch向量檢索

利用Elasticsearch的dense_vector字段類型存儲BERT向量,通過餘弦相似度算法計算查詢向量與文檔向量的相似度。

相似度計算機制

系統採用改進的餘弦相似度算法,確保搜索結果的相關性和準確性:

script_query = {

"script_score": {

"query": {"match_all": {}},

"script": {

"source": "cosineSimilarity(params.query_vector, doc['text_vector']) + 1.0",

}

}快速搭建實踐指南

環境準備要求

- Docker環境

- Docker Compose 1.22.0及以上版本

- 8GB以上內存配置

模型下載與配置

下載預訓練的BERT模型並配置環境變量:

wget https://storage.googleapis.com/bert_models/2018_10_18/cased_L-12_H-768_A-12.zip

unzip cased_L-12_H-768_A-12.zip

export PATH_MODEL=./cased_L-12_H-768_A-12

export INDEX_NAME=jobsearch系統啓動步驟

- 啓動Docker容器服務

- 創建Elasticsearch索引

- 轉換文檔數據為向量格式

- 索引文檔數據

完整部署流程

# 啓動服務

docker-compose up

# 創建索引

python example/create_index.py --index_file=example/index.json --index_name=jobsearch

# 處理文檔數據

python example/create_documents.py --data=example/example.csv --index_name=jobsearch

# 索引文檔

python example/index_documents.py實際應用場景展示

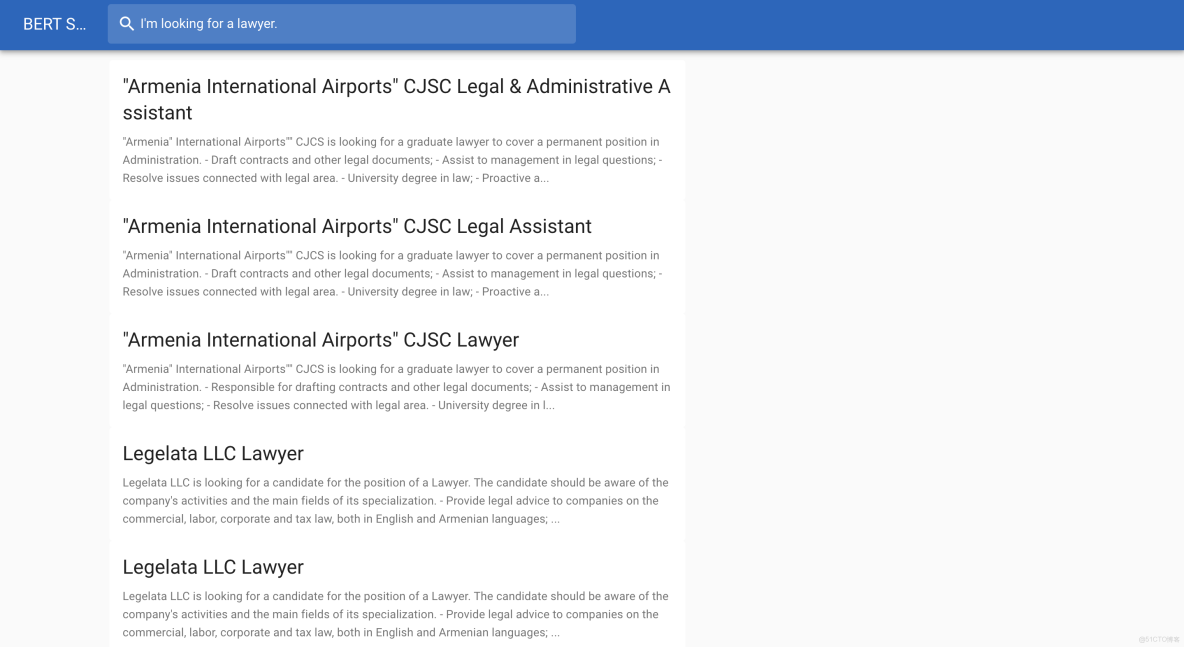

職位搜索系統

項目示例展示了一個智能職位搜索系統,用户可以通過自然語言描述來搜索相關職位:

- 輸入:"需要編程技能的工作"

- 輸出:軟件工程師、前端開發、後端開發等相關職位

文檔管理系統

適用於企業內部文檔檢索,能夠理解用户查詢意圖,返回最相關的文檔內容。

內容推薦引擎

基於語義相似度,為用户推薦相關內容,提升用户體驗。

性能優化建議

內存配置優化

BERT模型需要較大的內存空間,建議為Docker分配8GB以上內存,確保系統穩定運行。

批量處理策略

對於大量文檔處理,建議採用批量處理方式,設置合適的batch_size參數:

def bulk_predict(docs, batch_size=256):

for i in range(0, len(docs), batch_size):

batch_docs = docs[i: i+batch_size]

embeddings = bc.encode([doc['text'] for doc in batch_docs])索引配置調優

根據實際數據量和查詢需求,合理設置Elasticsearch的分片數和副本數:

{

"settings": {

"number_of_shards": 2,

"number_of_replicas": 1

}

}擴展與定製方案

模型替換支持

系統支持替換不同的BERT預訓練模型,用户可以根據具體需求選擇Base、Large或多語言版本。

自定義相似度算法

開發者可以修改相似度計算腳本,實現不同的匹配策略和權重配置。

總結與展望

BertSearch項目展示了深度學習與傳統搜索引擎技術的完美結合。通過BERT模型的語義理解能力和Elasticsearch的高效檢索性能,為用户提供了前所未有的搜索體驗。

隨着自然語言處理技術的不斷髮展,語義搜索將在更多領域發揮重要作用。無論是企業級應用還是個人項目,都可以基於此技術棧構建更智能的搜索解決方案。

通過本文的詳細解析和實踐指南,相信您已經掌握了構建智能語義搜索系統的核心技術。立即開始您的語義搜索之旅,探索深度學習的無限可能!