1、文章信息

《PredRNN: Recurrent Neural Networks for Predictive Learning using Spatiotemporal LSTMs》。

清華大學軟件學院博士生,後續的PredRNN++ 以及Memory in Memory都是這個人所寫。

2、摘要

時空序列的預測學習的目的是通過學習歷史幀來生成未來的圖像,其中空間表現和時間變化是兩個關鍵的結構。本文提出一種預測遞歸神經網絡(PredRNN)來模擬這些結構。這種架構的靈感來自於這樣一種思想,即時空預測學習應該在一個統一的記憶池中記憶空間表象和時間變化。具體來説,內存狀態不再侷限於每個LSTM單元內部。相反,它們可以在兩個方向上之字形移動:垂直穿過堆疊的RNN層,並水平貫穿所有RNN層的狀態。該網絡的核心是一種新的時空LSTM(ST-LSTM)同時提取和記憶空間和時間表示的單元。PredRNN在三個視頻預測數據集上實現了最先進的預測性能,是一個更通用的框架,可以很容易地擴展到其他預測學習任務。

3、簡介

一個簡單的想法是,如果我們希望預測未來,我們需要記住儘可能多的歷史細節。當我們回憶以前發生的事情時,我們不僅回憶物體的運動,還回憶從粗到細的視覺現象。在此基礎上,我們提出了一種新的循環架構——預測RNN(PredRNN),它允許屬於不同LSTMs的memory狀態跨層交互。作為PredRNN的關鍵組成部分,我們設計了一個新的時空LSTM (ST-LSTM)單元。它在一個統一的記憶單元中對空間和時間表示進行建模,並在垂直層面和水平層面上傳遞記憶。PredRNN在三個視頻數據集上取得了最先進的預測結果。它是預測學習的通用模塊框架,並不侷限於視頻預測。

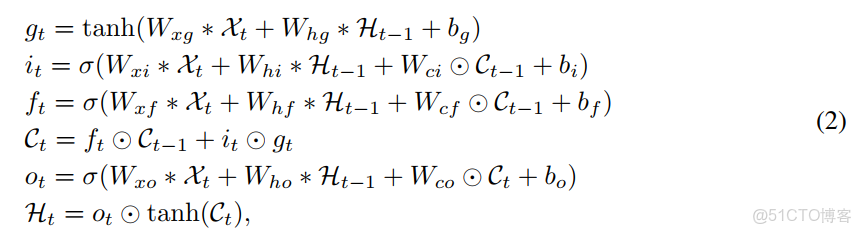

ConvLSTM網絡採用了[23]中提出的編碼-解碼器RNN結構,並擴展到[21]中的視頻預測。對於四層ConvLSTM編解碼器網絡,輸入幀被送入第一層,在第四層產生未來的視頻序列。在這個過程中,空間表示被逐層編碼,隱藏狀態從下到上傳遞。然而,屬於這四層的記憶細胞是相互獨立的,僅在時間域內更新。在這種情況下,底層會完全忽略頂層在之前的時間步中所記憶的內容。克服這種與層無關的記憶機制的缺點,對於視頻序列的預測學習具有重要意義。ConvLSTM的主要公式如下:

4、主體內容

在本節中,我們將詳細描述預測遞歸神經網絡(PredRNN)。最初,這種架構受到這樣一種思想的啓發,即預測性學習系統應該在統一的memory中記住空間表現和時間變化。通過這樣做,我們使內存狀態沿之字形方向流經整個網絡。然後,我們想進一步研究如何使時空記憶與原始的長短時記憶相互作用。因此,我們對LSTMs/ConvLSTMs中的存儲單元、存儲門和存儲融合機制進行了探索。最後我們推導出一個新的時空LSTM(ST-LSTM)用於PredRNN的單元,它能夠垂直和水平地傳遞存儲器狀態。

Spatiotemporal memory flow

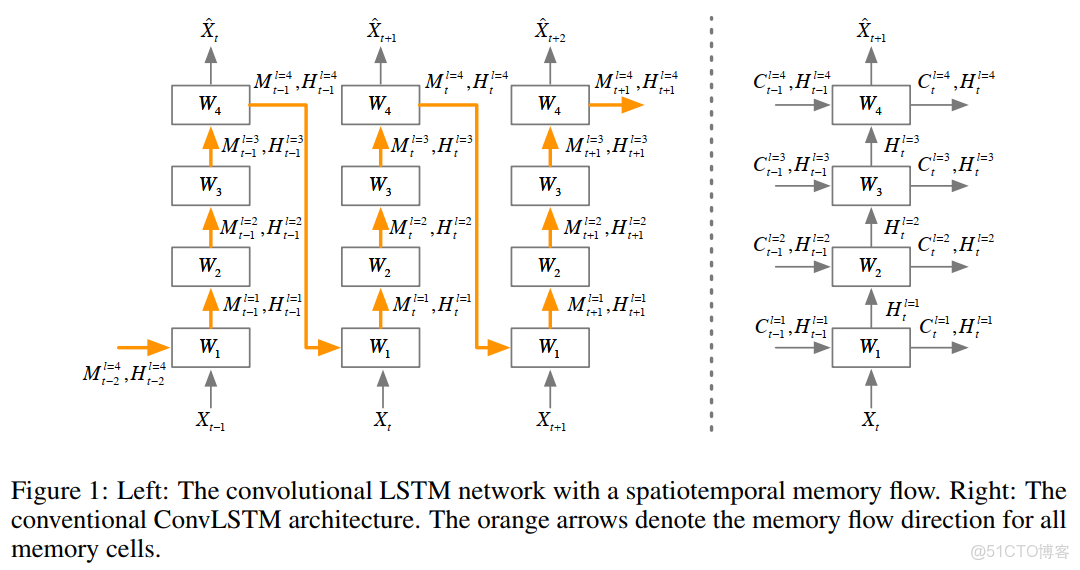

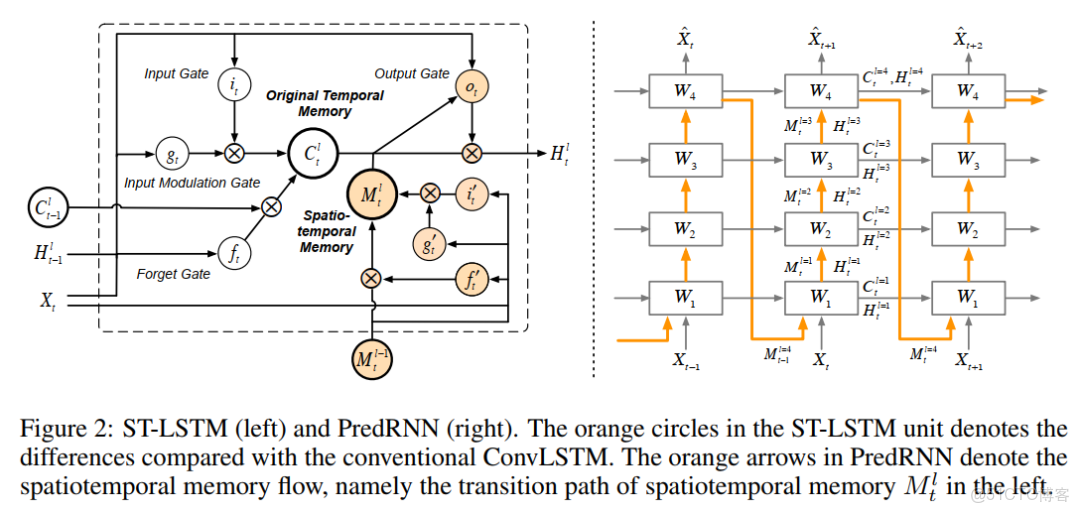

為了生成時空預測,PredRNN首先利用卷積lstm (ConvLSTM)[19]作為基本構建塊。堆疊的ConvLSTMs提取高度抽象的特徵逐層,然後通過將它們映射回像素值空間進行預測。在傳統的ConvLSTM體系結構,如圖1(右)所示,每個單元格的狀態只能水平更新。信息只能通過隱藏狀態向上傳遞。這種時間記憶流在監督學習中是合理的,因為根據對疊加捲積層的研究,隱藏的表示從底層向上可以變得越來越抽象和class specific。然而,我們假設在預測學習中,應該保持原始輸入序列中的詳細信息。如果我們想要看到未來,我們需要從不同層次的卷積層中提取的表示中學習。因此,我們應用一個統一的時空記憶池並改變RNN連接,如圖1所示(左)。橙色箭頭表示LSTM記憶細胞的前饋方向。在左邊的圖中,一個統一的內存被所有的LSTMs共享,並且沿着之字形方向進行更新。具有時空記憶流的卷積LSTM單元的關鍵方程如下所示:

輸入門、輸入調製門、遺忘門和輸出門不再依賴於同一層上的前一時間步的隱藏狀態和單元狀態。相反,如圖1(左)所示,

它們依賴於上一層的隱藏狀態和細胞狀態,在當前時間步長上一層更新。具體地説,底層LSTM單元(l = 1)在前一個時間步長從頂層接收狀態值。圖中的四層具有不同的輸入-狀態和狀態-狀態卷積參數集,同時它們維護一個時空記憶單元,並在信息流經當前節點時分別、重複地更新其狀態。注意,我們將記憶單元的符號從C替換為M,以強調它在PredRNN中以之字形流動,而不是在標準循環網絡中以水平方向流動。與使用Hadamard乘積在門中進行狀態轉換的ConvLSTM不同,我們使用卷積運算符∗來進行更細粒度的memory轉換。(即W和M之間是卷積而不是Hadamard乘積)。

Spatiotemporal LSTM

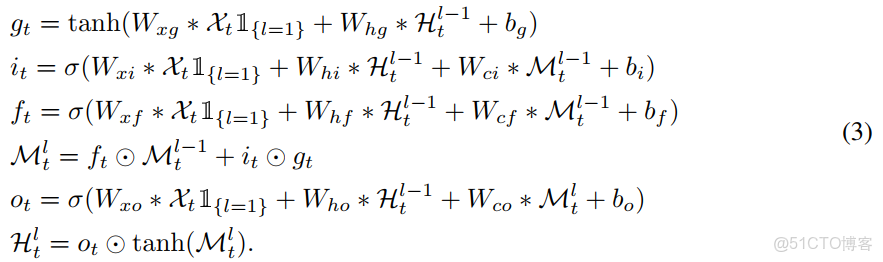

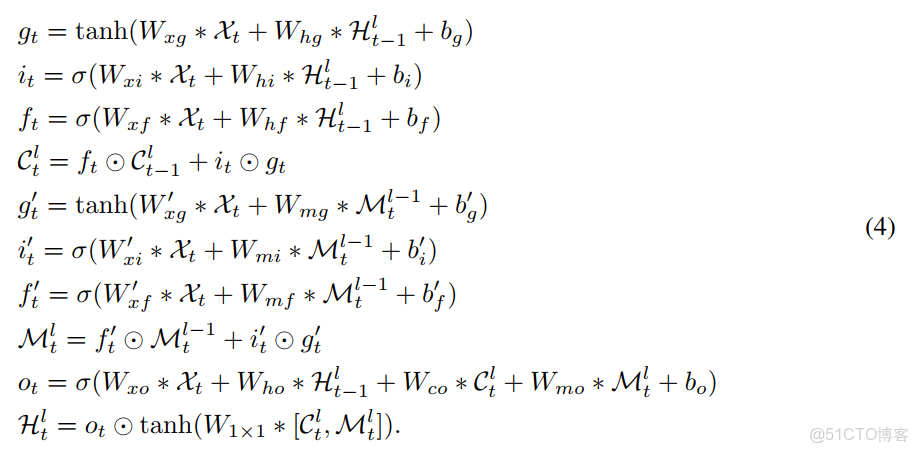

在本節中,我們提出了預測遞歸神經網絡(PredRNN),用一個新的時空長短時記憶(ST-LSTM)單元替換了ConvLSTMs(見圖2)。在上一小節介紹的體系結構中,時空記憶單元以鋸齒狀的方向更新,信息首先向上跨層傳遞,然後隨着時間向前傳遞。我們想知道如果記憶細胞狀態同時在這兩個方向傳遞會發生什麼。在ST-LSTMs的幫助下,上述帶有時空記憶流的PredRNN模型演化成了我們最終的架構。ST-LSTM的方程如下:

其中兩個記憶單元C和M都被保留了,Ct是標準的時間單元,在每個LSTM單元內從之前的節點t−1傳輸到當前時間步長(橫向傳播)。L層的Mt是我們在本節中描述的時空記憶spatiotemporal memory,它在同一時間步長內從l−1層垂直傳輸到當前節點(縱向傳播)。T-1時刻最後一層的M會傳遞到t時刻第一層。我們為Mt構造了另一組門結構,同時在標準LSTMs中保留了Ct的原始門控機構。最後,該節點的最終隱藏狀態依賴於融合的時空記憶。我們將這些來自不同方向的內存連接在一起,然後應用1×1卷積層進行降維,使得隱藏狀態Ht與memory cell具有相同的維度。與簡單的記憶拼接不同,ST-LSTM單元對兩種記憶類型使用共享的輸出門,實現無縫的記憶融合,可以有效地對時空序列中的形狀變形和運動軌跡進行建模。

5、實驗部分

本來使用了三個數據集,一個是Moving MINIST,一個是KTH action dataset,另外一個是雷達回波圖數據集。實驗細節不再詳述。