導語 | 近年來,隨着大模型技術的迅猛發展,搜索領域正經歷從傳統信息檢索向智能問題解決的深刻變革,檢索增強生成(RAG)、多智能體協同架構成為技術突破的關鍵方向。然而,如何實現搜索架構的動態升級與全鏈路算法重構,以適配複雜場景下的用户需求,仍是行業亟待解決的重要課題。

本文特邀騰訊雲元寶 AI 搜索團隊的葉莎妮老師,和大家探討在大模型顛覆知識生成模式的當下,為何我們仍注重搜索以及搜索如何在大模型時代煥發新生。

作者簡介

葉莎妮,來自騰訊雲元寶 AI 搜索團隊。

一、搜索的前世今生

ChatGPT 出現前,搜索長期是關鍵詞匹配 + 鏈接列表的信息檢索工具,用户需自行處理信息。雖然在 2018 年,Google 的 BERT 模型推動搜索進入了語義階段,但交互方式仍未改變。

ChatGPT 掀起大語言模型浪潮後,RAG 技術成熟使搜索從信息檢索邁向任務解決型智能產品,更貼合用户自然語言需求。未來,隨着更多垂類知識接入、多模態融合及交互升級,搜索將成為 AI 時代像水電煤一樣的認知基礎設施,擁有極具想象力的未來。

二、大模型和搜索的關係

大模型和搜索對彼此的影響

搜索這項誕生超 30 年的互聯網“古典技術”,在 AI 時代仍舊是兵家必爭之地。這是因為大模型與搜索能力有着互補、雙向進化的緊密關聯。

大模型需要搜索作為知識引擎,來補充實時與長尾知識、打破靜態邊界,鏈接垂直知識庫、減少 “幻覺”;經過多輪調用深化推理,如今搜索已是大模型落地標配。而大模型則賦予搜索 “新大腦”,推動搜索從鏈接列表加人工篩選,升級為 AI 自動生成精準答案,更帶動架構向生成式演進,實現算法全鏈路重構。

大模型和搜索結合的實踐案例

基於混元 T1 模型,結合內部多生態檢索增強與先進 Agent 架構,搭建的 AI 搜索已應用於騰訊元寶、QQ 瀏覽器等 700 多個內部產品場景,複雜需求下可啓動多輪反思機制。

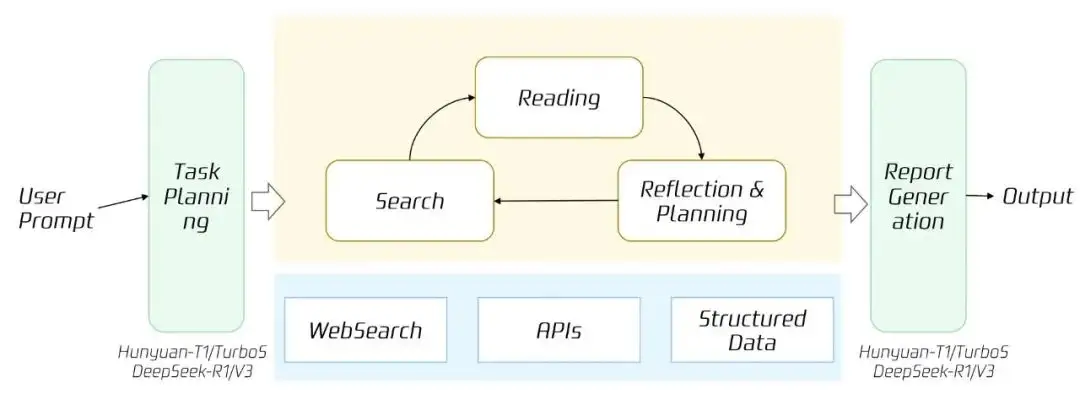

在複雜需求場景,構建 DeepSearch 服務,例如針對高考這類複雜場景,我們推出了 AI 高考通。以往搜索引擎難以滿足志願填報的個性化與完整性需求,而依託Agentic RAG 技術的 DeepSearch,能通過“規劃-搜索-閲讀-反思”循環,調用數十個專業工具,自動生成個性化報考方案並提供決策指引。

AI 高考通,能做到志願分析報告準確率 95%+,並生成數百萬份志願表。

高考相關需求的技術方案

三、關鍵技術挑戰

搜索技術架構躍遷

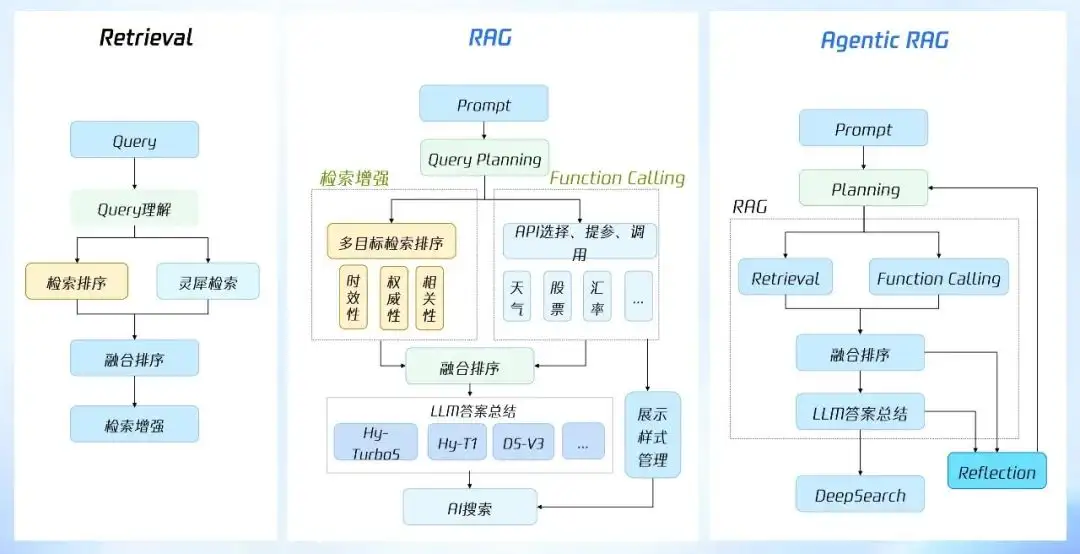

搜索技術架構經歷了從傳統 Retrieval 到 RAG 再到 Agentic RAG 三個階段的演進。

傳統 Retrieval 是靜態檢索流程,包括檢索詞處理解析、多內容源召回、多輪次混合排序等,本質是關鍵詞檢索邏輯,解決 “信息過載” 問題,滿足相關性、權威性等基礎需求。

到了 RAG 階段,是基於大模型決策能力的動態反應式流程,突破點在於 “理解意圖”。RAG 階段,大模型通過 Function Calling 實現股票、天氣等場景化服務接入,生成式排序實現多目標排序,為用户輸出大模型總結的答案。如前面介紹的混元 T1+RAG 實現的 AI 搜索,已積累大量應用場景,每日服務上億次用户需求。

而到了 Agentic RAG 階段,本質是 “認知閉環”,即採用多 Agent 協作架構,Planning 實現任務拆解,Reflection 實現動態調優,增加了強化學習、多輪反饋機制、Agent 靈活接入,實現了從單一流程到多智能體協同。搜索自此走向 “問題解決型智能體”,實現了複雜需求下的 DeepSearch。

靜態檢索流程升級為智能體協同的動態架構

主要技術挑戰和解法

搜索算法從需求理解、索引召回、精排混排、檢索系統進行了全鏈路重構。

在需求理解上,傳統搜索主要是分詞、意圖、糾錯,而 AI 搜索下,用户 prompt 更復雜,貼近自然語言,需要理解上下文、拆解複雜需求、轉化為適合檢索的 query,這依賴領域知識精調和基於檢索效果的強化學習。

索引召回方面,傳統搜索提供 doc 粒度的候選結果,依賴 query、title、doc 主體內容的匹配,粒度較粗,對於知識密度高的內容信息利用不足。現在面向大模型,需要精準的信息片段,因此進行了 chunk 級別索引,實現語義粒度的索引,提升檢索精度,搭配大模型的總結能力生成優質回答、進行多源信息校驗,降低模型幻覺。

生成式精排方面,之前是 bert-based 模型,需要豐富的人工特徵工程,因模型參數小、表徵能力差,單維度分別建模;而在 AI 搜索時代,更大尺寸的生成式模型可端到端針對最終結果的滿意度做綜合排序,表徵能力更強,能多目標一起建模,實現多目標連續生成和統一排序。

檢索系統隨着技術演進從 RAG 走向 Agentic RAG,利用任務規劃能力、工具調用能力、反思校驗能力等關鍵能力,提升了複雜問題解決能力。

搜索算法全面擁抱 LLM 的變化

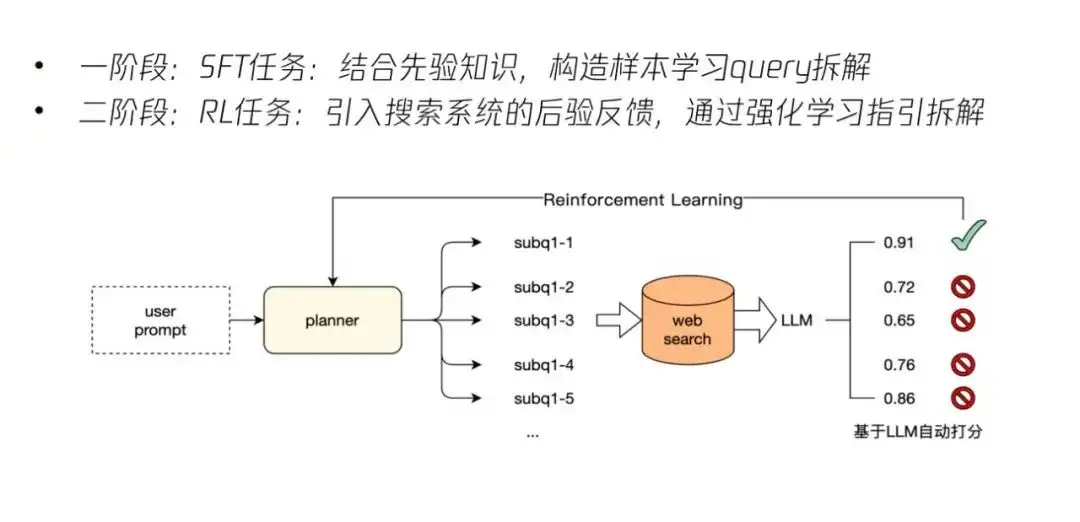

Query Planning

Query Planning 通過拆解 query 和上下文補全,能夠實現用户 prompt 到搜索 query 的規劃。比如,當用户詢問 “煙台大黑山島,這個景點有什麼特色?周邊有哪些經濟酒店?玩下來需要多少天”時,它可以將這個問題拆解為三個 query 來查詢;而在上下文補全方面,當前序 prompt 是 “可以給我一些備跑北馬的建議嗎?”,新一輪 prompt 為 “每年什麼時候舉辦?”時,planner 會自動將 query 改寫補全為 “北京馬拉松舉辦時間,北京馬拉松日期安排” 等。

其算法實現採用兩階段的 LLM 改寫機制:第一階段根據標註數據進行 SFT 任務,結合先驗知識學習意圖拆解;第二階段引入最終搜索後的效果反饋進行強化學習,使拆解後的檢索結果更滿足用户需求。同時,通過多輪並行訓練提升了訓練效率和多輪對話的理解能力,大幅提升搜索滿意度。

基於 LLM 的查詢改寫兩階段

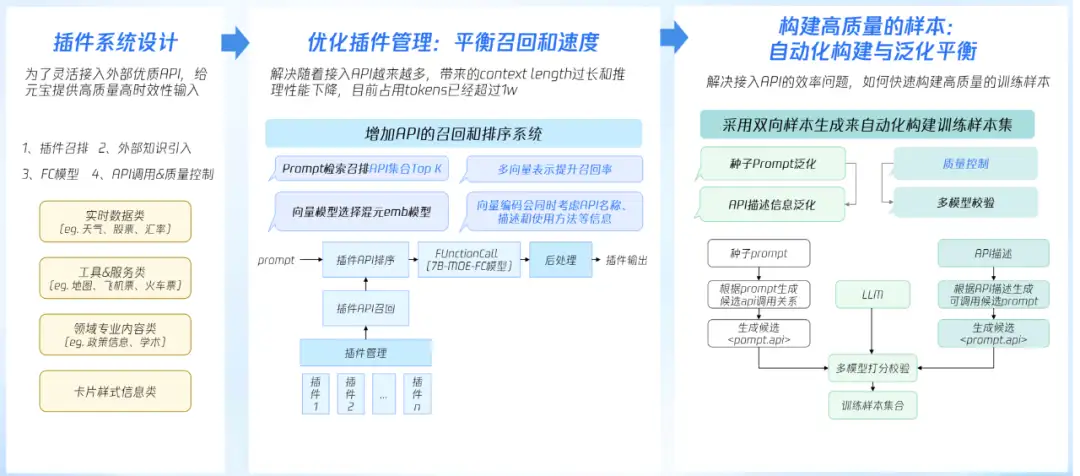

Function Calling

為靈活接入外部優質 API,給元寶提供高質量高時效性輸入,我們開發了插件系統。相當於在傳統搜索中接入合作 CP 的結構化數據,核心目標不變,但能力上有關鍵不同:從靜態數據接入到動態理解,執行機制從固定召回到多插件智能體協同,擴展從定製開發到即插即用,插件系統將數據從 “資源” 升級為 “智能體協作網絡中的敏捷生產力”。

插件系統的整體方案包括:

- 插件召排,基於用户輸入改寫後的 query,以向量方式召回 k 個插件,再基於 rank 模型簡化召回插件列表,輸出 top n,保證召回率 100%;

- 外部知識引入,為 Function Calling 模型提供節假日等外部知識,提升槽位抽取精度,降低模型幻覺;

- Function Calling,基於輸入候選插件及外部知識,對用户改寫 query 抽取出需要調用的 API 及槽位;

- API 調用,將插件結果按照規則映射到 API 請求,獲取 api 結果;

- 質量控制,部分插件偏向於檢索,增加相關度過濾提升精度。

對於插件過多的難點(即全量插件佔用 tokens 超過 1w,影響預測效果和推理速度),我們的解決方案是增加插件召排環節,為每個插件建立多個向量,選取與用户輸入最高相關度進行排序,向量模型上對目前主流多個 emb 模型進行測試,平衡召回率及速度。

針對樣本構建成本高的難點(即因為插件槽位複雜,需要大量樣本覆蓋),我們的解決方案是設計樣本自動構建系統,產品基於設計的插件,給出幾十個種子 prompt 或種子槽位結果,經雙向泛化及質量控制環節,構建出約 20 倍的 FC 模型高精度訓練樣本。

Function Calling的插件管理

LLM Ranking

Query planning 實現意圖理解並轉為檢索系統適配的任務系列後,多目標排序環節需要找到解決這些任務的內容集合。

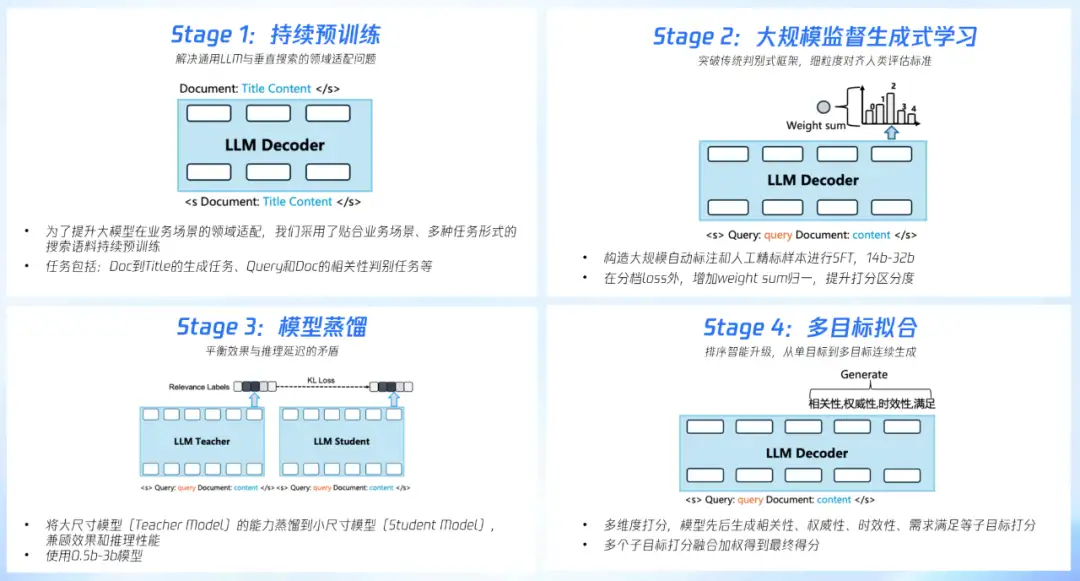

具體技術方法包含四個關鍵步驟:

- Continued Pre-training(搜索持續預訓練):採用多種任務形式的搜索語料持續訓練,優化大模型的領域適配效果;

- 大規模監督生成式學習:採用純生成式方案進行大規模下游任務訓練,並採用細粒度的打分 GenFR 對生成式模型進行約束;

- 生成式模型蒸餾:對生成式 teacher ( 13B/30B/70B) 進行蒸餾,將能力遷移到尺寸相對較小的 LLM student (0.5B) 上以滿足推理性能;

- 多目標能力擬合:多目標排序時採用 4 個目標連續生成的方案,先後生成相關性、權威性、時效性、需求滿足,最後多個目標加權得到最終得分。

這些環節對應了 AI 搜索從基礎能力建設到線上落地的全流程。

多目標排序環節全流程

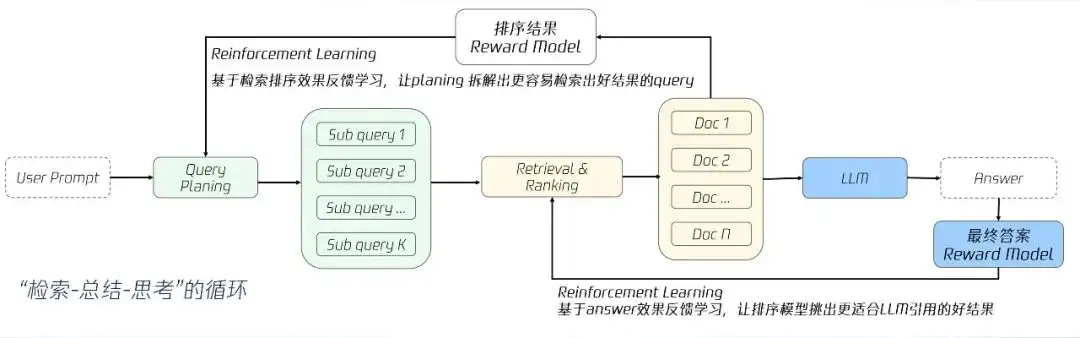

RAG Task Alignment with RL

當用户查詢需要多輪交互才能解決的複雜問題,傳統 RAG 的單次檢索機制難免力不從心。要解決這個問題,得從兩方面進行優化,一方面是從需求的複雜度維度出發,需要強化學習對多輪決策的優化;另一方面則是從結果的可靠性維度考慮,聚焦獎勵機制設計、減少幻覺,從而得到更好的答案。

為此,我們在技術方案上增加了兩個循環:

- 通過強化學習,讓答案好壞影響排序,讓排序結構影響 planing,實現端到端的效果優化。RL-Based Planner 利用檢索排序效果反饋學習,query 拆解引入搜索滿意信號,優化 subq 拆解,使 query 拆解任務下的搜索滿意度提升;

- RL-Based Retriever 利用 Answer 效果反饋學習,基於 LLM 對 Query / SearchDocs 的後驗滿意度信號、Answer 的正確性、Answer 中對 SearchDocs 的引用等信號計算 reward,通過 RL 對齊到 retrieval 階段的 ranking 或者 embedding model。

“檢索-總結-思考”的循環

四、搜索算法加速演講方向

搜索算法的加速演進將聚焦提升四項能力:

- 提升任務規劃能力:從 Query Planning 升級到 Task Planning,更有邏輯地拆解任務,增強搜索和工具調用規劃;

- 提升排序推理能力:利用強化學習增強基於 LLM 排序模型的推理能力,進一步提升排序效果;

- 提升複雜問題解決能力:增強模型規劃搜索、閲讀、反思、重新規劃的能力,提升系統對複雜問題的解決能力;

- 提升總結魯棒性:利用強化學習進一步提升模型的魯棒性、多文檔信息整合能力,使模型更擅長篩選時效內容、引用權威來源作答;同時實現多模態檢索增強,更充分地利用圖片、視頻等內容補充信息。

搜索算法加速演進方向

五、效果收益

2025 年是大模型與聯網搜索互促發展的元年。我們將騰訊內部的檢索增強能力封裝為搜索 API 對外服務。產品名稱“聯網搜索 API”,目前已服務 15 個高增長行業,支撐智能問答、自動駕駛、教育、辦公、金融等 100 多個 AI 場景,助力企業提升效率與體驗、實現 AI 時代戰略升級。

2025 年上半年,隨大模型技術普及,聯網搜索 API 也迎來爆發趨勢:客户數環比增 269%,搜索調用量同比飆升 315%,典型應用覆蓋大模型、汽車、辦公、電商、教育、金融等多領域場景。

騰訊"聯網搜索 API"的推出,不僅降低了企業接入高質量搜索能力的門檻,更通過靈活的接口設計,滿足不同行業的定製化需求。未來,騰訊將持續優化檢索技術,拓展更多垂直場景,與合作伙伴共同推動 AI 生態的繁榮發展。

歡迎大家來騰訊雲體驗 “聯網搜索 API”,一起探索更多的 AI 場景。