I/O多路複用(I/O Multiplexing)是一種允許單個線程同時監視多個文件描述符的I/O模型。其核心價值在於,它將應用程序從低效的I/O等待中解放出來,實現了“一次等待,響應多個事件”的高效併發模式。

要理解其優勢,需要對比非阻塞I/O的侷限性。雖然非阻塞I/O能避免線程在數據未就緒時阻塞,但它要求應用程序通過循環不斷地主動輪詢所有文件描述符,這會造成大量的處理器空轉,浪費計算資源。

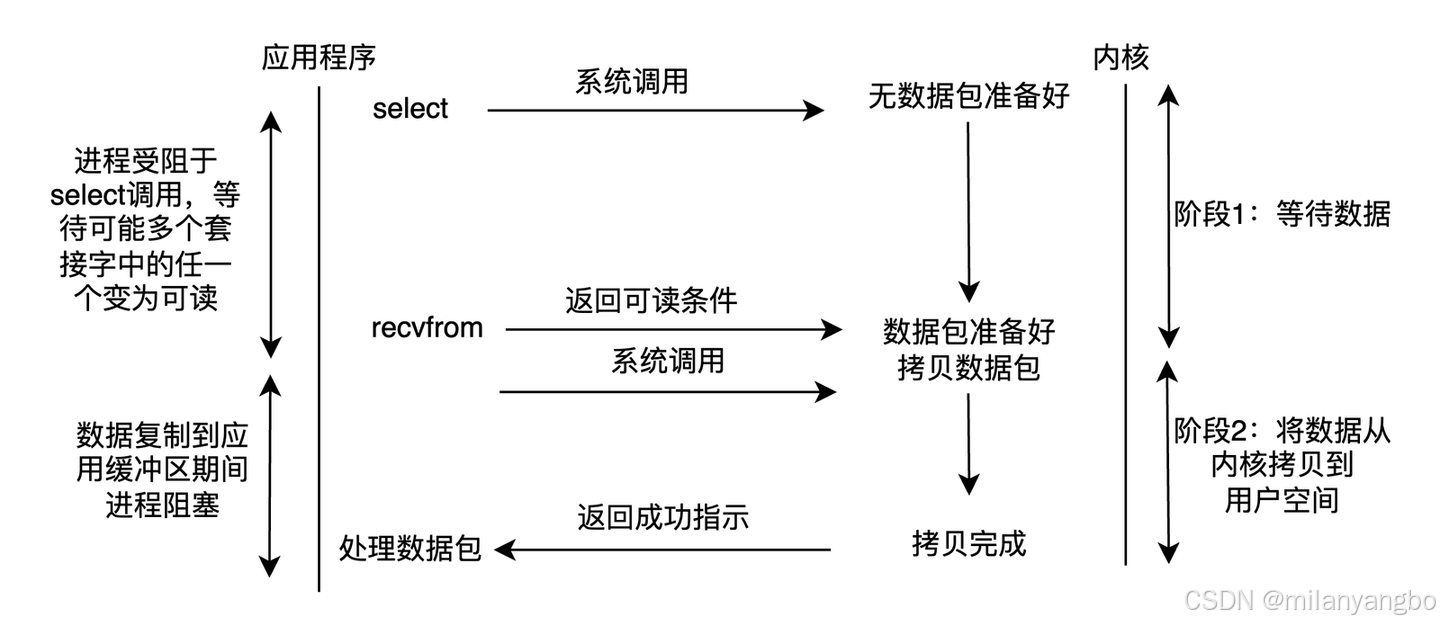

I/O多路複用則提供了一種優雅的解決方案:應用程序將監視任務委託給內核,然後阻塞在專門的事件等待調用上(如select, epoll_wait)。只有當一個或多個文件描述符就緒時,內核才會喚醒線程,使其僅對活躍的I/O進行處理。這是一種從“主動輪詢”到“被動通知”的轉變,極大地提升了系統效率。

I/O多路複用技術本身也經歷了一場深刻的演進,從select、poll到epoll,其效率和設計哲學不斷完善。作為早期的POSIX標準,select和poll引入了核心理念,但存在固有的性能缺陷。它們要求應用程序在每次調用時,都將整個待監視的文件描述符集合從用户空間完整地拷貝到內核空間,操作完成後再拷貝回來。更關鍵的是,內核需要以O(n)的線性複雜度遍歷所有文件描述符來檢查其狀態,這意味着隨着連接數的增長,系統開銷會顯著增加。此外,select還受限於FD_SETSIZE(通常為1024)的硬性數量限制,而poll雖解除了此限制,但並未改變其低效的內核掃描和數據拷貝機制。

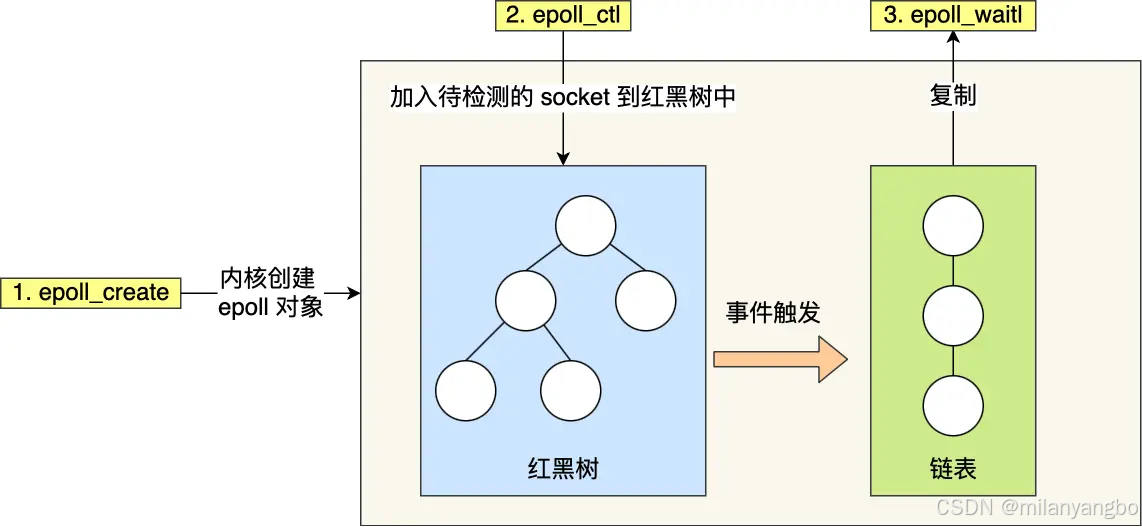

真正的技術飛躍在Linux平台上以epoll的形式出現。epoll徹底重構了接口和內核實現,它通過epoll_create在內核中建立一個持久化的事件中心,應用程序只需通過epoll_ctl將文件描述符註冊一次,後續便無需重複提交。其內部採用紅黑樹來高效管理文件描述符,並利用設備驅動的回調機制,在I/O就緒時主動將FD添加到一個“就緒隊列”中。

因此,當應用程序調用epoll_wait時,內核只需返回這個就緒隊列的內容,其時間複雜度為O(k)(k為活躍連接數),與被監視的文件描述符總數無關。這種設計不僅避免了無謂的數據拷貝,更將內核的查找效率提升到了極致。

此外,epoll還提供了水平觸發(Level-Triggered, LT)和邊緣觸發(Edge-Triggered, ET)兩種工作模式。LT模式是默認選項,只要緩衝區中存在數據,每次調用epoll_wait都會觸發通知,編程模型更簡單、容錯性高。而ET模式則僅在FD狀態發生變化(如數據從無到有)時通知一次,它要求應用程序必須一次性處理完所有數據,雖然編程複雜度更高,但能有效減少系統調用的次數。

從本質上看,I/O多路複用仍屬於同步I/O,因為應用程序在調用epoll_wait時是阻塞的。但它的阻塞點是高效的事件等待,而非低效的I/O操作。

這種模型天然地催生了事件循環(Event Loop)這一經典併發模式。一個或少數幾個事件循環線程負責等待I/O事件,並將就緒的任務分發給工作者線程池(Worker Threads)處理,實現了I/O操作與業務邏輯的解耦。這種流水線式的處理方式,可以充分利用多核處理器,進一步提升系統吞吐量。

以下偽代碼展示了基於epoll的事件循環流程:

// 偽代碼: I/O多路複用 (epoll)

epoll_fd = epoll_create();

// 1. 創建epoll實例

epoll_fd = epoll_create();

// 2. 註冊關心的文件描述符和事件

epoll_ctl(epoll_fd, ADD, socket1, READ_EVENT);

epoll_ctl(epoll_fd, ADD, socket2, READ_EVENT);

// 3. 進入事件循環

while (true) {

// 阻塞等待,直到有事件發生,僅返回就緒的事件列表

ready_events = epoll_wait(epoll_fd);

// 4. 處理所有就緒的事件

for (event in ready_events) {

if (event.is_readable()) {

data = read(event.fd); // 此處read通常不會阻塞

process(data); // 交給業務邏輯處理

}

}

}

未完待續

很高興與你相遇!如果你喜歡本文內容,記得關注哦