世界模型旨在理解、模擬與預測複雜的現實世界環境,是人工智能在真實場景中實現有效應用的重要基礎。在這一框架中,視頻生成模型通過其生成過程,逐步壓縮並學習幾何、語義、物理等多種知識形態,因而被視為構建世界模型的一條關鍵路徑,並有望最終實現對真實物理世界動態的有效模擬與預測。 而在視頻生成領域,實現高效的長視頻生成能力尤為重要。

基於此,美團開源了最新視頻生成模型 LongCat-Video,該模型旨在通過統一的架構處理多種視頻生成任務,包括文生視頻(Text-to-Video)、圖生視頻(Image-to-Video)以及視頻續寫(Video-Continuation)。 憑藉其在通用視頻生成任務中的出色表現,LongCat-Video 被研究團隊視作向構建真正「世界模型」邁出的堅實一步。

LongCat-Video 的主要特點包括:

多任務統一架構。 LongCat-Video 將文生視頻、圖生視頻和視頻續寫任務統一在一個視頻生成框架內,通過條件幀的數量來加以區分;

長視頻生成能力。 LongCat-Video 基於視頻續寫任務進行預訓練,使其能夠生成長達數分鐘的視頻,並在生成過程中有效避免顏色失真或其他形式的畫面質量退化;

高效推理。 LongCat-Video 採用「由粗到細」的策略,在幾分鐘內生成 720p、30fps 視頻,有效提升了視頻生成精度和效率;

多獎勵強化學習框架(RLHF)的強大性能。 LongCat-Video 採用組相對策略優化(GRPO),通過使用多個獎勵進一步提升模型性能,實現了與領先的開源視頻生成模型以及最新的商業解決方案相當的性能。

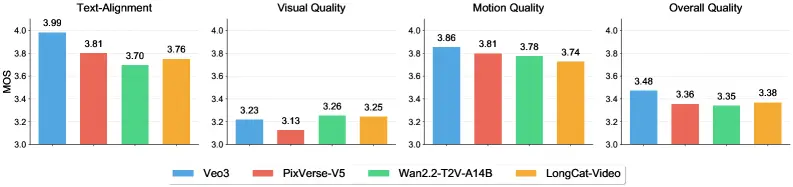

基於內部基準的性能評估,LongCat-Video 在文生視頻任務中,在視覺質量和動作質量方面表現出色,其得分幾乎與頂尖模型 Wan2.2 持平。 在文本對齊、整體質量上,該模型也取得了穩健結果,為用户提供了多維度一致的高質量體驗。

基於內部基準測試的文生視頻 MOS 評估結果

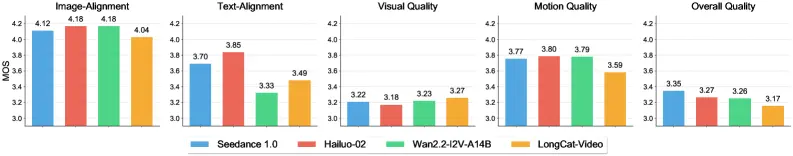

在圖生視頻任務中,LongCat-Video 在視覺質量上值得關注,得分領先 Wan2.2 等其他模型,表明其在生成畫面質量方面的突出優勢。在圖像對齊、整體質量等方面,則仍有改進空間。

基於內部基準測試的圖生視頻 MOS 的評估結果

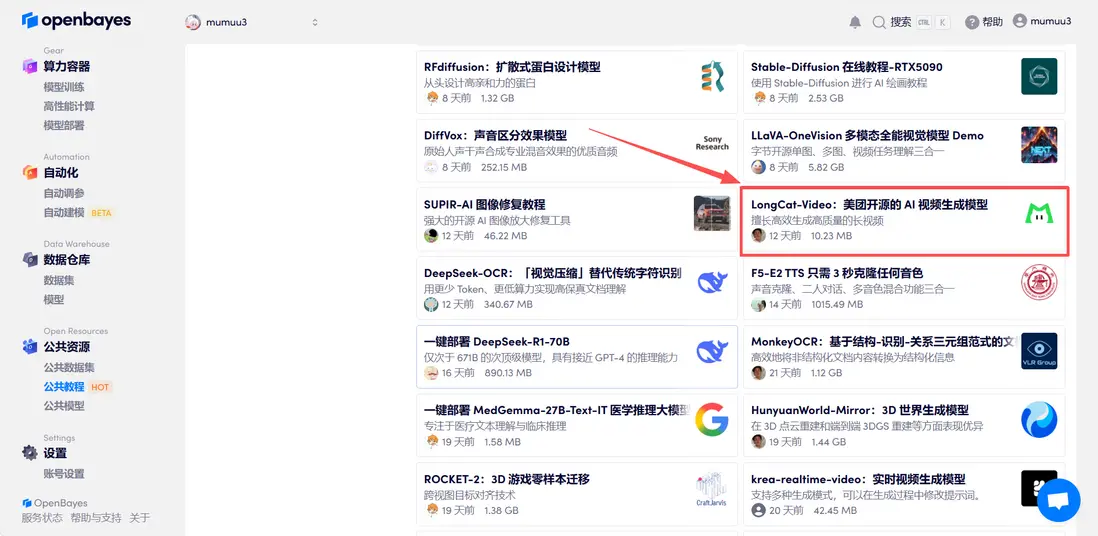

目前,「LongCat-Video:美團開源的 AI 視頻生成模型」已上線 OpenBayes 公共教程板塊,點擊下方鏈接即可體驗一鍵部署教程 ⬇️

教程鏈接:

https://go.openbayes.com/SbubB

Demo 運行

01 Demo 運行階段

1.登錄 OpenBayes,在「公共教程」頁面,選擇「LongCat-Video:美團開源的 AI 視頻生成模型」教程。

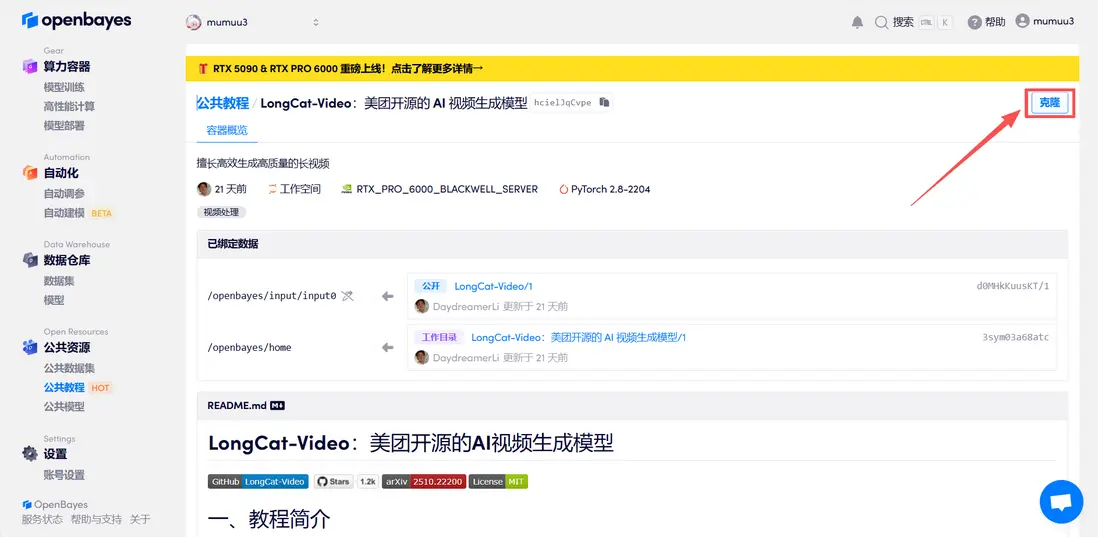

2.頁面跳轉後,點擊右上角「克隆」,將該教程克隆至自己的容器中。

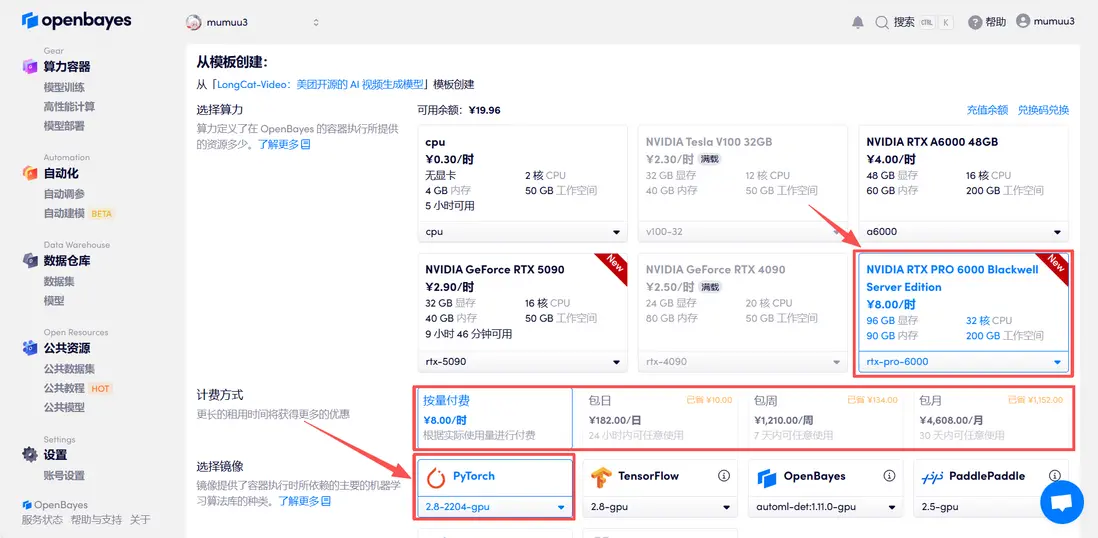

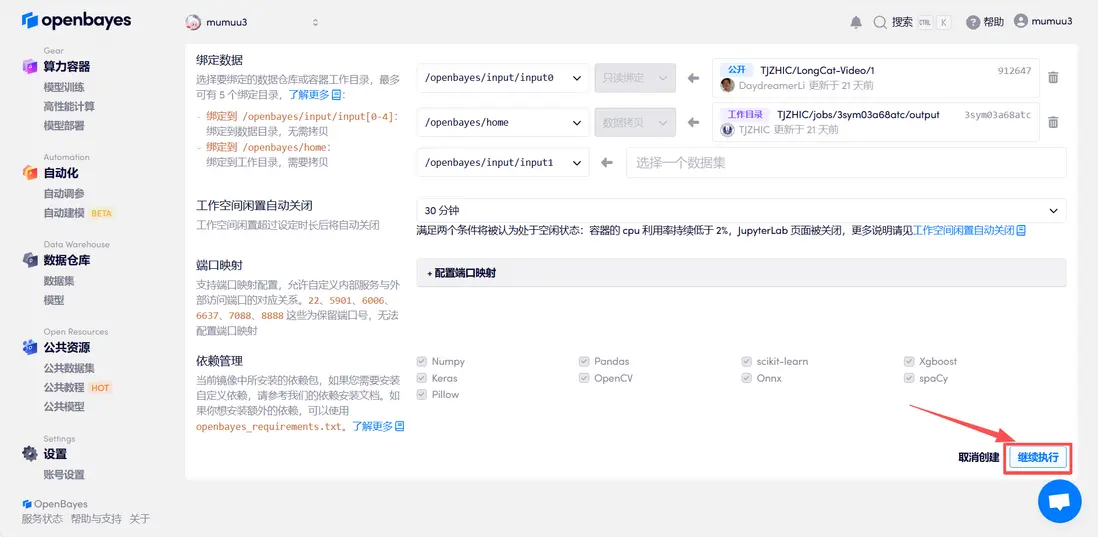

3.選擇「NVIDIA RTX PRO 6000 Blackwell Server Edition」以及「PyTorch」鏡像,按照需求選擇「按量付費」或「包日/周/月」,點擊「繼續執行」。新用户使用下方邀請鏈接註冊,可獲得 4 小時 RTX 5090 + 5 小時 CPU 的免費時長!

小貝總專屬邀請鏈接(直接複製到瀏覽器打開):

https://go.openbayes.com/9S6Dr

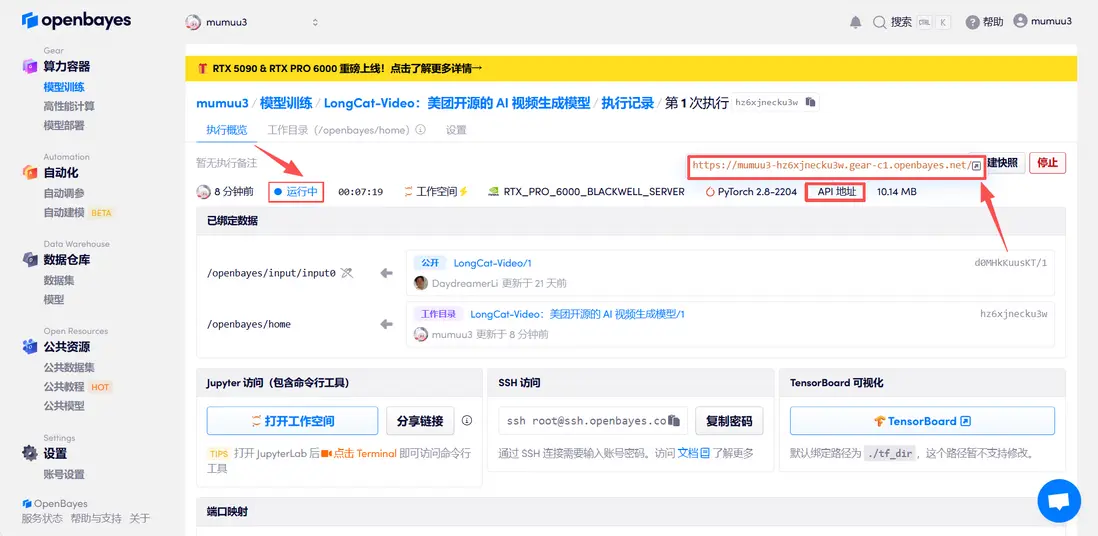

4.等待分配資源,首次克隆需等待 3 分鐘左右的時間。當狀態變為「運行中」後,點擊「API 地址」旁邊的跳轉箭頭,即可跳轉至 Demo 頁面。請注意,用户需在實名認證後才能使用 API 地址訪問功能。

02 效果演示

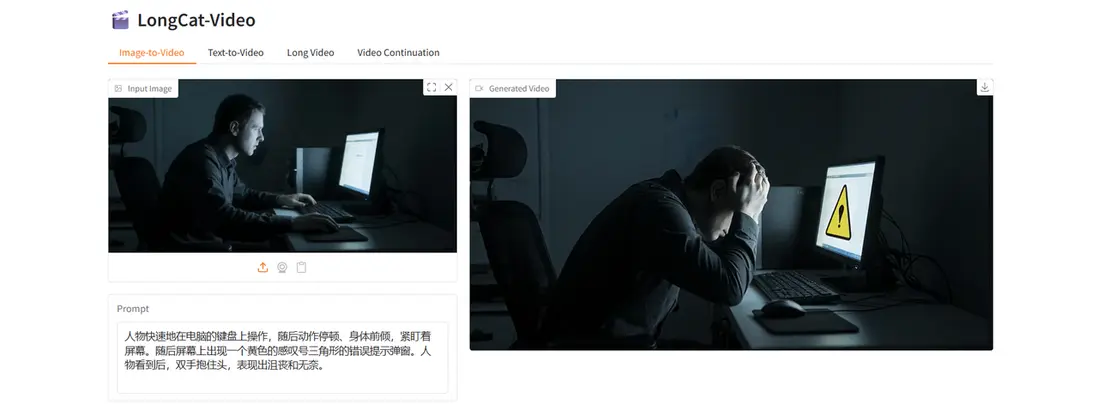

進入 Demo 運行界面後,可以選擇 Image-to-Video、Text-to-Video、Long Video 和 Video Continuation 四個示例進行測試。本文選擇 Image-to-Video 圖生視頻進行示例。

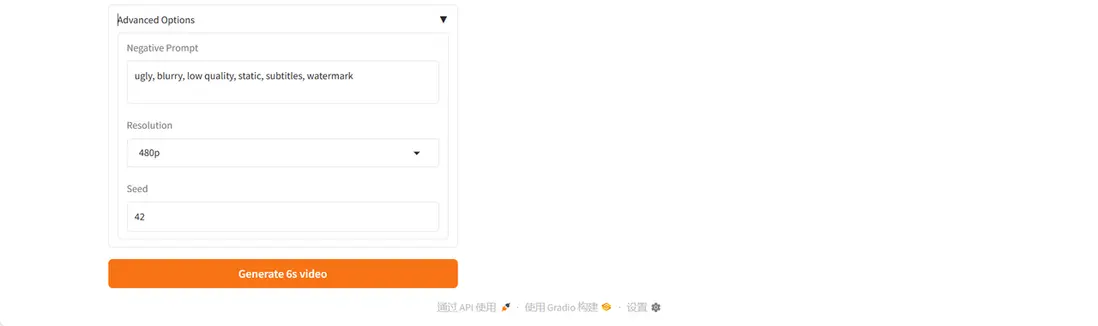

將示例圖片上傳後,輸入 Prompt,在「Advanced Options」中可以對生成視頻的負面提示詞、分辨率、生成過程的隨機性起點等參數進行更多設置,以實現更理想的生成效果。