端智能,是指在移動端設備運行人工智能(AI)應用的技術。本文主要講述大眾點評搜索場景下,在端側部署大規模深度學習模型進行搜索重排序任務的實踐方案,包括端上特徵工程、模型迭代思路,以及具體部署優化的過程,希望能對從事相關領域開發的同學有所幫助或者啓發。

1 引言

隨着大數據、人工智能等信息技術的快速發展,雲計算已經無法滿足特定場景對數據隱私、高實時性的要求。借鑑邊緣計算的思想,在終端部署 AI 能力逐漸步入大眾的視野,“端智能”的概念應運而生。相比於傳統的雲計算,在智能手機等終端部署運行 AI 模塊有以下幾個方面的優勢:首先,數據本地化可以緩解雲存儲的壓力,也有利於用户數據的隱私保護;其次,計算的本地化可以緩解雲計算過載問題;最後,端智能減少了和雲端系統的請求通信成本,可以更好地利用用户在端上的交互,提供更加實時、個性化的服務體驗。

在端智能的應用方面,國內外各大科技公司已經走在了前列。Google 提出了 Recommendation Android App 的概念,根據用户興趣進行內容推薦;Apple 的 Face ID 識別、Siri 智能助手等一些我們熟知的產品,也都是端智能典型的應用代表。阿里巴巴、快手、字節跳動等企業也在各自的應用場景上進行了端智能的落地,並推出相應的端上模型推理框架。比如,快手上線的短視頻特效拍攝、智能識物等功能。另外,在搜索推薦場景下也有一些實踐,其中,手機淘寶“猜你喜歡”在端上部署了智能推薦系統,取得較為顯著收益(EdgeRec[1],雙十一 IPV 提升 10%+,GMV 提升 5%+)。快手上下滑推薦場景也應用了端上重排的方案,並取得App時長提升了 1%+ 的效果。

搜索是大眾點評 App 連接用户與商家的重要渠道,越來越多的用户在不同場景下都會通過搜索來獲取自己想要的服務。理解用户的搜索意圖,將用户最想要結果排在靠前的位置,是搜索引擎最核心的步驟。為了進一步優化搜索個性化的排序能力,提升用户體驗,搜索技術中心進行了在端上部署深度個性化模型的探索實踐。本文主要介紹了端智能重排在大眾點評 App 上的實踐經驗,文章主要分為以下三個部分:第一部分主要分析端智能重排要解決的問題和整體流程;第二部分會介紹端上重排序算法部分的探索實踐過程;第三部分將介紹端上重排系統的架構設計以及部署優化,最後是總結與展望。

2 排序系統進階:為什麼需要端上重排

2.1 雲端排序痛點

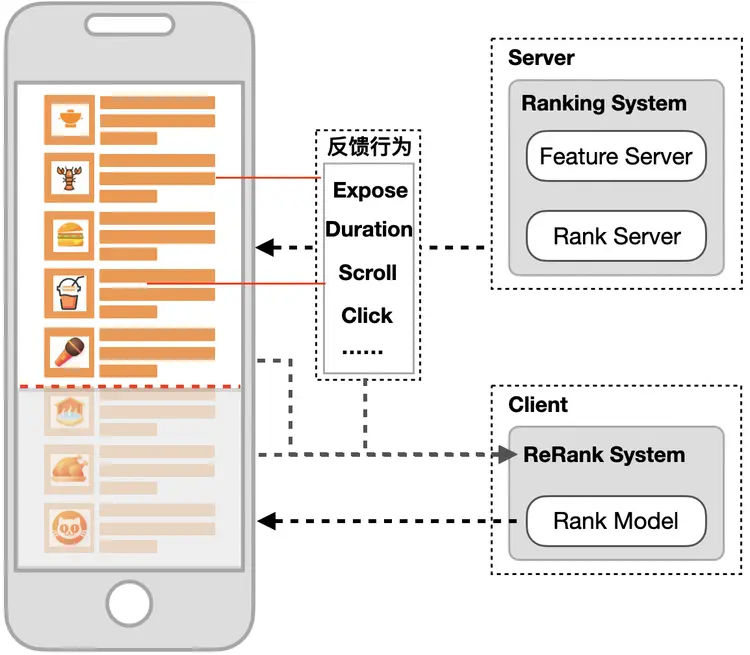

我們以一次完整的搜索行為,來看一下整個前後端執行的過程。如圖 1 所示,用户在手機端搜索入口發起檢索請求後,觸發雲端服務器執行,包括查詢理解、多路召回、模型排序與展示信息合併等處理,最終返回給客户端進行渲染呈現給用户。

由於整個系統的每秒查詢數(QPS)的限制,以及前後端請求通信、傳輸包體影響,通常會採用分頁請求機制。這種客户端分頁請求,雲端服務檢索排序返回給用户最終展示列表的 Client-Server 架構,對於大眾點評 LBS 場景、類推薦的搜索產品來説,存在以下兩個問題:

① 列表結果排序更新延遲

分頁請求限制會導致排序結果的更新不及時。在下一個分頁請求之前,用户的任何行為都無法對當前頁內的搜索排序結果產生任何影響。以大眾點評搜索結果頁為例,一次請求返回 25 個結果到客户端,每屏展示約 3~4 個,那麼用户需要滑動 6~8 屏左右,才能觸發新的分頁請求到雲端獲取下一頁結果(以美食頻道列表頁為例,有 20% 以上的搜索瀏覽超過一頁結果)。雲端的排序系統無法及時感知用户的興趣變化,並調整已下發到客户端的結果順序。

② 實時反饋信號感知延遲

一般來説,實時反饋信號會通過 Storm、Flink 等流處理平台,將日誌流以 Mini-batch 的方式計算後,存入 KV 特徵數據庫供搜索系統模型使用。這種方式往往會有分鐘級的特徵延遲,因為需要對反饋數據進行解析處理,當涉及到更多、更復雜的反饋數據時,這種延遲表現會更加明顯。而實時反饋反映着用户的實時偏好,對於搜索排序的優化有着十分重要的意義。

2.2 端智能重排流程和優勢

為了解決分頁結果排序調整決策延遲,更及時地建模用户實時的興趣偏好變化,我們在端上建設了重排序的系統架構,使得客户端具備深度模型推理能力,該方案具有以下幾個方面的優勢:

- 支持頁內重排,對用户反饋作出實時決策:不再受限於雲端的分頁請求更新機制,具備進行本地重排、智能刷新等實時決策的功能。

- 無延時感知用户實時偏好:無需通過雲端的計算平台處理,不存在反饋信號感知延遲問題。

- 更好的保護用户隱私:大數據時代數據隱私問題越來越受到用户的關注,大眾點評 App 也在積極響應監管部門在個人信息保護方面的執行條例,升級個人隱私保護功能,在端上排序可以做到相關數據存放在客户端,更好地保護用户的隱私。

端智能重排在大眾點評搜索和美食頻道頁上線後,均取得顯著效果,其中搜索流量點擊率提升了 25BP(基點),美食頻道頁點擊率提升了 43BP,Query平均點擊數提升 0.29%。

3 端上重排序算法探索與實踐

重排序任務在搜索、推薦領域已有不少研究工作和落地實踐,核心解決的問題是從 N 個結果候選中,生成 Top-K 個結果的排列。具體到端上的重排序場景,我們要做的主要工作是:根據用户對前面排序結果的反饋行為,生成候選商户上下文的排列,使得列表頁整體的搜索點擊率達到最優。下面將詳細介紹,針對端上重排序場景,我們在特徵工程、實時反饋序列建模以及模型結構做的一些探索與實踐。

3.1 特徵工程

在端上建設特徵工程的思路和雲端搜索排序系統基本一致,User/Item/Query/Contextual 各個維度的基礎、交叉特徵可以快速複用到端上,當然需要考慮傳輸和存儲優化,以及端、雲特徵系統的一致性,做到端雲“無感”的開發部署,這部分內容會在後面架構&部署優化章節詳細介紹。除此以外,還有一部分端上特色的用户實時反饋信號,包括更多細粒度的交互行為等,這些特徵也是前文所分析的端上實時反饋決策優勢的關鍵信號。

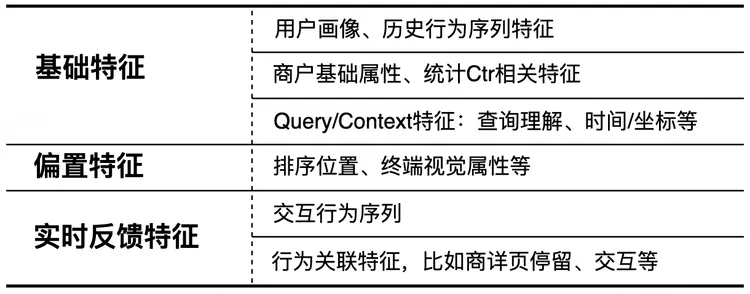

具體來説,在端上建設的重排模型特徵體系如表 1 所示,主要包括以下幾個方面:

- 基礎特徵,典型的用户/商户/Query/Context 側特徵,以及雙側的交叉特徵等。

- 偏置特徵,主要包括後端返回的排序位置,終端設備上存在的一些大小等視覺上的偏置。

-

用户的實時反饋特徵,這部分是整個端上重排特徵體系的重要組成部分,包括:

- 用户直接的交互行為序列(曝光、點擊等)。

- 行為關聯特徵,比如點擊進入商户詳情頁內的停留、交互等相關行為。

3.2 用户反饋行為序列建模

對於用户反饋序列的建模,業界有非常多的算法方案,比如我們所熟知的 DIN(Deep Interest Network[10])、DIEN(Deep Interest Evolved Network[11])以及基於 Transformer 的 BST(Behavior Sequence Transformer[12])等等。端上排序場景裏,對於用户反饋行為序列的應用會很大程度影響到算法的效果。因此,我們也在這個方面進行了一些探索。

引入深度反饋網絡

在雲端的精排模型優化工作中,我們一般只考慮用户和商户顯式的“正反饋”行為(包括點擊、下單等),隱式的曝光未點擊“負反饋”信號則少有引入,因為長短期的歷史行為中,此類曝光未點擊行為非常多,相比於點擊信號噪音很大。對於端上來説,這種實時的曝光“負反饋”信號也很重要。比如,對於同一品牌的某類商户實時多次曝光後,該品牌商户的點擊率會呈明顯的下降趨勢。

由於實時反饋序列中曝光未點擊的隱式負反饋信號佔了較大的比例,作為一個整體序列進行建模,對稀疏的正反饋信號存在較大的主導影響。阿里巴巴在淘寶首頁信息流推薦場景下也提出了一種基於對抗的方式,來挖掘曝光、點擊行為序列之間的聯繫,從而尋找當前曝光序列當中有哪些行為是真正的負反饋,而哪些行為與點擊有更相近的關係。微信團隊提出了深度反饋網絡 DFN[4],通過引入正負反饋信號的交互作用關係,進行一定程度的去噪、糾偏。

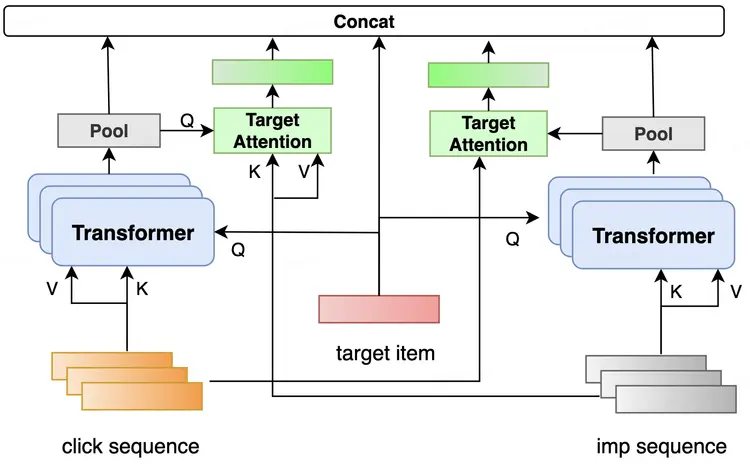

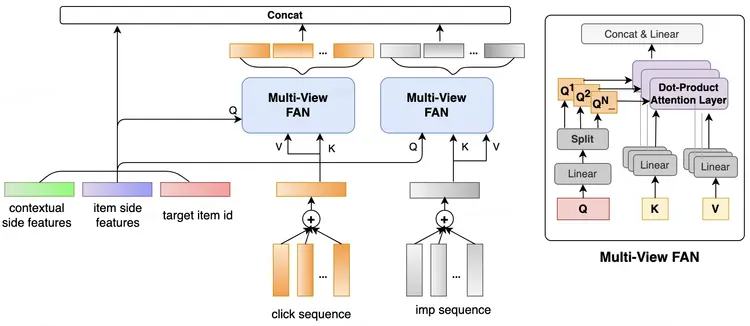

首先,基於 DFN 的優化思路,我們對反饋序列進行拆分,生成正負反饋序列,利用 Transformer 進行正負反饋信號的 Cross Attention 交互作用。具體來説,以曝光序列和點擊序列為例,曝光行為序列作為 Query,點擊行為序列作為 Key 和 Value,得到曝光行為序列對點擊行為序列的 Attention 結果。同理,再調換一下得到點擊行為序列對曝光行為序列的 Attention 結果。考慮到正反饋信號的稀疏性,當僅有負反饋序列時,會計算得到一些平均的無關噪音權重。因此,我們參考[7]的做法,在負反饋序列中引入全零的向量,來消除這種潛在的噪音。具體模型結構如下圖 4 所示:

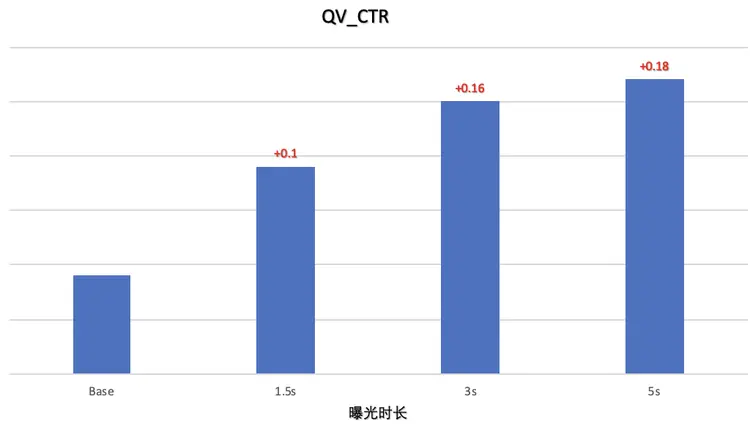

提升負反饋信號的信噪比

初版模型在美食頻道列表頁上線後,相比 Base 取得 0.1% 的穩定提升,但是和離線的收益對比還有一些差距,不太符合我們的預期。經過消融實驗分析發現,主要原因是負反饋信號中存在大量噪音,而噪音產生的根源是因為部分曝光商户的點擊行為可能發生在特徵收集的時刻之後。因此,為了提高負反饋信號的信噪比,我們對於負反饋信號的曝光時間進行了限制,長時間曝光但未點擊的商户更有可能是真實負反饋信號。如下圖 5 所示,更長的停留可以關聯到更穩定的反饋信號,線上效果更優。

多視角的正負反饋序列交叉建模

在初版正負反饋序列模型的基礎上繼續迭代,我們關注到在調整 Transformer 中 Multi-Head 的數目時,並沒有預期的增量收益,相比僅使用一個 Head 指標無明顯變化。經過分析,我們懷疑這種通過隨機初始化的生成的多頭表徵,很大程度上只是單純參數量上的擴充。

另外,在大眾點評搜索場景下,同 Query 下商户列表整體的相關度比較高,尤其對頁內的結果來説,同質度更高。差異性主要體現在比如價格、距離、環境、口味等細粒度的表徵上面。因此,我們設計了一種多視角的正負反饋序列交叉建模方式 Multi-View FeedBack Attention Network (MVFAN),來強化曝光、點擊行為在這些感知度更高的維度上的交互作用。具體網絡結構如下圖 6 所示:

用户行為序列按反饋類型切分為點擊正反饋和曝光未點負反饋,序列除了 shopid 本身,還補充了更多泛化的屬性信息(包括類目、價格等),以及上下文相關的特徵(比如經緯度、距離)。這些序列 Embedding 後疊加,形成最終正負反饋序列的表徵。接下來會使用多級的 Transformer 進行編碼,輸入多個維度的信號去解碼,激活用户在不同商户維度上的偏好:

- 使用待排商户ID作為Q,對實時反饋行為進行激活,表達用户隱形的多樣性興趣。

- 使用商户更多表現粒度的屬性信息作為Q,激活得到注意力權重,提升用户在這些更顯式感知的商户表徵上的興趣表達。

- 使用當前搜索上下文相關的信號作為Q,激活得到注意力權重,增強實時反饋行為對於不同上下文環境的自適應地表達。

$Q = [x_s, x_c, ..., x_d] \in \Re^{K\times d_{model}}$,$K = V = x_s \oplus x_c \oplus ... \oplus x_d$ 表示各種反饋序列(shop_id/category/distance/position等)相加,作為 Transformer 的輸入,Multi-View 的注意力結構可以由以下公式表示:

$$MultiHead(Q, K, V) = Concat(head_1, head_2, ..., head_h) W^O$$$$head_i = Attention(Q_iW^{Q_i}, KW_i^K, VW_i^V)$$$$Attention(Q_i, K, V) = softmax(\frac{Q_iK^T}{\sqrt{d_k}})V$$

通過消融對比實驗發現,相比於隨機初始化的 Multi-Head Attention,這種顯式使用多種商户上下文特徵的 Transformer 激活方式效果更顯著。

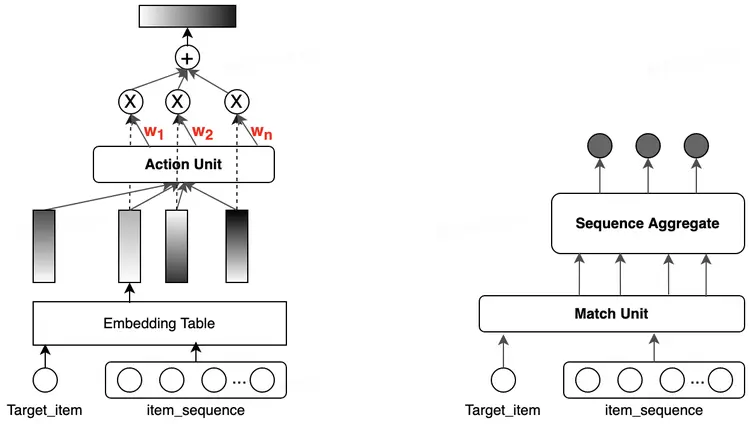

Match&Aggregate 序列特徵

對於端上的用户實時反饋特徵,除了各種常用的基於 Attention 的序列建模方式,還有一種採用顯式交叉的興趣提取方式。如圖 7 所示,相比於一般基於 Embedding 內積計算“Soft”權重的 Attention 建模,它可以理解為一種“Hard”的 Attention 方式,提取的形式包括:Hit(是否命中)、Frequency(命中多少次)、Step(間隔多久)等等,除了單變量序列的交叉,還可以組合多個變量進行交叉,來提升行為描述的粒度和區分度。

這種基於先驗知識引入的反饋序列交叉特徵,可以一定程度上避免“Soft” Attention 方式引入的一些噪音信息,同時也具有更好的可解釋性。比如,用户在搜索“火鍋”時,沒有選擇附近的商户,而點擊了常住地附近的歷史偏好商户,這種場景下存在明顯的信號説明用户提前決策的意圖。這時,加入一些顯式的強交叉特徵(例如,待排商户距實時點擊商户的距離等)就能非常好的捕捉這種意圖,從而把距離遠但和用户意圖更匹配的相關商户排上來。在大眾點評搜索的場景下,我們基於該方式引入了大量的先驗交叉特徵,也取得了較為顯著的效果。

3.3 重排模型設計

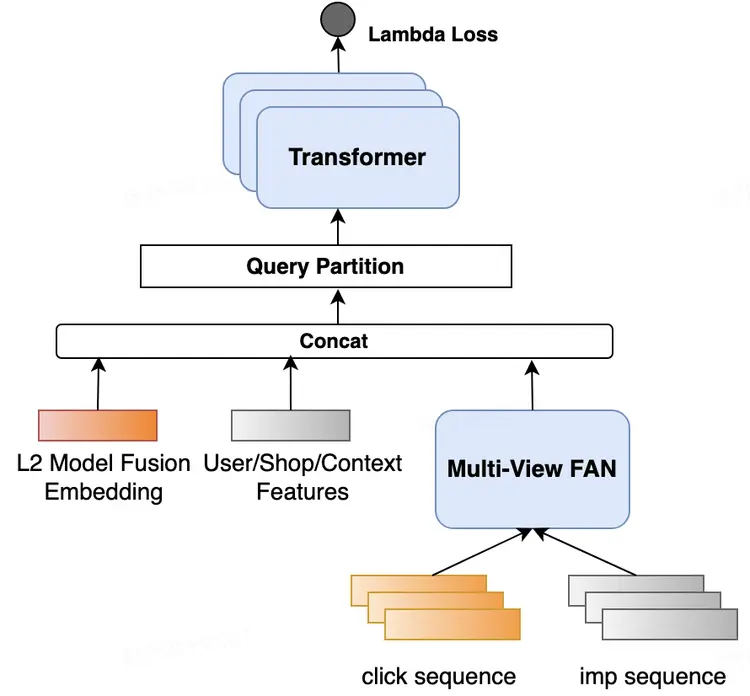

關於重排序的研究,目前業界也有不少相關的工作,包括:基於貪心策略優化多目標的 MMR(Maximal Marginal Relevance) [8],直接建模上下文作用關係的 Context-aware List-wise Model[2,3] 以及基於強化學習的方案[9]等。在搜索端智能重排場景上,我們採用了基於 Context-aware List-wise 的模型進行構建,通過建模精排模型生成的 Top-N 個物品上下文之間的互相影響關係,來生成 Top-K 結果。整體模型結構如下圖 8 所示,主要包括端雲聯動的訓練方案,以此來引入更多雲端的交互表徵;以及基於 Transformer 的上下文關係建模,下面將分別進行介紹。

端雲聯合訓練

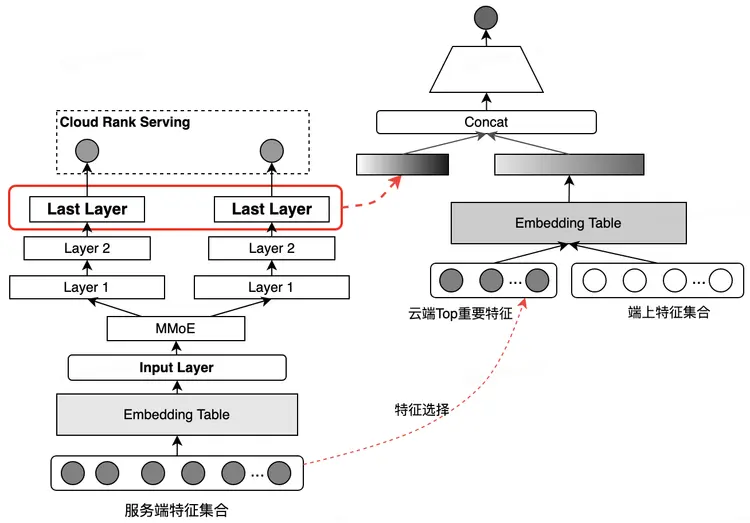

一般來説,雲端的重排序模型基本都複用精排層的特徵,並在此基礎上加入精排輸出的位置或者模型分。大眾點評搜索精排模型經過長期的迭代更新,已經建設了大量的基礎、場景相關特徵,以及建模了包括點擊、訪購等多個聯合目標,這些大規模維度的特徵和多目標優化在端上直接複用存在巨大的計算開銷、存儲&傳輸壓力。而僅使用雲端模型位置或者預估分輸出,則不可避免的會損失掉很多端雲特徵的交叉表達能力。同時,對於到端雲兩側的模型迭代、更新,還會存在較大的維護成本。

因此,我們採用端雲聯合訓練的方式把大量的雲端特徵交叉信號,以及多目標高階表徵引入到端上使用。如圖 9 所示,雲端的模型訓練收斂後,加入到端上重排任務繼續 Fine-tune 更新。需要注意的是:

- 因為搜索精排層使用的是 ListWise 的 LambdaLoss,模型輸出的預估分僅有相對的大小意思,不能表示商户的點擊率預估範圍,無法進行全局的絕對值使用。故僅採用網絡的最後一層輸出接入。

- 僅接入最後一層的 Dense 輸出,大大損失了雲端特徵與端上特徵的交叉能力,因此,需要通過特徵選擇方式,選取頭部特徵加入到雲端進行使用。

重排商户上下文建模

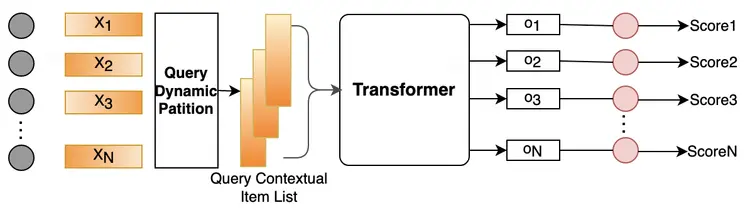

商户上下文重排建模結構參考 PRM[3],結合端上應用場景做了一些調整,具體結構如下圖 10 所示:

主要由以下幾個部分構成:

- 商户特徵向量 X :由前文所述的各方面特徵(User/Shop 單、雙側統計交叉特徵、反饋序列編碼特徵,以及雲端融合輸出的特徵)經過全連接映射後的輸出進行表示。該輸出已包含位置信息,所以後續的 Transformer 輸入不需要再增加位置編碼。

- 輸入層需要進過 Query Dynamic Partition 處理,切分為每個 Query 單元的上下文商户序列,再輸入到 Transformer 層進行編碼。

- Transformer 編碼層:通過 Multi-Head Self-Attention 編碼商户上下文關係。

優化目標

在搜索場景下,我們關注的還是用户搜索的成功率(有沒有發生點擊行為),不同於推薦、廣告場景往往基於全局性損失預估 item 的點擊率,搜索業務更關心排在頁面頭部結果的好壞,靠前位置排序需要優先考慮。因此,在重排提升用户搜索點擊率目標的建模中,我們採用了 ListWise 的 LambdaLoss,梯度更新中引入 DeltaNDCG 值來強化頭部位置的影響。詳細推論和計算實現過程參見大眾點評搜索基於知識圖譜的深度學習排序實踐。

$$C = \frac{1}{2}(1 - S{ij})\sigma(s_i - s_j) + log(1 + e^{-\sigma (s_i-s_j)})$$

$$\lambda_{ij} = \frac{\partial C(s_i - s_j)}{\partial s_i} = \frac{-\sigma}{1 + e^{\sigma (s_i-s_j)}}| \Delta _{NDCG}|$$

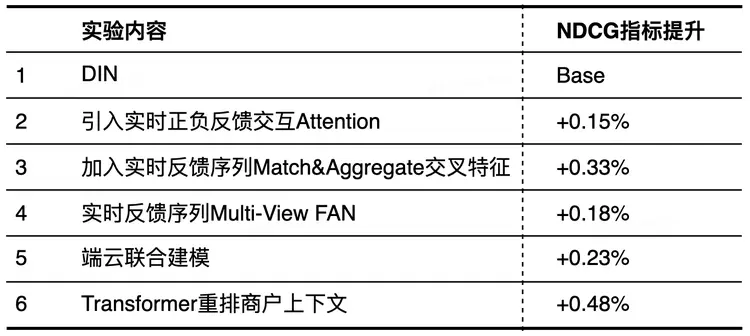

3.4 多場景應用效果

綜合上述特徵&模型優化舉措,相關的離線實驗指標效果對比如表 2 所示:

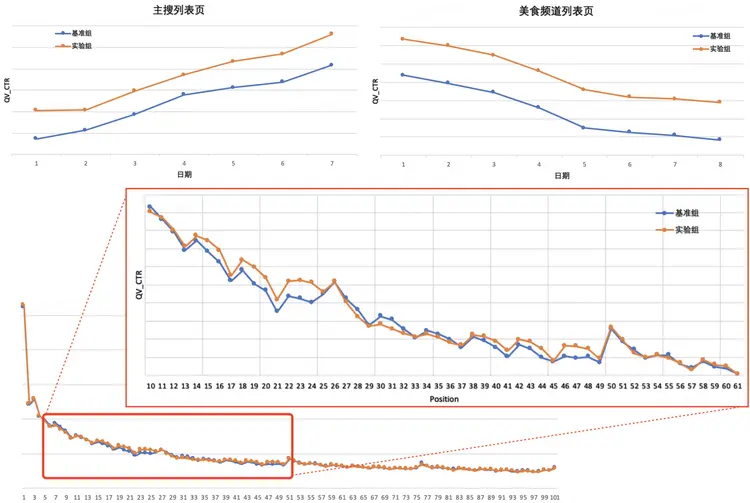

端智能重排序在點評主搜和美食頻道列表頁上線 AB 實驗,核心業務指標 QV_CTR 均在高位基礎上取得顯著提升。如圖 11 所示,上半部分,主搜列表頁 QV_CTR 提升 0.25%,美食頻道列表頁 QV_CTR 提升 0.43%,分端表現穩定正向。另外,從下半部分分位置的點擊率對比曲線,可以看出,端上重排能夠一定程度上緩解固定分頁請求的點擊衰減效果,尤其在靠後的幾屏展示上都有比較顯著的提升。

4 系統架構與部署優化

不同於雲端的大規模深度模型上線,幾百 GB,甚至上 T 的模型都可以通過擴充機器分片加載的分佈式方案部署使用。終端設備的計算和存儲能力雖然有了顯著提升,可以支持一定規模的深度模型進行推理,但相對來説,端上的存儲資源是非常受限的,畢竟 App 整體的大小最多不過幾百 MB。

因此,除了前面提到的在特徵選擇、觸發決策控制上對效果與性能進行權衡外,我們還在模型部署、壓縮上做了進一步優化,並對能耗等各方面指標進行詳細的評估。另外,為了更高效地迭代端上的模型,包括進一步挖掘用户實時的興趣偏好特徵,自研了一套和雲端系統流程一致的“端無感”模型訓練、預估框架,下面會逐步展開介紹。

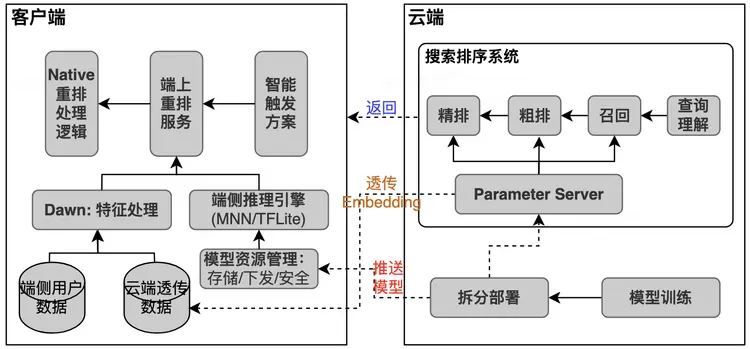

4.1 系統架構

整體的端智能重排系統架構,包括和雲端的搜索排序系統聯合部署方案如圖 12 所示。具體來説,主要有以下三大模塊來支持端上重排系統的實現:

- 智能觸發方案模塊,針對業務設計的各類觸發事件,執行端上智能模塊的調度。例如,用户點擊商户行為觸發執行本地重排。

-

端上重排服務模塊,執行構建特徵數據,並調用端側推理引擎運行重排模型,進行打分輸出。其中:

- 特徵處理部分,是搜索技術中心針對搜/推/廣算法場景,專項設計的一套方便算法使用的通用特徵算子處理服務。支持對客户端、雲端的各種類型數據,使用輕量、簡便的表達式構建特徵。

- 端側推理引擎部分,是終端研發中心輸出的統一模型管理框架,支持各類端上輕量級推理引擎部署,以及模型的動態下發控制等。

- Native 重排處理邏輯部分,主要進行重排輸出後的結果回插,刷新控制處理。

4.2 端上大規模深度模型部署優化

Sparse Embedding 與 Dense 網絡拆分部署

因為端上的計算資源受限,無法存儲完整的超大規模參數模型,因此,基於最直觀的思路,我們將離線訓練的模型參數拆分成了 Dense 網絡與大規模 ID 特徵的 Embedding Table 分別部署:

- 主 Dense 網絡以及一些較小的 Query/Contextual 特徵、Shop 基礎屬性特徵等輸入層結構,轉化成 MNN 格式,存儲在美團資源管理平台上,供客户端啓動時一次性拉取,存儲在客户端本地。

- 大規模的 ID 特徵 Embedding Table 部分(佔整體網絡參數量的 80%),存儲在雲端的 TF-Servering 服務中,在客户端發起搜索請求時,會從 Serving 服務中獲取當前頁商户結果所對應的 Embedding 特徵,與商户結果列表一同下返回到客户端,與客户端構建的其餘特徵一起 Concat 後,輸入到推理引擎進行打分重排。

模型壓縮

經過上一步拆分處理,模型大小可以控制在 10MB 以內,為了進一步減少模型在手機端的空間佔用,以及功耗/性能影響,我們採用了美團視覺智能部提供的壓縮方案。該方案針對現有的神經網絡模型壓縮技術沒有考慮要契合部署的端智能設備、壓縮後的模型往往不能適配特定的設備、輸出結果對齊度差等問題,設計了能更好用於移動端上部署的神經網絡壓縮工具,更好地在端上推理框架上發揮了性能。

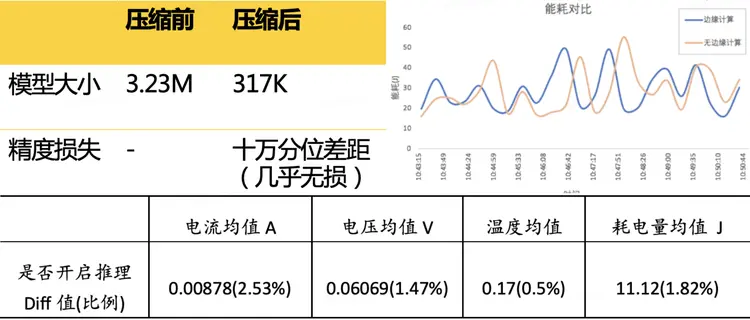

壓縮優化後從下面的測試對比數據可以看到,模型大小進一步減小到 1MB 以內,同時精度損失在十萬分位差距。採用 Sysdiagnose 進行耗電分析,開啓推理功能,重複動作:從首頁搜索“火鍋/五角場”,進入搜索列表頁進行首次重排推理,滑動列表再次計算後,退出頁面(測試時間為 10 分鐘,間隔 20 秒採用一次),相關的能耗指標均無顯著的變化。

4.3 端智能模型訓練預估平台

不同於雲端的排序算法實驗流程,已經有成熟、完善的訓練預估平台支持,特徵&模型上線非常便捷、高效。客户端的實驗流程前期存在非常大的迭代效率問題,比如模型的上線流程繁瑣,包括模型結構的分離、轉換&驗證以及發佈依賴大量的人工操作,跟多個內部平台的流轉、對接;另外特徵迭代效率低下,需要客户端協同開發相應的特徵加工邏輯,存在較大的邏輯一致性風險,而且還會存在分端的實現差異等問題。

基於此,美團的前後端工程合力推進開發、設計了一套適配客户端的 Augur 特徵處理框架,將端上的模型發佈和特徵處理與一站式實驗平台(Poker)、統一預估框架(Augur)進行打通,為進一步的算法迭代實驗奠定了良好的基礎,後續搜索技術中心團隊也會向大家介紹面向端智能算法應用的一站式模型訓練預估平台,敬請期待。

5 總結與展望

端智能重排序是大眾點評搜索在邊緣計算方向的一次探索實踐,並且在核心指標上取得了較為顯著的效果。通過利用端上計算的能力,更高效地捕捉用户的實時興趣偏好,彌補雲端服務決策延遲、用户反饋信息獲取延遲等問題。及時調整未曝光候選結果的順序,把更符合用户意圖的商户排上來,從而帶來更好的用户搜索觸達體驗。同時,我們對前後端訓練、部署預估框架進行了升級,為後續進一步快速迭代實驗奠定了良好的基礎。

大眾點評搜索技術中心團隊會持續進行端智能技術在各個業務場景中的落地,未來可以探索優化的方向還包括:

- 基於聯邦學習模式,進一步在保證數據隱私安全及合法合規的基礎上,迭代端雲聯合的智能搜索排序模型。

- 建模更精確、多樣的觸發控制策略,對於端上實時用户意圖感知的決策模塊,當前的控制策略還比較簡單。後續我們會考慮結合 Query 上下文,用户反饋信號等特徵輸出更靈活的預判信號,同時請求雲端,獲取更多符合用户當前意圖的候選結果。

- 繼續優化重排序模型,包括實時反饋序列建模算法,探索對於隱式負反饋信號更魯棒的編碼表達方式等。

- 思考端上更豐富、靈活的應用場景,比如模型的個性化定製,做到“千人千模”的極致個性化體驗。

作者簡介

祝升、劉哲、湯彪、嘉煒、凱元、楊樂、洪晨、曼曼、華林、孝峯、張弓,來自美團/大眾點評事業部/搜索技術中心。

逸然、朱敏,來自美團平台/搜索與NLP部/工程研發中心。

參考資料

[1] Yu Gong, Ziwen Jiang, et al. "EdgeRec: Recommender System on Edge in Mobile Taobao" arXiv preprint arXiv:2005.08416 (2020).

[2] Qingyao Ai, Keping Bi, et al. "Learning a Deep Listwise Context Model for Ranking Refinement" arXiv preprint arXiv:1804.05936 (2018).

[3] Changhua Pei, Yi Zhang, et al. "Personalized Re-ranking for Recommendation" arXiv preprint arXiv:1904.06813 (2019).

[4] Ruobing Xie, Cheng Ling, et al. "Deep Feedback Network for Recommendation" (IJCAI-2020).

[5] 非易、祝升等. 大眾點評搜索基於知識圖譜的深度學習排序實踐.

[6] 肖垚、家琪等. Transformer 在美團搜索排序中的實踐.

[7] Qingyao Ai, Daniel N Hill, et al. "A zero attention model for personalized product search" arXiv preprint arXiv:1908.11322 (2019).

[8] Teo CH, Nassif H, et al. "Adaptive, Personalized Diversity for Visual Discovery" (RecSys-2016).

[9] Eugene Ie, Vihan Jain, et al. "SLATEQ - A Tractable Decomposition for Reinforcement Learning with Recommendation Sets" (IJCAI-19).

[10] Zhou, Guorui, et al. "Deep interest network for click-through rate prediction." (SIGKDD-2018).

[11] Zhou, Guorui, et al. "Deep interest evolution network for click-through rate prediction." (AAAI-2019).

[12] Chen, Qiwei, et al. "Behavior Sequence Transformer for E-commerce Recommendation in Alibaba." arXiv preprint arXiv:1905.06874 (2019).

招聘信息

美團/點評事業部-搜索技術中心,致力於打造一流的搜索系統和搜索體驗,滿足大眾點評用户的多樣搜索需求,支撐各業務在大眾點評 App 上的搜索需求。歡迎感興趣的同學發送簡歷至:edp.itu.zhaopin@meituan.com。

閲讀美團技術團隊更多技術文章合集

前端 | 算法 | 後端 | 數據 | 安全 | 運維 | iOS | Android | 測試

| 在公眾號菜單欄對話框回覆【2021年貨】、【2020年貨】、【2019年貨】、【2018年貨】、【2017年貨】等關鍵詞,可查看美團技術團隊歷年技術文章合集。

| 本文系美團技術團隊出品,著作權歸屬美團。歡迎出於分享和交流等非商業目的轉載或使用本文內容,敬請註明“內容轉載自美團技術團隊”。本文未經許可,不得進行商業性轉載或者使用。任何商用行為,請發送郵件至tech@meituan.com申請授權。