我做數據這麼多年,總是會聽到:

"我快被這個月的數據搞瘋了!上週做的銷售報表,今天業務部門説數據對不上,差了好幾十萬。"

"數據一直對不上,是不是數據源有問題?"

"一堆格式不對的數據,光整理這些就花了兩天時間,結果還是出錯了。"

聽着是不是很熟?

其實説白了,這些問題都在於數據清洗沒做好。如果忽視數據清洗,就算有再精妙的計算公式和再高級的工具也是白搭,後續分析一定會出錯,決策還是不精準。

那到底要怎麼做好數據清洗呢?

下面我來給大家好好講講數據清洗,這樣你就對它有了一個整體把握,也能從中得到解決方法。

一、 我們為什麼要進行數據清洗?

你可能會想,數據拿到手,直接導入工具分析不就行了嗎?為什麼非要花費大量時間,去做清洗這種看似“枯燥”的工作呢?

簡單來説,真實世界的數據,絕大多數都是不完美,甚至是“髒”的,它們可能來自不同的業務系統,由不同的人錄入,經歷了複雜的流轉過程。

數據清洗,就是把這些原始數據變得規整、乾淨、可用的過程。

那麼,這麼做具體能帶來什麼好處呢?

- 保證分析結果的準確性:這是最核心、最根本的原因。如果基礎數據本身就是錯的,那麼無論你的模型多高級、算法多精妙,得出的結論也必然是錯誤的,甚至會引導你做出完全錯誤的決策。這背後有一個著名的原則:垃圾進,垃圾出。你想,如果你的銷售數據裏混入了測試數據,或者客户年齡出現了負值,基於這些數據制定的市場策略,怎麼可能正確呢?

- 提升數據分析的效率:乾淨、規整的數據,能被分析工具,比如Python的Pandas, SQL等更快速、更高效地處理。如果數據中存在大量缺失值、異常值或者不一致的格式,計算過程會不斷報錯、中斷,或者產生不可預知的後果,極大地拖慢你的工作進度。

- 統一數據口徑,確保一致性:不同部門、不同時期錄入的數據,標準可能完全不同。比如,性別字段,有的記錄是“男/女”,有的是“1/2”。如果不進行統一,計算機在統計時就會把它們當成三種不同的類別,結果自然是混亂的。

那我們要怎麼實現呢?

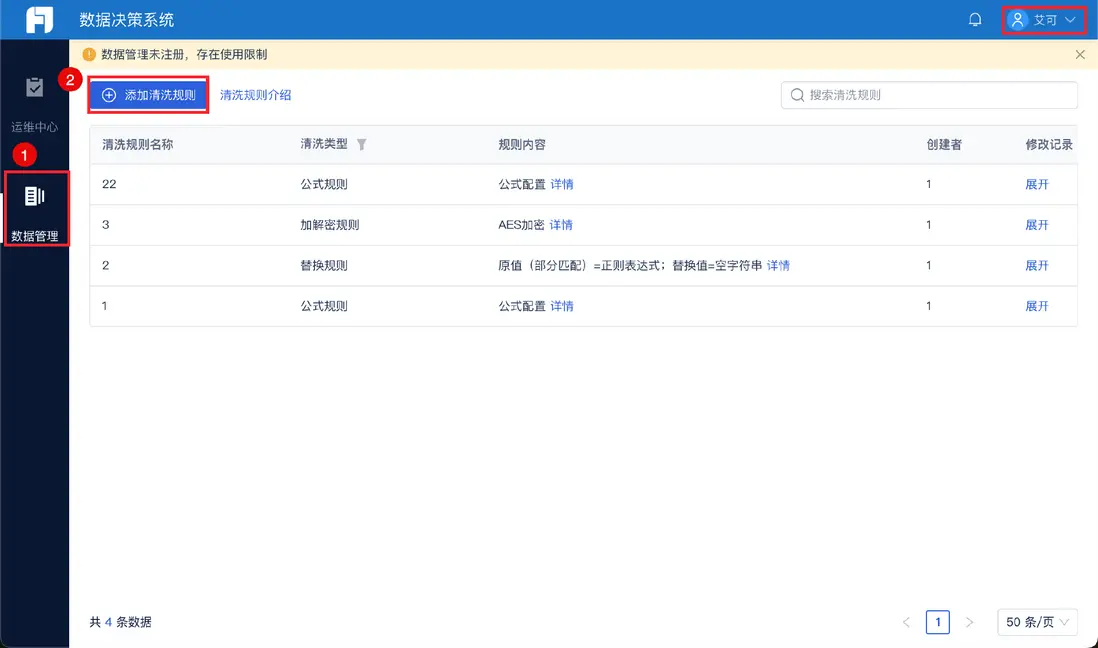

我們可以利用數據集成工具,比如我常用的FineDataLink,它就能一鍵添加清洗規則,直接把清洗後的數據呈現出來,非常方便,新手也能快速上手。

説白了,數據清洗不是一個可選項,而是一個必選項,它是你對數據負責、對分析結果負責的第一步。

聊完了為什麼,咱們再看看,這個過程裏具體有哪些讓人頭疼的地方。

二、 數據清洗的痛點有哪些?

知道了必要性,我們還得清醒地認識到其中的挑戰。這些痛點,幾乎每個數據分析師都深有體會。

- 耗時耗力,成就感低:數據清洗工作往往會佔據一個數據分析項目70%-80%的時間。你花了大量精力在查找、判斷、修正數據上,但最終成果卻大多隱藏在後台,無法直接體現在光鮮的分析報告裏。這種“幕後英雄”式的付出,有時會讓人覺得付出與回報不成正比,因此可能會出現數據清洗不全面,員工積極性不高等情況。

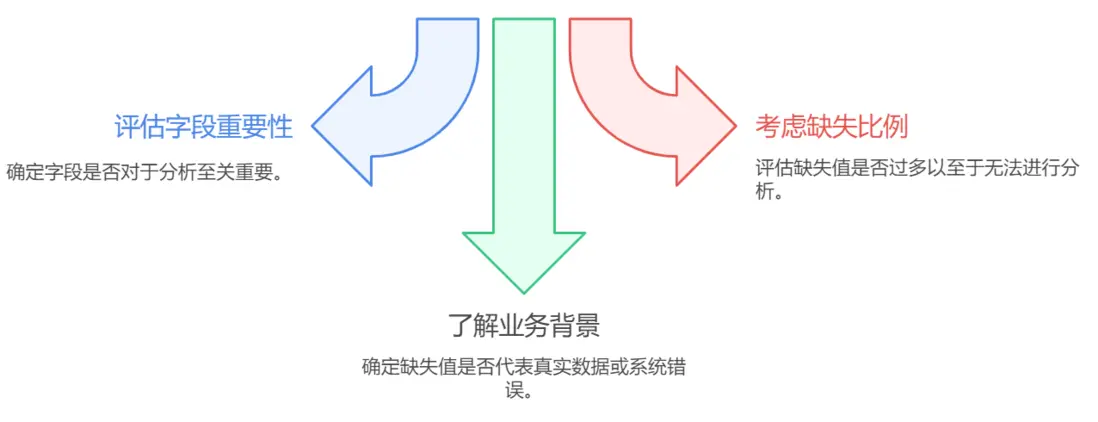

- 規則制定困難:這是最考驗專業能力和經驗的地方。比如,看到一個缺失的年齡值,你是直接刪除這一行?還是用平均年齡填充?或者通過其他信息推斷?每一種選擇都會對後續分析產生不同影響:規則定得太嚴,可能會誤刪大量有效數據;定得太鬆,又可能留下隱患。

- 問題隱蔽難發現:有些數據問題不是一眼就能看出來的。比如,日期格式看起來都是“2023-01-01”,但可能混入了極少數“2023/01/01”的格式,在批量處理時就會導致錯誤;或者數值看起來合理,但單位不統一,這種問題不經過仔細檢查,極易被忽略,從而導致分析結果出現數量級的偏差。

- 業務理解的挑戰:數據清洗不僅僅是技術活,更是業務活。一個值在技術上看起來是異常值,比如,某個商品的銷售額突然飆升,但在業務上可能是一次成功的促銷活動。如果你不理解業務背景,僅憑統計規則去清洗,很可能把最有價值的信息給“洗”掉了。你懂我意思嗎?脱離業務的數據清洗是盲目的。

既然有這麼多困難,我們總不能束手無策。那麼,具體要怎麼操作呢?

三、 數據清洗有哪些核心方法?

面對這些痛點,我們要有一套系統性的方法來應對。下面我梳理出一個清晰的流程,你可以把它當作一份操作指南。

第一步:理解數據與診斷問題

在動手之前,先為數據做一次全面體檢。使用描述性統計查看數據的基本分佈,檢查是否有明顯的異常值,查看數據的前幾行和後幾行,對數據有個直觀感受。這個階段的目標是發現問題的範圍和類型。

第二步:處理缺失值

缺失值是最常見的問題。主要有以下幾種處理方式:

- 刪除:如果某一行或某一列的缺失值比例非常高,並且對分析目標不重要,可以考慮直接刪除。

- 填充:這是更常用的方法。可以用統計量填充,比如均值、中位數、眾數等,也可以用前後值填充(適用於時間序列數據),或者通過算法模型預測填充。選擇哪種方法,取決於數據的特性和業務邏輯。

- 保留並標記:有時,缺失本身也是一種信息。你可以創建一個新的標誌字段,比如“是否缺失年齡”,將其作為一個新的特徵放入模型中,有時會帶來意想不到的效果。

第三步:處理異常值

異常值是指那些明顯偏離其他數據點的值。

- 識別:可以通過箱線圖、散點圖可視化發現,也可以通過統計方法,如Z-score、IQR法則來量化識別。

- 處理:同樣需要謹慎。如果是錄入錯誤,可以修正或視為缺失值處理;如果是業務上的特殊情況,則需要結合業務判斷是保留還是剔除。

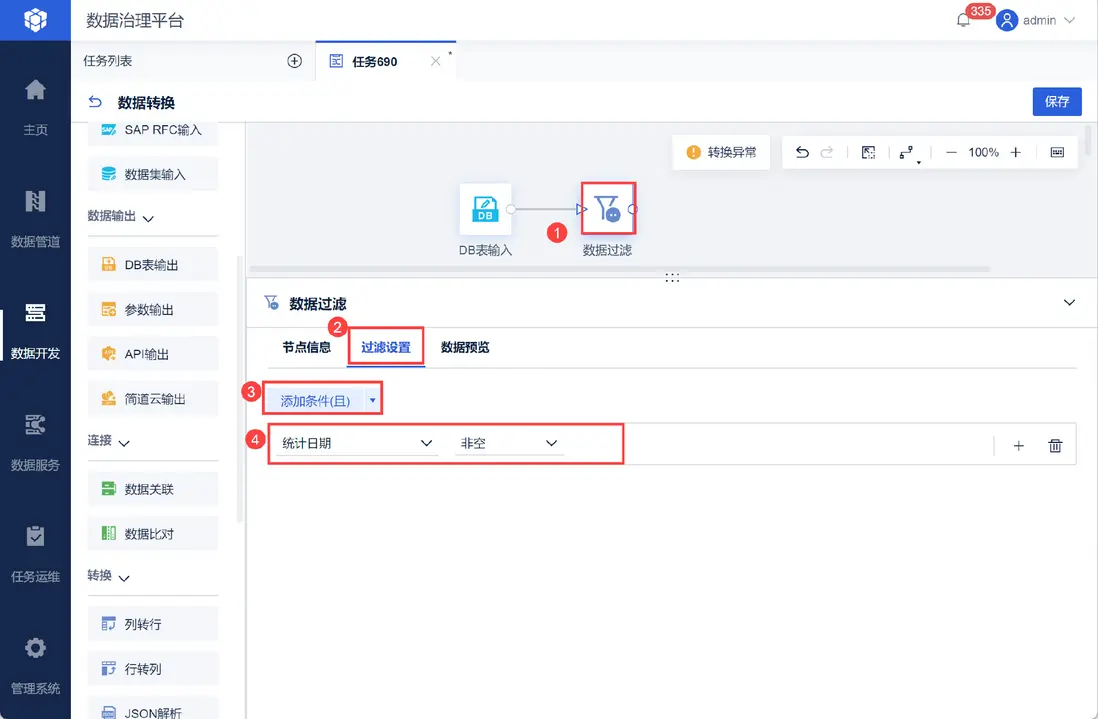

對於數據缺失和異常,我會利用FineDataLink的數據過濾功能,設置過濾條件就能一鍵得到想要的數據。

第四步:處理不一致數據

這是個體力活,但至關重要。

- 格式標準化:將日期、時間、數字、文本等統一成一致的格式。比如説,把所有日期轉為“YYYY-MM-DD”格式。

- 文本清洗:包括去除首尾空格、統一大小寫、糾正拼寫錯誤、將同義詞統一。

- 數據類型轉換:確保每一列的數據類型是正確的,比如把存儲為字符串的數字,轉換為數值類型,才能進行數學運算。

第五步:處理重複數據

完全重複的行通常沒有分析價值,反而會干擾統計結果,一般直接刪除。但需要注意,有些數據可能不是完全重複,只是關鍵字段重複,需要根據業務主鍵來判斷。

第六步:數據轉換與重構

為了滿足特定分析模型的需要,有時還需要進行一些轉換。

- 數據規範化:將數值縮放到一個特定的區間,消除量綱影響,這在很多機器學習算法中是必須的步驟。

- 數據離散化:將連續數據分段,變成類別數據。比如將年齡分為青年、中年、老年。

比如在FineDataLink裏,可以制定清洗規則,也就是統一字段標準 + 建立映射規則,這樣就能保證數據的規範性,是不是在後續工作裏就十分便利了?

我一直強調,這個流程不是僵化的,你需要根據手中數據的具體情況和你的分析目標,靈活地選擇和調整步驟。

掌握了基本方法,是不是就高枕無憂了?別急,還有一些關鍵的心法和原則,能讓你事半功倍。

四、 數據清洗的注意事項

最後,結合我自己的教訓,給你幾點關鍵的注意事項。

- 保留原始數據:要注意,任何清洗操作,都必須在數據的副本上進行。你必須確保在任何時候,都能回溯到最原始的數據狀態。這是一個重要的保障。

- 結合業務知識:我一直強調,技術手段必須與業務知識結合。在清洗每一個字段前,最好都能結合業務知識,保持和業務人員的溝通交流,他們的經驗能幫你避免很多想當然的錯誤。

- 迭代進行,循序漸進:可以先處理最嚴重、最明顯的問題,然後進行一輪簡單的分析,看看效果,接着再處理下一層問題。這種迭代的方式,能讓你及時發現問題,避免在錯誤的方向上走得太遠。

- 保持懷疑,持續驗證:清洗後的數據,並不代表就是絕對正確的。你要持續地用各種方法去驗證它,比如與歷史報告對比,與業務常識核對。

總結

説到底,數據清洗是一項無法繞開的基礎性工作,它看似繁瑣枯燥,卻是整個數據分析流程的基石。數據清洗考驗的不僅是技術,更是耐心、嚴謹和對業務的理解深度。

現在你看完了這篇文章,相信你對數據清洗有了一個整體的把握,下次在面對雜亂的數據時你就有了一個清洗思路。要知道,數據清洗的目的始終是為了最後的決策支持,數據清洗做好了,就能為後續的工作節省大量的時間,幫助你及時調整策略,而不是隻憑經驗和感覺。