ICLR 2025 | 中科院+哈工大重磅發現:預訓練視覺模型分類越準,可解釋性越強

論文標題:Enhancing Pre-trained Representation Classifiability can Boost its Interpretability

作者團隊:中國科學院、哈爾濱工業大學、鵬城實驗室、華為

發佈時間:2025年10月28日

👉一鍵直達論文

👉Lab4AI大模型實驗室論文閲讀

✅Lab4AI平台提供AI導讀和AI翻譯等工具,輔助論文閲讀。您還可以投稿復現這篇論文~

⭐研究背景

當前預訓練視覺模型在分類任務上表現優異,但其表示的可解釋性常被忽視。傳統觀點認為可解釋性與分類性能存在衝突,尤其在設計可解釋模型時分類性能往往下降。

⭐研究目的

本文旨在探究分類導向的預訓練表示是否能夠同時實現高分類性能和高可解釋性,並量化表示的可解釋性,揭示其與分類性能之間的內在關係。

⭐研究框架

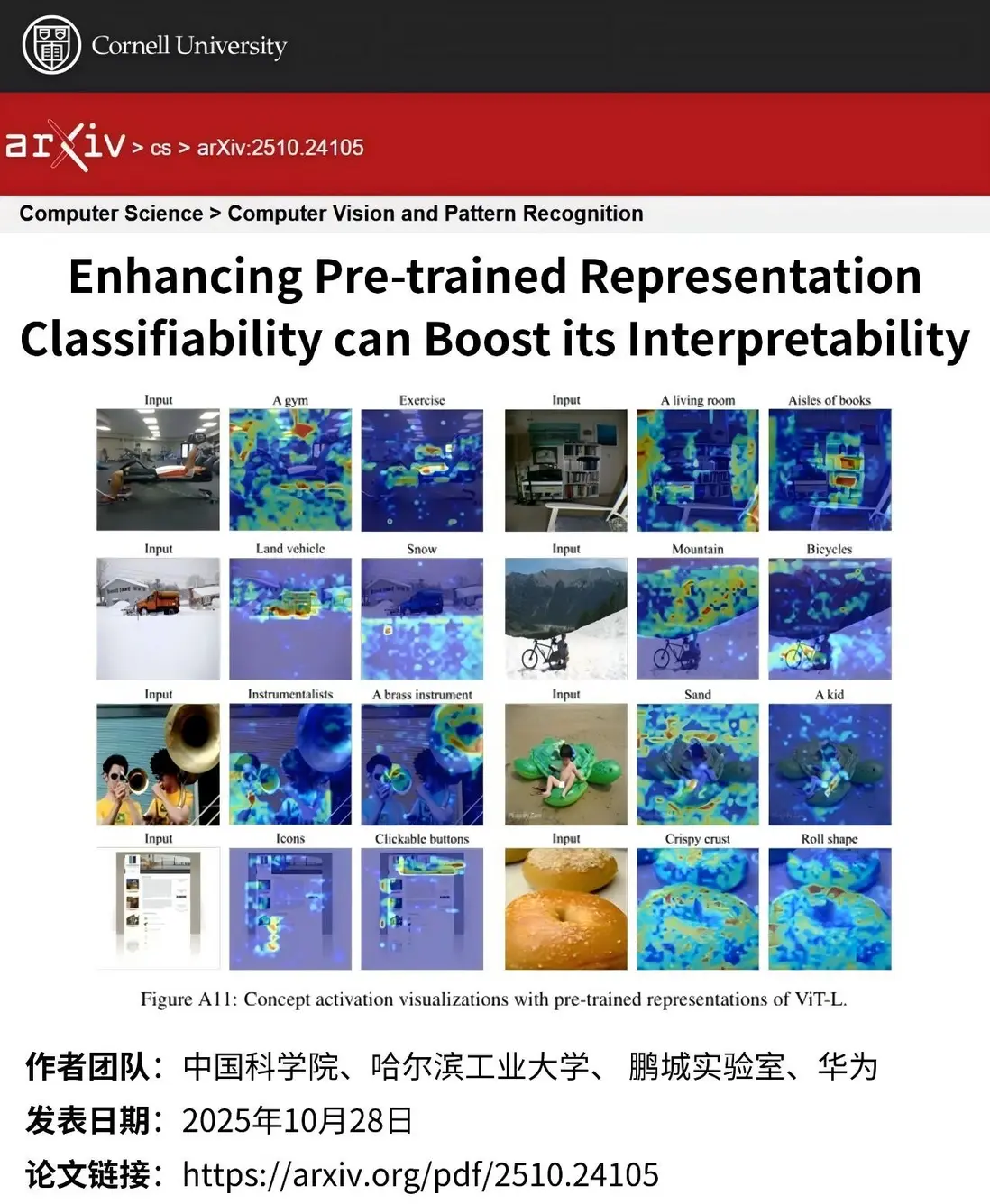

提出“內在可解釋性評分(IIS)”,通過將表示投影到概念空間並引入稀疏化機制,衡量其在解釋過程中保留任務相關語義的能力。IIS定義為不同稀疏度下解釋預測準確率與原始表示準確率之比的平均值。

⭐研究結果

實驗發現,IIS與分類準確率呈正相關,即分類性能越高的表示越易於解釋。進一步地,通過最大化IIS微調模型可提升其分類性能,同時基於解釋的預測也能達到接近原始模型的準確率,實現可解釋性與分類性能的協同提升。