1.論文概述

論文標題:SAM3: Segment Anything with Concepts

作者團隊:Anonymous authors

發佈時間:ICLR2026

論文鏈接:https://openreview.net/pdf?id=r35clVtGzw

👉Lab4AI 大模型實驗室鏈接:

https://www.lab4ai.cn/paper/detail/reproductionPaper?utm\_source=jssq\_sf&id=db767205533345c2ab013a7c31cbea7a

| 01 摘要解析

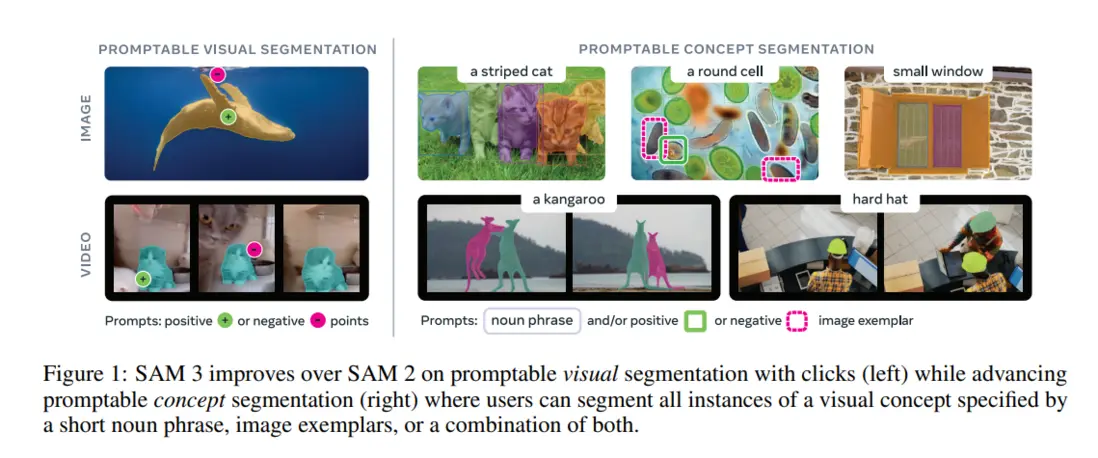

SAM3(SegmentAnythingModel3)代表了圖像和視頻分割領域的重大突破,這是一個基於概念提示的統一模型,能夠檢測、分割和跟蹤圖像視頻中的對象。其核心創新在於提出了可提示概念分割(PromptableConceptSegmentation,,PCS),支持通過短名詞短語(如“黃色校車”)、圖像範例或二者組合作為提示,為所有匹配對象實例返回分割掩碼和唯一標識。傳統方法相比,SAM3 在圖像和視頻 PCS 任務上實現了 2 倍的性能提升,同時在交互式視覺分割任務中也改進了前代 SAM 的能力。

| 02 研究背景與動機

計算機視覺中尋找和分割視覺場景中任何對象的能力是多模態 AI 的基礎,支撐着機器人技術、內容創作、增強現實、數據註釋和科學領域的應用。雖然 SAM 系列引入了通過交互式提示分割圖像視頻中對象的概念,但 SAM1 和 SAM2 主要關注視覺提示(點、框、掩碼),且每個提示僅分割單個對象實例,存在明顯侷限:

- 任務範圍窄:僅聚焦單提示單目標實例分割,無法處理“分割場景中所有某類概念目標”,如視頻中所有“貓”;

- 提示類型受限:SAM1、SAM2 以視覺提示為主,對文本概念的泛化能力不足;

- 開放性不足:難以應對開放詞彙表場景下的歧義問題(如“小窗户”的主觀性邊界定義)。

為解決上述問題,SAM3 擴展出提示性概念分割(PCS)任務,填補“概念級全實例分割”的技術空白。

| 03 可提示概念分割(PCS)

PCS 任務的核心目標是:給定一張圖像或時長 ≤30 秒的短視頻,模型根據概念提示(短名詞短語、圖像示例或兩者結合),完成檢測、分割、跟蹤符合概念的對象。該類任務的本質是開放詞彙,它具有固有的模糊性或歧義。許多概念存在多種解釋,例如“小窗户”是主觀的(小 vs 大)且邊界模糊(有百葉窗 vs 無百葉窗)。

SAM3 研究團隊通過三大方式緩解:一是在 SA-Co 基準的 Gold 子集為每個數據點收集 3 名位專家的標註,允許“多有效解釋”;二是在數據標註階段制定清晰指南,減少標註歧義;三是在模型中引入“歧義模塊”,學習概念的不同合理解釋。

| 04 架構設計

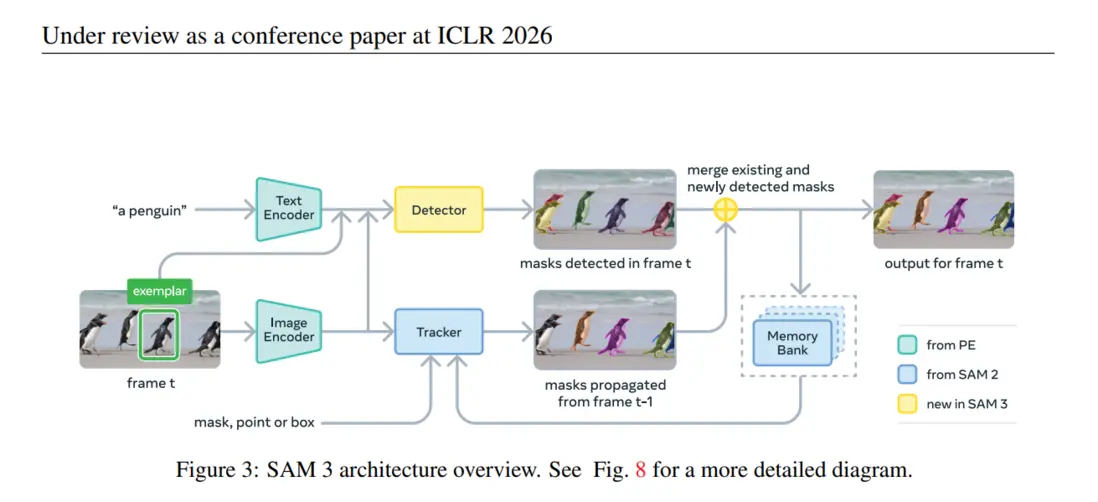

SAM3 基於 SAM2 與 DETR 架構擴展,SAM3 採用檢測器與跟蹤器共享視覺編碼器的雙路徑架構。PE 是 SAM3 的“多模態特徵中樞”,負責統一編碼圖像、文本、圖像示例的特徵,為檢測器與跟蹤器提供對齊的視覺-語言嵌入。檢測器基於 DETR 範式設計,核心創新是“解耦識別與定位”,解決傳統 DETR 中“單個目標查詢需同時負責‘目標是否存在(識別)’與‘目標在哪裏(定位)’”的矛盾。跟蹤器繼承 SAM2 的 Transformer 編解碼器架構,核心是實現“檢測器新目標檢測 + 跟蹤器掩碼傳播 + 實例匹配更新”的閉環流程,確保視頻幀間實例 ID 的一致性與掩碼精度。

簡單來説就是,SAM3 能理解點或者框圈出來的物體(exemplar),也能理解提示概念(a penguin)。

| 05 四階段數據引擎

為解決 PCS 任務“數據稀缺且概念覆蓋不足”的問題,研究團隊構建了四階段數據引擎,通過與 SAM3、人類標註員和 AI 標註員的反饋循環迭代地生成註釋數據。數據引擎分四個階段演進,每個階段增加 AI 模型的使用,將人類努力導向最具挑戰性的失敗案例,同時擴展視覺領域覆蓋範圍。

- 階段 1:人類驗證。該階段的目標是建立“人工標註基準”,為後續 AI 標註器訓練提供高質量數據。

- 階段 2:人類 +AI 驗證。使用第一階段收集的人工標註數據微調 Llama3.2,得到兩個 AI 驗證器:一是“掩碼驗證器(MVAI)”,判斷掩碼與概念提示的匹配度;二是“完整性驗證器(EVAI)”,判斷掩碼是否覆蓋所有實例。

- 階段 3:擴展與領域擴展。該階段聚焦“長尾概念”與“多領域數據”,使用 AI 模型挖掘日益挑戰性的案例,將領域覆蓋擴展到 15 個數據集,通過從可用 alt-text 中提取 NP 擴展概念覆蓋。

- 階段 4:視頻標註。該階段將數據引擎擴展到視頻,聚焦“視頻特有挑戰”(如遮擋、快速運動、幀間實例關聯)。

這種數據引擎設計使標註吞吐量翻倍,最終產生了包含 400 萬個獨特短語和 5200 萬個掩碼的高質量訓練數據集,以及包含 3800 萬個短語和 14 億個掩碼的合成數據集。

![640[3].png](http://openwrite.cn/uploads/19733/55711/6c56fd83-57d6-400e-ad...)

| 06 實驗設計與結果分析應用

研究團隊在圖像/視頻 PCS、少樣本遷移、目標計數、複雜查詢分割等任務上驗證 SAM3 性能,詳細結果可見論文原文。

2.論文原文閲讀

您可以跳轉到 Lab4AI 平台上去閲讀論文原文。

👉Lab4AI 大模型實驗室已經提供SAM3 論文,閲讀鏈接:

https://www.lab4ai.cn/paper/detail/reproductionPaper?utm\_source=jssq\_sf&id=db767205533345c2ab013a7c31cbea7a

👉文末點擊閲讀原文,即可跳轉至對應論文頁面。

目前,SAM3 論文的復現工作還在招募中,歡迎各位感興趣的朋友報名參與復現創作,我們提供一定額度的 H800 算力作為獎勵。

Lab4AI 大模型實驗室已經提供🔥SAM2 論文的一鍵復現 🔥,您無需準備代碼、模型、數據、環境,即可一鍵快速體驗,鏈接直達:

https://www.lab4ai.cn/paper/detail?utm\_source=jssq\_sf&id=7bdf649416384cbcbdf44d42c2f72641&type=paper

![640[2].png](http://openwrite.cn/uploads/19733/55711/f8d1e550-8b19-490f-96...)

- Lab4AI.cn 覆蓋全週期科研支撐平台,提供論文速遞、AI 翻譯和 AI 導讀工具輔助論文閲讀;

- 支持投稿論文復現和 Github 項目復現,動手復現感興趣的論文;

- 論文復現完成後,您可基於您的思路和想法,開啓論文創新與成果轉化。

![640[1].jpg](http://openwrite.cn/uploads/19733/55711/4c0327c9-14ba-4bc3-a1...)