NeurIPS 2025!採樣成本降 50%+ 準確率提升!南大等團隊的RPC方法刷新 LLM 推理上限

論文標題:A Theoretical Study on Bridging Internal Probability and Self-Consistency for LLM Reasoning

作者團隊:南京大學、瑞士蘇黎世聯邦理工學院

發佈時間:2025年10月17日

👉一鍵直達論文

👉Lab4AI大模型實驗室論文閲讀

✅Lab4AI平台提供AI導讀和AI翻譯等工具,輔助論文閲讀。您還可以投稿復現這篇論文~

⭐核心貢獻

- 理論框架:首次提出用於分析LLM推理中採樣式測試時縮放方法的理論框架,將推理誤差分解為估計誤差和模型誤差。

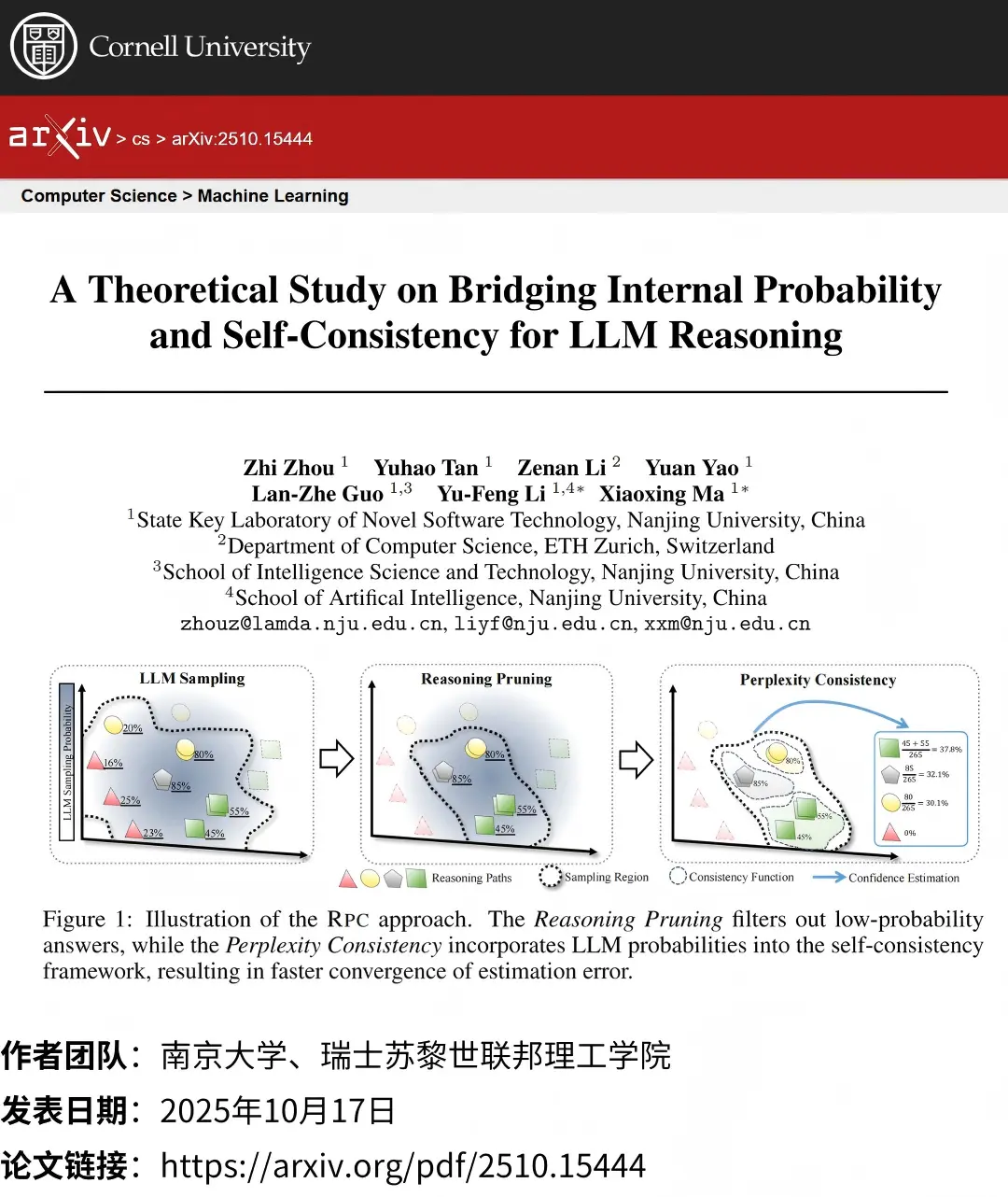

- 方法創新:提出RPC方法,融合自洽性和內部概率的優勢,通過Perplexity Consistency和Reasoning Pruning組件解決現有方法的侷限性。

- 實證驗證:在多個基準數據集上驗證RPC的有效性,顯著降低採樣成本並提升推理性能。

⭐研究方法

- 誤差分解理論:將推理誤差分解為估計誤差(與採樣規模和置信度估計策略相關)和模型誤差(由LLM固有推理能力決定)。

- 現有方法分析:自洽性估計誤差收斂慢(線性),困惑度模型誤差大且估計誤差優勢在低概率路徑下退化。

-

RPC方法設計:

- Perplexity Consistency:將LLM內部概率融入自洽性框架,以指數級速率降低估計誤差。

- Reasoning Pruning:通過混合威布爾分佈建模概率分佈,自動過濾低概率路徑,防止估計誤差退化。

⭐研究結果

- 效率提升:RPC在達到與自洽性相同性能時,所需採樣數量減少50%以上。

- 性能優化:在7個基準數據集上,RPC平均準確率優於基線方法(如數學推理任務提升1.29%)。

- 可靠性增強:RPC的置信度估計更接近真實置信度(預期校準誤差更低)。

- 泛化性驗證:在代碼生成(如HumanEval)和邏輯推理(如LogiQA)任務中均表現優異。