論文標題:Controlling Thinking Speed in Reasoning Models

作者團隊:浙江大學、阿里巴巴雲、浙江工業大學

發佈時間:2025年10月30日

👉一鍵直達論文

👉Lab4AI大模型實驗室論文閲讀

✅Lab4AI平台提供AI導讀和AI翻譯等工具,輔助論文閲讀。您還可以投稿復現這篇論文~

核心亮點

本研究的核心亮點集中在三大突破性貢獻:

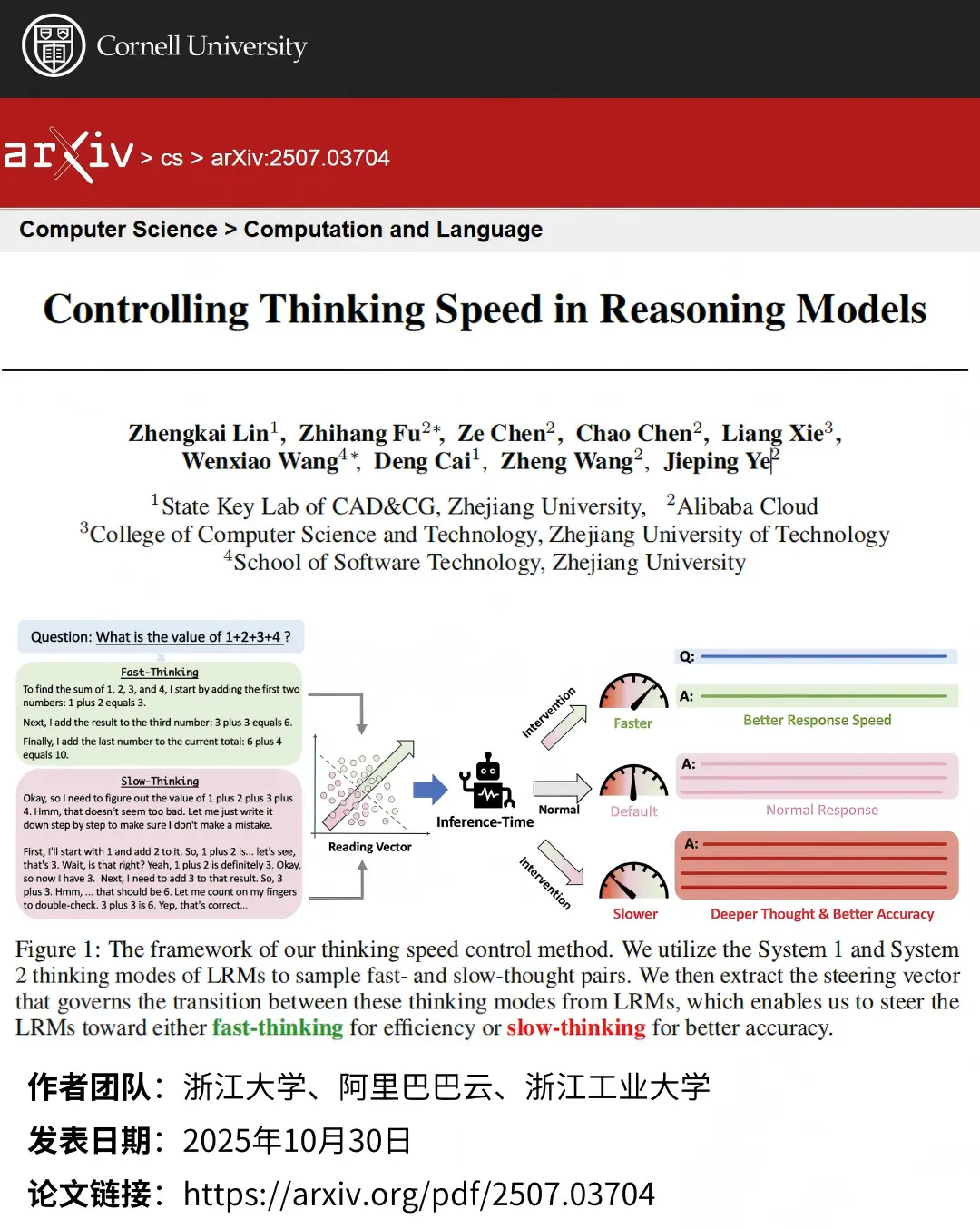

- 其一,首次揭示LRMs存在快慢思維模式的內在切換機制,發現“To”“Okay”等特定開頭詞可分別觸發快速、慢速思維,為思維控制提供了天然切入點;

- 其二,基於表示工程技術首創思維速度控制方法,通過讀取快慢思維樣本的PCA導向向量,並向模型隱藏狀態注入該向量,實現推理時的縮放效應;

- 其三,設計自適應動態推理策略,藉助Jensen-Shannon散度量化推理難度、滑動窗口檢測高難度片段,再通過動態閾值機制自動在簡單段加速、複雜段減速,且方法無需訓練即可嵌入現有部署系統,兼顧創新性與實用性。

核心結果

研究在多模型、多基準上驗證了方法有效性。

- 實驗以DeepSeek-R1-Distill-Qwen-7B/32B、QwQ-32B等為測試模型,在AIME24、MATH-500等基準上對比預算強制法等基線;

- 思維速度控制方面,所有LRMs加速(α>0)時準確率較基線平均提升8.2-11.4%,減速(α<0)時平均提升0.51-1.46%;自適應控制表現更優,相比原始LRMs,在將準確率提升1.26%的同時,減少8.56%的token使用量;

- 此外,模型呈現明顯測試時縮放效應,隨響應長度增加(思維變慢),性能持續提升,驗證了思維速度調控的有效性與穩定性。