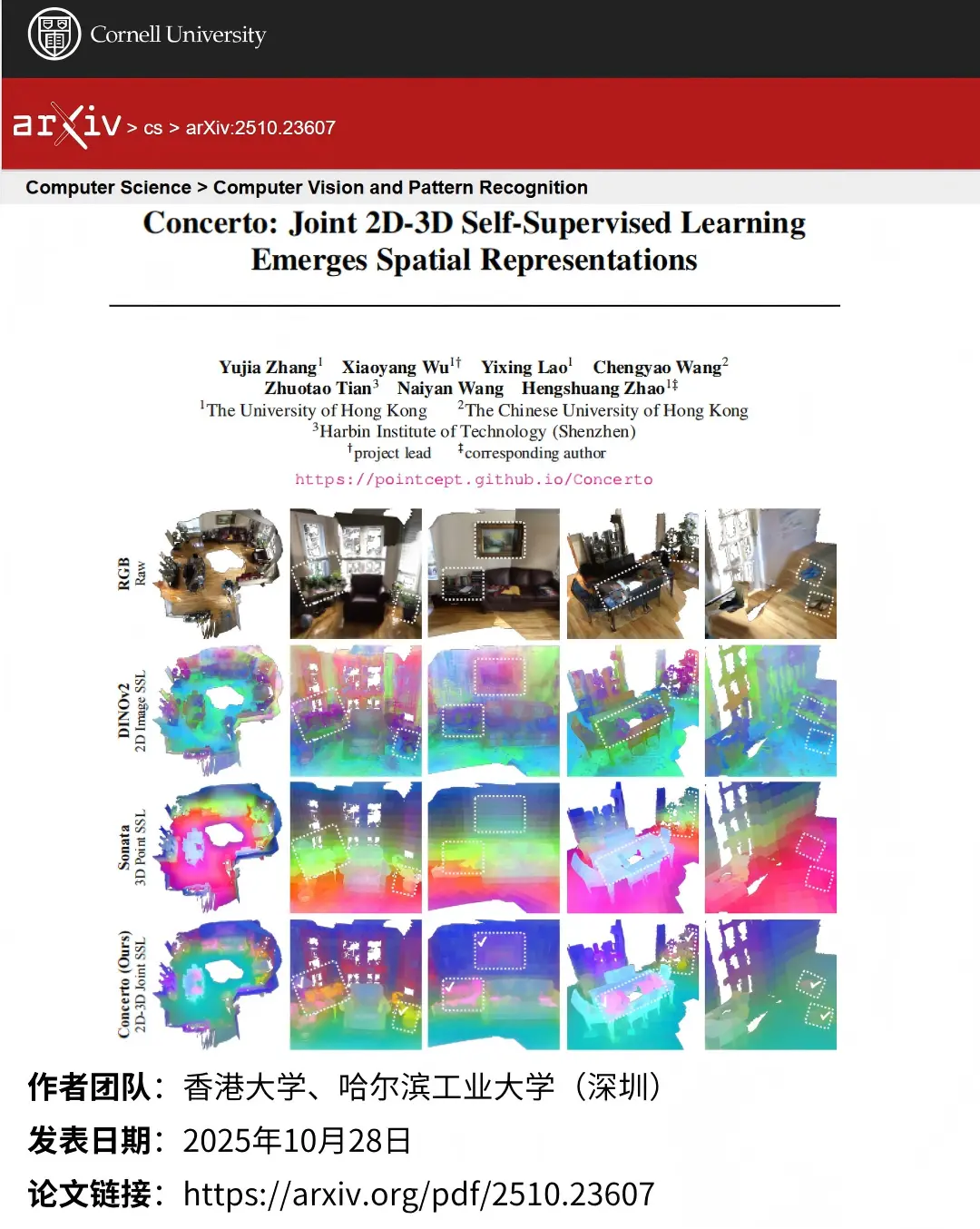

論文標題:Concerto: Joint 2D-3D Self-Supervised Learning Emerges Spatial Representations

作者團隊:香港大學、香港中文大學、哈爾濱工業大學(深圳)

發佈時間:2025年10月28日

👉一鍵直達論文

👉Lab4AI大模型實驗室論文閲讀

✅Lab4AI平台提供AI導讀和AI翻譯等工具,輔助論文閲讀。您還可以投稿復現這篇論文~

⭐核心問題

當前多模態視覺學習存在四大關鍵痛點

- 單模態侷限:現有研究多聚焦二維圖像或三維點雲單一模態,缺乏跨模態協同,無法像人類多感官那樣形成完整知識結構;

- 淺層融合缺陷:簡單拼接二、三維特徵未挖掘模態間潛在交互,導致空間表徵能力受限;

- 效率瓶頸:傳統模型對參數和標註數據依賴度高,在低資源場景下性能驟降;

- 開放世界適配缺失:現有自監督表徵難以與人類語言對齊,無法支撐開放詞彙的概念接地任務。

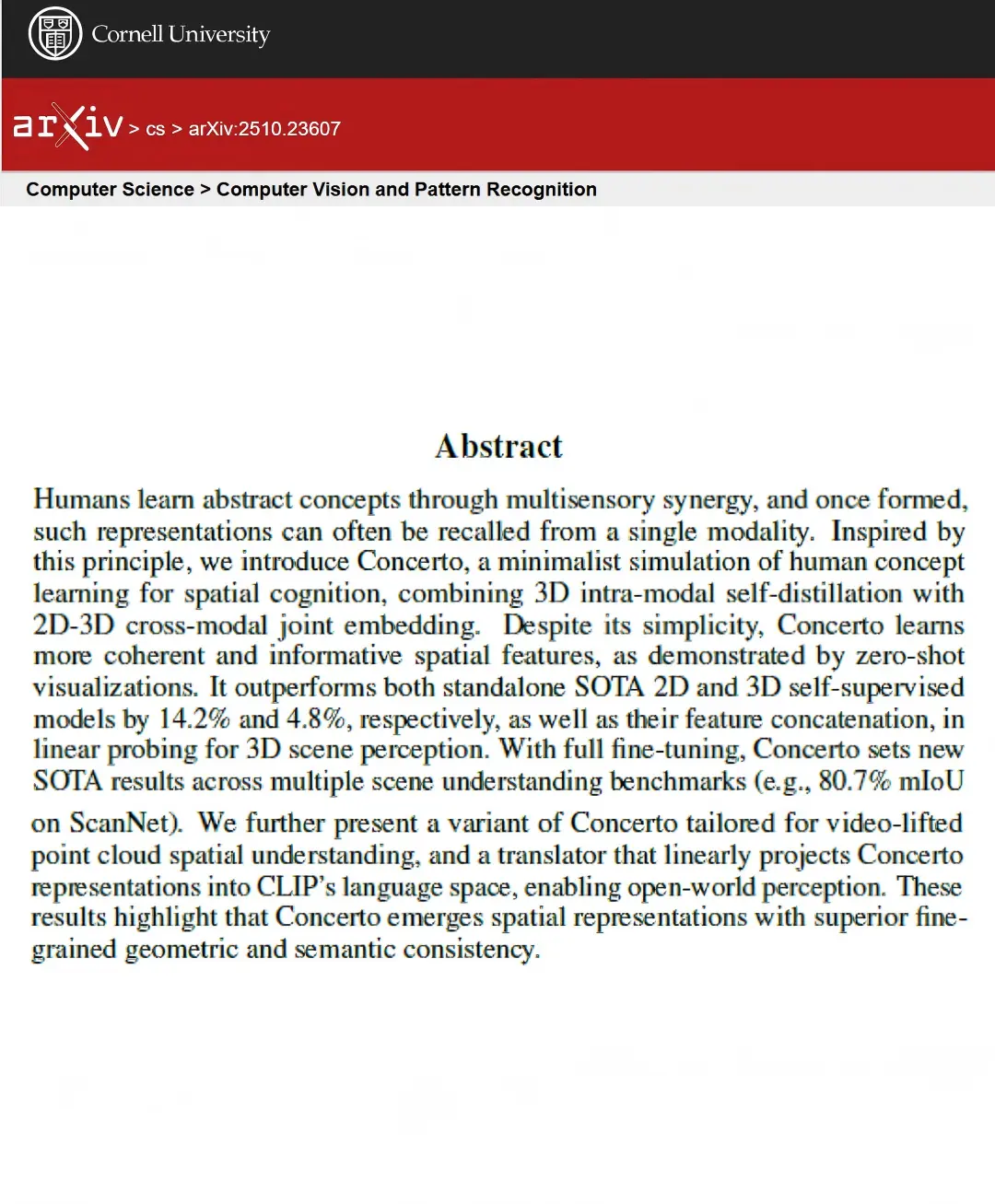

針對上述問題,提出Concerto框架:以“模內自蒸餾”優化單模態表徵,以“跨模態嵌入預測”關聯二、三維數據,二者協同形成更優空間表徵,同時通過線性探針設計提升參數與數據效率,引入語言映射模塊實現開放世界感知。

⭐研究亮點

研究亮點聚焦“創新+性能+實用”三維價值,成果顯著:

- 框架創新:首次將“模內自蒸餾”與“跨模態嵌入預測”結合,模仿人類認知機制,突破傳統單模態與淺層融合範式;2. 性能頂尖:在ScanNet、S3DIS等基準上刷新紀錄,如ScanNet200語義分割達80.7% mIoU,實例分割性能超全量微調模型,尤其擅長細粒度語義幾何信息捕獲;

- 效率突出:參數量較小時仍優於監督學習模型,僅用1%-5%標註數據,通過線性探針即可實現優於解碼器微調的效果,降低低資源場景應用門檻;

- 拓展性強:引入線性投影翻譯器實現表徵與CLIP語言空間對齊,支持開放世界任務,還推出視頻適配變體,提升框架通用性。