論文標題:Linear Differential Vision Transformer: Learning Visual Contrasts via Pairwise Differentials

作者團隊:清華大學、北京大學

發佈時間:2025年11月4日

👉一鍵直達論文

[👉Lab4AI大模型實驗室論文閲讀](

https://www.lab4ai.cn/paper/detail/reproductionPaper?utm_sour...)

✅Lab4AI平台提供AI導讀和AI翻譯等工具,輔助論文閲讀。您還可以投稿復現這篇論文~

⭐核心思想:讓視覺AI“抓重點”,既快又準

這篇文章解決了一個核心矛盾:強大的Vision Transformer(ViT)模型計算量太大,太慢。

你可以把傳統的ViT想象成一個特別認真的學生,看一張圖片時,會把圖片切成很多個小塊(比如256個),然後讓每一個小塊都去和其他的255個小塊互相比較一下,看看誰和誰更像。這種方法很全面,但計算量隨着圖片塊數量的增加呈平方級爆炸增長。

⭐研究方法

為了讓這個“認真但低效”的學生變得更聰明,作者團隊提出了一個名為 “視覺對比注意力”(Visual-Contrast Attention, VCA) 的新方法。它的核心思想是:不要一上來就讓所有細節互相比較,先讓模型學會“抓重點”,通過“對比”來找出真正有區分度的信息。

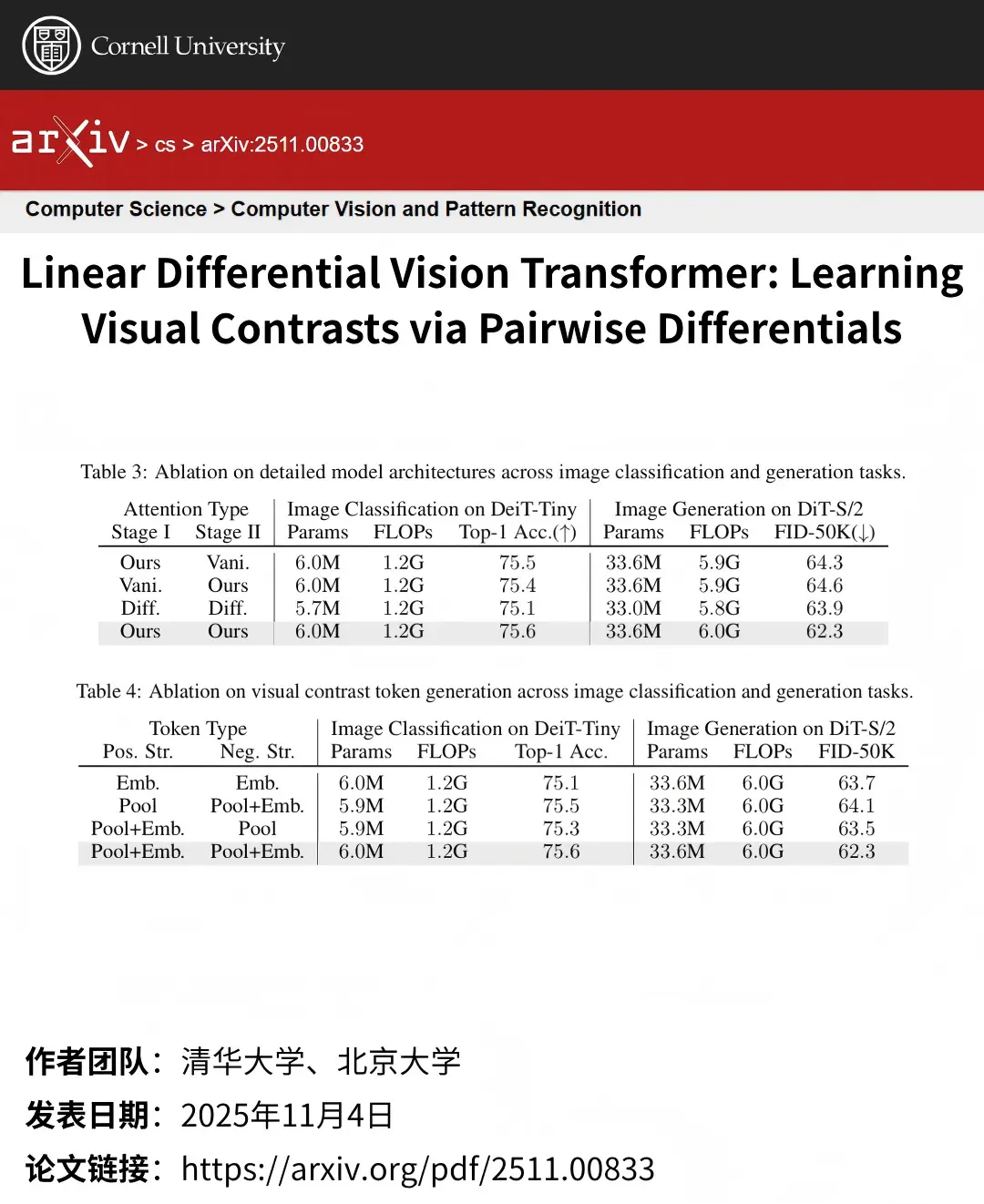

⭐研究結果

該方法在多個任務中表現卓越。在ImageNet上,它將DeiT-Tiny的準確率提升了3.4%;在圖像生成中,顯著降低了DiT等模型的FID指標。所有這些提升僅引入了極少參數量,且未增加計算開銷,證明了其高效性和普適性。