數小時視頻,關鍵僅幾秒:AI如何像偵探一樣找到答案?LongVT:先定位再核驗,精準不瞎猜

01論文概述

這篇文章由MiroMind AI 與 南洋理工大學核心領銜(通訊作者:Shijian Lu、Xingxuan Li),聯合香港科技大學(廣州)、清華大學以及 LMMs-Lab 團隊共同完成。

論文名稱:LongVT: Incentivizing "Thinking with Long Videos" via Native Tool Calling

👉論文鏈接

👉項目地址

👉Github地址

👉大模型實驗室Lab4AI

長視頻推理與以往的視頻問答任務存在本質上的不同挑戰: 大語言多模態模型(LMMs) 必須在長達數小時的視頻內容中,定位其中稀疏、細粒度且具有因果決定性的片段。

但目前的大語言多模態模型大多是基於粗粒度、片段級的數據訓練的。

這種不匹配導致當下的大語言多模態模型缺乏必要的監督,無法學習時間假設的形成、驗證或修正的方式。

除此之外,現有的大多數視頻理解基準數據集僅提供選擇題形式的問答任務,這類任務無需真正的時間定位即可完成,並且容易受到數據集信息泄露或捷徑利用的影響。

受人類先對長視頻進行全局概覽、再針對相關片段查看細節的理解方式啓發,作者提出LongVT。

LongVT 的核心目標是讓模型學會像人一樣工作:不確定就回去查證據,並把查證過程放入訓練目標與獎勵信號。

針對長視頻推理任務缺乏細粒度問答(QA)數據的問題,作者還整理並將會發佈一個名為 VideoSIAH 的數據集套件。它一方面可以作為訓練數據集,捕捉“大海撈針式”視頻片段問答所需的推理動態。

另一方面也包含一個細粒度的評估基準 VideoSIAH-Eval,該基準通過人在環路的驗證方式,用於長視頻開放式問答的評估。

02核心貢獻

(1) LongVT:面向 “長視頻協同推理” 的端到端智能體框架

作者提出了一種全新的範式,它將多模態工具增強思維鏈(CoT)與針對長達數小時視頻的按需片段檢查進行原生交錯結合,從而使大語言多模態模型(LMMs)可以實現更高效、更可靠的長視頻推理。

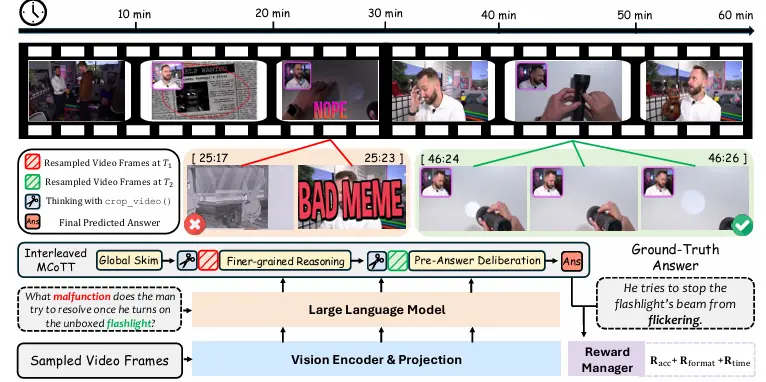

(2) VideoSIAH:面向證據稀疏型長視頻推理的細粒度數據集套件

作者構建了一個可擴展的數據生成流程,可產出多樣且高質量的問答(QA)數據與工具集成推理軌跡;同時搭建了一個專門的基準數據集,針對 “大海撈針式” 視頻片段推理場景設計。

(3) LongVT-7B-RFT:當前最優基線模型

通過大量的定量對比、針對數據方案、訓練策略與設計選擇的系統性消融實驗,以及對訓練動態的深入分析,作者構建並開源了一個具備“長視頻協同推理” 能力的高性能基線模型。

03核心技術

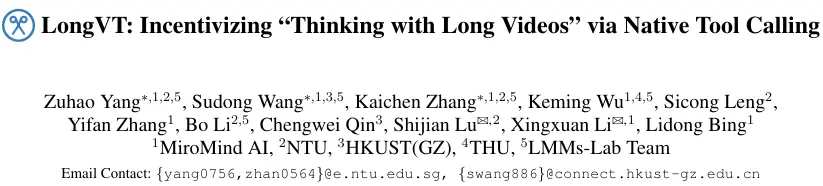

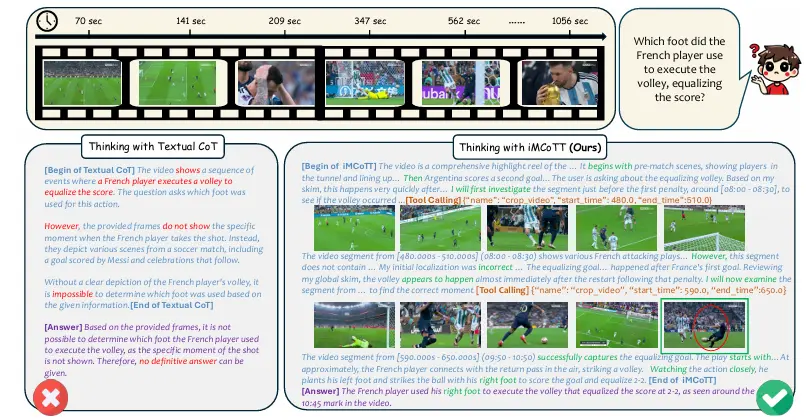

(1)iMCoTT推理範式

LongVT 模仿人類“瀏覽-聚焦-驗證”的思考流程:

模型先對採樣幀進行全局粗瀏覽形成粗定位假設,再調用原生工具聚焦關鍵片段,獲取細粒度視覺證據;如果證據不足,則修正初始假設,迭代推理直至輸出答案。

(2)VideoSIAH數據集構建

為支撐“先定位再核驗”的工具增強推理,論文構建了 VideoSIAH 數據套件,覆蓋 SFT(含非工具與工具增強)+ RL/RFT 的完整訓練鏈路。包括以下3類:

- SFT數據:24.7K個工具增強的監督微調樣本(通過半自動管道生成,結合場景檢測、片段化、QA生成與人工過濾);

- RL數據:1.6K個強化學習樣本(用於學習主動工具調用策略);

- RFT數據:15.4K個強化微調樣本(蒸餾高獎勵軌跡,穩定推理行為)

(3)三階段訓練策略

LongVT是一個端到端的智能體框架,該框架藉助三階段訓練策略,結合來自 VideoSIAH 的大規模高質量工具增強數據,激發大語言多模態模型(LMMs)的 “與長視頻一同思考” 的能力。

- 冷啓動監督微調Cold-start SFT:先教會模型“該怎麼選時間窗、怎麼調用工具、怎麼用工具返回證據寫答案”;

- 自主強化學習Agentic RL(GRPO):在強化學習階段引入時間定位獎勵,讓策略學會“何時檢索、檢索多長、如何融合證據”,突破純監督的性能上限;

- 自主強化微調Agentic RFT:把高獎勵軌跡“蒸餾回監督數據”,進一步穩定並獲得額外增益。

04研究結果

(1)主要實驗

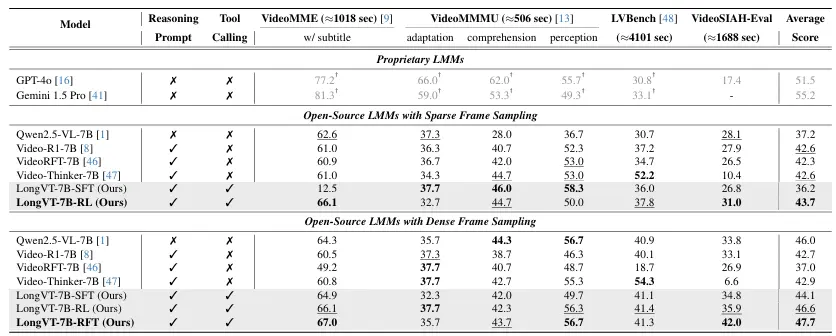

如Table 2所示,LongVT 在 VideoMME、VideoMMMU、LVBench 與 VideoSIAH-Eval 四個基準上均實現一致提升。

在更具挑戰的VideoSIAH-Eval 上,LongVT-7B-RFT 達到 42.0分,較次優開源基線提升約 6 分,體現其在“證據稀疏”的長視頻場景中具備更強的時序定位與證據複核能力。

從整體平均分看,LongVT 最優 checkpoint 為 47.7,與 GPT-4o 的 51.5 相差約 3.8 分(≈4 分),説明開源模型正在快速逼近閉源上限。

(2)消融實驗

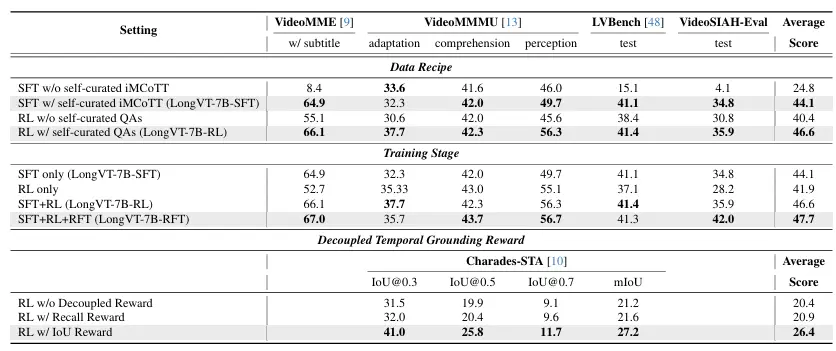

從SFT-only(44.1分)到 SFT+RL(46.6分),再到 SFT+RL+RFT(47.7分),平均分隨訓練階段逐步上升,説明 RL 與後續 RFT 在 SFT 冷啓動能力之上繼續帶來可累計的增益。

消融表明提升並非 “堆數據/堆輪次” 帶來的偶然收益:

一方面,細粒度工具軌跡與自構造QA對性能至關重要(數據配方消融);

另一方面,顯式引入時間對齊信號(IoU 形式的時序獎勵)才能穩定學到“圍繞時間證據進行檢索—複核—作答”的行為(獎勵設計消融)。

LongVT通過“工具調用+多階段訓練”的創新,讓LMMs具備“思考長視頻”的能力,為視頻理解領域提供了新範式。其數據集、方法與實驗結果為後續研究奠定了基礎,同時暴露的侷限也為未來方向指明路徑。

🔍本文由AI深度解讀,轉載請聯繫授權。關注“大模型實驗室Lab4AI”,第一時間獲取前沿AI技術解析!