NeurIPS 2025 Spotlight!跨模態重識別革命!東北大學等 MDReID 圖像信息智能匹配

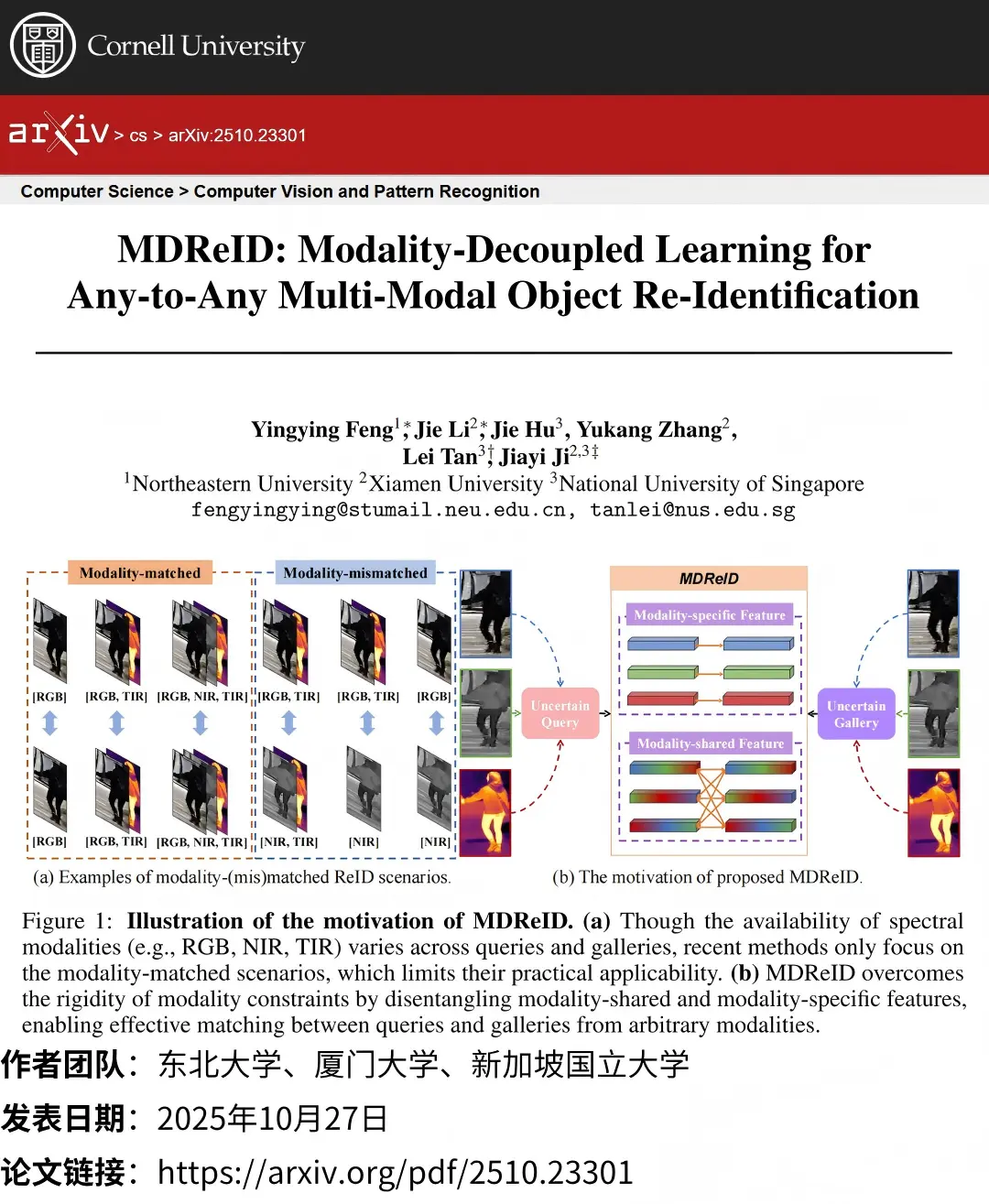

論文標題:MDReID: Modality-Decoupled Learning for Any-to-Any Multi-Modal Object Re-Identification

作者團隊:東北大學、廈門大學、新加坡國立大學

發佈時間:2025年10月27日

👉一鍵直達論文

👉Lab4AI大模型實驗室論文閲讀

✅Lab4AI平台提供AI導讀和AI翻譯等工具,輔助論文閲讀。

想象一下:警察想要通過監控錄像找到一個嫌疑人。但是,不同監控攝像頭的類型可能完全不同——有的拍的是普通的彩色照片(RGB),有的是黑白但能夜間看清的(NIR),還有的是能感知熱量的熱成像(TIR)。這就帶來了一個難題:如果用一張彩色照片(RGB)去熱成像(TIR)照片裏找人,傳統系統可能就失靈了。這篇論文就是為了解決這個“張冠李戴”的實際問題。它提出了一個叫 MDReID 的新方法,核心思想非常巧妙,叫做 “分而治之”。

⭐核心創新

MDReID 認為,任何一張圖像包含的信息都可以分成兩種:

- 通用特徵:這是物體最本質的信息。比如一個人的體型、姿勢、揹包的形狀。這些信息無論用什麼攝像頭拍,都應該差不多。

- 專用特徵:這是某種攝像頭特有的信息。如彩色攝像頭能看到的衣服顏色,或者熱成像攝像頭能看到的身體熱量分佈。

MDReID 的核心技術即主動把這兩種信息拆分開:

- 拆解信息:模型在分析圖片時,會同時生成兩組“密碼”:通用特徵和專用特徵。對於一張彩色照片,模型既知道它裏面包含的通用人體形狀,也知道它特有的顏色信息。

- 智能對比:當需要比對兩張圖片時,MDReID 會進行智能匹配。專用特徵只和同類型攝像頭的專用特徵比對(比如顏色和顏色比)。通用特徵則可以跨類型自由比對(比如彩色照片裏的人的體型,可以和熱成像照片裏的人的體型比)。

通過一種特殊的“訓練法則”,模型會學習讓通用特徵儘可能相似,同時讓通用特徵和專用特徵儘可能不同,避免信息冗餘。