在圖像生成領域,偏好優化的目標是讓模型更好地符合人類的審美標準。傳統的偏好優化方法通常依賴視覺-語言模型(VLMs)作為像素級的獎勵模型對生成圖像進行打分,並通過強化學習或對比學習方式進行微調。然而,像素級獎勵模型應用於步驟級(step-aware)的偏好優化時,其對高噪聲圖像不魯邦,導致後續強化學習效果差。為了解決這些問題,中科院自動化所與快手可靈團隊聯合提出了一種全新的偏好建模與優化範式——Latent Reward Model(LRM)與 Latent Preference Optimization(LPO)。

該方法首次系統性地將擴散模型自身作為獎勵模型,在帶噪隱空間中直接建模人類偏好,並實現了從數據篩選、獎勵建模到模型優化的完整流程。相關研究成果已被 NeurIPS 2025 會議正式接收,相關代碼已開源。

論文標題:Diffusion Model as a Noise-Aware Latent Reward Model for Step-Level Preference Optimization

論文鏈接:https://arxiv.org/abs/2502.01051

代碼鏈接:https://github.com/Kwai-Kolors/LPO/tree/main

🎯 研究背景

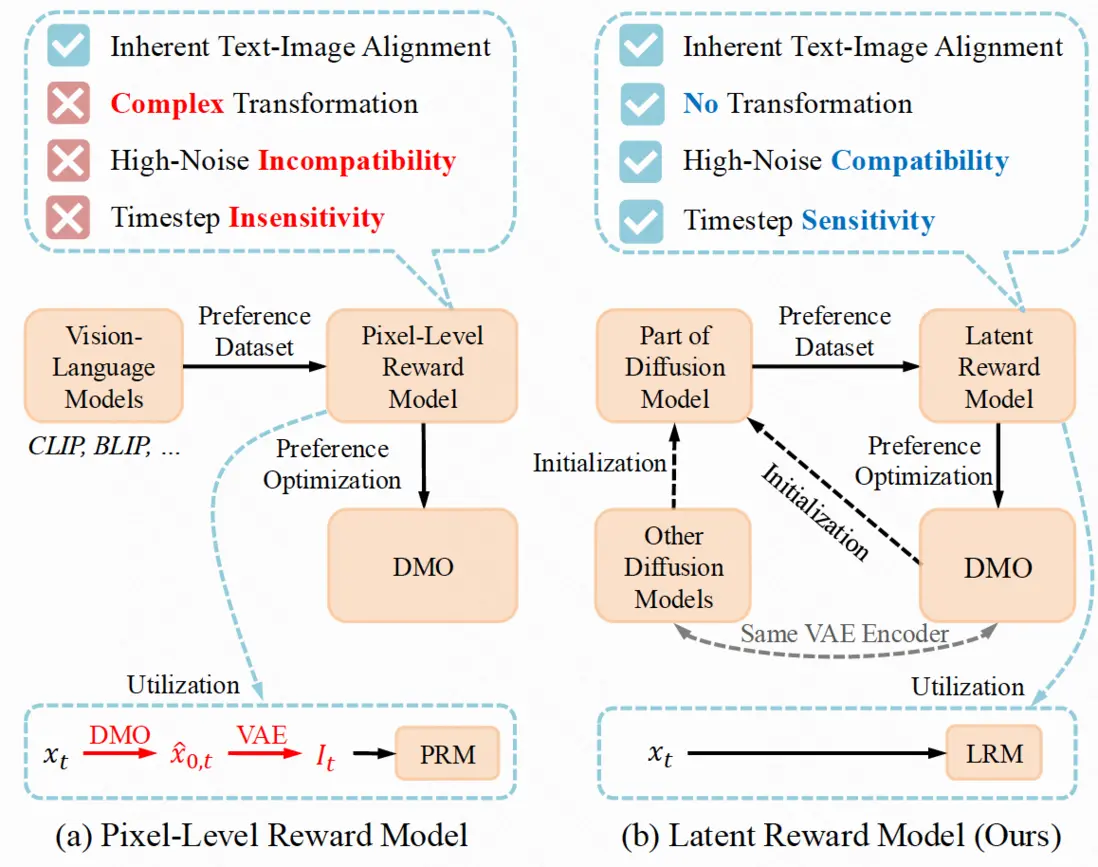

隨着 Stable Diffusion、SDXL 等模型的廣泛應用,如何使其生成結果更符合人類審美與語義偏好,成為圖像生成研究的關鍵方向。當前主流方法主要依賴像素級獎勵模型(Pixel-level Reward Models, PRMs),如 CLIP、PickScore 等,通過打分機制引導模型優化。然而,這類方法在步驟級偏好優化(step-level preference optimization)中存在以下問題:

1.複雜推理鏈路:每一步都需還原圖像,涉及擴散逆過程與 VAE 解碼,計算開銷大;

2.高噪聲不兼容:在大時間步(timestep)下,圖像高度模糊,PRMs 難以準確評估;

3.缺乏時間感知:PRMs 通常不感知 timestep,難以建模不同階段的偏好差異。

💡 核心思路

本文提出一個關鍵問題:是否存在一種模型,能直接在帶噪隱空間中建模人類偏好,同時具備良好的時間感知與噪聲魯棒性?

答案是:擴散模型本身。擴散模型本身就具備建模偏好的潛力,可以使用擴散模型自己評價自己!本文提出的核心洞見是:擴散模型本身就具備建模偏好的潛力。

它們在預訓練過程中已經學習到了豐富的文本-圖像對齊能力,能夠直接處理帶噪隱變量,不需要進行 VAE 的解碼。並且擴散模型對不同時間步的噪聲強度具有天然敏感性。因此,作者提出將擴散模型“改造”為一個噪聲感知的隱式獎勵模型(LRM),在隱空間中預測圖像對的偏好關係,從而規避傳統像素級方法的種種限制。

🔧 方法框架

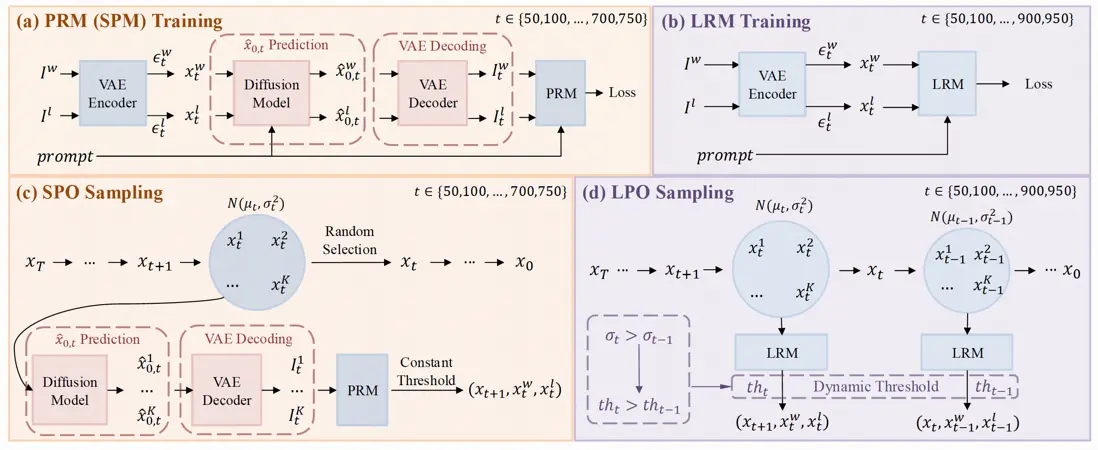

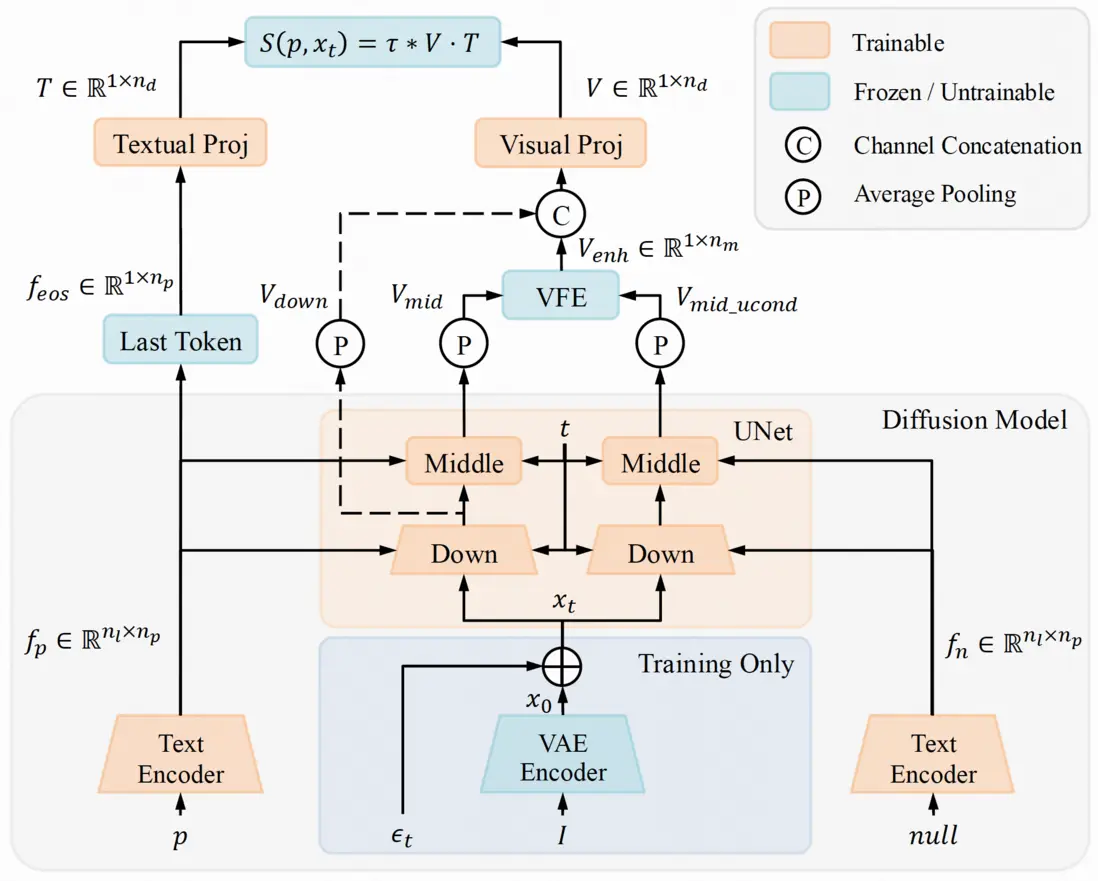

1.Latent Reward Model(LRM):隱式獎勵建模

LRM 利用擴散模型的 U-Net 或 DiT 結構提取視覺特徵,結合文本編碼器的語義信息,構建圖文聯合表示。為了增強模型對文本-圖像對齊的關注,作者還引入了視覺特徵增強模塊(VFE),通過無分類器引導機制強化文本相關特徵的表達。最終,LRM 在帶噪隱空間中直接輸出偏好分數,實現對圖像對的排序與評估。

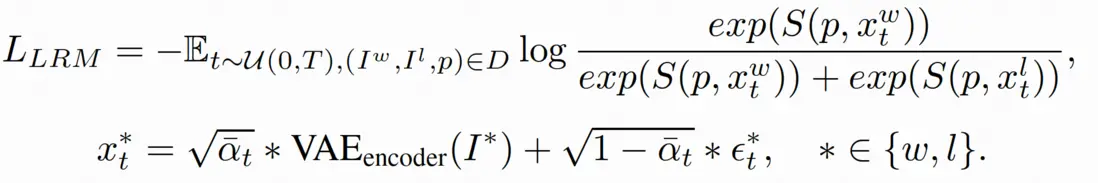

LRM 計算文本特徵和圖像特徵的點積作為最終獎勵,使用 Bradley-Terry (BT)損失進行訓練

2.Multi-Preference Consistent Filtering(MPCF):高質量偏好數據篩選

為了訓練出更穩健的獎勵模型,本論文提出了一種多偏好一致性篩選策略(MPCF),用於從公開數據集中構建高質量的偏好對。以 Pick-a-Pic 數據集為例,原始數據中存在大量“勝出圖像在某一方面優於敗者,但在其他方面劣於敗者”的情況,這種偏好不一致會嚴重影響模型訓練效果。MPCF 策略從美學評分、CLIP 分數、VQA 分數等多個維度對圖像對進行篩選,確保勝出圖像在多個關鍵指標上均優於敗者圖像。通過這種方式,LRM 能夠在訓練中獲得更一致、更可靠的偏好信號,從而提升其對齊能力與泛化性能。

3.Latent Preference Optimization(LPO):步驟級偏好優化新方法

基於 LRM,本論文提出隱空間的逐步偏好優化方法 LPO(Latent Preference Optimization),其在擴散模型的隱空間進行在線採樣,並利用 LRM 對樣本進行打分和篩選,然後在隱空間對模型進行偏好優化。LPO 可以在整個去噪過程(t ∈ [0, 950])中進行優化,而傳統方法如 SPO 僅能覆蓋低中噪聲段(t ∈ [0, 750]),這進一步體現了 LRM 在高噪聲條件下的魯棒性與適應性。

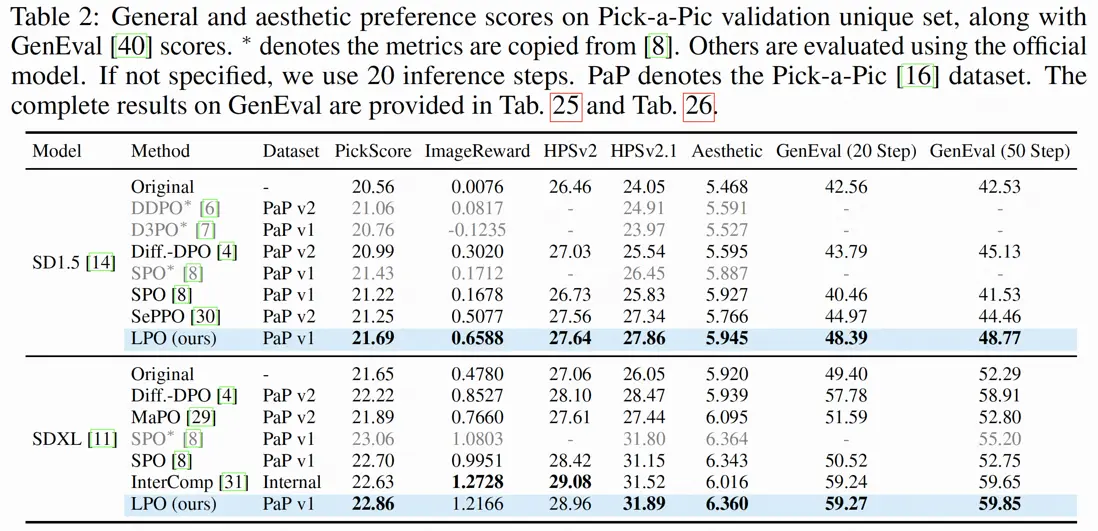

📈 實驗結果LPO

方法在整體人類偏好得分、圖文對齊能力、圖像美學質量等多個維度均大幅提升模型性能,在 PickScore、ImageReward、HPSv2 和 Aesthetic Score 等指標上均顯著優於現有方法。

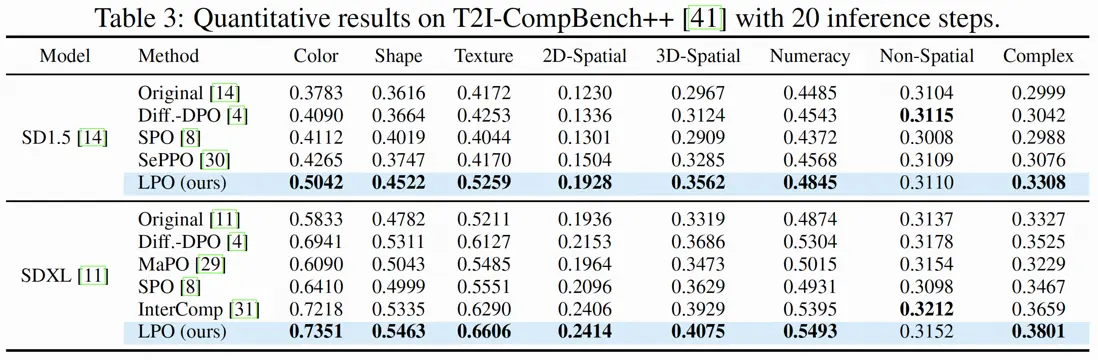

在更具挑戰性的 T2I-CompBench++ 基準上,LPO 在顏色、形狀、紋理、空間關係等維度均取得領先成績,尤其在顏色與紋理生成方面,提升超過 10%。

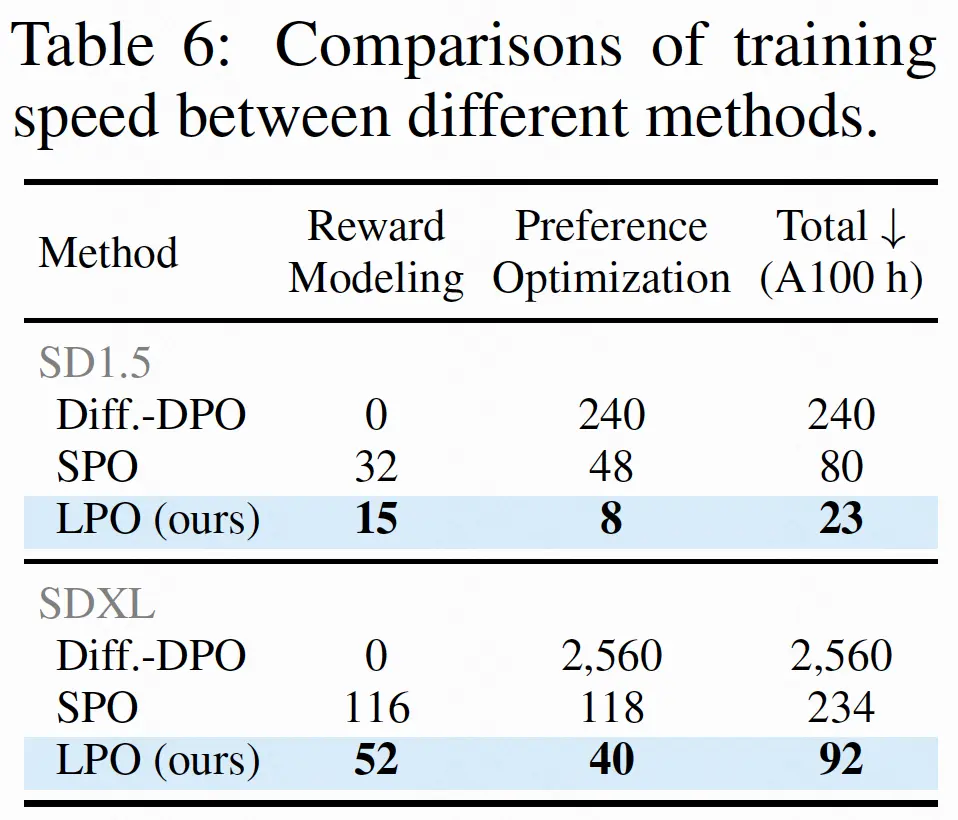

除了性能提升,LPO 在訓練效率方面也實現了質的飛躍。以 SDXL 為例,LPO 的總訓練時間僅為 92 小時,而傳統的 Diffusion-DPO 方法需 2560 小時,SPO 也需 234 小時。LPO 的訓練速度分別是兩者的 28 倍和 2.5 倍,極大地降低了模型對齊的計算門檻。

🔮 總結與展望

本論文提出了 LRM 與 LPO 方法,首次系統性地將擴散模型自身轉化為獎勵模型,並在帶噪隱空間中完成偏好優化,突破了傳統像素級方法的瓶頸。同時,我們將 LRM 方法應用於不同的強化學習算法,如 step-wise 的 GRPO,並且將 LRM 和 LPO 方法拓展至基於 DiT 架構和 Flow matching 策略的 SD3 模型上,均取得了不錯的效果。未來,LRM 與 LPO 有望成為圖像/視頻生成模型對齊的基礎工具,推動生成式 AI 邁向更高質量、更強一致性的新階段。