“情智兼備”是新一代人工智能邁向通用人工智能的重要方向。在人機交互中,從動態視頻理解並預測人類複雜演變的情感是一項重要挑戰,在安防、醫療等領域應用前景廣闊。儘管現有方法在基礎情感分類上表現良好,但難以有效建模情感的動態性與上下文依賴。當前視頻大語言模型雖提供了新思路,卻仍缺乏將面部線索融合為高層次情感表徵的能力,難以實現兼具情感智能與理性可解釋的預測。

針對這一瓶頸,快手可靈團隊與南開大學計算機視覺實驗室在「多模態視頻情感理解」領域開展了創新研究,成功定位了現有多模態大模型在理解視頻情感時的關鍵短板。提出了一種基於情感線索引導的推理框架,以分階段的方式統一基礎屬性感知、表情分析與高層情感理解。

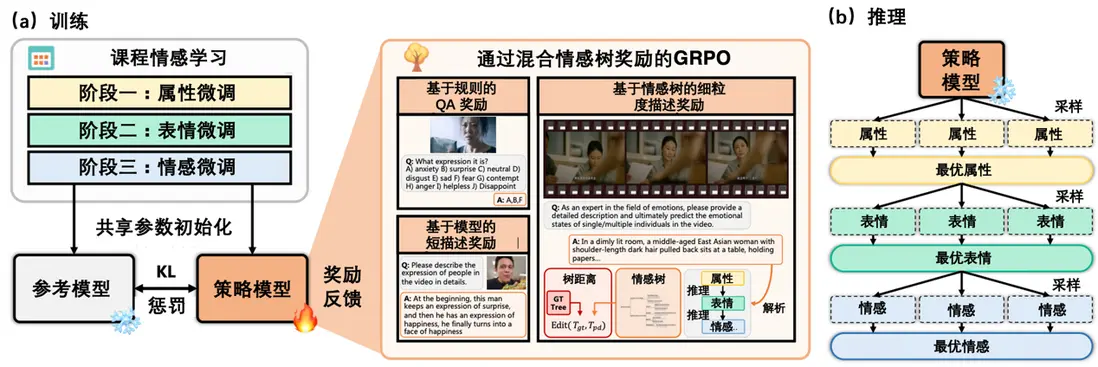

模型經過兩個階段的優化訓練:第一階段通過課程式情感學習注入情感知識,第二階段則採用情感樹強化學習提升情感推理能力。此外,研究團隊構建了數據基礎設施,引入了以情感為中心的細粒度數據集(Emo-CFG),包含 210 萬條多樣化的指令型樣本。該數據集涵蓋了可解釋的情感問答、細粒度描述及其對應的解釋依據,為推動情感理解任務提供了關鍵資源。所提方法在 15 項人臉感知任務中表現出色,樹立了新的性能標杆。目前,該研究成果已被 NeurIPS 2025 錄用。

論文標題:VidEmo: Affective-Tree Reasoning for Emotion-Centric Video Foundation Models

論文地址:https://arxiv.org/html/2511.02712

項目主頁:https://zzcheng.top/VidEmo

3B 模型:https://huggingface.co/KlingTeam/VidEmo-3B

7B 模型:https://huggingface.co/KlingTeam/VidEmo-7B

數據地址:https://huggingface.co/datasets/KlingTeam/Emo-CFG

代碼地址:https://github.com/KlingTeam/VidEmo

相關工作:https://github.com/nku-zhichengzhang/Awesome-emotion_llm_and_mllm

一、研究背景

從動態視頻中理解和預測人類情感[1]是計算機視覺領域日益重要的一項挑戰,其在人機交互、監控系統和醫療健康等領域具有廣泛的應用前景。儘管現有先進方法在基本情感分類任務上取得了顯著成果,但在對複雜且不斷演變的情感狀態進行合理預測方面仍存在侷限。這主要是由於情感本身具有動態性和上下文依賴性,因此需要模型具備高水平的情感智能,同時能夠輸出理性且可解釋的結果。

近期,視頻大語言模型(VideoLLMs)的興起為這一領域提供了有希望的基線路徑。然而,這些基礎模型通常難以實現高層次的情感理解,因為它們缺乏將基本面部屬性有效融合為複雜情感表徵的能力。即便是最先進的里程碑模型 Gemini2.0,在細粒度情感分析任務中的準確率也僅為 26.3%,凸顯了該領域在性能上的差距以及進一步創新的迫切需求。

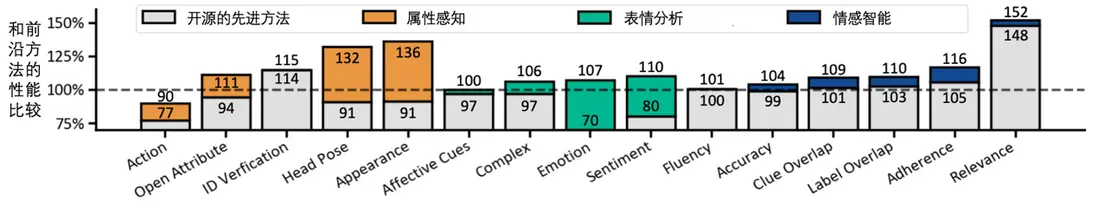

為應對這些挑戰,我們提出了 VidEmo,一個基於樹結構的新型情感線索引導推理框架,該框架集成了三個核心組件:基礎屬性感知、表情分析和高層次情感理解(參見圖 1)。在 15 項人臉感知任務中,VidEmo 超越了全部現有的開源視頻大模型,包括之前最先進的基準模型 Gemini 2.0(參見圖 2)。具體地,VidEmo 受到了近期推理工作的啓發,這些模型在提供可解釋依據方面表現出色,它們通過結合思考過程與模型操作來解決複雜任務。

我們的研究發現,同樣的推理過程可以應用於高層次的情感理解,通過引入分階段思考,圍繞屬性感知、表情分析和情感理解構建結構化流程。我們為 VidEmo 配備了課程式情感學習和情感樹推理,在預訓練和後訓練階段分別注入情感推理路徑。

- 在預訓練階段,課程式情感學習逐步調整模型從基本面部屬性到更復雜的情感狀態。

- 在後訓練階段,情感樹推理幫助模型使用層次結構細化其情感理解,確保情感反應既準確又可解釋。

這種兩階段過程使得 VidEmo 能夠有效地分析和推理動態視頻數據中的情感。

此外,我們還構建了一個以情感為中心的細粒度數據集 Emo-CFG,專門設計用於情感理解任務的基礎數據。Emo-CFG 是一個包含 210 萬條樣本的大規模數據集,具有以情感為核心標籤、嚴格的數據驗證機制、高度多樣性等特點,確保在廣泛的情感上下文中實現全面且可靠的標註。通過豐富的標註信息和多樣化的場景覆蓋,Emo-CFG 使 VidEmo 能夠從情感推理路徑中高效學習細粒度的情感理解能力。

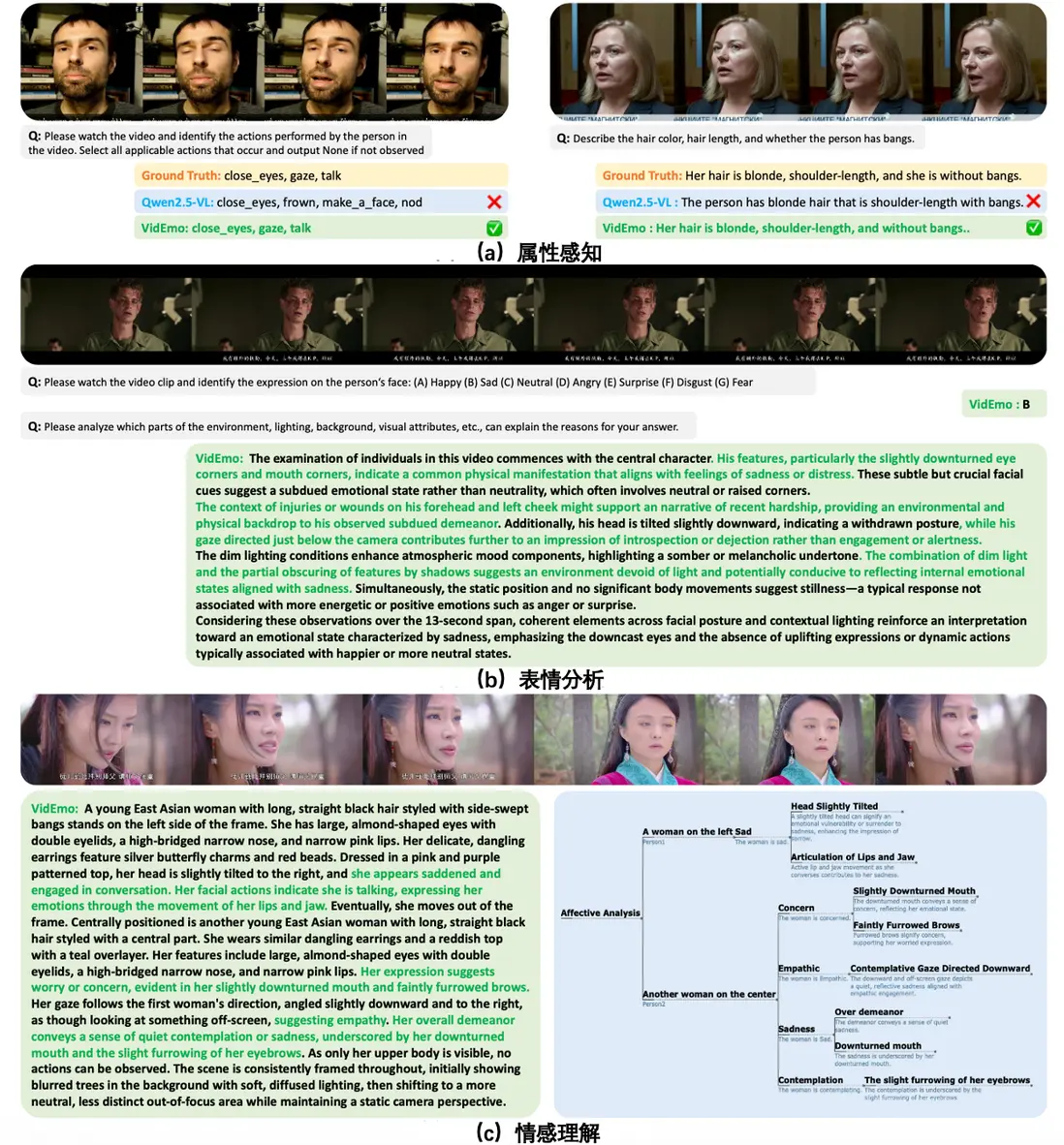

圖 1: VidEmo 的輸入與輸出示例。除了提供基礎屬性感知與表情分析的工具集(上),VidEmo 還拓展了認知能力,能夠生成具有可解釋依據的細粒度情感描述(下)。

圖 2: 結果概覽。我們的最佳模型在 15 項人臉感知任務中均展現出優越性能。

二、Emo-CFG: 以情感為中心的細粒度視頻數據集

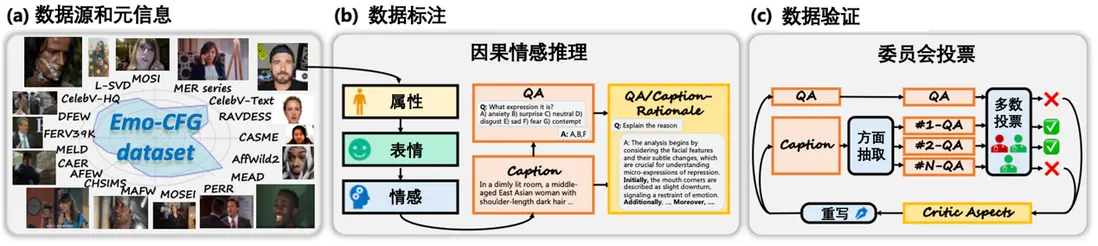

Emo-CFG 數據集旨在推動對視頻中動態情感的理解。受訓練情感推理模型對高質量、以情感為中心的數據需求的驅動,Emo-CFG 針對多樣化的情感、可靠的標註以及嚴格的驗證等關鍵挑戰進行了專門設計。我們在圖 3 和圖 4 中展示了 Emo-CFG 的數據構建流程與統計信息。

2.1數據來源與元信息。

數據收集始於高質量的視頻數據集。數據來源包括來自頭部、半身和全身人像的 17 個數據集。通過使用多種類型的數據,確保從整體視角理解視覺與情感數據中的細微差異。此外,保留了每段視頻的元信息,包括人臉邊界框、視頻時長、視頻分辨率和視頻幀率。

2.2Caption & QA 指令數據標註。

採用兩類主要數據源進行標註:大規模無標註數據集用於覆蓋廣泛場景,以及小規模全標註數據集用於確保精度。對於已標註數據集,使用 GPT-4o 生成指令對,並構建多種模板形式,包括選擇題、開放式問答和短句描述。對於無標註數據集,採用一種因果式情感推理策略,以逐階段、序列化的方式生成標籤。

具體來説,給定一段視頻,首先利用當前最先進的 Gemini 2.0 模型,提示其按順序生成關於屬性、表情和情感的細粒度 Caption 數據。隨後,使用 GPT-4o 生成針對視頻不同方面的 QA 對。通過整合這些屬性與表情標籤,能夠準確推斷出潛在的情感狀態,從而實現對情感狀態的細緻且豐富的理解。

2.3Caption − R & QA − R 歸因依據數據標註。

在指令數據的基礎上,進一步探索低級屬性與高級情感之間的關係。引導模型對情感線索背後的理性依據進行自我反思,即 QA 和 QCaption。這一過程不僅通過揭示情感表達背後的原因增強了模型的可解釋性,也為提升模型的推理能力提供了關鍵訓練階段。

2.4Critic 數據驗證:投票機制。

為應對情感數據因主觀性帶來的模糊,採用基於委員會投票的數據驗證策略。使用三個異構的 VideoLLMs 構成一個評審委員會,用於驗證數據的正確性並輸出 Critic 條目,包括錯誤答案及建議修正。通過驗證的數據將被保留,未通過驗證的數據則根據建議修正重新生成。此外,還從描述數據中提取不同維度信息,並將其拆分為多個 QA 對,以確保與問答流程的一致性。

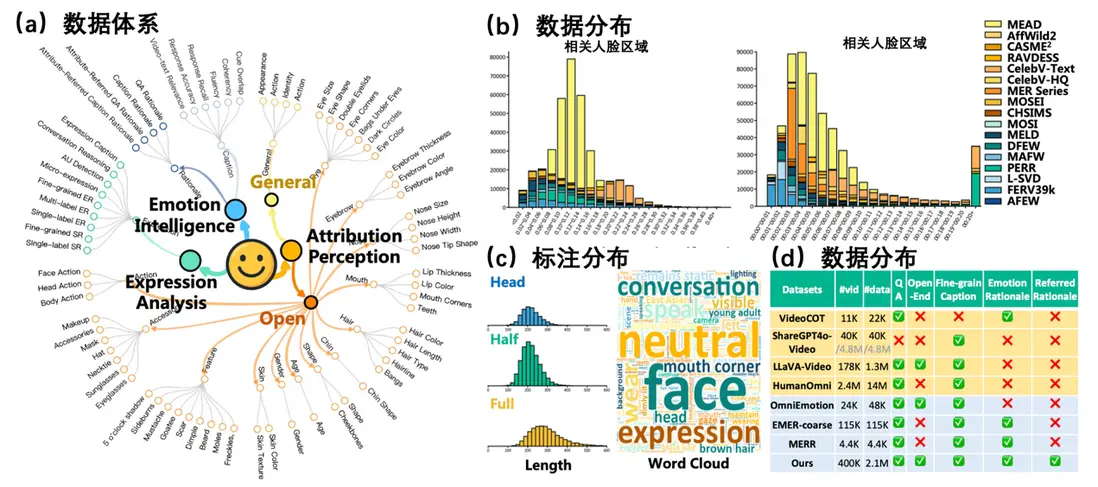

2.5Emo-CFG 數據統計。

圖 4 展示了 Emo-CFG 數據集的關鍵統計數據。在(a)中,數據分類體系將數據集劃分為三項主要的人臉感知任務:情感智能、表情分析和屬性感知,涵蓋了廣泛的人臉特徵與情感屬性。(b)的數據分佈圖展示了不同數據集中人臉區域比例與視頻時長的分佈情況,體現了 Emo-CFG 所包含視頻數據的多樣性和豐富性。(c)的標註分佈包括了人臉視角(頭部、半身、全身)和視頻長度的構成,並附有詞雲圖,突出了最常出現的標註關鍵詞,如中性、人臉和表情。(d)的數據統計對比顯示,與其他情感和視頻數據集相比,Emo-CFG 提供了更豐富的標註類型和標籤維度,包括細粒度情感標籤、歸因依據以及全面的視頻信息,使其成為以情感為中心的研究中獨特且寶貴的資源。

圖 3: Emo-CFG 數據集的數據構建流程。

(a)數據來源,涵蓋來自 17 個不同數據集的素材。(b)數據標註步驟示意圖,展示了從原始視頻到結構化標註的全過程。(c)數據驗證循環,人工審核與模型輔助質檢相結合的迭代驗證機制。

圖 4: Emo-CFG 數據集的統計概覽。

(a)來自三類人臉感知任務的數據分類體系。(b)視頻數據在時間和空間維度上的分佈情況。(c)數據標籤的分佈與示例,涵蓋屬性、表情和情感等多個層面。(d)與其他情感和視頻數據集的對比,展示 Emo-CFG 在標註豐富性和任務多樣性方面的優勢。

三、VidEmo:視頻情感基礎模型

為了開發一系列以情感為中心的視頻基礎模型,提出了一套全面的工具包,用於預訓練、後訓練和推理,如圖 5 所示。通過結構化的預訓練過程注入情感知識,隨後進行後訓練以增強模型的推理能力。最終,在推理階段,模型能夠有效生成情感輸出,利用所學習到的屬性、表情和情感。

圖 5: VidEmo 的訓練流程圖

3.1 預訓練:課程情感學習

為了向基礎模型中注入情感知識,採用課程情感學習逐步調整基礎模型。訓練分為三個階段:I) 屬性調整,II) 表情調整,III) 情感調整。預訓練專注於整理數據,平衡情感任務的難度同時解決困惑度問題。在每個階段,我們都精心整理數據,確保情感相關的任務逐漸增加複雜性。從簡單的屬性開始,並逐步轉向更復雜的表情和情感,確保模型建立對情感的強大基礎理解,這有助於在整個過程中更平滑地注入情感知識。

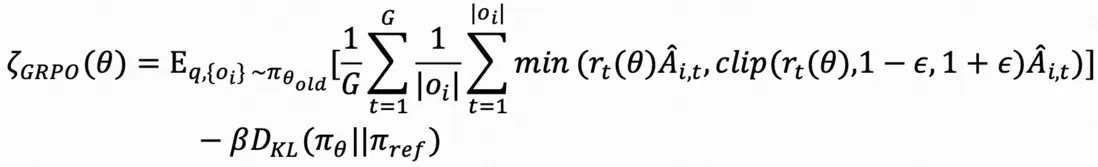

3.2 後訓練:通過混合情感樹獎勵的強化學習

基於已注入情感知識的基礎模型,進入後訓練階段探索情感推理路徑。最近的強化學習技術在推理方面展示了強大的能力,GRPO 由於其簡單性和有效性而受到廣泛關注。這使得 GRPO 成為我們工作的理想起點。正式地説,設為查詢,GRPO 從舊策略模型中採樣一組輸出,數量為,並通過最大化以下目標來訓練策略模型:

其中是基於組內相對獎勵的優勢值,和分別是 KL 懲罰係數和剪裁閾值,而 , , 分別是當前、舊和參考策略模型。

基於規則的 QA 獎勵。

模型根據預定義的準確率和 F1 分數規則評估其響應情感相關查詢的能力。評估任務包括分類(單標籤、多標籤)、細粒度分類、微表情檢測和動作單元(AU) 檢測。

基於模型的短描述獎勵。

對於動作、外觀和情感的短描述,使用一個生成獎勵模型來評分模型生成的描述的質量。

基於情感樹的細粒度描述獎勵。

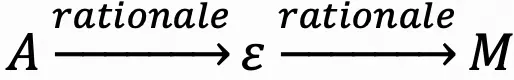

為了評估模型進行結構化情感推理的能力,引入了一個基於細粒度描述構建的層次情感樹的獎勵機制。給定生成的描述,首先將其解析為三個語義層次上的方面-項目對:屬性(),表達() 和情感()。這些元素被組織成三層情感樹,其中每個節點代表提取的項目,有向邊編碼基於理由的依賴關係——即,

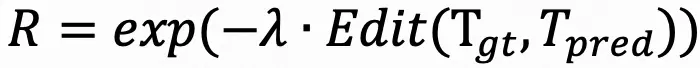

將預測樹 與從人工標註描述解析的真實樹進行比較,使用樹編輯距離 Edit(Tgt, ) 來量化將一棵樹轉換為另一棵樹所需的最小編輯操作(插入、刪除、替換)數量。最終獎勵 R 使用指數衰減計算樹距離:

其中λ > 0 是控制獎勵對樹差異敏感性的縮放因子。這種公式鼓勵模型不僅在內容上準確,而且在結構上可解釋,符合人類對情感理解的推理模式。

3.3 推理:高層次情感理解的推理

VidEmo 採用分階段訓練,可以順利與基於搜索的推理策略相結合。具體來説,採用一種層次化的、基於搜索的推理方法,將情感理解分解為三個層次:屬性感知、表情分析和情感推斷。在每個層次上,策略模型採樣多個候選輸出,並通過獎勵引導的評分機制選擇最佳輸出,形成自底向上的推理軌跡。

四、實驗結果

①性能提升:

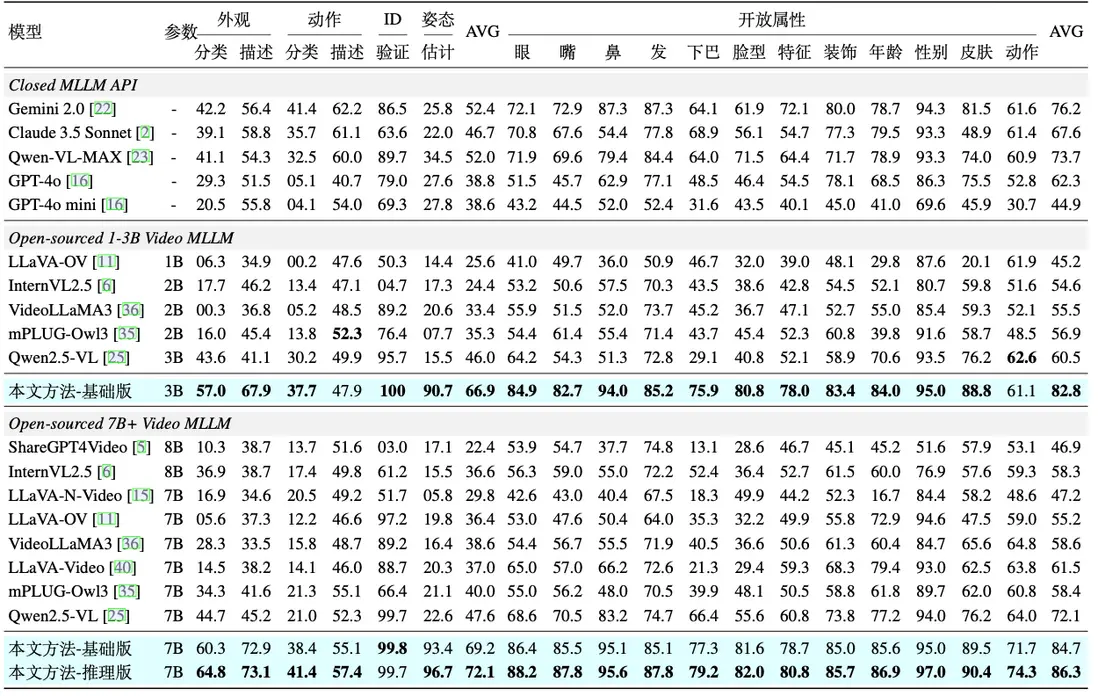

- 人臉屬性感知能力:如表 1 所示,VidEmo 在 Emo-CFG 數據集的 14 項人臉屬性感知任務上的性能展現出明顯優勢。

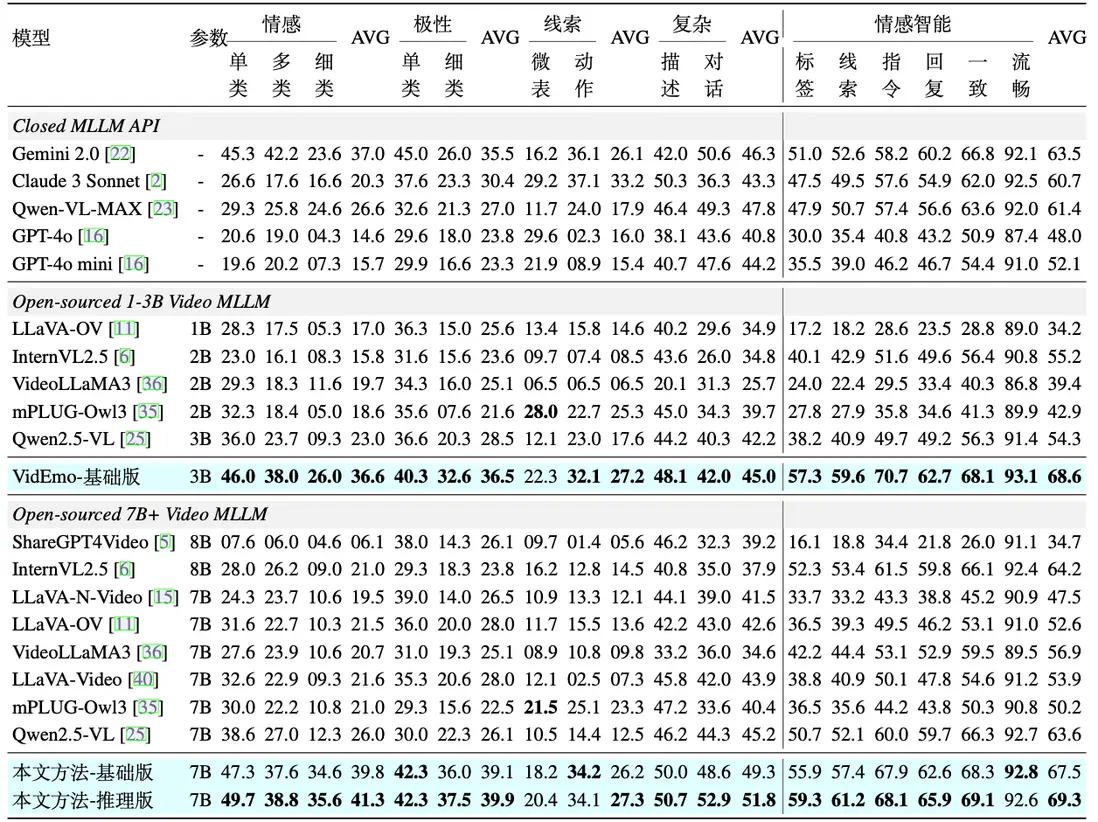

- 表情分析能力: 如表 2 所示,VidEmo 在 Emo-CFG 數據集的 11 項表情分析任務上的性能也得到顯著提升。

- 細粒度情感理解:在情感理解任務中,涵蓋指令遵循、語言流暢性、響應準確性及視頻-文本相關性等維度。VidEmo 平均得分優於包括所有先前模型。

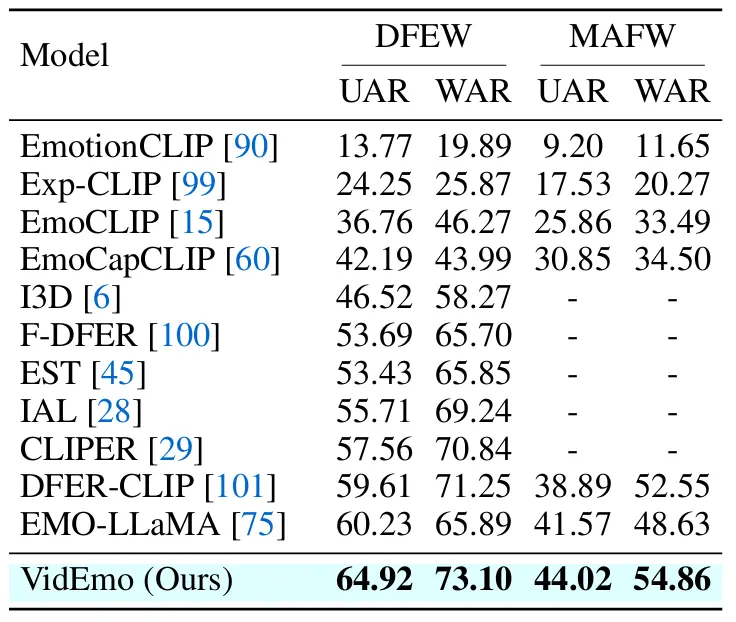

- 情感分類能力:在公開視頻情感分類數據集 DFEW 和 MAFW 中,VidEmo 依然取得了最好的結果。

表 1: 在 Emo-CFG 數據集的 14 項人臉屬性感知任務上與 18 個主流視頻大模型的對比結果,包括 6 項閉集屬性感知任務和 12 項開集屬性感知任務。

表 2: 在 Emo-CFG 數據集的 11 項表情分析任務與 6 項細粒度情感理解任務上與 18 個主流視頻大模型的對比結果。

表 3: 在 DFEW 和 MAFW 數據集的表情分類的對比結果。

圖 6: 屬性感知、表情分析與情感理解的可視化結果

②可視化:圖 6 展示了我們的模型在三個關鍵方面的可視化結果:屬性感知、表情分析和情感理解。

- 屬性感知:模型能夠準確識別面部屬性,如髮色、髮長以及是否有劉海,並通過與真實標籤的對比清晰地展示了驗證結果。例如,模型正確識別出某人的頭髮為金色、及肩長度,並區分了是否有劉海的存在。

- 表情分析:模型能夠分析細微的面部表情,識別諸如眼神下垂、頭部姿勢等特徵。正如圖中第二部分所示,這些面部和上下文線索(如光照和身體動作)為理解人物的情感狀態(如悲傷或沉思)提供了重要依據。

- 情感理解:通過整合面部特徵與上下文線索,模型對情感狀態進行了詳細的解讀。例如,在圖的最後一部分中,模型識別出一種沉思的情感狀態,其依據包括略微傾斜的頭部、皺起的眉頭以及細微的眼神變化。

參考文獻

Sicheng Zhao, Guoli Jia, Jufeng Yang, Guiguang Ding, Kurt Keutzer. Emotion recognition from multiple modalities: Fundamentals and methodologies. IEEE Signal Processing Magazine, 38(6): 59-73, 2021.