當用户向大語言模型提出一個簡單問題,比如“單詞HiPPO裏有幾個字母P?”,它卻正襟危坐,開始生成一段冗長的推理鏈:“首先,讓我們分析HiPPO這個詞,河馬的英文單詞為hippo,河馬是一種半水生哺乳動物,這裏用户用了大寫字母,可能有特殊的含義,對於單詞HiPPO,我們可以將其拆分為H-i-P-P-O,字母P出現在第3與第4個位置,因此有2個字母P...讓我們簡化問題,HiPO可以拆分為...”

面對這樣的“嚴謹”,用户難免哭笑不得,既浪費了計算資源,也增加了等待時間,甚至更壞的情況是模型被自己冗長的推理鏈“繞暈了過去”,最終給出了錯誤的答案,用户只得捶胸頓足地大喊:“這合理嗎?”

這種現象,正是當前追求強大推理能力的LLM們普遍面臨的“過度思考”(Overthinking)困境。無論是數學計算、代碼生成還是邏輯問答,模型似乎習慣了“啓動即深思”的模式,即使面對本可直觀回答的簡單問題,也要展開一番鏈式思考(Chain-of-Thought, CoT),導致token使用量激增、推理延遲變長、部署成本高昂。如何在保持複雜問題解決準確性的同時,避免在簡單任務上“空轉”、在複雜任務上高效“運轉”,成為LLM走向實用化的一大關鍵挑戰。

如今,快手 KwaiKAT 團隊與南京大學劉佳恆老師 NLINK,張煜羣教授實驗室 ARiSE 合作重磅推出HiPO(Hybrid Policy Optimization)框架,為LLM裝上了智能的“思考開關”。該框架通過創新的混合數據冷啓動與混合強化學習獎勵系統,使模型能夠自主、動態地決策何時該啓動詳細推理(Think-on),何時該直接給出答案(Think-off)。

這不僅顯著提升了推理效率,更在多個核心基準測試上實現了準確率的同步提升,為構建高效、實用的下一代推理大模型提供瞭解決方案。

論文鏈接:https://arxiv.org/abs/2509.23967

項目鏈接:https://huggingface.co/Kwaipilot/HiPO-8B

一、困境之源:LLM的“思考”代價與“過度思考”頑疾

大語言模型在複雜認知任務上的巨大成功,很大程度上歸功於鏈式思考(CoT) 推理範式的引入。讓模型像人一樣“一步一步想問題”,極大地提升了其在數學、編程、科學問題解決等領域的表現。然而,這套強大的推理機制也帶來了“認知慣性”:模型傾向於對所有問題都“一視同仁”地進行深度推理。

- 效率與成本的矛盾:始終生成冗長的推理軌跡是低效的。它直接轉化為極高的Token使用量,意味着更慢的響應速度(延遲)和更昂貴的API調用或自建推理成本。在追求交互體驗和成本控制的真實應用場景中,這成為了一個致命的短板。

- “過度思考”的普遍性:近期多項研究都明確指出,LLM存在普遍的過度思考現象。即使是最先進的模型,也常常在簡單問題上“小題大做”,生成大量冗餘推理步驟,造成了計算資源的巨大浪費。在複雜問題上,模型也常常出現反覆冗餘思考的現象,導致回答出錯。

現有的解決方案試圖緩解這一問題,但各有侷限:

- 基於訓練的自適應推理:通過強化學習(RL)引入長度懲罰或簡潔性獎勵,或通過監督微調(SFT)偏好更短的推理。但這類方法信號粗糙,可能因單調的“縮短”激勵而損害模型處理難題的能力。

- 外部控制:通過精心設計的提示詞或動態指令來限制推理步驟。這種方法靈活但依賴人工設計,難以規模化且泛化能力存疑。

- 事後優化:在推理鏈生成後進行剪枝或重構。這屬於“事後補救”,無法從根源上改變模型的思考模式。

核心問題在於,缺乏一個原則性的機制,來精細地平衡準確性、回答效率之間的權衡,讓模型學會“具體問題,具體分析”。

二、HiPO破局之道:雙輪驅動的“智能思考開關”

HiPO框架的核心思想是將“是否思考”的決策權交給模型自身,並通過系統性的訓練方法,確保其決策的智能性與平衡性。其創新性主要體現在兩大核心組件上:

組件一:混合數據冷啓動——為模型裝上“智能思考開關”

要讓模型學會選擇,首先需要讓它見識過“思考”和“不思考”兩種模式下的高質量回答是什麼樣的。HiPO設計了一套精密的自動化數據構建流程,並使用混合數據進行冷啓動。

- 數據收集與分類:研究團隊整合了多個高質量的公開及專有數學與代碼推理數據集(如AM-Thinking-v1-Distilled, AceReason-Math, II-Thought-RL, Skywork-OR1-RL-Data),構建了一個高質量的訓練語料庫。

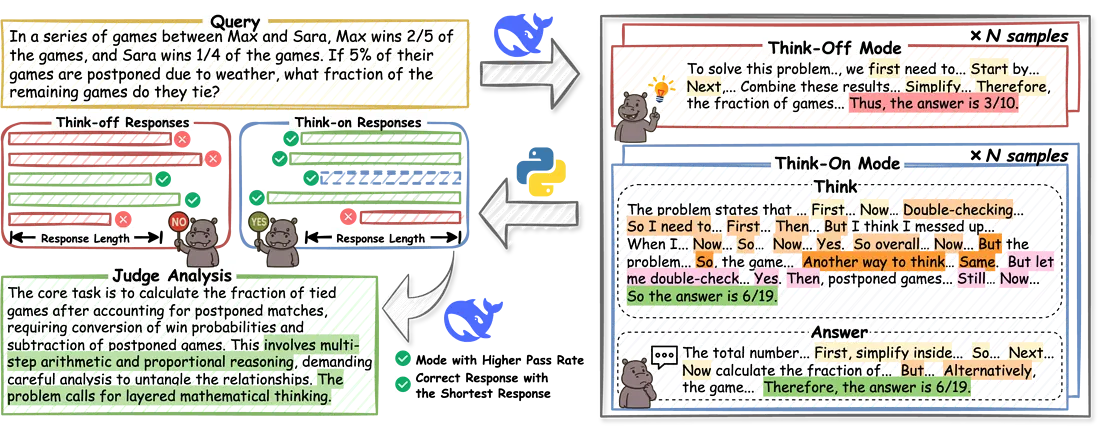

- 雙模式響應生成與優選:對於每個問題,使用一個強大的推理模型(如DeepSeek-V3)分別生成N個“Think-on”(帶推理)和N個“Think-off”(直接回答)的響應。然後,自動驗證所有回答的正確性。

- 關鍵優選策略:比較兩種模式的通過率(Pass Rate)。如果“Think-on”模式的通過率顯著高於“Think-off”,則選擇“Think-on”模式;反之則選擇“Think-off”。特別巧妙的是,當兩種模式通過率相差無幾(低於閾值δ)時,策略會傾向於選擇“Think-off”模式。這一設計直接鼓勵模型在深度思考不能帶來明顯收益時,優先選擇更簡潔的回答,從數據源頭注入效率意識。

- 最短正確響應:在獲勝的模式下,選擇最短的正確響應作為最終樣本,進一步強化簡潔性。

- 引入模式解釋信號:為了強化模型對模式選擇的理解,HiPO還引入了一個輔助解釋信號。對於每個優選出的問答對,會使用DeepSeek-V3生成一段理由(Justification),解釋“為什麼這個問題適合(或不適合)進行深度推理”。這為模型提供了寶貴的元認知信號,幫助其將模式選擇與問題內在的複雜性對齊。

這套管道最終產出的數據,每條都包含了問題、最終回答、以及關於思考模式的理由。在這些數據上對模型進行冷啓動,使得模型初步具有了“智能思考”的能力。

組件二:混合強化學習獎勵系統——精細化引導模型的“決策天平”

有了高質量的數據進行“冷啓動”(Cold-Start)訓練後,HiPO通過一個設計精巧的混合強化學習(RL)階段,對模型進行微調,使其決策能力臻於完善。該獎勵系統的核心目標是防止模型過度依賴看似更可靠的“Think-on”模式,實現真正的自適應。

- 基礎獎勵:每個生成的回答會根據其答案正確性(ACC)和格式正確性(FORMAT)獲得一個基礎獎勵分。

- 偏差調整機制——防止“思考”慣性:這是HiPO的一個關鍵創新。由於“Think-on”模式通常更準確,模型在RL過程中容易產生偏向,無論問題難易都選擇“思考”。為了解決這一問題,HiPO引入了動態的偏差調整機制。

- 它會計算“Think-on”模式響應的平均獎勵,然後為“Think-off”模式設定一個偏置項(bias_off),該偏置項是“Think-on”平均獎勵的一個比例(由ω控制,通常設為0.01)。

- 當“Think-off”模式的性能不顯著優於“Think-on”,但差距在一定範圍內時,會啓動調整,適當提升“Think-off”模式的評估得分。

- 這一機制有效防止了模型通過“無腦”選擇冗長推理來獲取獎勵的投機行為,確保了訓練穩定性,並維護了深度與效率之間的 intended balance。

- 混合優勢函數——雙重監督:HiPO設計了兩個獨特的優勢(Advantage)函數來提供更精細的指導信號:

- 評判優勢(A_judge):關注於模式選擇的合理性。它結合了“所選模式的全局平均優勢”和“當前響應在其模式內的相對質量”,確保模型選擇某個思考模式的理由(即之前生成的Justification)與其實際表現一致。

- 回答優勢(A_answer):聚焦於回答本身的質量。它在同一思考模式內進行局部歸一化,鼓勵模型在既定模式下生成更好的回答,而不與模式選擇的偏好混淆。

最終,這兩個優勢信號被分別賦予給回答中對應的“理由”部分和“答案”部分的每個令牌,實現令牌級別的精細化優化。整個RL過程採用類似PPO的算法,在最大化期望獎勵的同時,約束策略更新幅度,防止偏離太遠。

三、實驗結果:不僅更快,而且更準

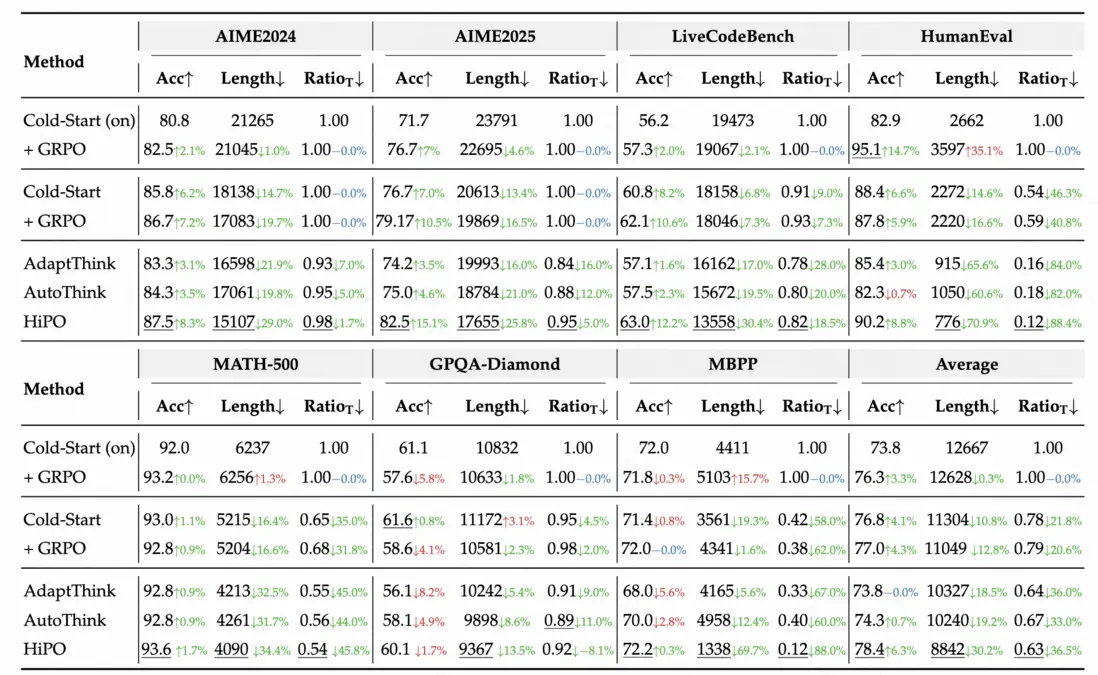

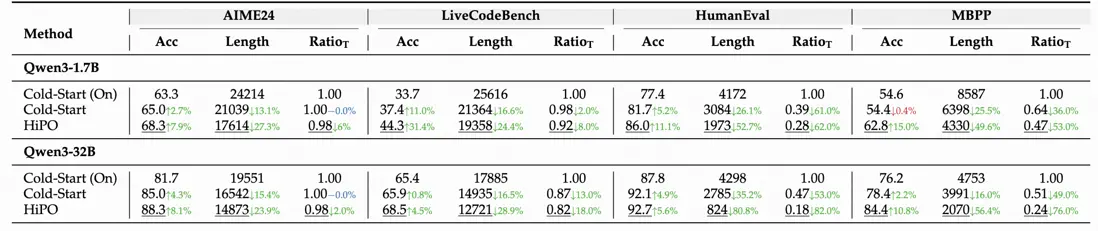

HiPO在基於Qwen3系列模型(如8B參數版本)的實驗中,取得了令人矚目的成果。在AIME2024/2025、HumanEval、LiveCodeBench(v6)、MATH-500、GPQA-Diamond等多個權威基準測試上,與多種基線方法進行了全面對比,並進行了充分的消融實驗。

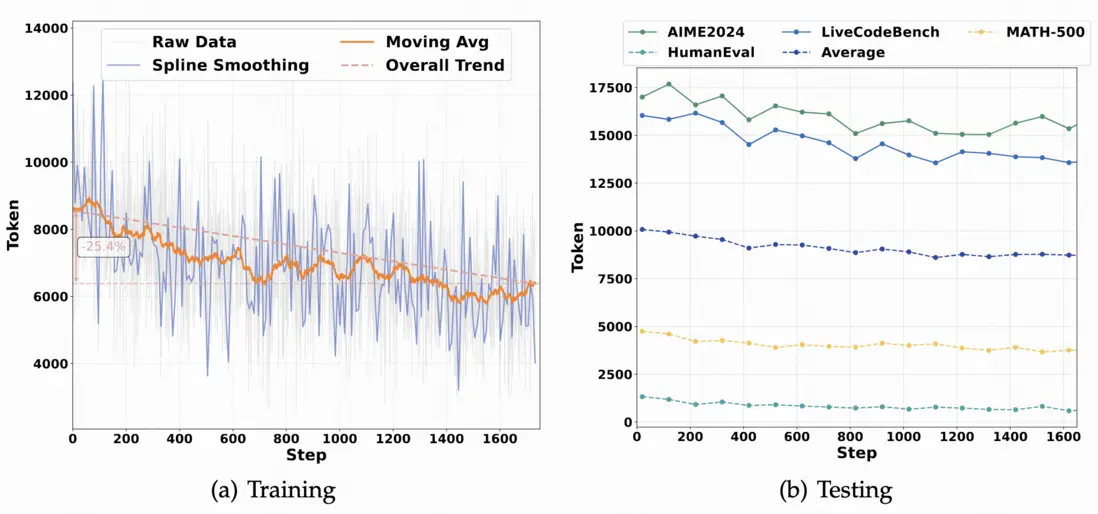

- 顯著提升效率:與僅使用“Think-on”數據訓練的模型相比,最終HiPO模型在平均令牌長度上減少了30%,思考率(RatioT)降低了37%。這意味着模型在處理大量問題時,能智能地跳過不必要的推理,直接輸出答案,帶來了實實在在的成本和延遲收益。

- 同步提升準確率:更令人驚喜的是,HiPO在實現效率飛躍的同時,平均準確率提升了6.3%。這證明其自適應機制不僅沒有損害性能,反而通過優化決策,讓模型在難題上更“專注”地思考,在簡單題上更高效地回答,實現了雙贏。

- 超越現有方法:實驗表明,HiPO在準確性和效率的綜合表現上,優於AdaptThink、AutoThink等現有的自適應推理方法。動態決策分析:研究團隊還深入追蹤了模型在訓練和推理過程中的行為演變。

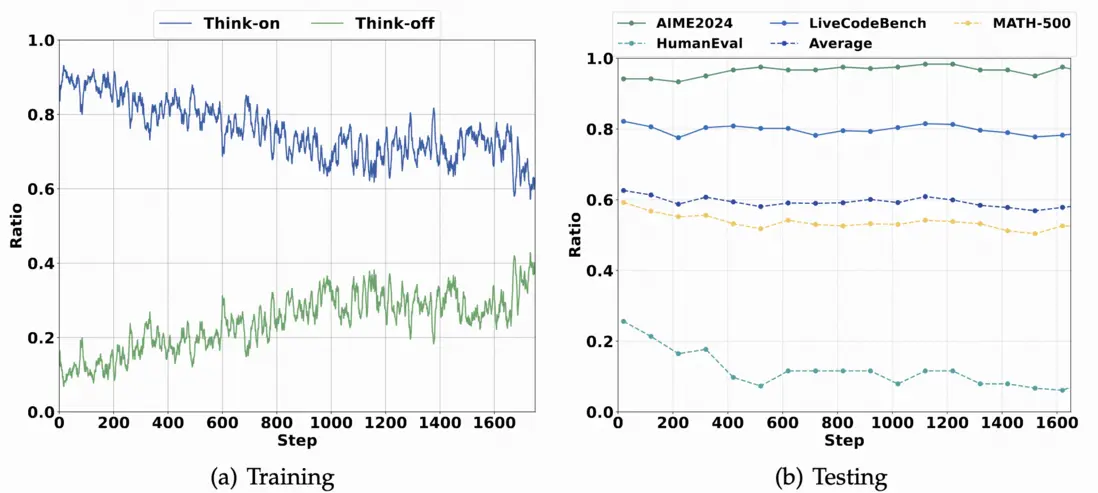

如上圖(a)所示,隨着RL訓練的進行,模型激活“Think-on”和“Think-off”的頻率差距逐漸縮小,從初期的89.5%降至最終的53.1%,説明模型確實學會了更精細地切換模式。

上圖(b)顯示,在不同數據集上,模型的思考模式激活率與任務特性高度相關。在AIME2024、LiveCodeBench等需要強推理的任務上,“Think-on”率始終保持在70%以上;而在HumanEval等相對簡單的代碼任務上,“Think-on”率則隨訓練明顯下降,體現了良好的任務適應性。

上圖(a)和上圖(b)清晰地展示了RL訓練過程中以及在不同數據集上,模型輸出令牌數量的持續下降趨勢,直觀反映了HiPO在提升效率方面的有效性。強泛化性:HiPO的成功不僅在Qwen3-8B上得到驗證,在Qwen3-1.7B和Qwen3-32B等不同規模的模型上也展現出一致的性能提升,證明了其方法的普適性。

四、未來展望:HiPO如何重塑高效LLM生態

HiPO框架的提出,不僅僅是一項技術突破,更是為LLM的發展方向提供了一個重要的思路轉變:從一味追求“更強思考”到追求“更智能地思考”。

- 推動LLM實用化落地:對於需要大規模部署LLM的應用(如搜索引擎、智能客服、代碼助手),HiPO能直接降低計算成本和響應延遲,使高性能LLM服務變得更加“親民”。

- 為模型輕量化提供新路徑:通過讓模型學會“停止思考”,可能在保持相當性能的前提下,為模型壓縮和蒸餾開闢新的可能性。

- 增強模型的“元認知”能力:HiPO訓練模型對自身認知過程進行監控和決策,這是向具備更高層次智能的AI系統邁出的重要一步。

五、結語

當大語言模型陷入“為思考而思考”的認知慣性時,其巨大的潛力被低效的運作方式所束縛。快手與南大團隊的HiPO框架,如同一位高明的教練,不是粗暴地限制模型的“思考”,而是教會它判斷“何時該深思熟慮,何時可一擊即中”。這項研究巧妙地平衡了推理的“質”與“效”,為構建真正高效、可靠、適用於真實世界的下一代人工智能助手奠定了堅實的基礎。在LLM競速發展的下半場,“智能效率”或許將是比“暴力計算”更重要的決勝籌碼。

目前,HiPO的相關模型和資源已在Hugging Face平台開源,供社區研究和使用。