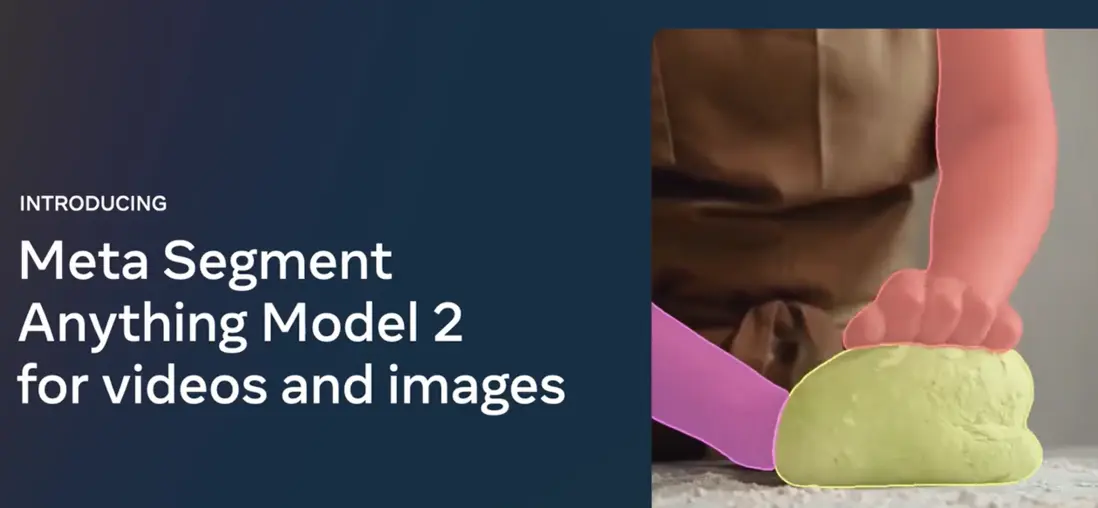

Segment Anything Model 2

Meta公司推出 Llama 3.1 沒多久,又在今天推出了Segment Anything Model 2(SAM 2),以其強大的實時、可提示對象分割能力,引領了視頻處理領域的一場新風潮。

SAM 2不僅支持各種未見過的視覺對象的分割,更為圖像與視頻提供了統一、高效的處理平台。如此突破,無疑為計算機視覺的未來賦予了無窮可能。

功能性大突破

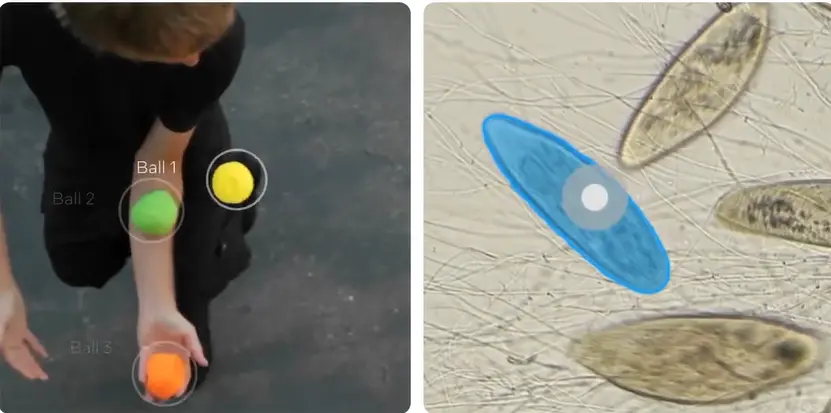

SAM 2官方演示效果

在SAM 2中,可以看到諸多設計創新,其中最令人矚目的當屬其實時處理能力。藉助流式內存設計,SAM 2能夠順序處理視頻幀,讓用户在各種實時應用場景下獲得更流暢、更及時的數據反饋。而且它還有着廣泛的適用性,能夠對任何圖像或視頻中的對象進行分割,即使是它之前從未見過的新物體。

此外,通過基於提示的靈活分割方式,用户只需通過點擊、框或掩碼來定義目標對象,非常便捷。為了進一步提高模型在動態環境中的表現,SAM 2還引入了一種記憶機制。在連續幀預測中,該機制幫助模型有效地克服模糊和遮擋,並改善對對象追蹤的準確性。這一系列功能,使得SAM 2成為當前市場上最先進的視頻對象分割工具之一。

性能再次提升

超強性能

Meta針對計算速度和效率進行了深度優化,在流式內存架構方面取得顯著進步,使得用户交互時間減少至原有水平的1/3。此外,通過引入遮擋 head 模塊,這款新的模型能夠智能判斷目標對象是否依舊可見,從而提升視頻處理效果。

根據訓練數據來看,Meta還建立了龐大的SA-V數據集,包括51,000個真實世界的視頻及超過600,000個masklet,為持續優化提供了強大支撐。和前代版本相比,SAM 2表現在多個維度都顯示出色:交互效率顯著提升、實時推理速度達到每秒44幀,並且能快速生成相關分析結果。這標誌着視頻處理從此進入了全新的智能時代。

實測表現

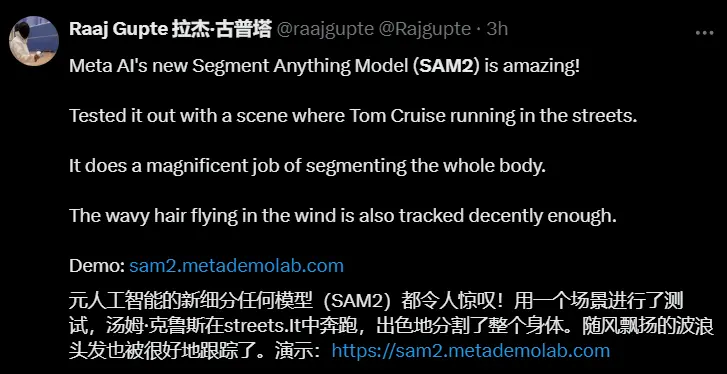

外網用户評價

隨着這項技術逐漸應用到實際中,各方對於SAM 2也給予了高度關注和讚揚。一些用户試用了未經官方測試的視頻後,都表示效果驚人,讓他們不禁重新審視這一技術。而在零樣本測試環節中,SAM 2也在17個數據集上展現出了優異表現,人機交互所需時間減少約三倍。

同時,在註釋過程中,比起傳統手工操作,它能以8.4倍的速度完成各類任務,讓整個流程更為高效順暢。總體來看,Segment Anything Model 2以實時性、靈活性以及廣泛適用性等核心優勢,將圖像與視頻內容分割推向新的高度。這次技術革新不僅啓示着未來更多潛力應用,也預示着全面普及AI驅動的視頻分析工具並不遙遠。

有關厚德雲

厚德雲致力於為用户提供穩定、可靠、易用、省錢的 GPU 算力解決方案。海量 GPU 算力資源租用,就在厚德雲。