在真實場景裏,目標檢測模型經常被一些「刁鑽情況」整得措手不及:監控里人羣密密麻麻,模型只敢報「一坨」;

無人車想識別遠處的交通燈,結果紅綠燈被當成「發光點」;體育轉播裏球速太快,目標框剛跟上,球已經飛到下一幀;甚至在電商倉庫裏,一堆外觀相似的包裹排成一排 —— 模型直接「懵圈」,不知道誰是誰。

想要又快又準,其實比想象中難得多。YOLOv13 的出現,就是為了應對這些真實世界的「刁鑽題」。它由清華大學、太原理工大學與西安交通大學團隊於 2025 年 6 月發佈,它在延續 YOLO 家族高效架構的基礎上,引入超圖增強表示、高階語義感知、輕量化結構重構等關鍵技術,使模型在感知上下文關係、捕捉細粒度特徵與處理複雜背景方面顯著增強,實現了從圖像到目標結構的更穩定、更精確的檢測推理。

在 MS COCO、Pascal VOC 等主流數據集上的廣泛評估顯示,YOLOv13 在精度、速度與泛化能力上均超越上一代方法,在複雜場景中對遮擋目標與細粒度結構的識別更加穩健。其結構設計兼顧算力友好與部署可行性,可在邊緣設備與雲端環境中一致運行,對實時檢測應用具有強可落地性。

換句話説,YOLOv13 並不是 YOLO 的一次常規升級,而是一套真正面向現實世界的「實時視覺解決方案」——讓模型不僅跑得快,還能看得清、分得明、用得穩。

教程鏈接:https://go.openbayes.com/gXXz5

使用雲平台: OpenBayes

http://openbayes.com/console/signup?r=sony_0m6v

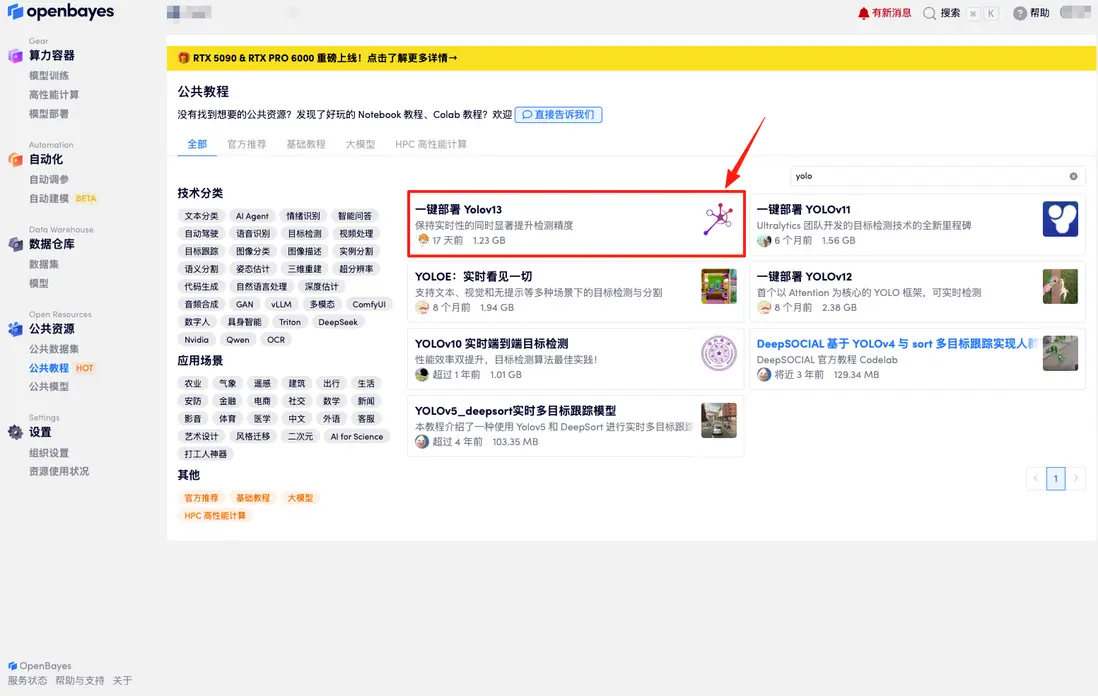

首先點擊「公共教程」,找到「一鍵部署 Yolov13」,單擊打開。

頁面跳轉後,點擊右上角「克隆」,將該教程克隆至自己的容器中。

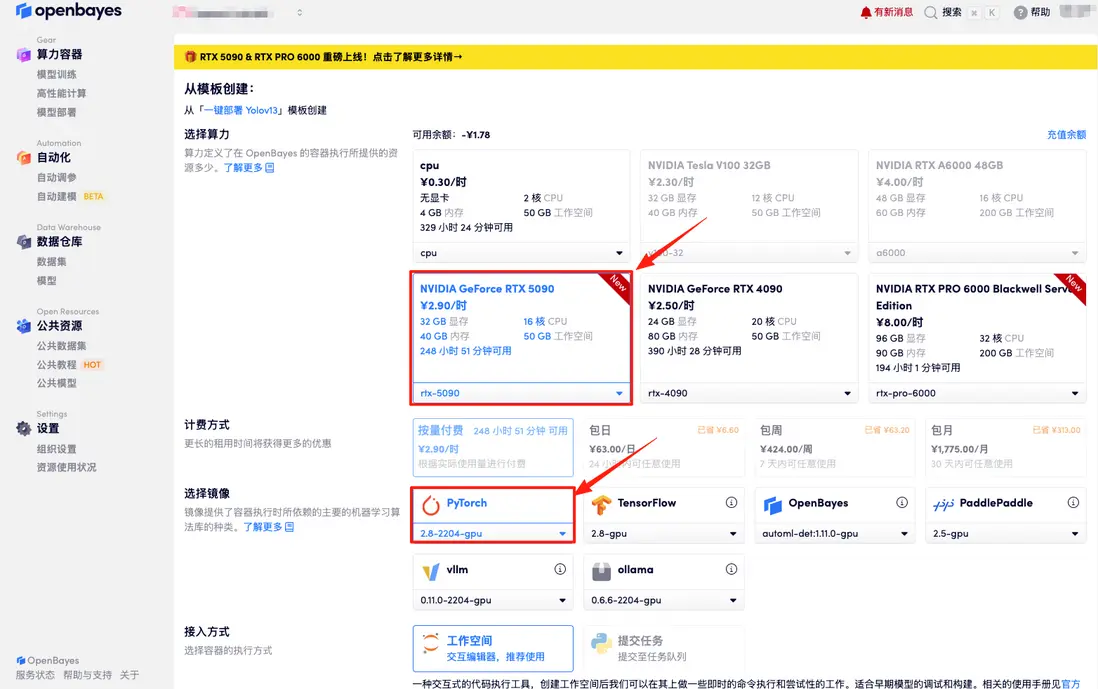

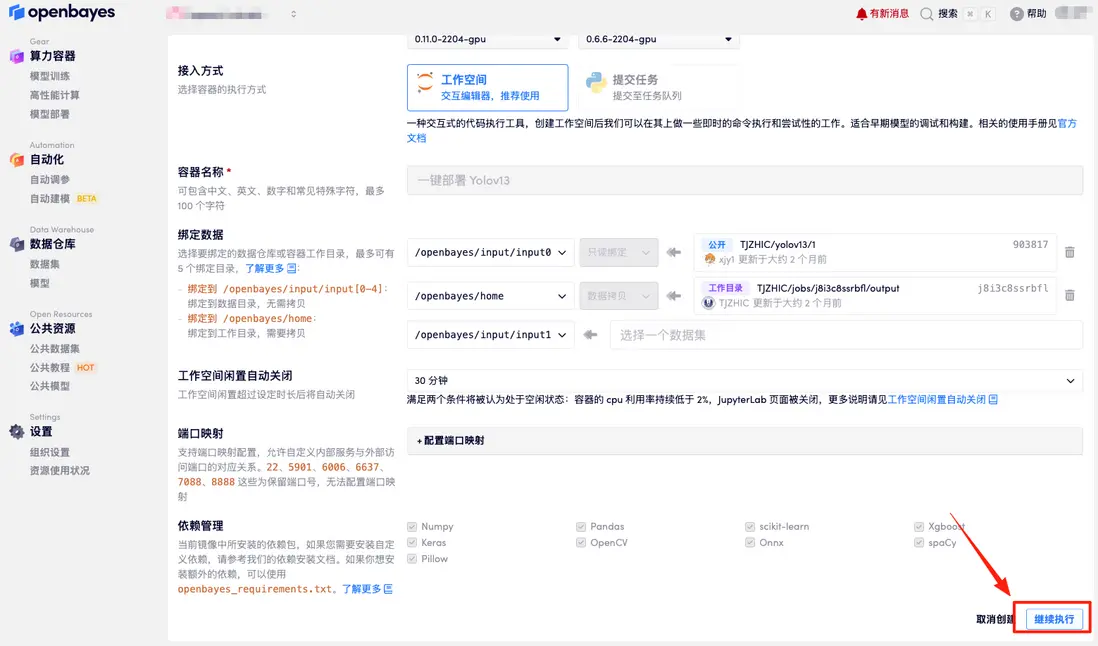

在當前頁面中看到的算力資源均可以在平台一鍵選擇使用。平台會默認選配好原教程所使用的算力資源、鏡像版本,不需要再進行手動選擇。點擊「繼續執行」,等待分配資源。

數據和代碼都已經同步完成了。容器狀態顯示為「運行中」後,點擊「API 地址」,即可進入模型界面。

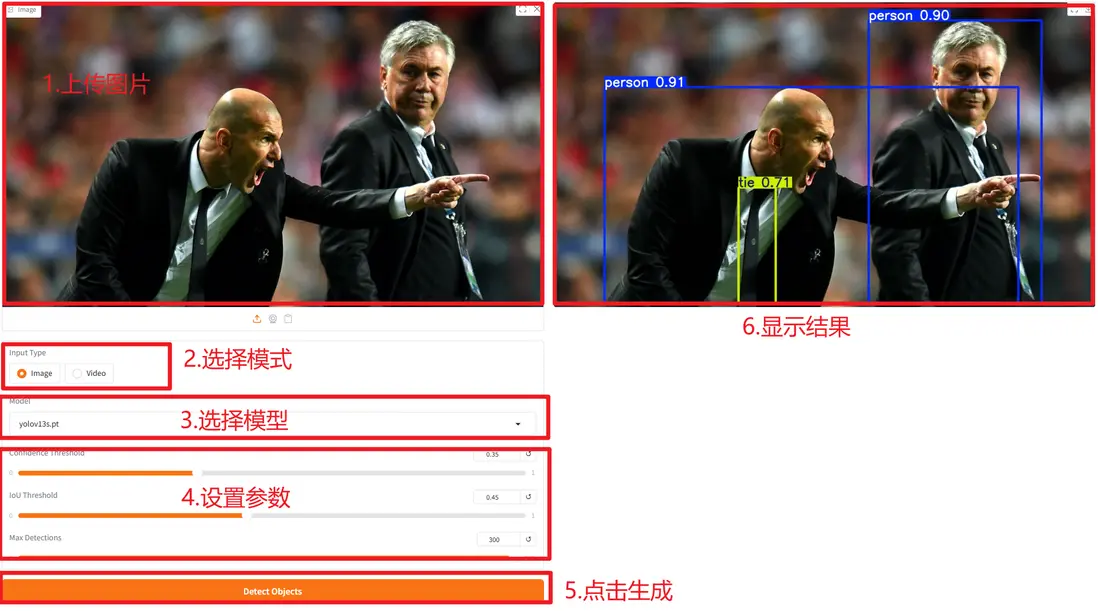

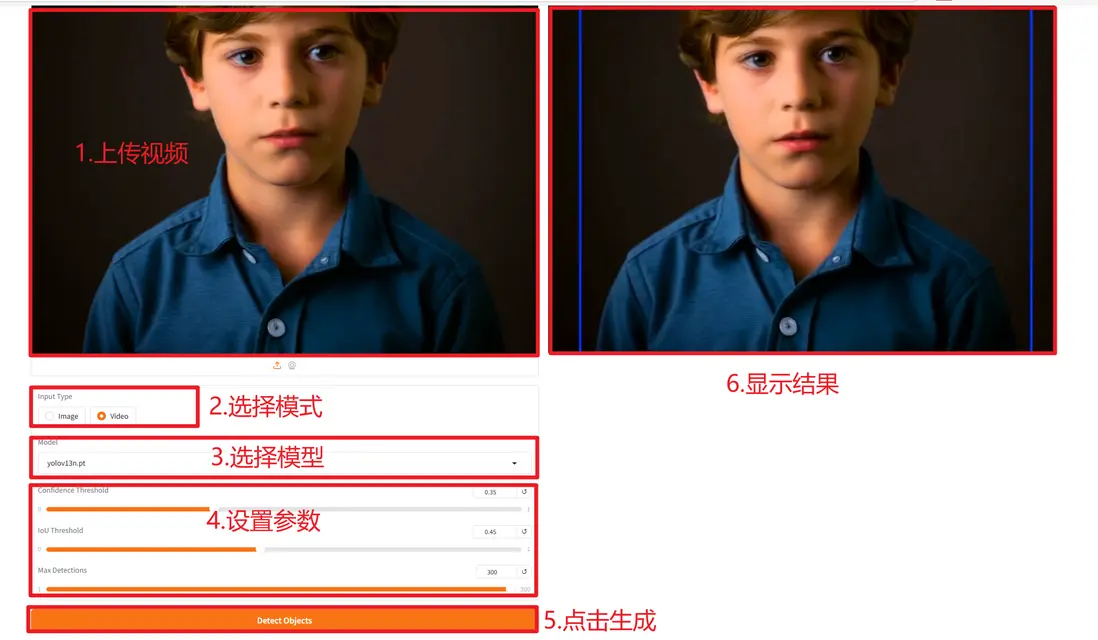

使用步驟如下:

圖像:

視頻:

參數説明:

- Model:yolov13n.pt(nano)、yolov13s.pt (small)、yolov13l.pt(large)、yolov13x.pt(extra large)。模型越大,精度(mAP)越高,但參數量、計算量(FLOPs)和推理時間也越長。

- Confidence Threshold:置信度閾值。

- IoU Threshold:交併比閾值,用於 NMS。

- Max detections per image:每張圖片最大檢測框數量。

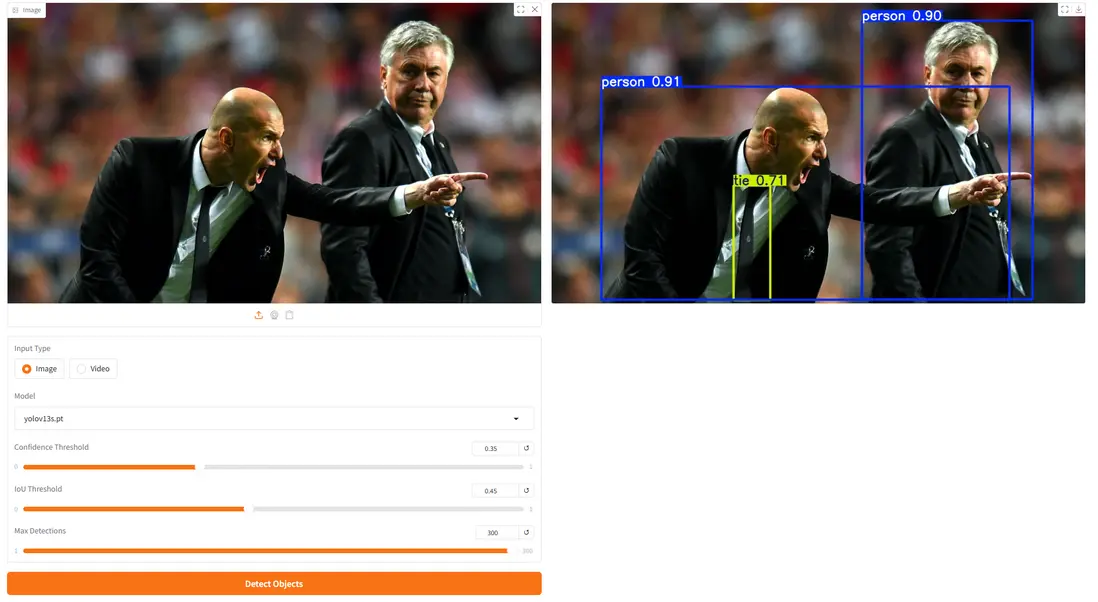

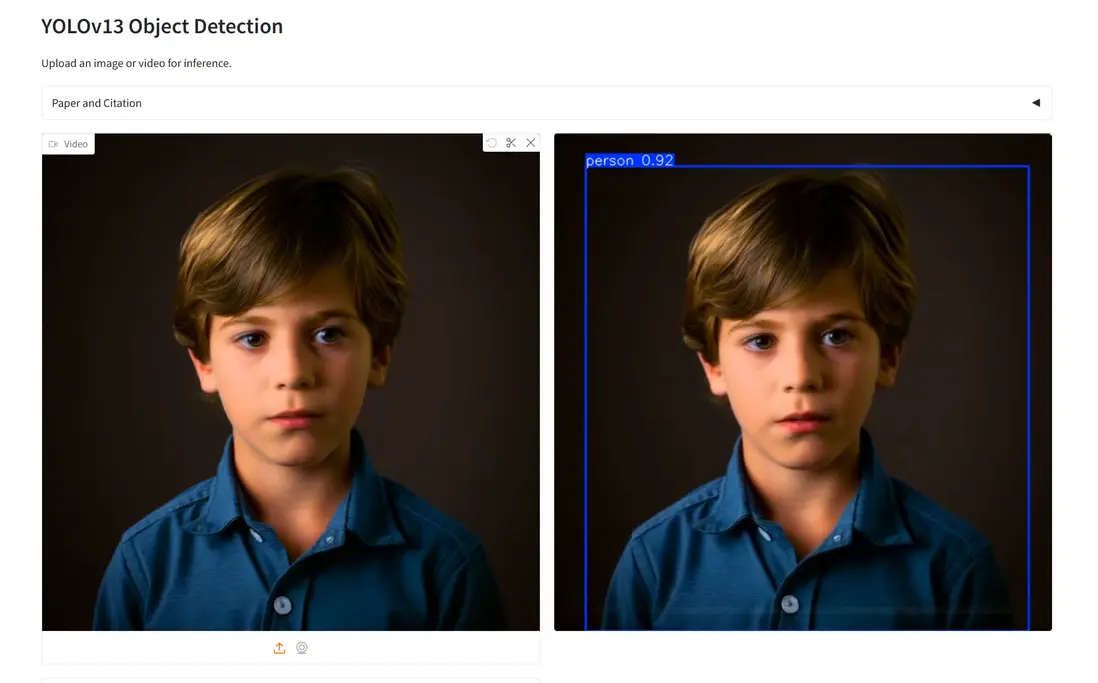

以下是項目示例展示:

圖像:

視頻: