過去的開源圖像模型有點像一櫃子分科工具:這一個負責生成,那一個負責編輯,想讓角色不崩還得再上個微調模型,流程又長又碎。而 Flux.2-dev 的出現就像突然給你塞了一把真正能幹活的 AI 瑞士軍刀——一句話能畫圖,一張圖能修改,幾張參考圖還能自動融合成統一風格,整套流程一個模型就走通了,再也不用東拼西湊。

更讓人驚訝的是,它明明有 32B 參數,卻因為量化和推理優化做得非常激進,居然能在 RTX 5090,甚至更低顯存的顯卡上輕輕鬆鬆跑起來。以前這種級別的模型動不動就得上服務器,現在打開家用電腦就能流暢生成,體驗直接跨了一個時代。

最爽的是——完全不需要 LoRA、不需要 DreamBooth、更不需要準備一堆微調數據。給它幾張參考圖,或者扔一句文本,它就能穩穩給出高質量結果。對設計師、創作者、開發者來説,這基本意味着第一次能把「高質量、多模態、可控」的生成能力真正裝進自己的電腦裏。

簡單講:Flux.2-dev 就像把過去散落在不同模型裏的功能重新打包成了一台「本地超級生成器」。能畫、能改、能融合,角色風格還不跑偏,讓整個創作流程變得快、穩、省心。

教程鏈接:https://go.openbayes.com/pjbdf

使用雲平台: OpenBayes

http://openbayes.com/console/signup?r=sony_0m6v

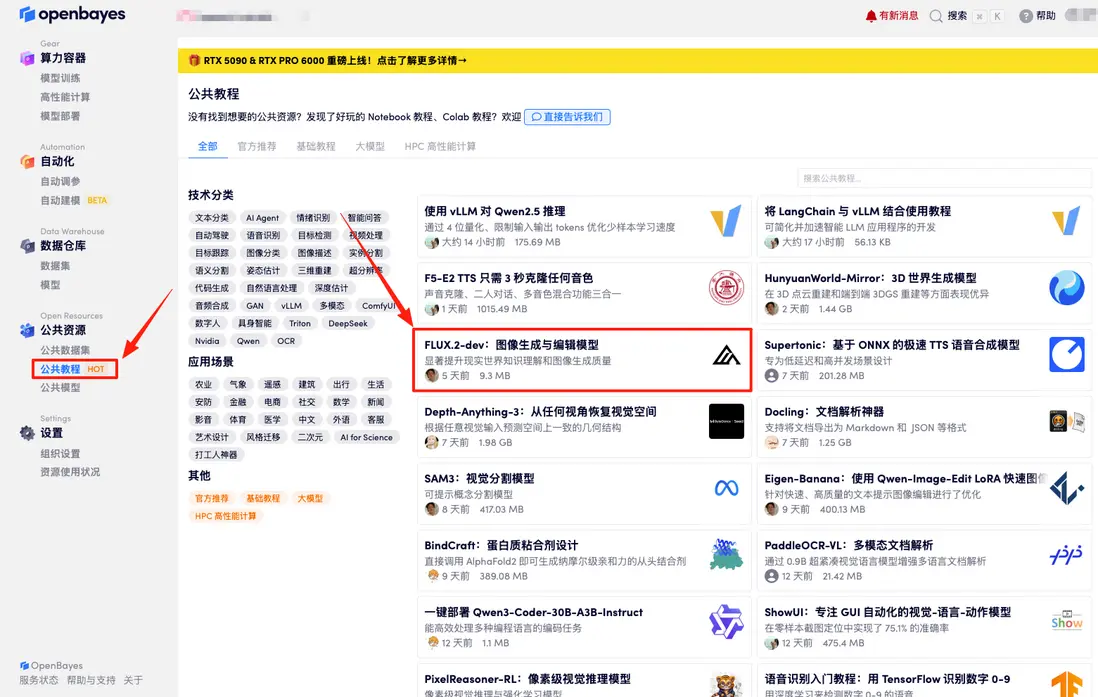

首先點擊「公共教程」,找到「FLUX.2-dev:圖像生成與編輯模型」,單擊打開。

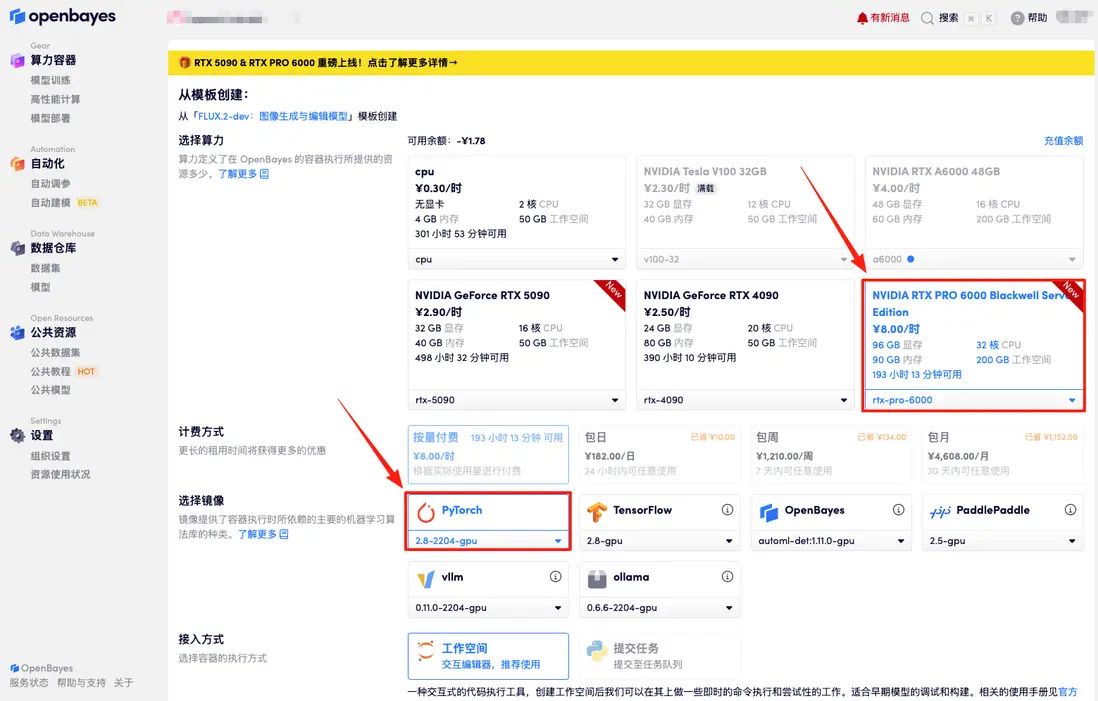

頁面跳轉後,點擊右上角「克隆」,將該教程克隆至自己的容器中。

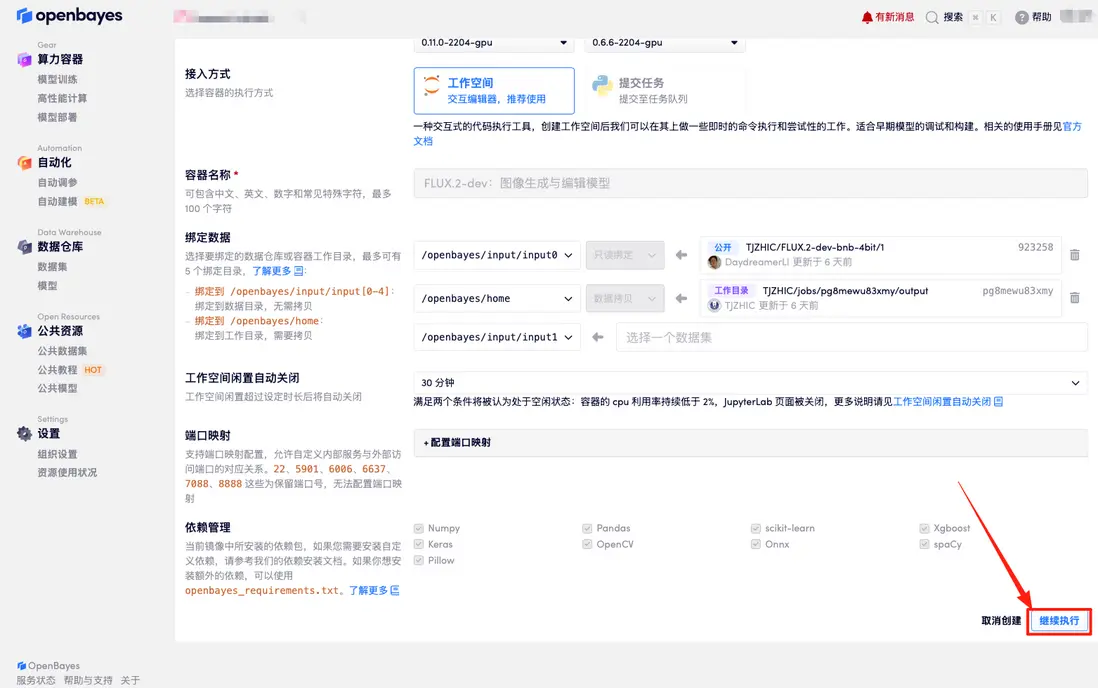

在當前頁面中看到的算力資源均可以在平台一鍵選擇使用。平台會默認選配好原教程所使用的算力資源、鏡像版本,不需要再進行手動選擇。點擊「繼續執行」,等待分配資源。

數據和代碼都已經同步完成了。容器狀態顯示為「運行中」後,點擊「API 地址」,即可進入模型界面。

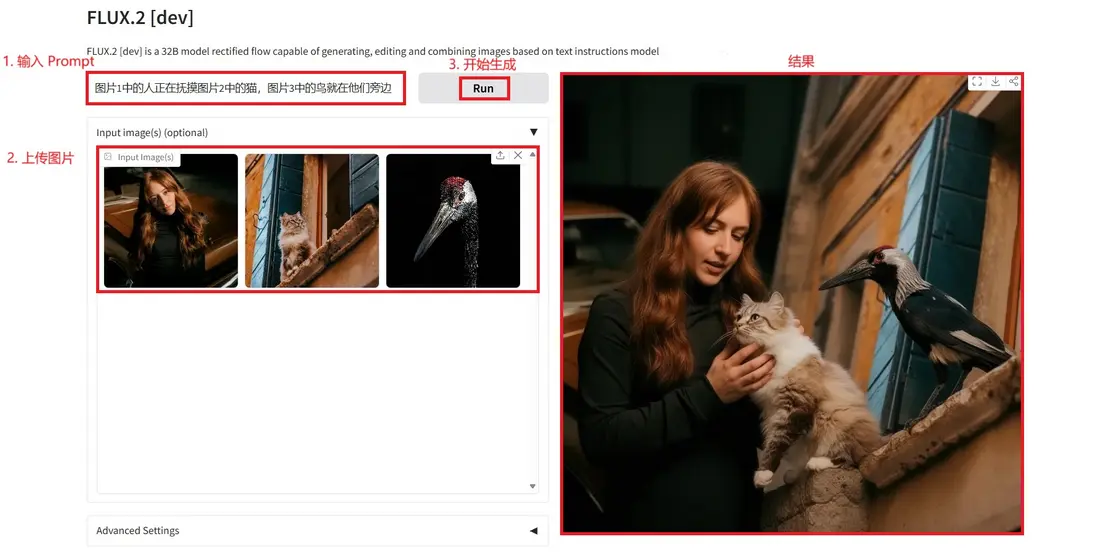

本教程提供 multi-reference editing、text-to-image generation 兩個案例供測試,使用步驟如下:

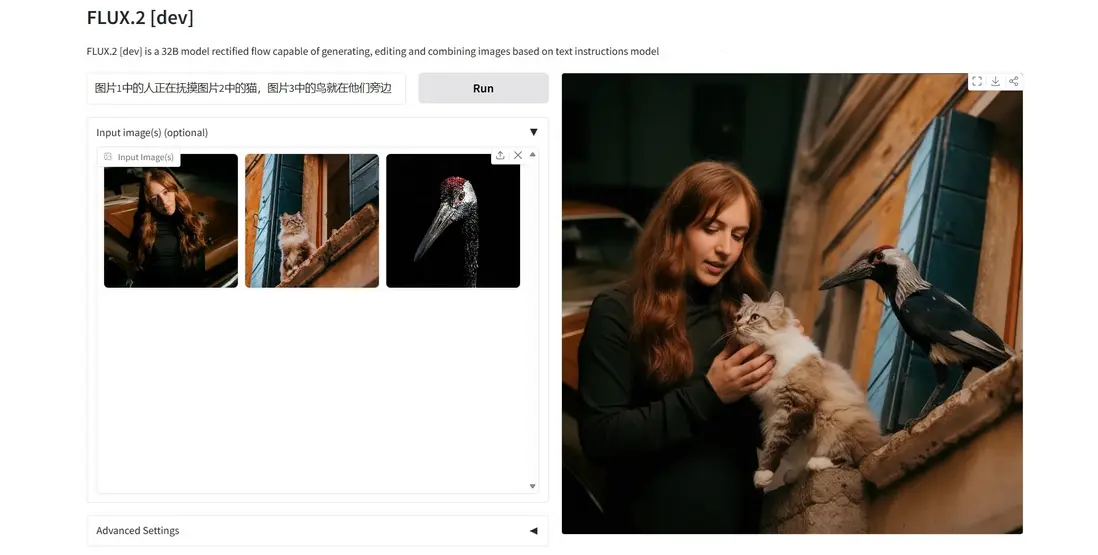

multi-reference editing(多參考圖像編輯)

具體參數:

- Seed:一個輸入到生成模型隨機數生成器中的初始值,用於控制生成過程中的隨機性。

- Width:生成圖像的寬。

- Height:生成圖像的高。

- Number of inference steps:指生成模型在生成最終結果時所經歷的迭代次數或處理步驟數。

-

Guidance scale:控制生成模型(如擴散模型)中條件輸入對最終生成結果的影響程度。

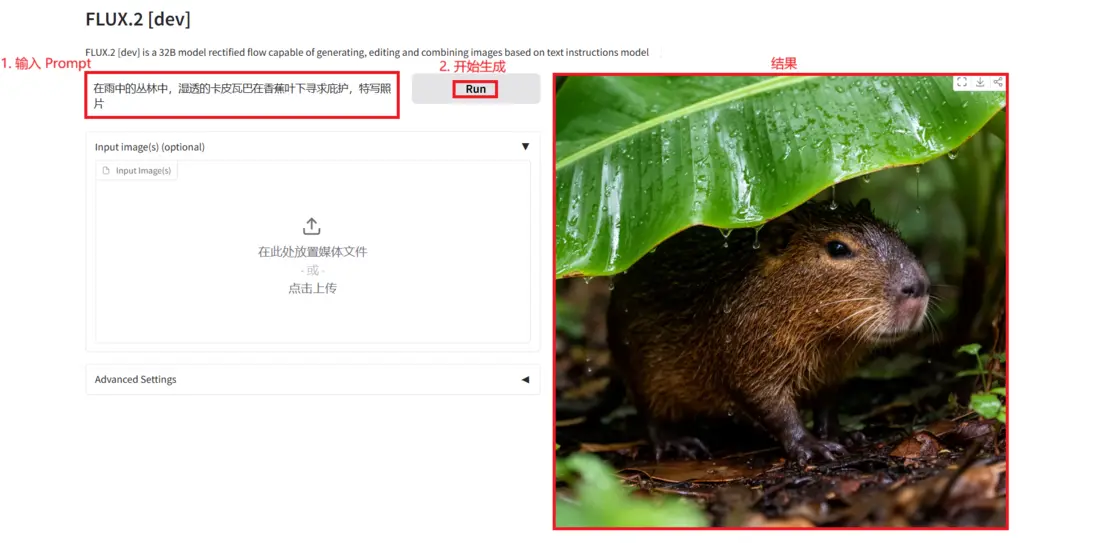

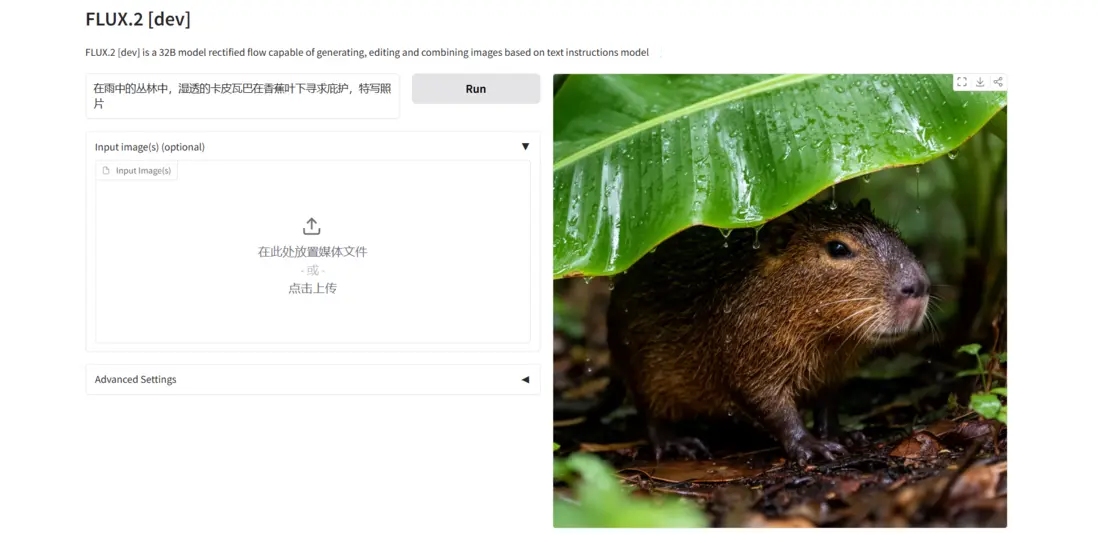

text-to-image generation(文本到圖像生成)

具體參數:

- Seed:一個輸入到生成模型隨機數生成器中的初始值,用於控制生成過程中的隨機性。

- Width:生成圖像的寬。

- Height:生成圖像的高。

- Number of inference steps:指生成模型在生成最終結果時所經歷的迭代次數或處理步驟數。

-

Guidance scale:控制生成模型(如擴散模型)中條件輸入對最終生成結果的影響程度。

效果展示:

multi-reference editing

text-to-image generation