追問快手直播事故:AI審核的技術反思

本文共 1595 字,閲讀預計需要 3 分鐘。

Hi你好,我是Carl,一個本科進大廠做了2年+AI研發後,裸辭的AI創業者。

12月22日晚,快手直播遭有組織的黑灰產攻擊,"打直球"式的涉黃內容涌入多個直播間。

不得不説,快手這次丟了大人。AI審核形同虛設,處置靠人工干預和外部舉報,導致大量色情內容在推薦頁刷屏了半小時之多。許多用户反饋舉報鍵都點爛了也封不過來,連舉報通道都顯示嚴重擁堵,最終平台只能緊急關停整個直播功能。

這篇文章我們只説人話,聊聊這幾個問題背後的技術原因:

AI審核為什麼沒攔住?直播低延遲和內容安全怎麼權衡?其他平台怎麼做的?

看完,你會拿到3個可落地的防護建議。

22點,快手直播間"淪陷"了

12月22日22點左右,快手直播功能遭到網絡攻擊。

在這期間400多萬人因為獵奇心態下載了快手,被調侃為“快手拉新效果最好的一次”。

凌晨,平台緊急關閉全部直播功能,用户點進去只看到"沒有內容"。

根據快手官方聲明,黑灰產利用技術手段向多個直播間投放涉黃內容。平台在陸續收到用户舉報後開始逐個關閉直播間,在手動干預完全抵禦不住後,緊急關閉了直播功能。

手動干預,多麼小眾的詞彙啊。

12月23日上午,快手發佈正式聲明確認遭受攻擊,並表示直播功能正在逐步恢復。

事件本身不復雜。但它暴露了幾個值得技術從業者思考的問題:

AI審核系統,為什麼沒能在第一時間攔住這些內容?

直播預留的幾秒延遲就是用來處理這樣的突發事件的,為何完全失靈?

如此大體量的平台,內容安全的防禦竟然要靠用户舉報與人工介入+手動關播才能生效?

今天我們聊第一個問題。AI審核,為什麼沒攔住?

先看雲廠商怎麼説。

阿里雲、騰訊雲、華為雲都有成熟的直播內容審核產品,宣傳口徑都差不多:毫秒級響應、高準確率、支持圖文音視頻全模態。

但"高準確率"到底是多少?

Meta在2025年Q3透明度報告中給出了一個參考數字:Facebook的內容審核執行精確度超過90%,Instagram超過87%。聽起來很高,但換個角度想——10%的漏判或誤判,在每天數千億條內容的規模下,是一個巨大的數字。

不過,以這次直播內容**“打直球”、還能在推薦頁刷屏半小時來看,單純用“精確度不夠**”解釋,其實有點勉強。

更像的問題在於:很多平台的直播審核,真正要跑通的是一條鏈路——

抽幀/取樣(看什麼)→ 模型識別(判什麼)→ 風險評分(多嚴重)→ 處置動作(怎麼停)。

前面三步做得再漂亮,只要最後一步沒打通(比如仍然依賴人工確認、依賴舉報觸發、或者處置隊列被打爆),用户看到的效果依然是:AI在“看”,但直播還在“播”。

更棘手的是對抗樣本攻擊。2020年ICML的一篇論文指出,AI模型在防禦對抗攻擊時存在根本性權衡:

你加強對一類攻擊的防禦,可能會主動削弱對另一類攻擊的準確性。

黑灰產的技術也在進化,添加噪聲、變形畫面、諧音替換、快速閃屏——這些手段專門針對AI審核的弱點。

還有一個現實約束:逐幀審核的成本是天文數字。因此行業普遍採用抽幀檢測加關鍵幀識別的方式。

但這種技術組合能否扛住有組織的黑產攻擊?這次快手的事件已經給出了答案。

把抽幀説得更直白點:你不可能每秒把直播的每一幀都送去跑大模型,通常只能**“隔幾幀看一眼”**。這就天然有盲區。

如果黑灰產用“快速閃屏”“低佔空比”的方式投放(畫面違規只出現一瞬間、或者以某種節奏間歇出現),剛好卡在你的抽幀間隔裏,模型再強也可能“沒看見”。

更麻煩的是“規模化投放”。當同一時間被攻陷的直播間很多,審核側的推理資源、風控隊列、人工複核和關停動作會一起被沖垮:不是你識別不出來,而是你來不及處置。

所以問題不是"AI審核有沒有用",而是**"AI審核能不能100%攔住所有攻擊"。**答案顯然是不能。

低延遲 vs 安全窗口:一道兩難題

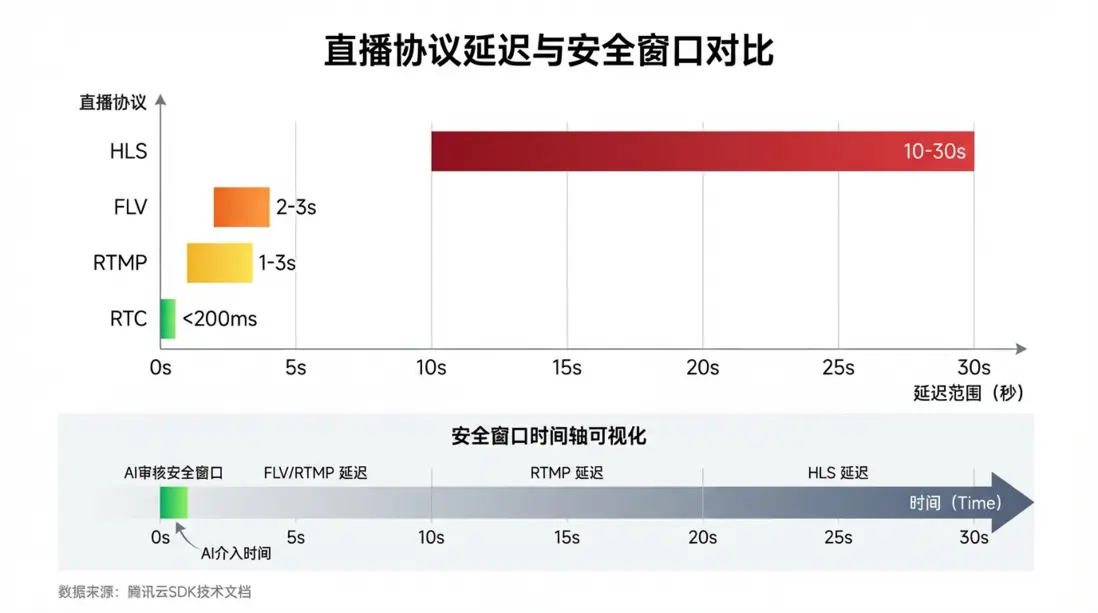

騰訊雲官方文檔:

還有一個容易被忽視的技術細節:直播延遲。

根據騰訊雲直播SDK文檔,不同協議的延遲差異很大。

延遲越低,用户體驗越好。但延遲越低,留給審核系統的反應窗口也越短。

如果用HLS協議,審核系統有10-30秒的時間檢測和攔截違規內容。

但如果追求低延遲體驗用RTC,窗口可能只有幾百毫秒——AI模型跑一次推理都不一定夠。

平台怎麼選?低延遲意味着用户體驗好、互動強,但安全風險高。高延遲意味着審核窗口充足,但用户可能覺得"卡"。主流平台為了應對突發情況,一般會把延遲控制在3-5秒的時間窗口,取一個折中的平衡。

別人怎麼做的?

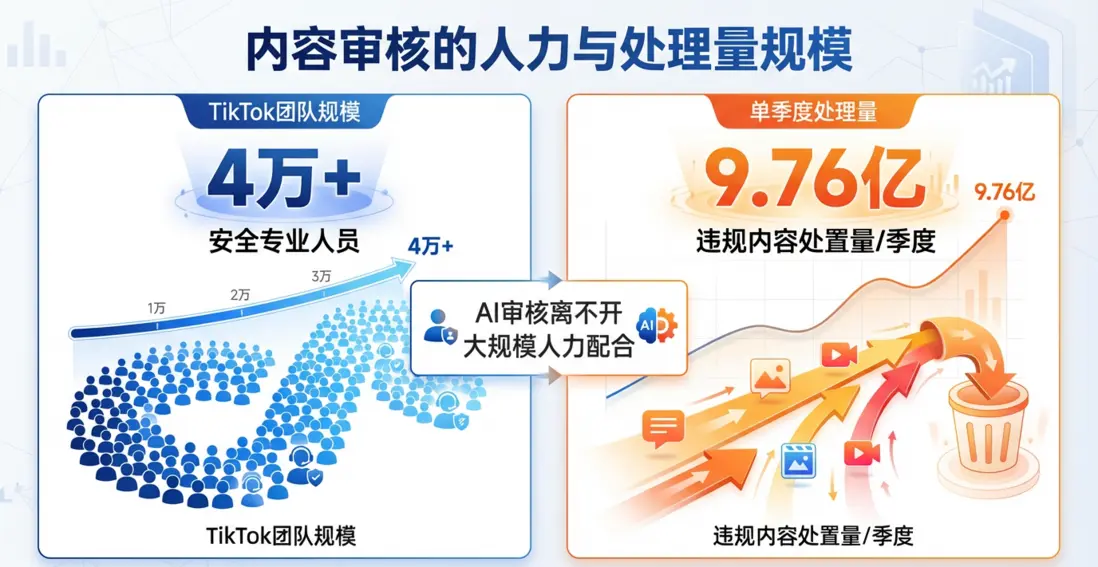

看看行業頭部玩家的數據。

TikTok:2024年Q1透明度報告顯示,TikTok擁有超過4萬名信任與安全專業人員。同期刪除了9.76億條違規評論,佔總評論量的1.6%。

這些數據説明一個問題:AI審核離不開大規模的人力配合。純技術方案在面對有組織的攻擊時,往往力不從心。

風險盲區:相關從業者該怎麼辦?

如果你在做直播、UGC或任何涉及內容審核的產品,這次事件有幾個風險點值得警惕:

風險1:單一審核層容易被突破

只靠AI審核,一旦模型被繞過就全線崩潰。

→ 規避動作:設計多層架構。AI初篩+人工複核+延遲緩衝,任何一層失效都有兜底。高風險時段可以臨時提高延遲,換取更長的審核窗口。

風險2:你升級技術,對抗攻擊也在持續進化

黑灰產的技術迭代速度可能比你的模型更新還快。

→ 規避動作:把對抗樣本防禦納入模型訓練流程。定期用紅隊測試檢驗審核系統的邊界,而不是等到被攻擊了才發現漏洞。

風險3:應急響應不夠快

從發現問題到切斷入口,中間的時間窗口決定了損失大小。

→ 規避動作:提前預演應急SOP。設置熔斷機制,當違規內容檢出率突然飆升時自動觸發降級或關停。不要等人工決策,機器先動。

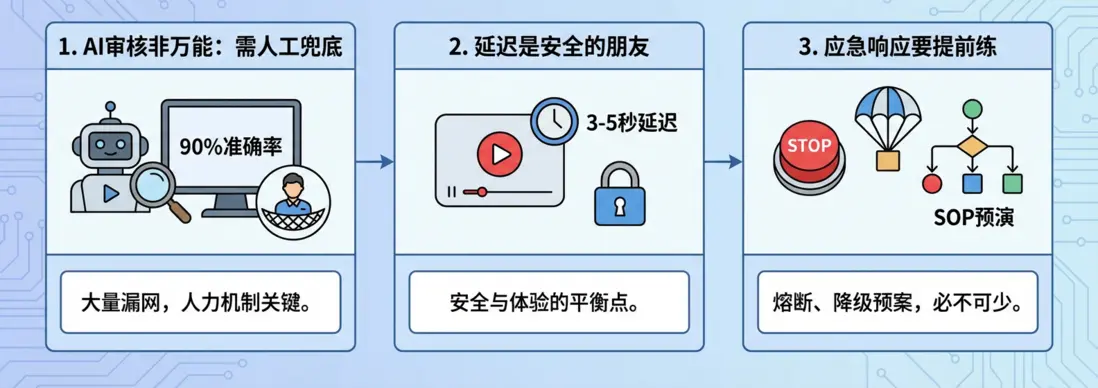

結語:給技術從業者的3個落地建議

總結一下:

1. AI審核不是萬能的。90%的準確率在大規模場景下仍然意味着大量漏網之魚,必須有人工複核和兜底機制。這次事件告訴我們:這鍋不該只讓AI背,人力投入和機制建設同樣重要。況且一些觀點認為,此次事故是繞過AI審核直接劫持推流接口導致的,那就更是安全建設的巨大失誤。

2. 延遲是安全的朋友。在追求低延遲體驗的同時,要想清楚你願意為安全窗口付出多少體驗代價。主流平台的3-5秒延遲不是隨便定的,而是安全與體驗的平衡點。

3. 應急響應要提前練。熔斷機制、降級預案、SOP預演,這些不是"有了更好",而是"沒有會死"。

最後留一個開放問題:

當一家公司的AI明星產品頻繁刷屏時,它的安全基建是否也在同步進化?歡迎評論區聊聊。

既然看到這了,如果覺得不錯,隨手點個贊、收藏、轉發三連吧~

我是Carl,大廠研發裸辭的AI創業者,只講能落地的AI乾貨。

關注我,更多AI趨勢與實戰,我們下期再見!

數據來源

快手官方聲明確認遭黑灰產攻擊:[數據|2025.12.23|IT之家 https://www.ithome.com/0/907/209.htm]

Meta透明度報告審核精確度:Facebook >90%,Instagram >87%,錯誤刪除率<0.1% [數據|2025 Q3|https://transparency.meta.com/reports/community-standards-enf...]

TikTok安全團隊規模4萬人,Q1刪除9.76億條評論 [數據|2024 Q1|https://www.tiktok.com/transparency/en/community-guidelines-e...]

直播協議延遲數據:FLV 2-3秒,RTC <200ms,HLS 10-30秒 [數據|2024|騰訊雲直播SDK文檔 https://cloud.tencent.com/document/product/454/7886]

對抗樣本攻擊根本性權衡:Tramèr等人研究 [數據|2020|ICML 2020, arXiv:2002.04599]

阿里雲內容安全產品能力描述 [數據|2024|https://cn.aliyun.com/product/lvwang]