- 還在為 OpenAI API 的高額賬單和 Token 限制而煩惱嗎?

- 還在擔憂代碼和配置被 AI 編碼工具上傳到雲端嗎?

- 還在被離線開發折磨嗎?

- 想擁有一個完全由你掌控、私密安全、免費無限量 Token 的 AI 編程夥伴嗎?

今天,我就手把手帶你解鎖這個終極奧義:利用強大的 Ollama 運行最新的 devstral:latest 模型,配合 Windows Docker Desktop 部署酷炫的 OpenWebUI,最後無縫集成到 VS Code 的 CodeGPT (原名 Codegpt a.k.a. Cline) 擴展中,讓你在編碼世界中如虎添翼,靈感無限!

你將獲得:

✅ 完全免費:告別按 Token 計費的時代。

✅ 無限 Token:只要你的硬件頂得住,想寫多長就寫多長。

✅ 本地運行,數據私密:代碼和對話數據不出本地,安全放心。

✅ 高性能編碼模型:體驗專為開發者優化的 Devstral 模型。

✅ 絲滑的 VS Code 集成:在最熟悉的編輯器中享受 AI 輔助。

聽起來是不是已經熱血沸騰了?讓我們開始吧!

🛠️ 第一步:Ollama 加持,請出 Devstral 大神

Ollama 是一個讓你在本地輕鬆運行開源大語言模型的工具。devstral 是 Mistral AI 推出的專為開發者設計的模型,代碼生成、解釋、調試能力超強。

安裝 Ollama:

訪問 Ollama 官網。下載並安裝適合你操作系統(Windows, macOS, Linux)的 Ollama。Windows 用户安裝後,Ollama 會在後台運行,並通過任務欄圖標訪問。

運行 Devstral 模型:

打開你的命令行終端(Windows 用户可以使用 PowerShell 或 CMD):

ollama pull devstral:latest

Use code with caution.這個命令會下載最新的 devstral 模型。模型文件較大 ( 14GB ),請耐心等待。

下載完成後,你可以嘗試運行一下(可選,主要為了確認模型可用):

ollama run devstral:latest "write a python function to download a file from a url"

Use code with caution.看到模型輸出 Python 代碼,就説明 Ollama 和 Devstral 已經準備就緒!Ollama 默認會在 http://localhost:11434 提供 API 服務。

🐳 第二步:Windows Docker Desktop 部署 OpenWebUI

OpenWebUI (前身是 Ollama WebUI) 提供了一個美觀且功能豐富的聊天界面,可以連接到 Ollama,並且能提供 OpenAI 兼容的 API 接口,這是我們後續連接 VS Code 的關鍵。

安裝 Docker Desktop for Windows:

如果你的 Windows 還沒有安裝 Docker Desktop,請前往 Docker 官網 下載並安裝。

確保 Docker Desktop 正在運行,並且已經切換到使用 WSL 2 後端(通常是默認設置)。

運行 OpenWebUI 容器:

打開 PowerShell 或 CMD,執行以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://host.docker.internal:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main命令解釋:

-d: 後台運行容器。

-p 3000:8080: 將容器內的 8080 端口映射到主機的 3000 端口。這樣你就可以通過 http://localhost:3000 訪問 OpenWebUI。

--add-host=host.docker.internal:host-gateway: 關鍵步驟! 這允許 Docker 容器內的 OpenWebUI 訪問到運行在 Windows 主機上的 Ollama 服務(Ollama 監聽在 localhost:11434,對於容器來説就是 host.docker.internal:11434)。

-v open-webui:/app/backend/data: 將 OpenWebUI 的數據持久化到名為 open-webui 的 Docker volume 中,防止容器刪除後數據丟失。

-e OLLAMA_BASE_URL=http://host.docker.internal:11434: 關鍵步驟! 告訴 OpenWebUI 去哪裏找 Ollama 的 API。

--name open-webui: 給容器取個名字,方便管理。

--restart always: 容器退出時總是自動重啓。

ghcr.io/open-webui/open-webui:main: OpenWebUI 的官方 Docker 鏡像。

訪問 OpenWebUI 並創建賬户:

等待片刻,讓容器啓動。

打開瀏覽器,訪問 http://localhost:3000。

首次訪問,會提示你註冊一個管理員賬户。填寫郵箱、用户名和密碼即可。

連接模型並生成 API Key:

登錄 OpenWebUI 後,它應該會自動檢測到你本地 Ollama 中的 devstral:latest 模型。你可以在聊天界面選擇它。

點擊左下角你的用户名 -> "設置"。

在設置菜單中,找到 "API 密鑰" (API Keys) 選項。

點擊 "新建密鑰" (Create new key),給它取個名字(例如 vscode-key),設置過期時間(或永不過期),然後點擊創建。

複製並保存好生成的 API Key,例如 sk-xxxxx...。這個 Key 非常重要,我們馬上會用到。

現在,你的 OpenWebUI 已經配置完成,並且提供了一個 OpenAI 兼容的 API 接口,地址是 http://localhost:3000/v1。

💻 第三步:VS Code + Cline 擴展,釋放 AI 編程超能力

Cline ( cline.bot ) 是 VS Code 上一款非常流行的 AI 輔助編程擴展。

安裝 CodeGPT 擴展:

打開 VS Code。

進入擴展市場 (快捷鍵 Ctrl+Shift+X)。

搜索 "Cline" 並安裝它(通常是 cline.bot 開發的那個)。

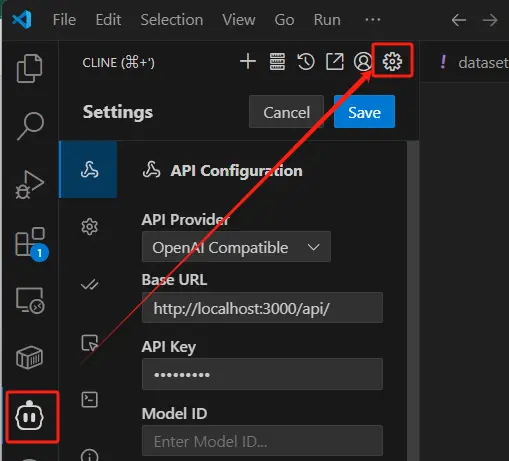

配置 Cline 連接到 OpenWebUI:

在 VSCode 的界面左側導航圖標欄目中點擊外星人頭像一樣的那個圖標 (小電視中間兩個大的豎點)

Provider: 選擇 OpenAI compatible (或者如果它有 OpenAI Compatible 類似的選項,選那個)。

API Key: 粘貼你剛才從 OpenWebUI 生成的 API Key (例如 sk-xxxxx...)。

API Base URL / Endpoint: 輸入 http://localhost:3000/api/ (這是 OpenWebUI 提供的 OpenAI 兼容 API 地址)。

Model: 選擇或手動輸入模型名稱。由於 OpenWebUI 已經連接了 Ollama,這裏你應該可以填入 devstral:latest

(這是一個示意圖,具體UI可能隨版本更新)

請注意: 根據 Cline 擴展版本的不同,設置項的名稱和位置可能略有差異。關鍵是找到設置 API Key、Base URL 和 Model 的地方。

開始你的無限 Token AI 編程之旅:

配置完成後,你就可以在 VS Code 中使用 Cline 了!

提問/聊天:打開 Cline 的聊天側邊欄,選擇 devstral:latest 模型,開始對話,讓它幫你解釋代碼、生成代碼片段、debug 等。

代碼操作:選中一段代碼,右鍵點擊,你會看到 Cline 提供的各種功能,如 "Explain "、"Refactor Cline"、"Generate Unit Test Cline" 等。

因為所有請求都發送到你本地的 OpenWebUI -> Ollama -> Devstral,所以完全免費,且沒有 Token 限制!

🎉 總結與展望

恭喜你!現在你擁有了一套完全本地化、免費且無 Token 限制的 AI 編程環境。從 Ollama 運行強大的 Devstral 模型,到 Docker 部署美觀的 OpenWebUI,再到 VS Code 的無縫集成,每一步都讓你離 AI 輔助開發的自由更近一步。

温馨提示:

硬件資源:運行大型語言模型對 CPU、內存(RAM)和顯卡(GPU VRAM,如果 Ollama 使用 GPU 加速)有一定要求。如果感覺卡頓,可以嘗試運行更小的模型,或者檢查你的硬件配置。

防火牆:確保 Windows 防火牆沒有阻止 Docker Desktop 或 Ollama 的網絡訪問,特別是 host.docker.internal 的通信。

Ollama GPU 支持:如果你的 Windows 系統有 NVIDIA 顯卡,Ollama 可以利用它進行加速。確保你的 NVIDIA 驅動是最新的,並且 Ollama 能正確識別。

模型選擇:devstral 很棒,但 Ollama 支持眾多模型,你也可以嘗試 codellama, mistral, llama3 等其他模型,看看哪個最合你口味。

現在,盡情享受編碼的樂趣,讓這個本地 AI 夥伴助你一臂之力,創造更多可能吧!如果你覺得這篇教程有用,別忘了分享給你的朋友們!

希望這篇博客能幫到你!