翻牆、攀爬、違規行為檢測數據集(10,000 張圖片已劃分)——安全檢測實踐

在現代城市安全管理與工地監控場景中,“違規攀爬”與“翻越圍欄”等行為的實時檢測,是視頻智能分析系統中的關鍵功能之一。為了提升這類行為識別算法的魯棒性與泛化能力,本文將介紹一個 翻牆、攀爬、違規行為檢測數據集(共10,000張圖片),並結合 YOLOv8 模型展開技術解析與實戰講解,幫助研究者與開發者快速構建智能檢測系統。

數據集獲取

鏈接:https://pan.baidu.com/s/1TPB68kQQBNSKRseN0rUVyw?pwd=p88c

提取碼:p88c 複製這段內容後打開百度網盤手機App,操作更方便哦

數據集説明

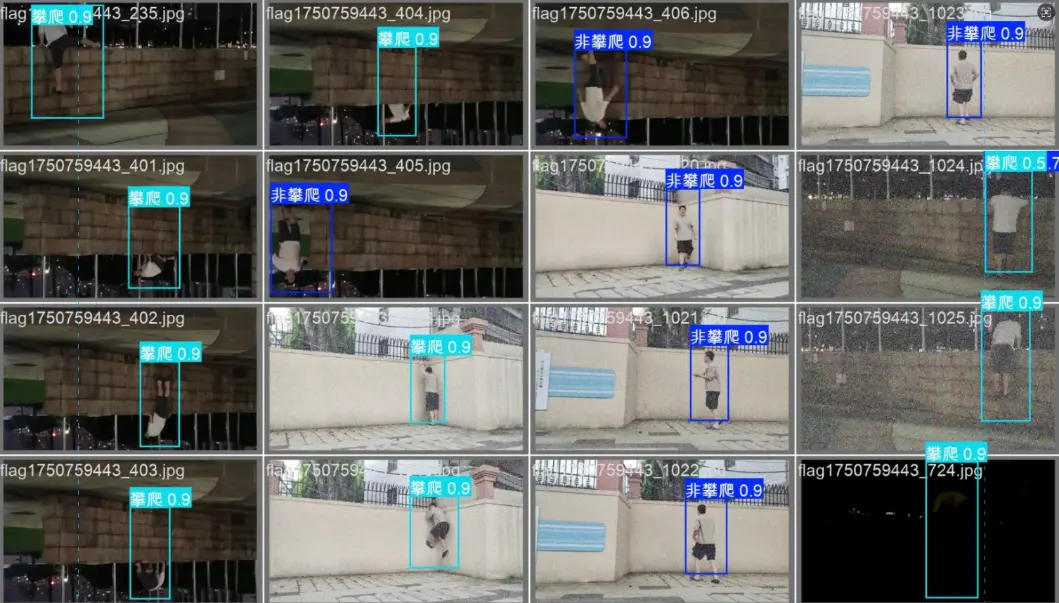

樣本分類輸出(中文):非攀爬,攀爬

樣本分類輸出(英文):no_climb,climb

樣本分類輸出數量:2

訓練集train: 9030個樣本

驗證集valid: 1130個樣本

訓練集和驗證集樣本比例:約8:1

數據集使用説明

下載並解壓數據集後,確保目錄結構完整。可直接用於項目訓練

將數據集中的 yaml文件 中的路徑替換為你的實際目錄,即可訓練模型完成檢測。

一、背景

隨着人工智能(AI)與計算機視覺的發展,越來越多的公共區域開始部署 視頻智能分析系統(VSA),用於實時檢測異常行為、入侵行為或危險事件。例如:

- 工地中檢測工人是否違規攀爬腳手架;

- 小區與學校中檢測行人是否翻越圍欄;

- 交通區域中監測行人是否進入限制區。

傳統基於規則的檢測算法依賴背景建模與運動分析,但在光照變化、複雜背景或多角度攝像頭下易產生誤報。相比之下,基於深度學習的目標檢測模型(如YOLOv8) 能夠通過端到端學習識別目標類別與位置,實現更高精度、更強魯棒性的“智能行為檢測”。

為了滿足上述需求,本文介紹的 “翻牆、攀爬、違規行為檢測數據集” 專為目標檢測任務設計,能有效支持 YOLO 系列模型的訓練與測試。

二、數據集概述

該數據集共包含 10,000 張圖片,均為清晰標註的 翻牆、攀爬、非攀爬行為 樣本,覆蓋不同場景、角度與光照條件。所有圖片均已完成 目標框標註(Bounding Box Annotation),可直接用於訓練目標檢測模型。

| 數據項 | 內容説明 |

|---|---|

| 數據總量 | 10,000 張圖片 |

| 分類數量 | 2 類 |

| 類別(中文) | 非攀爬、攀爬 |

| 類別(英文) | no_climb、climb |

| 訓練集數量 | 9,030 張 |

| 驗證集數量 | 1,130 張 |

| 訓練/驗證比例 | 約 8 : 1 |

| 標註格式 | YOLO格式(.txt + .jpg) |

| 推薦任務 | 目標檢測 (Object Detection) |

| 推薦模型 | YOLOv8 / YOLOv9 / RT-DETR |

📁 數據組織示例結構:

detect_climb_noclimb/

├── images/

│ ├── train/

│ ├── valid/

├── labels/

│ ├── train/

│ ├── valid/

└── data.yamldata.yaml 文件定義了數據路徑與類別:

train: ./images/train

val: ./images/valid

nc: 2

names: ['no_climb', 'climb']三、數據集詳情

1. 樣本來源

圖片數據來源於公共監控視頻幀截取與仿真模擬場景,覆蓋多種類型的環境:

- 工地圍欄區域;

- 校園與小區牆體;

- 室外鐵柵欄、網格圍牆;

- 公共區域護欄。

2. 樣本多樣性

為增強模型的泛化能力,數據集涵蓋以下維度的多樣性:

- 不同時間段(白天、夜晚、黃昏);

- 多攝像機角度(高視角、平視、俯視);

- 不同人羣特徵(衣着、姿態、距離);

- 不同光照、遮擋、模糊條件。

3. 標註規範

每張圖像都採用 YOLO格式標註,即:

<class_id> <x_center> <y_center> <width> <height>其中座標均為歸一化形式(相對於圖像寬高的比例)。例如:

1 0.521 0.463 0.278 0.592表示一個攀爬目標(class_id=1),位於圖像中央偏右。

四、適用場景

該數據集非常適合用於以下AI視覺任務:

| 應用場景 | 實現目標 |

|---|---|

| 工地安全監控 | 實時檢測違規攀爬、危險行為 |

| 智能視頻分析系統 | 融入行為識別模塊,預警入侵 |

| 智慧園區管理 | 檢測翻越圍欄或隔離區行為 |

| 學校安防監控 | 防止學生攀爬圍牆、翻越柵欄 |

| 智慧交通檢測 | 檢測行人闖入禁區或欄杆區域 |

通過此數據集,模型可以自動識別“人是否在攀爬”,並輸出檢測框位置,實現視頻監控自動化管理。

五、目標檢測模型實戰(YOLOv8)

下面以 YOLOv8 為例,展示如何基於該數據集訓練一個高精度的攀爬檢測模型。

1. 環境配置

首先確保安裝最新版本的 ultralytics 庫:

pip install ultralytics -U2. 數據集路徑與配置

將下載好的數據集解壓後,修改 data.yaml 文件中路徑為你的本地路徑,例如:

train: D:/dataset/detect_climb_noclimb/images/train

val: D:/dataset/detect_climb_noclimb/images/valid

nc: 2

names: ['no_climb', 'climb']3. 模型訓練命令

執行以下命令開始訓練:

yolo detect train model=yolov8n.pt data=detect_climb_noclimb/data.yaml batch=32 epochs=100 imgsz=640 device=cudamodel=yolov8n.pt:加載輕量級YOLOv8模型(適合快速訓練)batch=32:每批次32張圖像epochs=100:訓練100個週期imgsz=640:輸入圖像尺寸device=cuda:使用GPU訓練

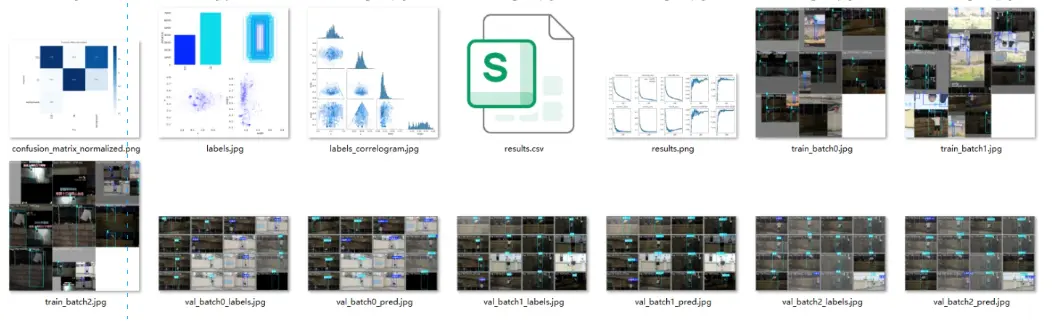

4. 訓練輸出結果

模型訓練結束後,將自動生成:

runs/detect/train/weights/

├── best.pt

├── last.pt其中 best.pt 即為在驗證集表現最優的權重模型。

六、推理與檢測示例

使用訓練好的模型進行推理檢測:

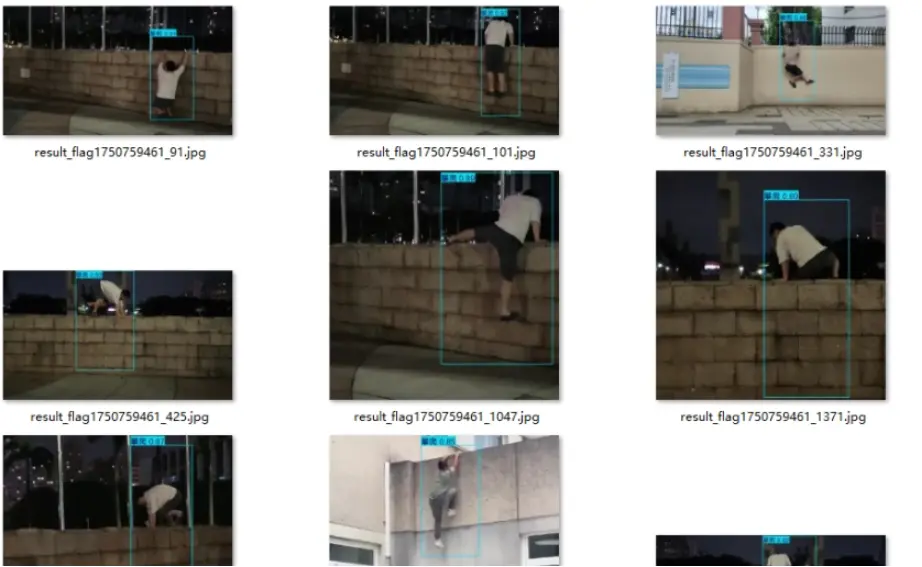

yolo detect predict model=runs/detect/train/weights/best.pt source=demo_video.mp4運行後,YOLOv8 將輸出帶有檢測框的視頻結果,如下圖示意(假設畫面中一名工人正在攀爬圍欄):

from ultralytics import YOLO

model = YOLO("runs/detect/train/weights/best.pt")

results = model.predict(source="test_images/", show=True, save=True)推理結果將自動保存至:

runs/detect/predict/檢測框中標註的類別為:

- no_climb:未攀爬

- climb:正在攀爬

七、性能優化建議

為了進一步提升檢測效果,可以嘗試以下策略:

- 數據增強(Augmentation):如隨機旋轉、亮度調整、裁剪、翻轉;

- 模型替換:可嘗試

yolov8m.pt或yolov8l.pt提升檢測精度; - 遷移學習(Transfer Learning):基於 COCO 預訓練權重微調;

- 多尺度訓練:提高對不同距離目標的識別能力;

- 後處理優化:調整

conf與iou閾值以減少誤檢。

八、結語

“翻牆、攀爬、違規行為檢測數據集” 提供了一個高質量、結構化的訓練基礎,可幫助研究人員與開發者快速構建 智能安全檢測系統。結合 YOLOv8 等主流目標檢測框架,可以輕鬆實現高精度、實時性強的違規行為檢測。

未來,該數據集可進一步拓展為多行為識別體系,如:

- “摔倒檢測(Fall Detection)”;

- “區域入侵檢測(Intrusion Detection)”;

- “打架、奔跑等異常行為識別”。

通過持續優化與擴展,AI將為智慧城市、校園安全與工業防護提供更全面、更智能的視覺感知能力。

✅ 總結關鍵詞:

翻牆檢測、攀爬行為識別、YOLOv8訓練、目標檢測、智能安全監控、AI行為分析