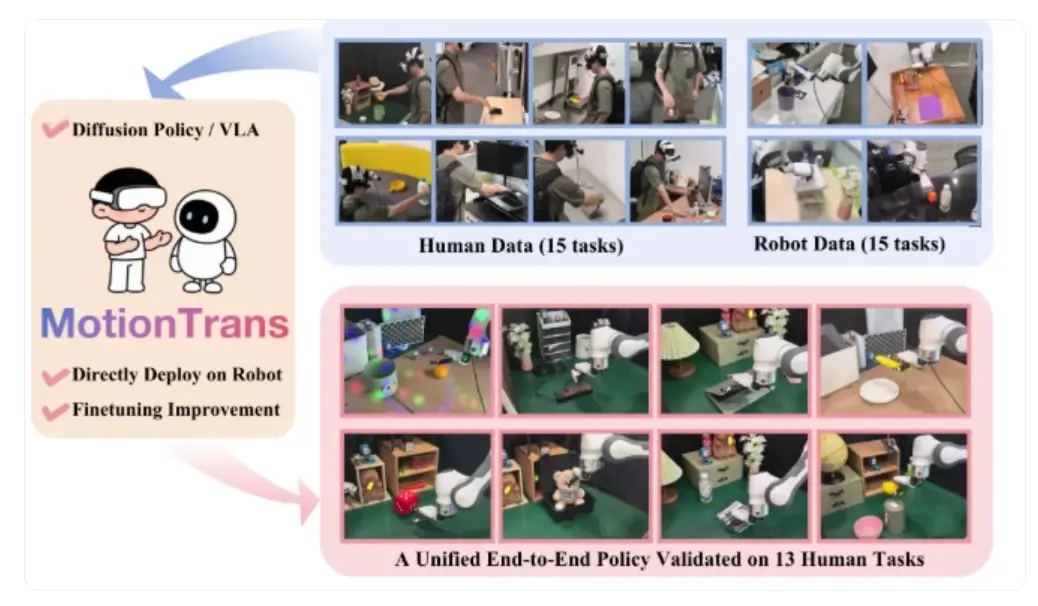

清華大學、北京大學、上海交通大學和武漢大學等高校聯合發佈了一種名為 MotionTrans 的人機協同訓練框架。

這一框架的創新之處在於,讓機器人能夠在沒有任何示範的情況下,僅通過觀察人類的動作,學習和執行新的技能。這標誌着機器人學習領域的一次重大突破。

傳統的機器人訓練需要大量的真實演示數據,收集這些數據的過程耗時且成本高昂。例如,教機器人如何擰瓶蓋,需要反覆操作並記錄每一個細節。而現在,MotionTrans 通過虛擬現實(VR)設備,能夠捕捉人類的精細手部動作數據,從而為機器人提供學習的基礎。

在 MotionTrans 的實施過程中,研究人員使用便攜式 VR 設備,任何人都可以隨時參與數據錄製。系統不僅記錄佩戴者的手部關鍵點,還同步拍攝第一人稱視角的視頻,這樣確保了數據的高質量和豐富性。收集完成後,團隊建立了一個包含 3,213 個演示的數據集,涵蓋了多種人類與機器人任務。

核心的技術在於將人類的動作數據轉化為機器人可理解的格式。研究者們通過優化技術將人類的手部動作精確映射到機器人的關節角度,這樣機器人便能夠在真實環境中執行人類的動作。此外,為了適應機器人的工作特點,研究團隊還進行了速度和舒適區域的調整,以確保機器人的安全與穩定。