中國 AI 獨角獸公司稀宇科技上週發佈並開源其新一代文本大模型 MiniMax-M2:

- 頂級代碼能力:專為端到端開發工作流打造,在 Claude Code、Cursor、Cline、Kilo Code、Droid 等多種應用中表現卓越

- 強大 Agentic 表現:出色規劃並穩定執行復雜長鏈條工具調用任務,協同調用 Shell、Browser、Python 代碼執行器和各種 MCP 工具

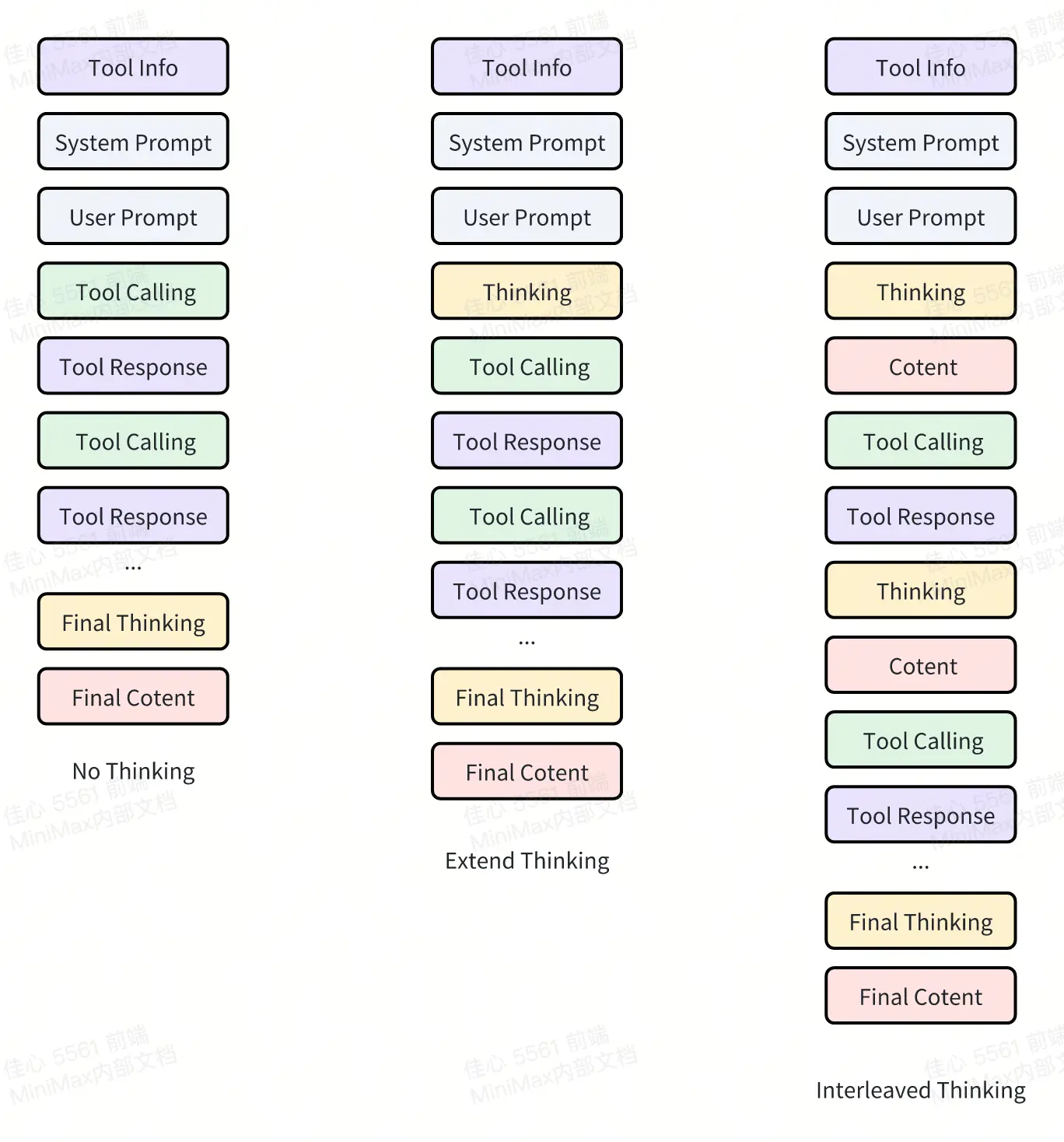

其團隊表示,在 M2 研發的早期階段,他們就發現了 Interleaved Thinking(交錯思維鏈)在 Agent 和 Coding 應用中的重要性。

除 Anthropic Claude 外,目前大多數模型還未完全支持 Interleaved Thinking,它仍是業內的非共識。從用户反饋中我們也注意到,Interleaved Thinking 在實際應用中有時並未被正確使用。

為什麼 Interleaved Thinking 重要,以及如何在不同 API 接口中有效地使用 Interleaved Thinking 以獲得最佳效果?

下文是 MiniMax 對“Interleaved Thinking”的內部思考。

為什麼 Interleaved Thinking 如此重要?

Interleaved Thinking 對 Agent 至關重要:它指在顯式推理(reasoning)與工具調用(tool use)之間交替進行,並把推理結果持續帶入後續步驟。這一過程能顯著提升在長程任務中的規劃能力、自我修正能力與可靠性。

在實踐中,它將冗長、重度依賴工具的任務轉化為穩定的 “計劃→行動→反思” 循環,減少狀態漂移與重複性錯誤,同時確保每一步行動都基於最新證據(evidence)。Interleaved Thinking 同時提升了可調試性:通過推理過程的快照讓故障變得可解釋與可恢復,並通過複用假設、約束與部分結論(而不是重新推導每個步驟)從而提高樣本效率。

為獲得最佳效果,與其在一開始完成所有思考,不如將思考與工具反饋交錯進行,保持思維鏈的連貫性,使其在多輪交互中不斷累積。

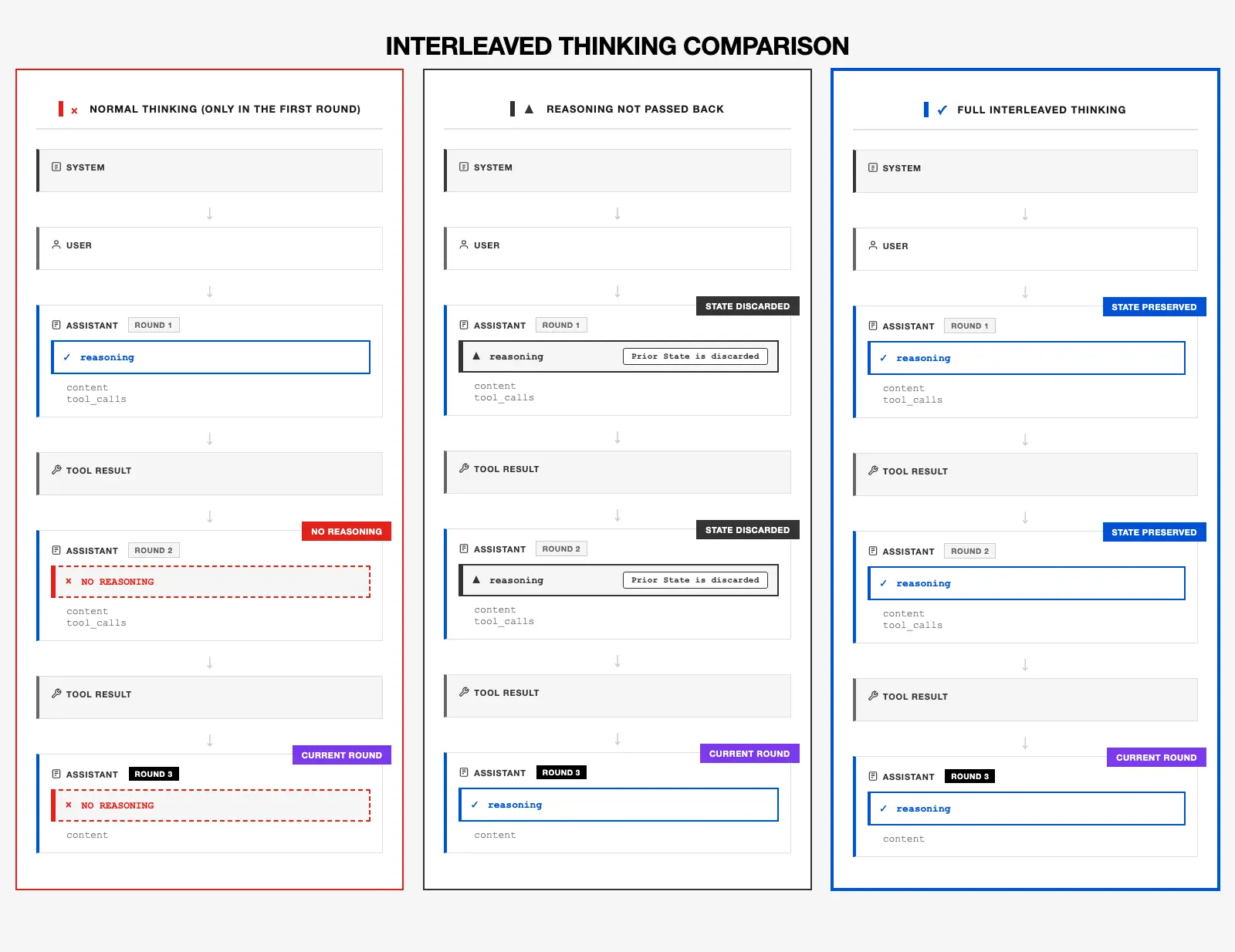

從社區開發者反饋中,我們發現部分失敗案例源於沒有正確使用 Interleaved thinking,即未能在多輪會話之間保留之前每一輪的思考狀態。問題的原因之一是,社區廣泛使用的 OpenAI Chat Completion API 並不支持返回推理內容,並在後續請求中再次傳遞。

Anthropic API 雖然原生支持該能力,但社區對 Claude 之外的模型支持得較少,並且許多應用在其 Anthropic API 的實現中仍然沒有回傳之前的思考過程。這種情況導致 Interleaved Thinking 並沒有得到良好的支持。而為了完全釋放 M2 的全部能力,在多輪交互中保留思考過程至關重要。

在 MiniMax M2 中,只有保留並把上一輪的推理反饋到後續輪次,Interleaved CoT 才能發揮最大效果。模型會在工具調用之間進行推理,將計劃、假設、約束與中間結論持續向後傳遞—— 正是這種可持續、可累積的推理狀態讓 M2 模型穩定可靠。一旦丟棄了之前的推理狀態,模型的累積理解能力會下降,狀態偏離會增加,自我修正能力會減弱,規劃能力也會退化,尤其在長程(long-horizon)工具調用和 “運行–修復” 循環中更為明顯。

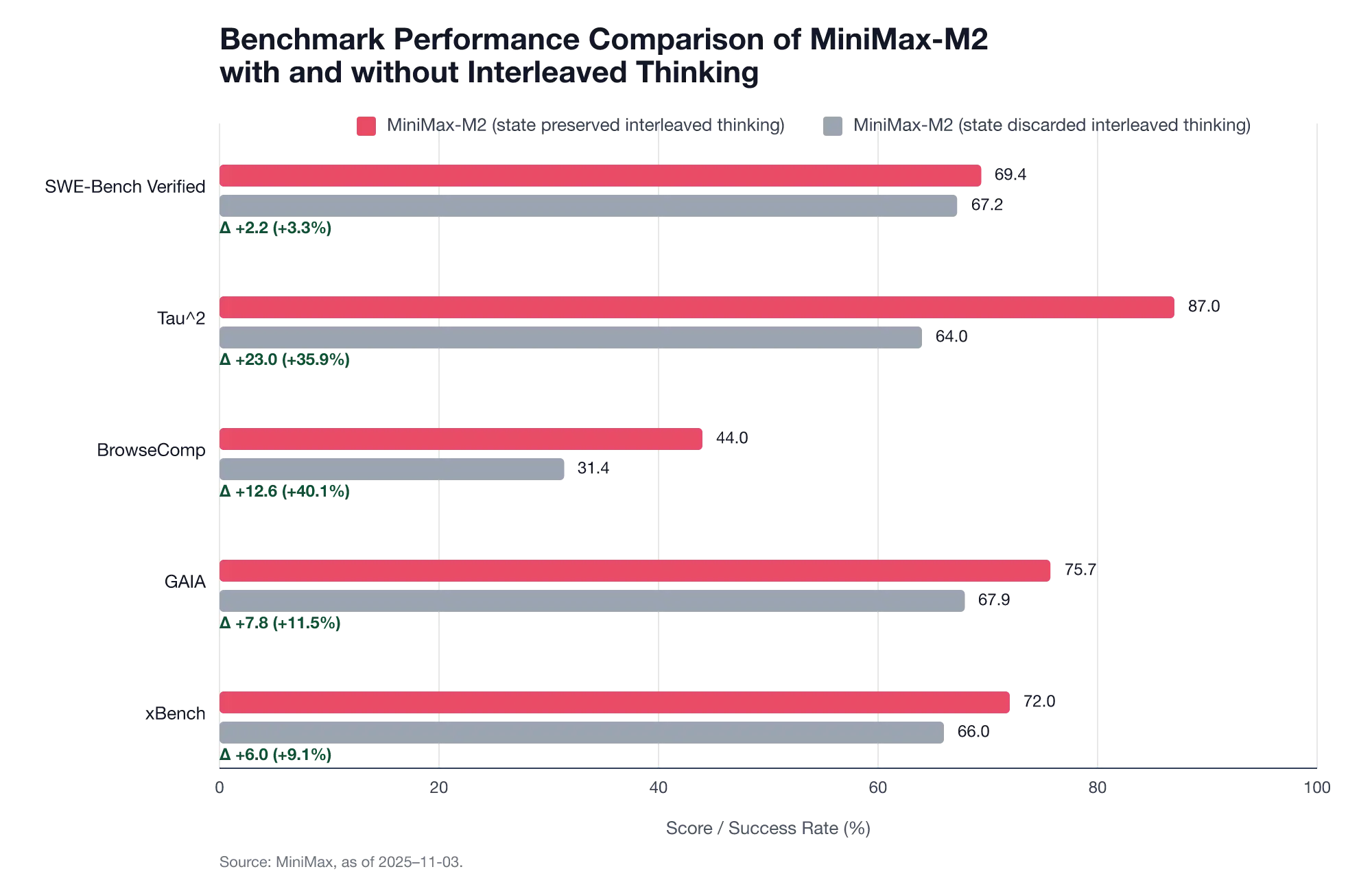

多項基準測試表明,保留之前多輪交互的思維狀態更能提高性能:

- SWE‑Bench Verified:69.4 vs. 67.2 (Δ=+2.2; +3.3%)

- Tau^2:87 vs. 64 (Δ=+23; +35.9%)

- BrowseComp:44.0 vs. 31.4 (Δ=+12.6; +40.1%)

- GAIA:75.7 vs. 67.9 (Δ=+7.8; +11.5%)

- xBench:72.0 vs. 66.0 (Δ=+6.0; +9.1%)

保持 Interleaved Thinking 狀態完整至關重要 —— 模型的可靠性不僅在於它當前的想法,更在於它能否回顧和修正之前的想法。Interleaved Thinking 把這一過程機制化:計劃 → 行動 → 反思,且狀態始終保留,讓反思得以累積,讓修正在多輪交互中傳遞。

圖解 Interleaved Thinking

詳情查看:

https://mp.weixin.qq.com/s/az9OvwEKJ_vYifqlfw6rWA

https://huggingface.co/blog/MiniMax-AI/aligning-to-what