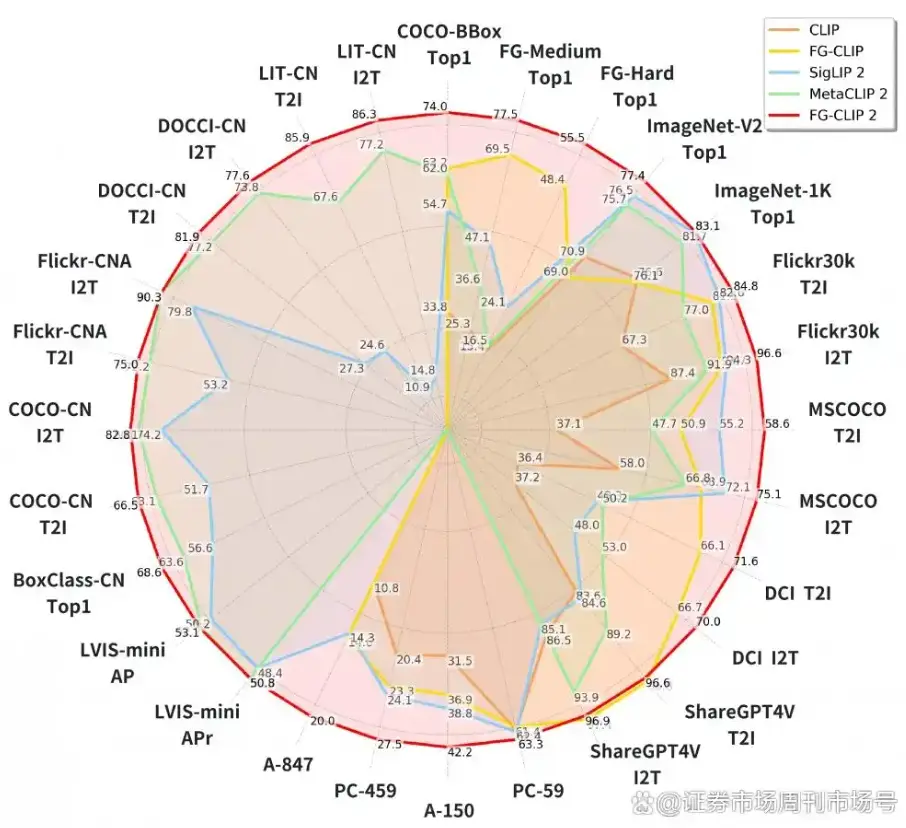

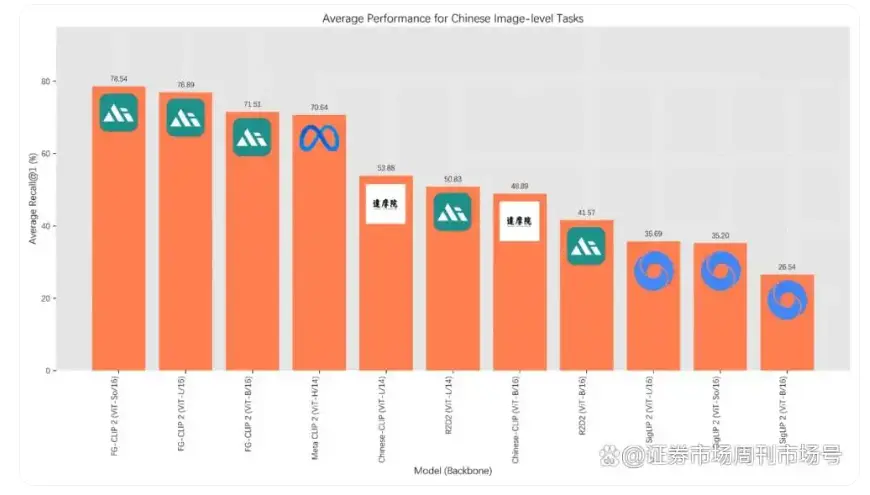

360 集團近日開源視覺語言對齊模型 FG-CLIP2。這款模型在涵蓋長短文本圖文檢索、目標檢測等在內的29項權威公開基準測試中,全面超越了科技巨頭Google的SigLIP 2與Meta的MetaCLIP2。

根據介紹,FG-CLIP2 在模型核心上實現了三大根本創新:第一,層次化對齊架構,讓模型能像人眼一樣,同時把握宏觀場景與微觀細節,實現從“看得見”到“看得清”的跨越。

第二,動態注意力機制,使模型可以智能聚焦於圖像關鍵區域,以最小算力代價換取精準的細節捕捉能力。第三,雙語協同優化策略,從底層解決了中英文理解不平衡的難題,實現了真正的雙語原生支持。

FG-CLIP2依託於自研的超大規模高質量數據集FineHARD。該數據集不僅包含詳盡的全局描述和千萬級的局部區域標註,還創新性地引入了由大模型生成的“難負樣本”。