美團宣佈 LongCat-Flash 系列模型再升級,正式發佈全新家族成員——LongCat-Flash-Omni。

據介紹,LongCat-Flash-Omni 是業界首個實現 “全模態覆蓋、端到端架構、大參數量高效推理” 於一體的開源大語言模型,首次在開源範疇內實現了全模態能力對閉源模型的對標,並憑藉創新的架構設計與工程優化,讓大參數模型在多模態任務中也能實現毫秒級響應,解決了行業內推理延遲的痛點。

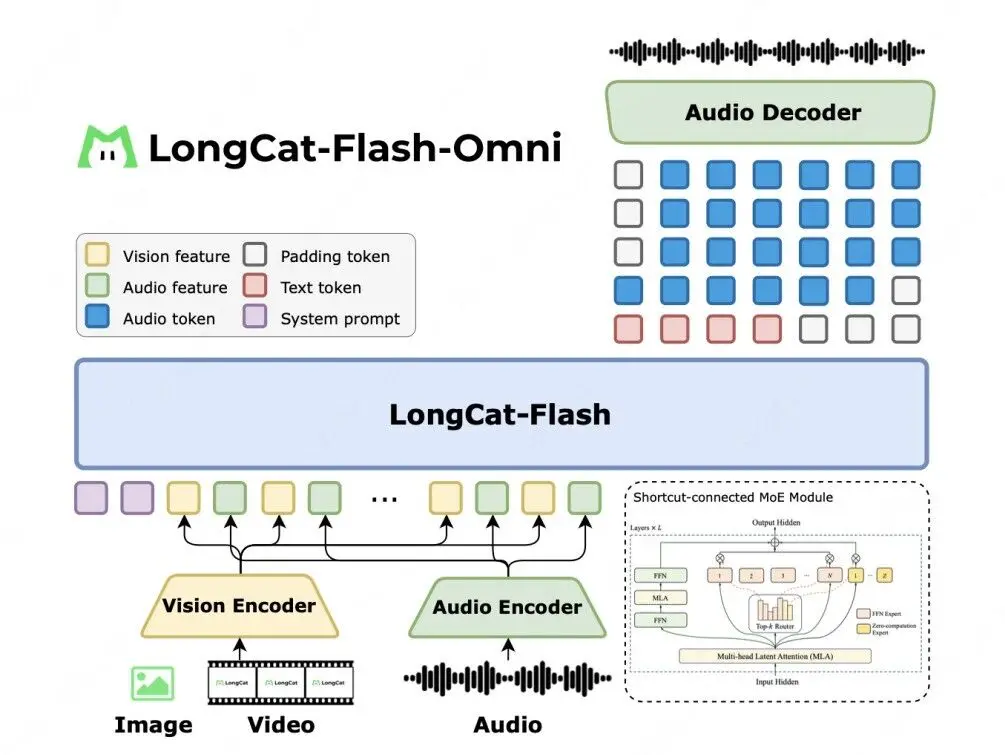

LongCat-Flash-Omni 以 LongCat-Flash 系列的高效架構設計為基礎( Shortcut-Connected MoE,含零計算專家),同時創新性集成了高效多模態感知模塊與語音重建模塊。即便在總參數 5600 億(激活參數 270 億)的龐大參數規模下,仍實現了低延遲的實時音視頻交互能力,為開發者的多模態應用場景提供了更高效的技術選擇。

綜合評估結果表明,LongCat-Flash-Omni 在全模態基準測試中達到開源最先進水平(SOTA),同時在文本、圖像、視頻理解及語音感知與生成等關鍵單模態任務中,均展現出極強的競爭力。

LongCat-Flash-Omni 作為一款擁有極致性能的開源全模態模型,在一體化框架中整合了離線多模態理解與實時音視頻交互能力。該模型採用完全端到端的設計,以視覺與音頻編碼器作為多模態感知器,由 LLM 直接處理輸入並生成文本與語音token,再通過輕量級音頻解碼器重建為自然語音波形,實現低延遲的實時交互。

所有模塊均基於高效流式推理設計,視覺編碼器、音頻編解碼器均為輕量級組件,參數量均約為6億,延續了 LongCat-Flash 系列的創新型高效架構設計,實現了性能與推理效率間的最優平衡。

LongCat-Flash-Omni 模型架構如下:

Hugging Face:https://huggingface.co/meituan-longcat/LongCat-Flash-Omni

Github:https://github.com/meituan-longcat/LongCat-Flash-Omni