螞蟻百靈大模型團隊正式發佈 Ming-flash-omni-Preview,並表示這是首個參數規模達到千億的開源全模態大模型。

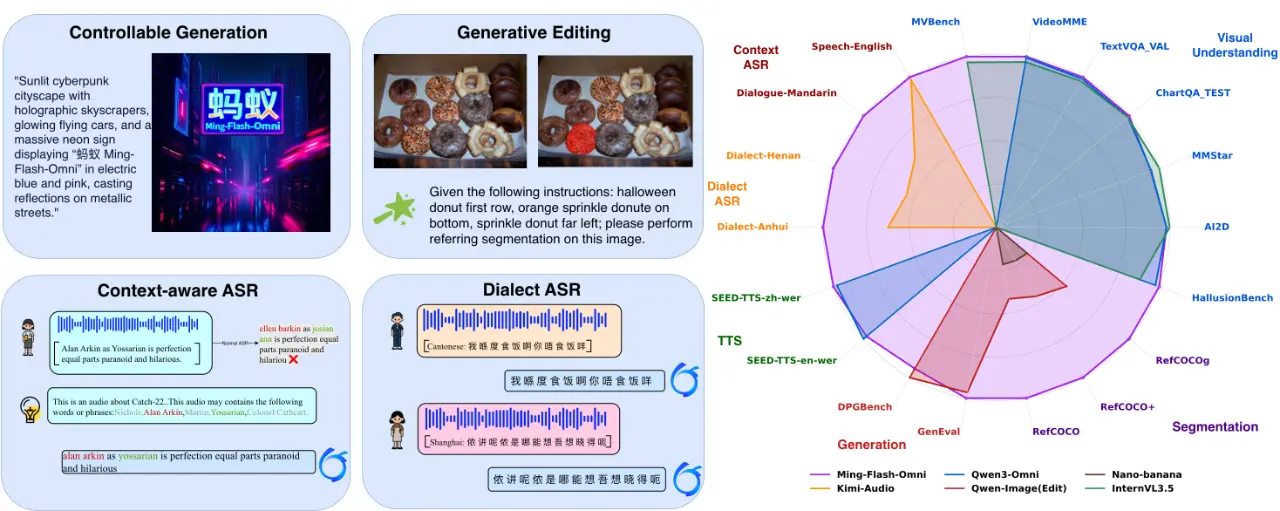

該模型基於 Ling 2.0 的稀疏 MoE 架構,總參數 103B, 激活 9B。相比之前很受歡迎的 Ming-lite-omni-1.5,Ming-flash-omni-Preview 在全模態理解和生成能力上均有提升,各模態總體效果達到開源全模態模型的領先水平, 尤其在可控圖像生成、流式視頻理解、以及語音識別等領域性能表現尤為突出。

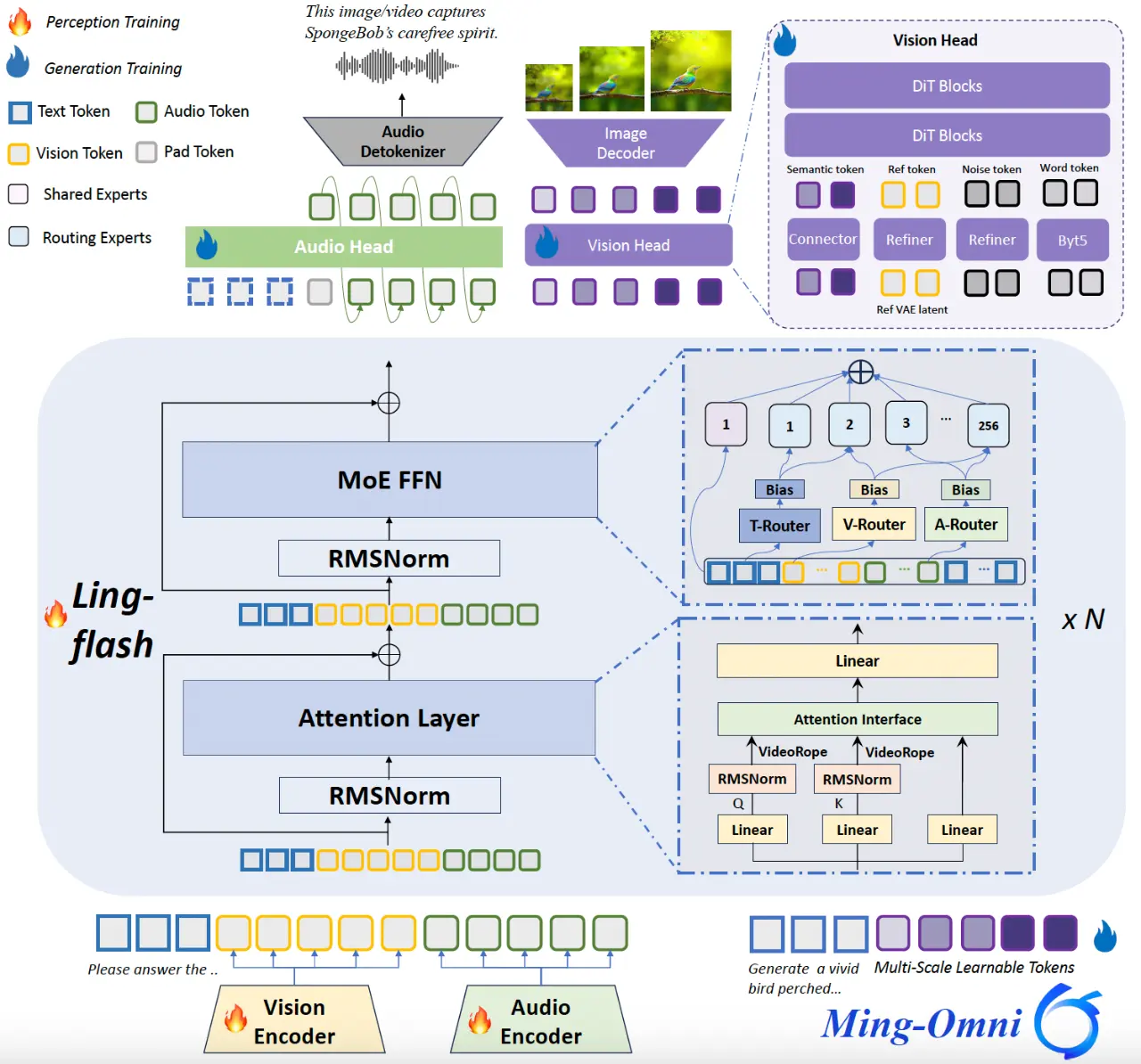

Ming-flash-omni-Preview 模型結構圖:

團隊介紹稱,相比 Ming-lite-omni-1.5,Ming-flash-omni-Preview 主要有以下方面的技術優化:

1) 基於稀疏專家架構的全模態訓練

Ming-flash-omni-Preview 將 Ling-flash-2.0 稀疏 MoE 架構拓展到全模態大模型,基於 Ming-lite-omni 提出的模態級路由實現對各模態分佈和路由策略建模,實現各模態的 “大容量、小激活”。通過在 Attention 層引入 VideoRoPE,強化對長視頻的時空建模,提升視頻交互能力。 另外在訓練策略上:

-

穩定稀疏訓練:使用混合專家平衡方案(結合輔助負載均衡損失與路由器偏置更新),確保稀疏 MoE 架構下全模態訓練的均勻激活和收斂性;

-

上下文感知的 ASR 訓練範式:語音訓練任務上以任務 / 領域信息輸入作為解碼條件,顯著提高專有名詞識別和轉錄一致性。同時引入高質量方言等訓練語料,實現對湖南話、閩南話、粵語等 15 種中國方言的識別準確率顯著提升。

2)生成式分割編輯一體化

在構建統一多模態模型時,核心挑戰在於如何高效融合圖像的理解與生成能力。我們的Ming-lite-omni-1.5 通過凍結語言通路,並藉助多尺度QueryToken注入層級化語義,從而在保持理解性能的同時,使生成目標能更好地與理解任務融合。這一訓練策略雖然提升了穩定性,但由於理解與生成的學習目標本質上存在差異,即使引入層級化語義,那些細粒度的視覺知識(如物體屬性和空間關係)仍難以高效遷移到高精度的生成與編輯任務中,進而限制了模型在生成質量和可控性上的提升。

為克服這一瓶頸,Ming-flash-omni-Preview 提出了“生成式分割即編輯” 的協同訓練範式。該範式將圖像分割重構為語義保持的編輯任務(例如:“將香蕉塗成紫色”)。相應的設計所提供的關鍵幫助是:強制統一了理解和生成目標—— 成功的編輯必須依賴對對象輪廓的精確理解,編輯質量直接為理解提供監督信號。這一範式直接增強了模型的細粒度時空語義控制能力,間接解決了純文本到圖像生成中的組合性問題。

在 GenEval 基準測試中,Ming-flash-omni-Preview 取得了 0.90 分,超越所有領先的非強化學習(non-RL)方法;在 GEdit 基準測試中,在物體刪除、物體替換等精準編輯任務上的均分從 6.9 提升至 7.9。這兩項結果共同證明:通過“生成式分割即編輯”訓練所獲得的細粒度時空語義控制能力,不僅顯著提升了精準編輯任務的表現,還能夠有效泛化到純文本驅動的圖像生成任務中。

3) 高效全模態訓練架構

訓練全模態基礎模型面臨兩大挑戰:數據異構性(多模態輸入形狀不一)和模型異構性(模態專用編碼器難以並行)。這些問題導致負載失衡、內存碎片化和流水線氣泡,嚴重拖慢了訓練速度。

為解決這些問題,我們在訓練 Ming-flash-omni-Preview 模型時基於 Megatron-LM 框架進行了兩項關鍵優化:

-

序列打包 (Sequence Packing):解決數據異構性。將變長序列密集打包成定長批次,大幅提升內存利用率和計算密度;

-

彈性編碼器分片 (Flexible Encoder Sharding):解決模型異構性。擴展 Megatron-LM 支持模態編碼器在 DP/PP/TP 上的細粒度分片,消除流水線氣泡,實現負載均衡。

這些優化措施使 Ming-flash-omni-Preview 的訓練吞吐量比基線提升了一倍。

Ming-flash-omni Preview 的模型和代碼均已開源:

GitHub: https://github.com/inclusionAI/Ming

HuggingFace: https://huggingface.co/inclusionAI/Ming-flash-omni-Preview

ModelScope: https://www.modelscope.cn/models/inclusionAI/Ming-flash-omni-Preview